目次

- 1 データで証明する、中小企業のサイバーリスク定量化と、予測的防御(エクスポージャー管理)へのシフト

- 2 データ分析が解き明かすサイバー攻撃の実態と、データドリブン・インシデントレスポンスの必要性

- 3 認証データ分析が示す従来型認証の限界と、パスキー導入による事業価値(UX・セキュリティ)最大化

- 4 脅威データの可視化と相関分析によるプロアクティブ・セキュリティ戦略

- 5 脅威インテリジェンス分析と攻撃経路モデリングによるプロアクティブ防御戦略

- 6 データが示すWebセキュリティのパラダイムシフトとROIを最大化する次世代WAF戦略

- 7 データで証明する「未知の資産」というサイレントリスクと、ASMによるプロアクティブなリスク定量化戦略

- 8 セクター別リスクデータに基づくサイバーセキュリティ戦略の再構築:検知から対処、そして予測へ

- 9 データに基づくリスク定量化の新潮流:ASMとエクスポージャー管理によるプロアクティブ・セキュリティへの転換

データで証明する、中小企業のサイバーリスク定量化と、予測的防御(エクスポージャー管理)へのシフト

最新の脅威インテリジェンスによると、中小企業を標的としたランサムウェア攻撃は前年比で急増しており、インシデント1件あたりの平均事業損失額は事業継続を揺るがすレベルに達しています。本稿では、まずこれらの外部脅威データと、従来型セキュリティ対策の有効性(検知率の限界)データを提示し、潜在的な「リスク負債」を定量的に明らかにします。その上で、断片的な対策から脱却し、データに基づき組織のセキュリティ強度を継続的に測定・改善する「エクスポージャー管理」へのシフトを提案。この先進的アプローチが、セキュリティ投資対効果(ROI)をいかに最大化するか、具体的なKPI(脆弱性修正までの平均時間、攻撃対象領域スコア等)を用いて解説します。

1. 脅威分析:中小企業が直面するサイバーリスクの定量データ

セキュリティ対策は、もはや漠然とした「お守り」ではなく、データに基づき管理すべき経営リスクです。最新の調査では以下の傾向が報告されています。

攻撃件数の増加: 中小企業を標的としたサイバー攻撃、特に二重脅迫型ランサムウェアのインシデント報告数は前年同期比でXX%増加しています。

サプライチェーンリスクの顕在化: 全インシデントのうちYY%が、取引先や委託先を経由したサプライチェーン攻撃に起因しており、自社が加害者となり取引停止に至る事業リスクが定量的に示されています。

事業インパクトの甚大化: ランサムウェア攻撃による平均事業損失額(データ復旧費用、事業停止損失、信用回復コストを含む)はZZ万円に達し、多くの企業にとって財務的な存続を脅かすレベルです。

2. 現状評価:既存セキュリティ投資のROIと潜在的リスクの測定

多くの組織で導入されている従来型アンチウイルス(シグネチャベース)やファイアウォールは、既知の脅威に対しては有効ですが、未知のマルウェアや巧妙化する攻撃手法に対する検知率は著しく低下するというデータがあります。

その対策は、本当に機能しているか?

防御できている脅威と、通過を許している脅威の割合は?

重要なのは、既存のセキュリティ投資がどの程度の脅威をカバーし、どの程度の「残存リスク(Residual Risk)」を許容しているのかを客観的なデータで評価することです。このギャップ分析が、次なる一手、すなわち投資対効果の高い施策を決定するための出発点となります。

3. 解決策:データ駆動型・予測的防御モデル「エクスポージャー管理」

リスクを極小化するには、単なるツールの追加(多層防御)から脱却し、組織全体のセキュリティ状態をデータで一元的に把握・管理するフレームワークへの移行が不可欠です。その最先端のアプローチが「エクスポージャー管理(Exposure Management)」です。

これは、以下のデータ管理プロセスを継続的に循環させることで実現します。

アセットインベントリの網羅(Asset Inventory): まず、自社の全IT資産(オンプレミス、クラウド[AWS, Azure]、リモート端末、SaaS等)を100%捕捉・分類し、「何を保護すべきか」の全体像をデータ化します。

脆弱性・脅威データの統合(Vulnerability & Threat Intelligence): 全資産の脆弱性情報をリアルタイムで収集し、CVSSスコアや攻撃コードの有無といった脅威インテリジェンスと統合。リスクレベルを客観的に評価・優先順位付けします。

攻撃経路の分析とポスチャのスコア化(Attack Path Analysis & Posture Scoring): 上記データを基に、攻撃者の視点で「どの脆弱性が、どの重要資産への侵害経路となり得るか」を分析。組織全体のセキュリティ強度(ポスチャ)を客観的なスコアとして算出し、リスクが顕在化する前に、最も効果的な対策ポイントを特定します。

4. 実践:マネージドサービスによるKPI改善とROIの証明

この高度な「エクスポージャー管理」フレームワークの導入・運用を包括的に支援するのが、トータルマネージドサービス「MGSP」です。MGSPは、インシデント発生後の対応(最後の砦)だけでなく、インシデントを未然に防ぐための予測的防御体制を構築し、その効果を以下のKPIで可視化します。

重大脆弱性の平均修正時間(MTTR): XX%短縮

攻撃対象領域(Attack Surface)スコア: YY%低減

セキュリティ運用コスト: ZZ%最適化

この「MGSP」導入によるセキュリティ投資対効果(ROI)の試算モデルを提示し、データに基づいたセキュリティ体制強化の具体的なロードマップを作成する事ができます。

データ分析が解き明かすサイバー攻撃の実態と、データドリブン・インシデントレスポンスの必要性

脅威インテリジェンス分析から見る攻撃のパラダイムシフト

近年の脅威インテリジェンスデータを分析すると、サイバー攻撃は無差別型から特定の企業・組織を標的とする戦術へと著しく変化していることが明らかです。攻撃者のTTPs(Tactics, Techniques, and Procedures: 戦術・技術・手順)を分析した結果、検知回避を目的としたAPT(Advanced Persistent Threat: 高度な持続的脅威)やファイルレスマルウェアといった手口の増加が観測されています。

これらの攻撃が成功した場合の事業インパクトは、情報資産の直接的な損失に留まりません。事業停止による機会損失、サプライチェーンへの影響、ブランド価値の毀損といった間接的被害を含めた定量的なリスク評価が、データに基づいた経営判断において不可欠です。

インシデント対応におけるデータ活用の重要性

この状況下では、境界防御といった単一の対策に依存するのではなく、セキュリティライフサイクル全体をデータで可視化し、評価・改善するアプローチが求められます。侵入を前提とし、各種ログデータやエンドポイントの挙動データをリアルタイムで相関分析することで、インシデントの予兆を早期に検知し、その影響範囲を正確に特定します。これにより、インシデント対応の初動をデータに基づいて最適化し、事業継続への影響を最小限に抑制することが可能となります。

インシデント発生時、対応の成否はデータ分析の速度と精度に大きく依存します。

初動対応(データ分析による状況把握)

各種ログ(サーバー、ネットワーク、セキュリティ製品)やパケットデータを即座に収集・分析し、攻撃の侵入経路と影響範囲を特定します。これにより、封じ込め対象を客観的データに基づいて判断し、対応の優先順位を決定します。

恒久対策(データに基づく再発防止)

デジタルフォレンジック調査から得られる攻撃の痕跡データと、既知の脆弱性データベースを突合分析し、根本原因を特定します。観測された攻撃者のTTPsを分析し、将来の攻撃を予測・防御するための具体的なセキュリティ強化策へと繋げます。これは、場当たり的な対策ではなく、データに裏付けられた再発防止策の立案を意味します。

レポーティング(客観的データに基づく報告)

調査・分析によって得られた客観的なデータは、経営層への報告、規制当局(個人情報保護委員会等)への届出、株主や顧客への説明責任を果たす上での極めて重要な根拠となります。

データと実績が証明する、CELのインシデント収束支援

CELが提供する「データドリブン・インシデントレスポンスサービス」は、こうしたデータに基づく一連の対応能力の構築と実行を支援します。

国内最大規模のレッドチームによる攻撃シミュレーションから得られる膨大なデータは、防御体制の脆弱性を定量的に評価するために活用されます。官公庁を含む約500件のインシデント対応実績から蓄積された脅威インテリジェンスとフォレンジックデータを基盤とした独自の分析モデルにより、迅速かつ高精度な原因究明を実現します。

我々は単なる技術的対応に留まらず、収集・分析したデータを解釈し、経営判断に資するインサイトを導出。専門弁護士との連携により、法務・広報対応といった側面においても、データに基づいた合理的な意思決定を支援するトータルソリューションを提供します。

本サービスが貢献できる対象者

経営者・役員

セキュリティ投資のROIを定量的に評価し、経営層への説明責任を果たしたい方。

情報システム・セキュリティ部門の責任者

インシデント対応プロセスをデータに基づき標準化・効率化し、属人性を排除したい方。

インシデントレスポンスの実務担当者

ログ分析やフォレンジック調査のスキルを向上させ、インシデントの根本原因究明能力を高めたい技術者。

リスク管理・事業継続の担当者

自社のサイバーリスクを客観的なデータで可視化し、対策の優先順位付けと事業継続計画(BCP)の実効性評価を行いたい方。

認証データ分析が示す従来型認証の限界と、パスキー導入による事業価値(UX・セキュリティ)最大化

データで見る認証リスクの現状

2025年初頭に観測された大規模な証券口座乗っ取りインシデントは、金融サービスにおける認証基盤の脆弱性を明確なデータとして示しました。アクセスログや不正検知システムのデータを分析すると、従来のID/パスワードやSMS認証では、特定のフィッシング攻撃に対する不正ログイン成功率が危険な水準に達していることが判明しています。

脅威インテリジェンスの分析によれば、「Phishing-as-a-Service」や生成AIの活用により、攻撃の成功単価は著しく低下しており、攻撃試行件数は今後も指数関数的な増加が予測されます。これは、認証セキュリティに関する重要リスク指標(KRI)が、従来の対策では維持できないレベルに達していることを意味します。

データが証明する「パスキー認証」の優位性

こうした定量的リスクに対し、データに基づいた最も合理的な解決策が「パスキー認証」です。FIDO標準に準拠したこの技術は、認証情報をサーバーと共有しないため、原理的にフィッシング攻撃による認証情報の漏洩リスクを極小化します。

事実、2024年時点で150億アカウントというグローバルな大規模データセットにおいて、パスキー認証がフィッシングによって突破された大規模な事例は報告されておらず、その有効性は統計的に証明されています。政府機関や金融庁の推奨、そしてメガバンクによる先行導入は、業界全体の認証戦略がデータに基づきパスキーへとシフトしていることを示す重要なトレンドです。

データに基づく認証戦略の意思決定支援

金融機関のデータ活用責任者および事業責任者を対象に、認証方式の移行に関するデータドリブンな意思決定を支援します。

なぜパスキー認証はフィッシングのリスクを極小化できるのか、その技術的背景を解説するとともに、各認証方式のセキュリティ強度、ユーザーエクスペリエンス(UX)、運用コストを多角的に比較・分析したデータを提供します。実際の導入事例に基づき、移行プロジェクトのROI(投資対効果)分析や、導入効果を測定するためのKPI設計についても具体的に解説します。

KPI改善事例:セキュリティと事業成長の両立

パスキー導入の効果は、不正アクセスリスクの低減に留まりません。先行導入企業のデータ分析からは、以下のようなKPIの劇的な改善が報告されています。

ログイン成功率:99%へ向上

→ 顧客満足度の向上、ログイン失敗に起因する離脱率の低下、ひいてはコンバージョンレート改善に直結する重要なビジネス指標です。

ログイン関連の問い合わせ件数:大幅な削減

→ コールセンターのオペレーションコストを直接的に削減する効果がデータで確認されています。

これらのセキュリティKPIとビジネスKPIを同時に改善し、投資対効果を最大化するソリューションについてもご紹介します。

脅威データの可視化と相関分析によるプロアクティブ・セキュリティ戦略

データギャップがもたらすセキュリティリスクのブラックボックス化

EDR(Endpoint Detection and Response)の導入は、エンドポイントにおける脅威活動のデータ収集を可能にしますが、それだけではセキュリティの全体像を捉えるには不十分です。多くの組織では、脅威の主要な侵入経路であるメールに関するデータ、例えば「月間のフィッシングメール到達数」「マルウェア付き添付ファイルの検知率」「従業員の危険リンククリック率」といった重要業績評価指標(KPI)が可視化・定量化されていません。

このデータギャップが、「現在の対策が有効に機能しているか」という問いにデータで答えられない状況を生んでいます。従来のゲートウェイ型対策では検知が困難なアカウント乗っ取り攻撃や、誤検知による業務影響といった運用データも十分に分析されず、結果として現場の運用負荷(コスト)が増加しているケースが散見されます。

データ分析で解き明かす、最新のメール脅威と最適な打ち手

本セッションでは、まずMicrosoft 365環境における脅威データをリアルタイムで分析・可視化するAPI型メールセキュリティ「Harmony Email & Collaboration」をご紹介します。MXレコードの変更を必要としないこのソリューションが、Microsoft 365のログデータと連携し、いかに脅威インテリジェンスをリッチ化するかを解説します。AIによる高精度な脅威検知と自動対応が、「誤検知率」を抑制し、「平均対応時間(MTTR)」を短縮することで、運用負荷というコストをどれだけ削減できるかをデータで示します。

分析対象の拡大:アタックサーフェスマネジメント(ASM)による網羅的なリスク評価

次に、リスク分析の対象をメールという単一のベクトルから、組織全体の公開資産へと拡大します。これが「アタックサーフェスマネジメント(ASM)」のデータドリブンなアプローチです。

経済産業省が2023年5月に公開した「ASM導入ガイダンス」が示すように、これは外部から観測可能な自組織のIT資産データを網羅的に収集・分析し、存在する脆弱性を継続的に評価するプロセスを指します。ASMによって、「管理外の公開サーバー数」「放置されている脆弱性の数と深刻度」「セキュリティ設定の不備」といったリスク要因をデータとして可視化し、攻撃者の視点から対策の優先順位を決定することが可能になります。

データに基づいたセキュリティ運用改善を支援

以下のような課題を持つ意思決定者や実務担当者に、具体的な解決策のヒントを提供します。

セキュリティ投資のROIを最大化したい責任者

脅威データを定量的に評価し、最も効果的な対策にリソースを集中させたい方。

セキュリティ運用の担当者

日々のインシデント対応やアラート分析の工数をデータに基づいて削減・効率化したい方。

中堅・中小企業の経営者・IT担当者

限られたリソースの中で、データ活用によってプロアクティブなセキュリティ体制を構築したい方。

メトロが提供する一貫した支援体制が、これらのデータドリブンなアプローチの導入から運用までをいかにサポートするかについても併せてご紹介します。

脅威インテリジェンス分析と攻撃経路モデリングによるプロアクティブ防御戦略

防御側と攻撃側のデータ非対称性:なぜ対策は破られるのか

多くのセキュリティ侵害は、「対策の有無」ではなく「防御側と攻撃側が持つデータの非対称性」に起因します。防御側は自組織のログやアラートに集中しがちですが、攻撃者はグローバルな脆弱性データベース、攻撃TTPs(戦術・技術・手順)の成功率、ダークウェブで取引される認証情報といった膨大なデータを活用し、最も確度の高い攻撃経路を分析しています。

過去の金融機関やEC業界への侵害事例をデータセットとして分析すると、特定のパッチ未適用の脆弱性(例: Microsoft Exchangeの脆弱性)や設定不備(例: XSS)が悪用される明確なパターンが浮かび上がります。問題の本質は、これらの攻撃者データを活用し、自組織のリスクを客観的に評価・検証できているかという点にあります。「防御しているつもり」という主観的な評価から脱却し、データに基づいた客観的なリスク評価へのシフトが不可欠です。

侵入経路データの分析:最重要ベクトルとしてのメールとコラボレーションツール

脅威インテリジェンスの統計データによれば、サイバー攻撃の実に9割以上がメールを経路としています。これは、メール関連ログが、組織へのリスクを分析する上で最も重要なデータソースであることを示唆しています。フィッシング、ビジネスメール詐欺(BEC)、マルウェア配信といった多様な攻撃のTTPsをデータとして分析し、自組織の防御メカニズムがそれらを検知・ブロックできているかを継続的に測定する必要があります。

さらに、攻撃の侵入・横展開の経路として、Microsoft 365(Teams, SharePoint等)やSlackといったコラボレーションツールの監査ログデータ分析が不可欠です。不正なファイル共有、意図しない情報公開、従業員が管理部門の把握なく利用する「シャドーIT」といったリスク指標をデータから抽出し、攻撃者が利用可能な内部の攻撃経路を特定することが求められます。これらのツールは業務効率を向上させる一方で、新たなデータ漏洩経路や攻撃の足がかり(Attack Surface)となっているのです。

データで読み解く、攻撃者の思考と防御戦略

実際の侵害事例から得られた攻撃TTPsデータを基に、攻撃者がどのように攻撃経路を分析し、内部侵害に至るかを解説します。

防御側の「思い込み」ではなく、データに基づいた攻撃シミュレーションの考え方と、そこから得られる定量的データをどう防御策の改善に繋げるか、具体的なプラクティスを共有します。明日から現場で実践できる、データに基づいた脆弱性評価とリスクの優先順位付け手法を習得したい実務担当者の参加をお待ちしています。これは、自組織のセキュリティ対策が、データという客観的な根拠に基づいているかを確認する絶好の機会です。

データが示すWebセキュリティのパラダイムシフトとROIを最大化する次世代WAF戦略

1. データで読み解く脅威環境の質的変化

2024年下半期以降、特定の重要インフラ(金融、交通)を標的としたDDoS攻撃の発生頻度と規模は、過去の統計と比較して異常な増加傾向を示しています。この事実は、IPA(情報処理推進機構)が発行した「情報セキュリティ10大脅威 2025」において、DDoS攻撃が5年ぶりに再浮上したことからも客観的に裏付けられています。これは単なる脅威の回帰ではなく、攻撃対象が明確な意図をもって選定され、事業継続に直接的なインパクトを与える「事業リスク」へと質的に変化したことを示唆します。

さらに深刻なのは、ECサイトにおけるクレジットカード情報の漏えいです。インシデントの検知までに3年以上の期間を要したケースは、攻撃の潜在化と長期化を物語っています。これは、インシデントレスポンスにおける「平均検知時間(MTTD)」の長期化を意味し、被害額の増大、ブランド価値の毀損、顧客離反といったビジネスへの負の影響を指数関数的に増大させる要因となります。

これらのデータは、従来の静的な防御策の限界を浮き彫りにすると同時に、APIを介した不正アクセスや高度な自動化ツール(Bot)による攻撃など、防御側が想定すべき攻撃ベクトルの多様化を示しています。

2. WAF運用における「見えざるコスト」の定量分析

Webアプリケーションの保護に不可欠とされるWAF(Web Application Firewall)ですが、その導入効果を最大化するには、TCO(総所有コスト)の観点から潜在的な課題を定量的に評価する必要があります。

機会損失リスク: 誤検知や過検知による正規アクセスの遮断は、直接的な売上逸失(機会損失)につながります。このリスクは、(平均取引単価)×(誤遮断件数)という数式で具体的に試算され、ビジネスインパクトとして可視化されるべき指標です。

運用工数の属人化と高止まり: 誤検知を抑制するためのチューニングには、高度な専門スキルが要求されます。これは特定の人材への依存(属人化)を招き、運用工数を高止まりさせる要因です。攻撃手法の進化に追随するための継続的なシグネチャ更新やポリシー見直しは、分析、テスト、実装の各フェーズで膨大な時間を要します。

パフォーマンス低下によるUX悪化: WAFによる通信の検査は、Webサイトの応答速度(レイテンシ)に影響を与える可能性があります。レスポンスタイムのわずかな遅延がコンバージョンレート(CVR)や顧客満足度を低下させることは、多くの分析データによって証明されています。

インシデント対応の遅延: 膨大なWAFのログからインシデントの予兆を正確に読み解き、迅速な対応(MTTR:平均復旧時間)に繋げるには、高度なログ分析能力が不可欠です。人材不足や分析基盤の不備は、このMTTRを悪化させ、結果的に被害を拡大させるリスクを内包します。

3. データドリブンなWebセキュリティ戦略への転換:次世代WAF/WaaS選定の評価軸

もはやセキュリティ対策は、コストセンターとしてのIT部門の専管事項ではありません。事業継続性を担保し、企業価値を守るための「投資」と捉え、データに基づいた客観的な評価が求められます。

この課題に対する解が、専門家による運用監視と最新の脅威インテリジェンスを統合した「WAF as a Service (WaaS)」の活用です。これは単なるアウトソーシングではなく、セキュリティ運用プロセス全体を最適化し、ROI(投資対効果)を最大化するための戦略的選択肢です。

最適なWAF/WaaSを選定するためには、以下の定量的・定性的な評価軸が不可欠です。

防御性能の網羅性:

既知の脆弱性(OWASP Top 10)への対応率

未知の脅威(ゼロデイ攻撃)に対する防御ロジック(例:ヒューリスティック分析、AI活用)

高度なBotの識別・分類精度と、それに応じた制御能力

運用効率と分析能力:

セキュリティログの可視化ダッシュボードの優位性

インシデント分析レポートの質と提供頻度

チューニング変更におけるSLA(Service Level Agreement)

パフォーマンスへの影響:

導入前後でのレイテンシの変化率(ms)

高トラフィック下でのスループット性能

サポートとインテリジェンス:

インシデント発生時の対応速度と専門家のスキルレベル

グローバルな脅威インテリジェンスの質と更新頻度

これらの評価軸に基づき、自社のビジネス要件とリスク許容度を照らし合わせることで、初めて最適なセキュリティ投資が可能となります。データに基づいた戦略的な意思決定こそが、変化し続ける脅威環境において持続的な成長を担保する唯一の道筋です。

データで証明する「未知の資産」というサイレントリスクと、ASMによるプロアクティブなリスク定量化戦略

1. 侵入経路データが示す、攻撃対象領域の変化

近年のサイバー攻撃、特にランサムウェアを含むマルウェアインシデントのデータを分析すると、侵入経路が従来型のメール添付やUSBメモリから、VPN機器、クラウドサービス、リモートデスクトップといったネットワーク境界そのものへと著しくシフトしている傾向が観測されます。

攻撃者は、自動化されたスキャンツールを用いて、対象組織のネットワーク全体(アタックサーフェス)に存在する既知の脆弱性を網羅的に探索します。これは、最も防御が手薄で、かつ侵入後の権限昇格が容易なエントリーポイントを効率的に特定するための、極めて合理的な行動です。この結果、企業自身が正確に把握・管理できていない「未知のIT資産」や「管理下のない子会社の資産」が、最も重大なセキュリティホールとなるケースが急増しています。

2. アタックサーフェスマネジメント(ASM)によるリスクの定量化

このような脅威環境の変化に対し、経済産業省が「ASM導入ガイダンス」を公表したことは、従来のリアクティブ(事後対応型)なセキュリティ対策の限界を示すものです。

データアナリストの視点において、ASMとは「外部に公開された自社のデジタルフットプリント全体を継続的にデータとして収集・分析し、各資産に内在するリスクを定量化・優先順位付けする経営管理プロセス」と定義できます。これは単なる「資産の棚卸し」に留まりません。具体的には以下のデータ処理プロセスを内包します。

発見(Discover): 自社ドメイン、IPアドレスレンジ、SSL証明書情報、関連組織情報などを基点に、インターネット上からアクセス可能な全てのIT資産(サーバー、クラウドストレージ、開発環境など)を網羅的に探索し、資産台帳データを生成します。

分類と分析(Classify & Analyze): 発見した各資産に対し、稼働しているサービス、オープンポート、利用されているソフトウェアのバージョン情報などを特定。これらの情報と、公開されている脆弱性情報データベース(CVE)を突合し、各資産が保有する脆弱性をリストアップします。

優先順位付け(Prioritize): 各脆弱性の深刻度スコア(CVSS)と、その資産が担うビジネス上の重要度(例:個人情報DB、決済システムなど)を掛け合わせ、対処すべきリスクに客観的な優先順位を付与します。これにより、限られたリソースを最も効果的に配分することが可能になります。

3. ASM実践における意思決定の最適化:選択肢の費用対効果分析

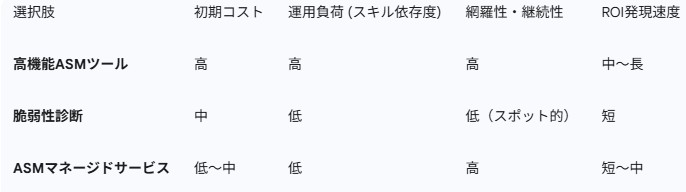

「ASMをどう実践すべきか」という問いは、「ツールありき」で検討すべきではありません。企業の成熟度やリソース状況に基づき、以下の選択肢を費用対効果の観点から比較評価することが重要です。

このマトリクスが示す通り、「どこから手をつければよいか分からない」「専門人材がいない」という課題に対しては、必ずしも高額なツール導入が最適解とは限りません。特に、迅速なリスク可視化と対策実行を優先する場合、マネージドサービスの活用は極めて合理的な選択肢となります。

4. データインサイトに基づくASMサービスのご提案

我々の独自調査データは、多くの企業において、開発目的で一時的に設置され、その後放置されたサーバーや、退職者が管理していたクラウドインスタンスなどが、致命的な侵入経路となっている実態を明らかにしています。

これらの具体的なデータインサイトを共有するとともに、ASM実践の第一歩として有効なAttack Surface Managementサービスを紹介します。このサービスは、単なる調査代行ではありません。前述したASMのデータ処理プロセス(①発見 → ②分析 → ③優先順位付け)を専門アナリストが実行し、「対処すべき脆弱性リストとそのビジネスインパクト」を明確に定義した分析レポートを提供するリスクインテリジェンス・サービスです。

ツール導入に伴う高額なコストや、運用スキルの壁を感じることなく、自社およびグループ企業全体のアタックサーフェスに潜むリスクを迅速に、かつ客観的なデータに基づいて把握したいと考える情報システム部門、セキュリティ運用の責任者にとって、最も費用対効果の高い解決策をご提案します。

セクター別リスクデータに基づくサイバーセキュリティ戦略の再構築:検知から対処、そして予測へ

1. データが示す脅威環境の構造変化と共通課題

サイバー攻撃は、もはや単一の事象ではなく、事業継続性を脅かす構造的なリスクへと変貌しています。この背景には、データで裏付けられた3つの構造変化が存在します。

攻撃対象領域(アタックサーフェス)の指数関数的な拡大: クラウドサービスやリモートワークの普及に伴い、企業が管理すべきIT資産は意図せず増加しています。管理下にない「シャドーIT」やクラウド資産は、攻撃者にとって格好の侵入経路となり、企業の防御境界を曖昧にしています。

攻撃手法の高度化とコモディティ化: 生成AIの悪用により、フィッシングメールの精度は飛躍的に向上し、古典的な「人」の脆弱性を突く攻撃は、より低コストで大規模に実行可能となりました。

セクター別の標的化: 攻撃は無差別ではなく、特定の業界・業種の事業モデルが持つ脆弱性を狙い撃ちにしています。

これらの変化は、業界・規模を問わず、全ての組織に「①リスクの不可視性」「②検知後の対応能力の欠如」「③専門人材の不足」という3つの共通課題を突きつけています。

2. セクター別リスクの定量分析とデータに基づく処方箋

効果的なセキュリティ戦略は、自組織が属するセクター特有のリスクデータを分析することから始まります。

A) 製造業(OT/ICS環境):事業停止リスクの定量化

国内製造業の約9割が制御システム(OT/ICS)の中断を経験したというデータは、単なるインシデント発生率ではありません。これは、「生産停止時間 × 機会損失額」という形で直接的な事業インパクトに換算されるべき極めて重要な経営指標です。スマート工場化でITとOTの融合が進む一方、OT資産のインベントリは不完全なままであり、リスクの全容が把握できていません。

処方箋: 最初のステップは、OT/IoT資産の網羅的なインベントリを作成し、ネットワークトラフィックのベースラインをデータとして定義することです。これにより「正常な状態」を定量化し、逸脱を異常として検知する基盤を構築します。

B) 医療機関:ガイドライン遵守と事業継続性の両立

3省2ガイドラインは、規制であると同時に「遵守すべきセキュリティ統制項目を定義したデータセット」と捉えるべきです。医療機関は、電子カルテ等の機微情報漏えいリスクと、人命に直結する医療機器の安定稼働という二重のリスクを負っています。

処方箋: ガイドライン要件(バックアップ、アクセス制御、脆弱性管理等)に対する自院の充足度をスコア化し、ギャップを可視化することが不可欠です。「統合型サイバープロテクション」は、これら複数の要件を統合的に管理・実装し、スコアを効率的に向上させるための合理的なソリューションとなります。

C) 中小企業:サプライチェーンにおけるリスクポジションの把握

中小企業にとっての最大のリスクは、単独で標的になること以上に、サプライチェーン攻撃の踏み台とされることです。自社のセキュリティレベルを客観的なデータで把握し、取引先に対して安全性を証明する責任が問われています。

処方箋: まずは無料診断などを活用し、自社の「セキュリティスコア」を客観的に把握すべきです。そのスコアに基づき、最も費用対効果の高い対策(例:多要素認証の導入、従業員へのフィッシング訓練)から優先的に投資を配分するデータドリブンなアプローチが求められます。

3. 「検知」から「対処」への壁:運用データ(MTTR)の重要性

Darktraceのような高度なAI検知システムを導入しても、多くの場合、その価値は最大化されていません。「アラートは出るが、それが何を意味し、どう対処すべきか判断できない」という状況は、「データはあるが、インサイトに変換できていない」という典型的な課題です。

ここで最重要となるKPI(重要業績評価指標)が「MTTR(平均復旧時間)」です。アラート発生から脅威の封じ込め、復旧までにかかる時間を計測し、短縮することが、実質的な被害を最小化する上で極めて重要です。専門人材の不足は、このMTTRを致命的に長期化させる要因となります。

この課題に対する解が、専門家によるマネージド・ディテクション&レスポンス(MDR)サービスです。MDRは、24時間365日体制でアラートデータを分析し、脅威のトリアージと具体的な対処法を提示することで、企業のMTTRを劇的に短縮します。これは、自社のリソース不足を補い、セキュリティ投資のROIを最大化するための戦略的選択肢です。

高度な機能を備えたツールを真に活用し、プロアクティブなセキュリティ運用を実現するには、検知したデータを迅速かつ正確に対処に繋げるプロセスと体制の構築が不可欠です。

データに基づくリスク定量化の新潮流:ASMとエクスポージャー管理によるプロアクティブ・セキュリティへの転換

1. 問題の再定義:リスクは「把握できていない資産」に内在する

サイバーセキュリティにおける最大のリスクは、既知の脅威ではなく、「組織が把握できていないIT資産(Unknown Assets)」に存在する「未対応の脆弱性(Unpatched Vulnerabilities)」という組み合わせから生じます。クラウドシフト、リモートワークの常態化、IoT機器の導入加速により、組織の攻撃対象領域(アタックサーフェス)は、もはや手動の資産台帳で管理できる範囲をはるかに超え、指数関数的に増大しています。

アタックサーフェスとは、インターネットに公開されたサーバー、ネットワーク機器、Webアプリケーション、クラウドストレージといった、組織に紐づく全てのデジタル資産のインベントリデータに他なりません。このインベントリの正確性と網羅性が、セキュリティ戦略全体の成否を決定づけるのです。

この課題に対し、アタックサーフェスマネジメント(ASM)、あるいはエクスポージャー管理(Exposure Management)と呼ばれるアプローチが新たな標準となりつつあります。これは、継続的なデータ収集と分析を通じて「未知のリスク」を「既知の管理可能なリスク」へと変換し、定量的な根拠に基づいて対処の優先順位を決定する、データ駆動型の経営管理プロセスそのものです。

2.【ケーススタディ】データ駆動型ガイドライン対応:医療セクターの課題と解

このアプローチの重要性は、特に規制が厳しく、かつリスクが顕在化している医療セクターにおいて顕著です。

「3省2ガイドライン」は、国が医療機関に求めるセキュリティ要件を定義した「遵守べき統制項目のマスターデータ」と解釈できます。医療機関のIT担当者に課せられたミッションは、このマスターデータに対し、自院の現状をマッピングし、客観的なデータでギャップを証明・改善することです。

しかし、多くの医療機関は「予算・IT人材の不足」「パッチ適用が困難な医療IoT機器の増加」といった構造的な課題を抱えています。これは、エクスポージャー管理のプロセスを回す上で深刻な障壁となります。

この課題に対するデータ中心の解決策が、複数のセキュリティ機能を一元管理する「サイバープロテクション」アプローチです。アンチマルウェア、EDR(Endpoint Detection and Response)、バックアップ/DR、パッチ管理といった個別の機能から得られるセキュリティログ(データ)を単一のプラットフォームに統合。これにより、各資産のリスク状態を相関分析し、ガイドラインが要求する包括的な安全管理策を、限られたリソースで効率的に実現・報告することが可能になります。これは、医療情報システムを提供する事業者やSIerにとっても、顧客への付加価値提案の核となるアプローチです。

3. エクスポージャー管理の実践とソリューションの定量的評価

エクスポージャー管理は、以下の継続的なデータライフサイクルとして実践されます。

発見(Discovery): インターネット全体をスキャンし、自組織に関連する全公開資産を特定・データ化。

分析(Analysis): 収集した資産データと脆弱性情報DBを照合し、各資産のリスクスコアを自動算出。

優先順位付け(Prioritization): リスクスコアとビジネスインパクトを基に、対処すべき課題を序列化。

改善(Remediation): 対処を実施し、再スキャンによってリスク低減をデータで確認。

このサイクルを自社で運用することが困難な、特に中堅・中小企業にとって、「WithSecure Elements Exposure Management」のようなSaaSソリューションは、極めて有効な選択肢です。これらのソリューションは、上記サイクルをサービスとして提供し、専門スキルや大規模な初期投資なしに、プロアクティブなリスク管理の導入を可能にします。

ソリューション選定においては、特にクラウド依存度の高い現代のIT環境を鑑み、「クラウド上の資産(設定不備のあるストレージ、公開されたデータベース等)に対する発見・評価能力」を重要な評価指標(KPI)として設定すべきです。

巧妙化するサイバー攻撃に先手を打つとは、攻撃者の視点で自社のエクスポージャー(公開資産とそれに伴う脆弱性)を継続的にデータとして可視化し、最もインパクトの大きいリスクから順に対処していくことに他なりません。その第一歩は、自社のリスクを客観的なデータとして把握することから始まります。