目次

- 1 【脅威インテリジェンス分析】暴露型攻撃グループ「Ransomed.vc」の活動分析とデータ漏洩インシデントの信憑性評価

- 2 【分析レポート】データ駆動型サイバーセキュリティ戦略:ランサムウェアリスクの定量的評価と対策の最適化

- 3 【インシデント・ネットワークトラフィック分析】次世代セキュアアクセス戦略のデータに基づく提言

- 4 インシデントデータ分析が示すランサムウェア対策の最適解:なぜActive Directoryの監視が最優先課題なのか

- 5 データ分析の死角を突くランサムウェア:ストレージテレメトリ分析によるリスク定量化と即時対応のアプローチ

- 6 1. 従来の対策では防げないランサムウェアの進化と現状

- 7 ランサムウェア被害拡大の分析:「バックアップデータ」の破壊を狙う複合攻撃

- 8 データ分断のリスク:実効性の高い多層防御を実現できない運用課題

- 9 セキュリティ診断のコスト最適化戦略:全社的IT資産データの可視化と脆弱性管理

【脅威インテリジェンス分析】暴露型攻撃グループ「Ransomed.vc」の活動分析とデータ漏洩インシデントの信憑性評価

ダークウェブ上にて、新興の脅威アクター「Ransomed.vc」がソニーグループのシステムへの侵入とデータ窃取を主張している。本件は、システムを暗号化せずにデータを窃取し、その販売や暴露を交渉材料とする「暴露型(Extortion-only)」攻撃の典型例であり、サイバー攻撃の収益化モデルの新たな潮流を示している。

本レポートでは、公開情報に基づき、この脅威アクターのプロファイルと、主張されているインシデントの信憑性を複数のデータポイントから客観的に評価する。さらに、この種のデータ漏洩を前提とした脅威に対し、従来のインフラ復旧中心の対策から、データそのものを保護する「データ・セントリック・セキュリティ」への戦略転換を提言する。

1. 脅威アクター分析:Ransomed.vcのプロファイル

分類: 新興の脅威アクター。金融機関やIT企業を標的とした活動が観測されている。

観測されたTTPs(戦術・技術・手順):

攻撃モデル: 暗号化を伴わないデータ窃取と、ダークウェブ上でのデータ販売・暴露。

公開された侵害指標(IoC): 窃取したとされるファイルツリー構造図(約6,000ファイル)。これは侵害の範囲と内容を示す客観的データとして分析価値を持つ。

自己認識と実態の乖離:

Ransomed.vcは自らを「ペネトレーションテスター」や「レッドチーム」であると主張し、活動を脆弱性の指摘であると正当化しようと試みている。しかし、これは許可なき侵入と恐喝を行うサイバー犯罪集団が用いる常套句であり、実際の活動は金銭を目的としたデータ窃取であると分析する。

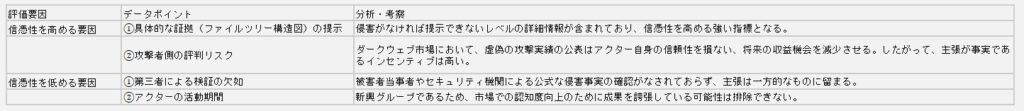

2. インシデントの信憑性に関する定量的・定性的評価

当該インシデントの信憑性について、肯定・否定双方のデータポイントを以下に示す。

総合評価:

提示された証拠の具体性と、攻撃者側の経済的合理性を鑑みると、侵害が事実である蓋然性は比較的に高いと評価できる。ただし、最終的な断定には、漏洩データサンプルの検証など、さらなる客観的証拠が必要である。

3. リスク分析と次世代バックアップ戦略への転換

この事案が示す最も重要な点は、攻撃の主目的が「システムの破壊(暗号化)」から「データの窃取」へとシフトしていることである。これにより、防御側に求められる対応も変化する。

従来のリスク: システム停止による事業継続性の毀損。

新たなリスク: 機密情報、知的財産、個人情報の漏洩による金銭的・信用的損害。

このリスクの変化は、バックアップ戦略が単なる「システム復旧」のためだけでは不十分であることを意味する。攻撃者がバックアップデータ自体の破壊や窃取を狙う現状を踏まえ、データ保護の観点から以下の3つの要素を必須要件として組み込むべきである。

データ不変性(Immutability):

バックアップデータをランサムウェアによる暗号化や悪意ある削除から保護する書き換え不可能な状態で保管する。

物理的・論理的隔離(Air Gap):

本番環境のネットワークから完全に隔離された領域(オフラインメディアや論理的に分離されたクラウドストレージ等)にバックアップを保管し、攻撃者のアクセスを遮断する。

迅速な復旧と侵害調査(Instant Recovery & Forensics):

システムを即座に復旧させる機能に加え、どのデータがいつ漏洩したかを特定するための高速な検索・分析機能を備える。これにより、被害範囲の特定と当局・顧客への説明責任を果たすことが可能となる。

これらの要件を満たすことで、バックアップは単なる復旧手段から、データ漏洩インシデントに対応するための戦略的な資産へと進化する。

【分析レポート】データ駆動型サイバーセキュリティ戦略:ランサムウェアリスクの定量的評価と対策の最適化

日本国内において2024年上半期に観測されたランサムウェア被害件数は114件に達し、依然として高い水準で推移している。このデータは、ランサムウェアが事業継続における予測可能かつ定量化すべきリスクであることを示している。攻撃手法はAI技術の悪用により高度化し、攻撃対象は自社組織内に留まらず、セキュリティレベルの異なるサプライチェーン全体へと拡大している。

このような状況下で、「どこにリスクがあるのか」「どの対策から着手すべきか」といった問いに答えるためには、場当たり的なツール導入ではなく、データに基づいた体系的なリスク管理フレームワークが不可欠である。本レポートは、セキュリティ投資対効果(ROI)を最大化するための、定量的リスク評価と対策の優先順位付けについて論じる。

1. データで見るランサムウェアの脅威動向

ランサムウェア対策を議論する前提として、まず客観的なデータを把握する必要がある。

脅威レベルの定量化:

2024年上半期の被害件数114件という実績は、年間200件を超えるペースでの被害発生を示唆する。これは、業種や規模を問わず、あらゆる組織が常に攻撃対象となり得る状態にあることを意味する。

アタックサーフェス(攻撃対象領域)の拡大:

脅威は組織内部に限定されない。業務委託先や子会社を経由するサプライチェーン攻撃の増加は、自社のセキュリティレベルが、最も脆弱な取引先に依存する構造となっていることを示唆している。自社のリスクを評価する際、これらの外部要因をリスク変数として組み込む必要がある。

対策の困難性:

IT人材の不足と、多様化・複雑化するセキュリティソリューション群は、多くの組織で適切なリスク評価と投資判断を困難にしている。この課題は、勘や経験に頼るのではなく、データに基づいた意思決定プロセスを導入することで解決されなければならない。

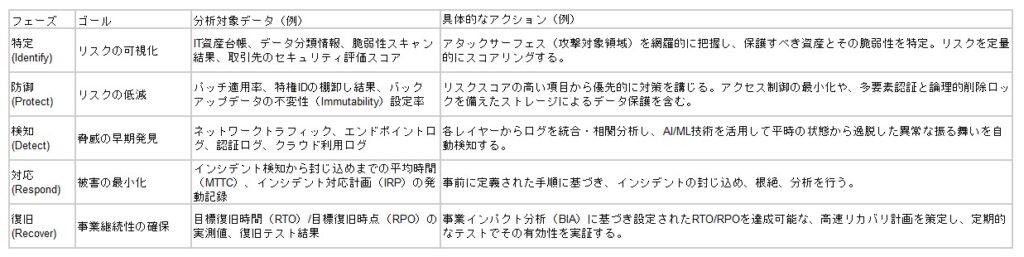

2. リスク管理フレームワーク:NIST CSFに基づくデータドリブンアプローチ

ランサムウェア対策は、「攻撃の前・最中・後」といった時系列の概念を、継続的な改善サイクルとして体系化したフレームワーク(例:NISTサイバーセキュリティフレームワーク)に沿って構築すべきである。以下に、各フェーズで収集・分析すべきデータと、それに基づくアクションを示す。

3. 結論:データ分析を中核としたセキュリティ投資の最適化

ランサムウェア対策の成否は、導入したツールの数や性能だけで決まるのではない。本質的な課題は、限られたリソース(予算・人材)を、どこに投下すれば最も効果的にリスクを低減できるかを判断することにある。

その唯一の客観的な羅針盤となるのがデータである。自組織とサプライチェーンのアタックサーフェスをデータとして「特定」し、リスクを定量的に「評価」し、その評価に基づいて対策の優先順位を決定する。このデータ駆動型のサイクルを確立することこそが、持続可能かつ効果的なランサムウェア対策の要諦である。

【インシデント・ネットワークトラフィック分析】次世代セキュアアクセス戦略のデータに基づく提言

国内で発生した複数の大規模ランサムウェアインシデントを分析した結果、その経済的インパクトは逸失利益数十億円、事業停止期間2ヶ月以上に達するケースが確認されている。これらのデータは、サイバー攻撃が単なるITの問題ではなく、事業継続そのものを揺るがす経営リスクであることを明確に示している。

インシデントデータと侵入経路の相関分析から、従来の境界型防御モデル、特にVPN(Virtual Private Network)が主要な攻撃ベクトルとなっている傾向が強く示唆される。本レポートは、セキュリティリスクの低減と、DX時代に求められるネットワークパフォーマンスの維持という2つの課題を同時に解決するための、データに基づいたアプローチを提言する。

1. インシデントデータの分析:事業インパクトの定量評価

近年の国内ランサムウェアインシデントは、その被害規模において共通のパターンを示している。

経済的インパクト(定量データ):

医療機関の事例: 復旧期間約2ヶ月、調査・復旧費用および診療制限による逸失利益は数十億円規模。

製造業の事例: 取引先企業への攻撃がトリガーとなり、国内全工場の生産ラインが停止。サプライチェーン全体に甚大な影響。

分析とインサイト:

これらの事例データから導き出されるインサイトは、単一のセキュリティインシデントが組織全体の財務およびオペレーションに直接的かつ深刻なダメージを与えるという事実である。リスク評価は、情報システム部門内に留まらず、全社的な事業継続計画(BCP)の中核として再評価される必要がある。

2. 根本原因分析:VPNを起点とする攻撃シナリオ

公開されているインシデント調査報告書を横断的に分析すると、侵入経路としてVPNが悪用されるケースが高い頻度で観測される。その背景には、構造的な2つの問題が存在する。

境界の脆弱性: 旧式のVPN機器に存在する既知の脆弱性が、パッチ未適用のまま放置されている。

内部の無防備さ: 一度VPNによる認証を通過したアクセスに対し、内部ネットワークでのアクセス制御が不十分である。これにより、侵入後の横展開(ラテラルムーブメント)が容易となり、被害の全社的な拡大を許している。

この「境界を越えれば安全」という従来のセキュリティ思想(境界型防御モデル)そのものが、現代の攻撃シナリオに対して有効性を失っていることが、データから明らかである。

3. データに基づく解決策:ゼロトラスト・アーキテクチャへの移行

「脱VPN」は手段であり、目的はセキュリティモデルの抜本的な転換である。その具体的な実装が「ゼロトラスト・ネットワーク・アクセス(ZTNA)」である。

基本原則: 「決して信頼せず、常に検証する(Never Trust, Always Verify)」

データに基づく有効性:

セキュリティ: ネットワークの場所(内部/外部)を問わず、すべてのアクセス要求をユーザー、デバイス、コンテキスト情報に基づき都度認証・認可する。ユーザーとアプリケーションを1対1で論理的に接続するため、万が一侵害が発生しても被害範囲を極小化できる。

パフォーマンス: 従来のVPNのように、すべてのトラフィックを一度データセンターに集約するヘアピン構成を回避できる。ユーザーからクラウドサービスへの直接かつ最適な経路を提供することで、ネットワーク遅延を構造的に削減し、生産性を向上させる。

4. パフォーマンス分析:DX時代のネットワーク可視化

DXの進展はネットワークトラフィックを増大・複雑化させ、「原因不明の遅延」という新たな生産性の阻害要因を生み出している。この問題の解決には、データに基づくアプローチが不可欠である。

課題: 従来のネットワーク監視ツールは、パケットやプロトコルといったインフラレイヤーのデータ分析に留まり、「どのユーザーの、どのアプリケーションの通信が遅いのか」という業務視点でのボトルネック特定が困難。

解決策: 以下のデータを収集・相関分析し、エンドツーエンドでの通信を可視化する。

ユーザー情報: 誰が

端末情報: どのデバイスで

アプリケーション情報: 何の業務を行い

ネットワーク経路と品質: どのような経路で通信しているか

このアプローチ(デジタル・エクスペリエンス・モニタリング:DEM)により、データに基づいた迅速な原因特定とプロアクティブなパフォーマンス改善が可能となる。

5. 結論と提言

ランサムウェア対策とネットワークパフォーマンスの課題は、根本で繋がっている。従来の境界型防御モデルは、セキュリティとパフォーマンスの両面で限界に達している。

提言1:セキュリティモデルの転換

VPNを基軸とした境界型防御から、ZTNAを基本原則とするデータ中心のセキュリティアーキテクチャへ移行する。

提言2:パフォーマンス管理の高度化

インフラ監視から脱却し、ユーザー体感(デジタル・エクスペリエンス)を定量的に測定するDEMを導入し、データに基づいた生産性向上を実現する。

インシデントデータ分析が示すランサムウェア対策の最適解:なぜActive Directoryの監視が最優先課題なのか

現状分析:セキュリティ投資とインシデント発生率の乖離

企業の事業継続性を脅かすランサムウェアの脅威は、依然として高い水準で推移しています。IPAが発表した「情報セキュリティ10大脅威 2024」においても、組織編で4年連続1位となるなど、その影響の深刻さは客観的なデータによって裏付けられています。攻撃手法は「二重脅迫型」のように常に進化しており、過去の対策が通用しないフェーズに移行しています。

多くの企業では、アンチウイルス、UTM、さらにはSIEMやEDRといった先進的なソリューションを導入し、「多層防御」というアプローチでセキュリティ投資を重ねています。しかし、投資額の増加に反して、ランサムウェアの被害報告は後を絶ちません。この事実は、投下したリソースと実際の防御効果の間に、深刻なミスマッチ、すなわち「投資対効果の乖離」が存在することを示唆しています。問題は、導入された各セキュリティ製品が生成する膨大なアラートやログデータが十分に分析されず、実際の攻撃手法との関連付けが行われていない点にあります。

根本原因分析:インシデントデータが明らかにする攻撃のクリティカルパス

我々は、これまで数多くのセキュリティインシデント対応支援を通じて、膨大な量のフォレンジックデータや攻撃フローのログを分析してきました。この実データに基づく分析から見えてきたのは、ランサムウェア被害に至った組織に共通する、統計的に有意なパターンです。

それは、攻撃の初期侵入手法に関わらず、最終的に大規模な被害へ発展する過程で、ほぼ全てのケースにおいて「Active Directory (AD) の管理者権限が奪取されている」という事実です。

攻撃者は、窃取情報の最大化と事業へのインパクトの極大化を目的とします。その目的を達成する上で、組織内の全リソースへのアクセス権を掌握できるADは、最も効率的かつ効果的な標的となります。つまり、ADの侵害は、攻撃成功における「クリティカルパス」であり、ここを抑えることが防御戦略の要諦となります。

データに基づく解決策:攻撃の予兆を捉えるADログのリアルタイム分析

従来のセキュリティ製品では検知が困難な初期侵入や、侵入後の潜伏活動を100%防ぐことは不可能です。したがって、防御戦略の焦点を「侵入後の内部活動の早期検知」へとシフトさせる必要があります。

ここで最も重要なデータソースとなるのが、ADのログです。ADのログには、攻撃者が権限昇格や内部偵察を行う際の、以下のような異常な挙動(アノマリー)が記録されます。

通常業務ではあり得ない深夜帯での管理者アカウントの作成

短時間での複数回にわたるログイン試行

特定のサーバーへの不審なアクセス権の付与

これらの「攻撃の予兆」を示すデータをリアルタイムで検知・分析する体制を構築することが、ランサムウェア被害を未然に防ぐ上で最も費用対効果の高いアプローチです。これは、単にログを収集するだけでは不十分であり、攻撃シナリオに基づいた検知ルールの策定と、常時監視の仕組みが不可欠となります。

本質的な対策とは、流行りのツールを導入することではありません。自組織のインシデントデータや攻撃トレンドを分析し、最も脆弱で、かつ影響の大きいポイント(この場合はAD)を特定し、そこに監視リソースを集中させることです。AD監視による早期検知の具体的な実現方法と、それがいかにしてランサムウェア被害を防ぐかについて、実際の成功事例データと共に解説します。

データ分析の死角を突くランサムウェア:ストレージテレメトリ分析によるリスク定量化と即時対応のアプローチ

現状分析:シグネチャベース検知の限界と観測されていないデータのリスク

ランサムウェア攻撃の検知と防御において、EDRやアンチウイルスといった従来型のセキュリティモデルは、既知の脅威情報(シグネチャ)への依存という構造的な限界を抱えています。攻撃の多様化により、未知のパターンを持つ脅威に対して、これらのモデルが有効に機能しないケースが増加していることは、データが示す通りです。

さらに深刻な問題は、クラウドやBYODの普及によって生じた「データ分析の死角」です。IT部門の管理下にあるエンドポイントのテレメトリデータは収集されていても、最も重要な資産である「データストレージ上でのファイル操作ログ」という、極めて重要なデータストリームが観測・分析されていないのが実情です。結果として、データが暗号化されるという最終段階に至るまで攻撃活動が検知されず、インシデントの平均検知時間(MTTD)が致命的に長期化する事態を招いています。セキュリティ戦略の焦点は、侵入防御から、侵入後の平均復旧時間(MTTR)をいかに短縮するかにシフトすべきです。

課題の再定義:未活用の「ふるまいデータ」がもたらすビジネスインパクト

ランサムウェア被害が継続する根本原因は、「ストレージ層における振る舞いデータの分析基盤の欠如」にあります。エンドポイントでの検知をすり抜けた後の、ファイルサーバー上での異常なアクセスパターン、短時間での大量のファイル書き換えや削除といった挙動は、極めて重要なインシデントの予兆です。しかし、このデータをリアルタイムで収集し、正常な状態からの逸脱(アノマリー)を検知する仕組みがなければ、攻撃を見過ごすことになります。

これは、セキュリティ担当者のリソース不足という運用課題であると同時に、「リスクを定量化するためのデータが不足している」という経営課題でもあります。「どのデータが」「どのようなリスクに」「どの程度さらされているのか」をデータで把握できていないため、有効な対策を講じることができないのです。

データ駆動型解決策:AIによる異常検知と自動化されたデータ保護

この課題に対する最も効果的なアプローチは、セキュリティ対策にデータ分析、特に機械学習を用いた異常検知モデルを導入することです。

NetAppの「Autonomous Ransomware Protection」と「Data Infrastructure Insights」は、まさにこのアプローチを具現化するソリューションです。その仕組みは、データ分析のプロセスそのものです。

データの収集とベースラインの構築:

まず、ストレージ上のファイル操作に関する膨大なテレメトリデータをAIが継続的に収集します。これにより、平常時のアクセスパターンやファイル変更頻度といった「正常な状態の統計的ベースライン」を動的に学習・構築します。

リアルタイムでの異常検知:

新たなファイル操作が発生すると、その挙動が統計的ベースラインからどの程度逸脱しているかをリアルタイムで評価します。例えば、単一ユーザーによる異常な速度でのファイル暗号化(書き込み)といった、統計的に発生確率の低いイベントを「アノマリー」として即座に検知します。

自動化されたインシデント対応:

異常検知をトリガーとして、即座にデータの健全な状態を保証するスナップショット(バックアップ)を自動で取得します。これにより、被害の範囲を最小限に抑え、目標復旧時点(RPO)を限りなくゼロに近づけることが可能です。

さらに、強力なダッシュボード機能は、インシデント発生時に「何が起きたか」をデータで可視化し、迅速な原因分析とレポーティングを支援します。これは、専門知識を持つ人材の運用負荷を低減しつつ、データに基づいたインシデント対応体制を構築する、極めて実践的なランサムウェア対策です。

1. 従来の対策では防げないランサムウェアの進化と現状

企業や組織の事業継続を脅かすセキュリティ・インシデントは年々増加しており、特にランサムウェアは深刻な脅威となっています。IPA(情報処理推進機構)が発表する「情報セキュリティ10大脅威 2025(組織編)」では、ランサムウェア被害が5年連続で第1位となっています。

ランサムウェアの攻撃手法は「二重脅迫型」など高度化・巧妙化しており、従来の対策だけでは防御が困難になっています。企業は多層防御を実施し、アンチウイルスソフトウェアやUTM(統合脅威管理)だけでなく、SIEM(セキュリティ情報・イベント管理)やEDR(Endpoint Detection and Response)を導入するケースも増えています。しかし、実際の被害事例を分析すると、攻撃手法と対策のミスマッチが原因で、ランサムウェアの侵入を防ぎきれないケースが多発しています。

2. ランサムウェア被害の本質:データ分析で明らかになる攻撃の実態

ランサムウェア攻撃の目的は、身代金の受け取り成功率を高めるために、企業の重要データを窃取し、大規模なシステム障害を引き起こすことです。そのため、攻撃者は企業のネットワーク全体を掌握しようとします。

データ分析の観点から見ると、攻撃者が最も狙うのは Active Directory(AD) です。ADは組織内のユーザー、グループ、コンピューター、およびセキュリティ権限を管理しており、これを乗っ取ることで企業ネットワークの完全な制御が可能となります。

弊社が対応したランサムウェア被害の分析結果では、ほとんどのケースでADの管理者権限が乗っ取られていた ことが判明しています。この事実から、従来のセキュリティ対策に加え、ADの監視が不可欠であることが明確になりました。

3. データ可視化による早期検知:最優先すべきAD監視の重要性

ランサムウェアの初期侵入や侵入後の挙動は、一般的なセキュリティ製品では検知が困難です。そのため、ADの適切な監視 が、ランサムウェア対策において最も重要な早期検知手法となります。

具体的には、以下の施策が求められます。

ADログの取得設定の最適化:攻撃を検知するために、適切なイベントログを取得し、リアルタイムで監視。

異常行動の検知:通常のユーザー活動と異なる挙動をAIや機械学習を活用して分析し、不正アクセスを即時に特定。

即時対応体制の構築:疑わしい動きがあった場合に、迅速に対処するためのインシデント対応プロセスを整備。

4. インシデント対応の実例とデータ主導の対策

豊富なセキュリティ事故対応の経験を持つS&Jが、日本で発生しているランサムウェア被害の攻撃手法や攻撃フローをデータ分析の観点から解説します。

また、従来型セキュリティ対策とのミスマッチをどのように解消すべきか、具体的な事例をもとに解説し、AD監視による早期検知の実現方法を詳しくご紹介します。

データ駆動型のアプローチでランサムウェアの脅威を最小化し、組織のセキュリティ強化を実現するための実践的な対策をお伝えしますので、ぜひご参加ください。

ランサムウェア被害拡大の分析:「バックアップデータ」の破壊を狙う複合攻撃

ランサムウェア被害拡大の分析:「バックアップデータ」の破壊を狙う複合攻撃

近年のランサムウェア攻撃は、標的をデータ本体だけでなく、バックアップ環境にも拡大させています。これは、単なる暗号化によるシステム停止だけでなく、事業継続性という最重要データの復元を完全に不能に追い込むことを目的としています。

製造業・建設業においては、図面や工程データといった重要情報の喪失リスクが特に高まっており、「復旧不能」という事態は、深刻な事業停止へと直結しかねません。

日々のバックアップを実施しているにもかかわらず、インシデント発生時に「復旧できなかった」という製造業・建設業の事例が増加しています。

CADデータや工程管理システムのリストアに時間がかかる、あるいはデータの整合性が取れないといった課題は、現場の稼働に直接的な影響を与えます。これは、バックアップデータの信頼性に対する組織の認識が、現実のリスクレベルと乖離していることを示しています。

製造業・建設業の業務特性を踏まえ、「復旧前提」のデータレジリエンスに特化したバックアップ・リストア環境構築を解説します。

確実なデータ保全: 設計・施工・製造データを確実に守るためのストレージ構成や、ランサムウェアに強いイミュータブル(不変)な仕組みの導入。

多層防御の実践: バックアップ環境自体を守るための多層防御戦略を実践し、データ保全の信頼性を確保します。

医療DXの加速により、電子カルテや画像診断装置などの重要診療データがネットワーク化され、利便性は向上しました。しかし、同時にこれらのシステムが新たなサイバー攻撃の標的となっています。

近年ではAIを悪用したランサムウェアが登場し、感染経路の巧妙化や自動拡散が進行しています。警察庁の統計でも医療分野の被害報告は年々増加しており、業務停止や救急診療の中断といった深刻な影響が現実化しています。もはや「医療は守られている」という前提はデータ上崩壊しており、患者データと業務を継続的に守るレジリエンス戦略が不可欠です。

従来、医療機関はバックアップを「最後の砦」として対策を行ってきました。しかし最近のランサムウェアは、バックアップ領域やクラウドストレージをも標的にし、データを暗号化・削除する手口を用いています。さらに、暗号化したデータを復旧できなくした上で患者情報を流出させ、身代金を要求する「二重恐喝」が多発しています。

こうした攻撃により、システムが停止し診療データが失われると、病院業務の継続は困難になります。限られたITリソースと予算の中で、いかにして迅速に復旧できる仕組みを整えるか、復旧時間目標(RTO)の達成が喫緊の課題となっています。

データ分断のリスク:実効性の高い多層防御を実現できない運用課題

データ分断のリスク:実効性の高い多層防御を実現できない運用課題

多くの企業では、VPNやオンプレミスの環境を前提に構築されたセキュリティ体制を維持していますが、クラウド活用の拡大に伴い、防御層の統合が進まず運用の複雑化が進んでいます。EDR(Endpoint Detection and Response)が攻撃検知というエンドポイントデータを担う一方で、認証・アクセス管理・監査ログは別々のシステムで動作しており、相互の関連性という分析データが見えないまま対処が遅れるケースが少なくありません。

「誰が」「どこから」「何に」アクセスしているのかという横断的なアクセス行動データを把握できなければ、実効性のある多層防御は機能しません。このデータ分断された運用体制こそが、攻撃の拡散を許す最大のリスクとなっています。

私たちは、既存のEDRを補完する「統合型防御アーキテクチャ」の実装手法を解説します。具体的には、ISL Online、UserLock、Token2、FileAuditなどのオーシャンブリッジ製品群を活用し、ユーザー認証からアクセス管理、ファイル操作の監査までを一気通貫でデータとして可視化し、異常行動を即座に検知する仕組みを紹介します。

ゼロトラストを前提とした防御設計を、現場運用者が無理なく導入できるよう設計することで、EDRの検知精度というデータを高め、被害拡大を未然に防ぐ「実践的な多層防御」を実現します。

さらに、Ansible Playbookの品質や設定を自動的に検証し、依存関係の可視化を可能にするSBOM(Software Bill of Materials)生成に対応したSteampunk Spotterについても紹介します。これにより、認証・アクセス管理といった運用レイヤーだけでなく、インフラ自動化そのものの安全性を確保し、構成の脆弱性や誤設定を事前に検出できるなど、より強固で抜け穴のないセキュリティ体制の構築を支援します。

多くの企業でクラウド移行が進む一方、基幹システムや社内業務を支える重要なシステムは、依然としてオンプレミス環境で安定稼働しています。

しかし、日常業務に支障がないため、運用やセキュリティ対応の優先度が下がり、構成情報の更新漏れやパッチ適用の遅れといった運用上のリスクデータが生じることがあります。こうした状況は、クラウド中心の運用体制を採る企業にとって、見過ごされがちな重大なリスクとなり得ます。

ランサムウェア感染時の体制として、以下の項目は事業継続性(BCP)を担保するために必須です。これらのプロセスを事前にマニュアル化し、訓練を通じてその有効性データを検証しておくことが重要です。

バックアップからの復旧体制

ランサムウェア感染時の対応マニュアル化

社内でのインシデント報告と初動体制(トリアージプロセス)

外部専門家への相談体制・インシデント・レスポンスサービスの契約

インシデントの公的機関への届け出体制

MDRや製品ベンダーによるサポート契約

取引先などインシデント発生時のステークホルダーへの連絡体制(透明性の確保)

インシデント発生時の顧客への連絡体制

セキュリティ診断のコスト最適化戦略:全社的IT資産データの可視化と脆弱性管理

セキュリティ診断のコスト最適化戦略:全社的IT資産データの可視化と脆弱性管理

サイバー攻撃から組織を守る上で、「セキュリティ診断」は重要な役割を果たします。一般的にセキュリティ診断とは、システムやネットワーク、Webアプリケーションなどに存在する脆弱性データを発見し、攻撃リスクを定量的に評価するための調査・検査を指します。

しかし、多くのシステムやサービスは日々更新され、構成変更や新規公開によって新たな脆弱性が発生する可能性が常にあるため、一度の診断では不十分です。また、攻撃手法や脆弱性情報は日々進化しており、最新の攻撃動向データに基づいて再評価することで、防御力を高めることが可能です。

特に子会社やグループ会社を保有する企業では、外部公開IT資産の棚卸しが不十分であったり、大量のIT資産に対する最新のセキュリティ状況を把握できていないという深刻な課題が散見されます。

それらの資産情報を適切に把握した上で全社的な対策ができなければ、サイバー攻撃などのセキュリティ・インシデントのリスクを高める原因となります。その一方で、全ての外部公開資産にセキュリティ診断を実施しようとすると、膨大なコストや手間がかかってしまうのが現状です。

このような状況において、サイバー攻撃からIT資産を守るには、コストを抑えて効率的に脆弱性診断を実施する戦略が必要です。その鍵は、「攻撃者の行動原理を理解し、戦略的に対処する」ことにあります。

サイバー攻撃の最新動向データをもとに「なぜ、攻撃者は外部公開資産を狙ってくるのか」を解説するとともに、セキュリティ強化の初歩として外部公開資産を把握し、インベントリデータとして管理することの重要性を解説します。

さらに、攻撃者の行動原理を踏まえた上で、限られた予算でも効率的に脆弱性管理を実現する方法をご提案します。特に、「組織内の様々な部署が大量のサイト(ドメイン)を管理している」「子会社やグループ会社など、多くの外部公開IT資産の管理に課題がある」という組織に推奨いたします。効率的な脆弱性管理による「診断コスト最適化」のポイントを知りたい方は、ぜひご参加ください。

近年のランサムウェアは、従来の単純な暗号化型から進化し、標的型攻撃、情報窃取、認証情報の奪取、内部拡散を組み合わせた多層的な脅威へと変貌しています。EDR(Endpoint Detection and Response)は依然として重要な防御手段ですが、侵入後の権限濫用や横展開の防止まではカバーしきれないという限界が顕在化しています。

特に、リモートアクセスやクラウド連携が常態化する現在、境界型防御に依存した設計ではデータセキュリティの穴が生じやすい状況です。攻撃の初期段階で不審な認証操作やアクセス挙動といった行動データを検知・遮断できる仕組みが、今、企業に求められています。