目次

- 1 データ主権とAI時代の生産性を両立する、次世代ワークプレイス戦略の提言

- 2 リモートワーク環境におけるデータ保護と事業継続性の両立

- 3 HPE GreenLakeが提供するデータ主導のVDIソリューション

- 4 【定量的分析】VMware顧客動向データから読み解く市場構造の変化と次世代ITインフラ戦略

- 5 【市場分析】AWSの新戦略が示すハイブリッドクラウド市場の動向とデータに基づいたインフラ選定

- 6 【市場動向分析】VMware代替戦略としてのAWSとRed Hatの連携強化とそのデータ的根拠

- 7 VMwareの戦略転換にどう向き合うか:データに基づいた次世代仮想化基盤の意思決定フレームワーク

- 8 リモートワーク環境のデータガバナンスとセキュリティリスク:既存VDI環境が抱える構造的な課題

データ主権とAI時代の生産性を両立する、次世代ワークプレイス戦略の提言

【現状分析と課題定義】

デジタルトランスフォーメーションが加速する現代において、企業の競争力は、データをいかに安全かつ迅速に活用できるかに大きく依存します。しかし、多くの企業が以下の構造的なジレンマに直面しています。

データ漏洩リスクと生産性のトレードオフ:

PCへのローカルデータ保存は、重大な情報漏洩インシデントに直結するリスク要因です。一方で、従来のVDI(仮想デスクトップ基盤)は、セキュリティを確保する代償として、レスポンスの遅延やアプリケーションの動作制限といった生産性の低下を招くケースが散見されます。

データガバナンスの形骸化:

クラウドサービスの利用拡大や外部AIとの連携は、データの物理的・法的な所在を曖昧にし、厳格なデータガバナンスの維持を困難にしています。「データは手元(オンプレミス)で管理したい」という統制上の要求と、「クラウドの俊敏性を享受したい」という事業部門の要求が、IT戦略の方向性を複雑化させています。

既存インフラのパフォーマンス限界:

AIや機械学習、高度なデータ分析ツールの業務利用が本格化するにつれ、従来のVDI/DaaS基盤では、GPU性能の不足から深刻なパフォーマンスボトルネックが発生。これが業務効率を著しく阻害し、データドリブンな意思決定の遅延を招いています。

これらの課題は、単なるインフラの問題ではなく、企業の成長を阻害する経営レベルの課題です。場当たり的な対策では、このトリレンマを解消することはできません。

【課題解決への新たなアプローチ】

VDI/DaaS基盤の更新は、単なるリプレースではなく、データ活用時代の新たなワークプレイスを再定義する好機です。我々は、その解として「ハイブリッドVDI + GPUアクセラレーション」というアーキテクチャを提唱します。

このアプローチは、オンプレミス環境(Azure Stack HCI)で稼働するAzure Virtual Desktopに、NVIDIAの高性能GPUを組み合わせることで、前述のトリレンマを解消します。

データ主権の確立: 機密性の高いデータとアプリケーションをオンプレミスで保持・実行することで、厳格なセキュリティポリシーと規制要件への準拠を保証します。

パフォーマンスの最大化: GPUパワーを仮想デスクトップに割り当てることで、AI開発、CAD/CAM、大規模データ分析といった高負荷業務でも、ローカルPCと遜色ない、あるいはそれ以上のパフォーマンスを実現。従業員の生産性を最大化します。

クラウドの俊敏性の獲得: Azureの管理プレーンを活用することで、運用の効率化と、ビジネス要求に応じた柔軟なスケーラビリティを両立します。

【得られる知見】

各分野をリードする専門家が、この次世代ワークプレイス戦略の具体的な実現方法と、それによってもたらされるビジネスインパクトを解説します。

貴社のデータガバナンスを強化し、同時にデータ活用による競争優位性を確立するための、具体的かつ実践的なヒントを提供します。

【バージョン2:データアナリスト・IT管理者向け】

タイトル:VDIのパフォーマンスボトルネックを解消し、データ分析とAI活用を加速させる実践的アプローチ

【提起する技術的課題】

VDI/DaaS環境におけるパフォーマンス劣化は、エンドユーザーの生産性低下に留まらず、データ分析やAI開発といった高度なワークロードの実行を阻害する深刻な問題です。特に、以下の課題が顕在化しています。

CPU負荷の増大: 近年のアプリケーションはリッチ化が進み、CPUリソースの消費が増大。VDI環境ではこれがパフォーマンスの直接的なボトルネックとなっています。

GPUリソースの欠如: データ可視化ツール、機械学習モデルのトレーニング、CAD/CAEといったGPUを要求するアプリケーションの利用が、従来のVDIアーキテクチャでは非現実的です。

データ配置の非効率性: 分析対象のデータがファイルサーバーやクラウドストレージに散在している場合、VDIセッションへのデータ転送がレイテンシーを発生させ、分析業務の効率を著しく低下させます。

これらの課題を放置することは、データ活用基盤としての価値を損なうことに繋がります。

【課題解決のソリューションアーキテクチャ】

従来のVDIの概念を覆す、新たな選択肢が登場しています。それが、オンプレミスで稼働するAzure Virtual DesktopとNVIDIA GPUを統合した「ハイブリッドVDI」ソリューションです。

このアーキテクチャが、技術的課題をいかに解決するかを解説します。

GPUオフロードによるパフォーマンス最適化:

NVIDIA GPUを仮想環境にパススルーまたは仮想化(vGPU)して割り当てることで、グラフィックス処理や並列演算をCPUからオフロード。アプリケーションのレスポンスを劇的に改善し、CPUリソースを他の処理に解放します。

データとコンピュートの近接配置:

Azure Stack HCIのようなHCI(ハイパーコンバージドインフラ)上にVDIとデータを同居させることで、データアクセスにおけるネットワークレイテンシーを最小化。テラバイト級のデータセットを扱う分析業務においても、高速な処理を実現します。

一貫性のある管理とセキュリティ:

Azureを管理プレーンとして利用することで、オンプレミスのVDI環境をクラウドサービスと同様の感覚で効率的に管理・展開できます。同時に、機密データは物理的に分離されたオンプレミス環境で保護され、厳格なセキュリティ要件を満たします。

【テクニカル・ディープダイブ】

この「Azure Virtual Desktop on Azure Stack HCI + NVIDIA GPU」ソリューションについて、技術的な観点から深掘りします。

各社のエンジニアが、アーキテクチャ設計のポイント、パフォーマンスベンチマーク、導入事例、そして貴社環境におけるROI(投資対効果)の試算方法まで、具体的な情報を提供します。既存のシンクライアント基盤の性能課題に直面しているインフラ担当者、データ分析基盤の刷新を検討しているデータサイエンティストにとって、重要な内容です。

リモートワーク環境におけるデータ保護と事業継続性の両立

リモートワークの普及は、企業のデータ管理とセキュリティ戦略に新たな課題を提起しています。コロナ禍以前、フルタイムのリモートワーカーは全体の8%に過ぎませんでしたが、2022年5月にはその割合が約4割程度へと4倍以上に増加しました。この傾向は今後も継続すると予測されており、場所に依存しない柔軟な働き方を支えるITインフラの再設計が急務となっています。

本稿では、データ活用の観点からリモートワーク環境の課題を分析し、その解決策としてのVDI(仮想デスクトップインフラストラクチャ)の有効性、特にas-a-serviceモデルがもたらす価値について解説します。

データに基づき顕在化するリモートワークの課題

リモートワークへの移行は、従業員の生産性向上に寄与する一方で、データガバナンスの観点からは以下の3つの主要なリスクを増大させます。

エンドポイントの多様化とセキュリティリスクの増大: 従業員が私有のデバイス(PC、タブレット、スマートフォン)を利用するBYOD環境では、デバイスごとのセキュリティレベルのばらつきが、情報漏洩やマルウェア感染の起点となるリスクを高めます。

データアクセス経路の分散: データが社内ネットワーク外からアクセスされる機会が増えることで、アクセス制御やログ監視が複雑化し、不正アクセスや内部不正のリスク管理が困難になります。

パブリッククラウド利用の限界: 迅速な環境構築が可能なパブリッククラウドは有力な選択肢ですが、機密情報や個人情報を取り扱う場合、データ主権(データが保存される国や地域の法規制に従うこと)やプライバシー、レスポンス性能の観点から、データをオンプレミス(自社管理下の設備)に保持する必要があるケースも少なくありません。

解決策としてのVDI:データの一元管理によるリスク低減

これらの課題に対する有効なアプローチが、VDI(仮想デスクトップインフラストラクチャ)の活用です。VDIは、デスクトップ環境をサーバー上に集約し、ユーザーはネットワーク経由で画面情報のみを受け取る仕組みです。これにより、以下のメリットが期待できます。

データ非保持による情報漏洩リスクの最小化: 従業員のデバイスにはデータが一切保存されないため、デバイスの紛失、盗難、不正な持ち出しによる直接的な情報漏洩リスクを根本から排除します。

セキュリティポリシーの集中的な適用: すべてのデスクトップ環境がデータセンターで一元管理されるため、セキュリティパッチの適用やアクセス制御を効率的かつ網羅的に実施でき、ガバナンスを強化します。

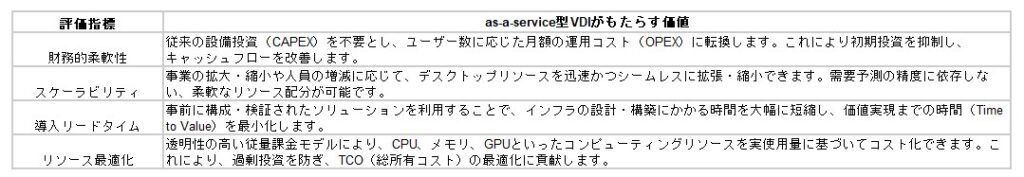

as-a-service型VDIによる投資対効果の最大化

VDIの導入形態には、自社でインフラを構築するオンプレミス型と、サービスとして利用するas-a-service型が存在します。特に後者は、近年のビジネス環境の変化に柔軟に対応するための優れた特性を備えています。

as-a-service型VDIは、オンプレミスが持つセキュリティ、パフォーマンス、コンプライアンスといった利点を維持しつつ、クラウドの持つ「俊敏性」と「柔軟性」を両立させるモデルです。このモデルがもたらすビジネス価値は、以下の指標で評価できます。

HPE GreenLakeが提供するデータ主導のVDIソリューション

HPE GreenLakeは、as-a-serviceモデルでVDI環境を提供するプラットフォームです。このソリューションは、オンプレミス環境にクラウドの運用モデルを適用することで、セキュリティとデータ主権を確保しながら、ビジネスの要求に応じた柔軟なリソース活用を可能にします。

特筆すべきは、多様な従業員の業務内容(ナレッジユーザー、タスクユーザー、開発者、設計者など)に合わせて、CPU、GPU、メモリの最適な組み合わせをカスタマイズ提供できる点です。これにより、従業員一人ひとりの生産性を最大化すると同時に、オーバースペックによる無駄なコストを排除し、投資対効果(ROI)を最大化するデータ駆動型のアプローチを実現します。

外部の専門家がプラットフォームの運用管理を担うため、情報システム部門の担当者は煩雑なインフラ保守から解放され、データ分析やDX推進といった、より付加価値の高い戦略的業務にリソースを再配分することが可能になります。

このように、データ保護と柔軟な働き方を両立させるためには、as-a-service型VDIのような、データガバナンスを維持しつつ、ビジネスの俊敏性を高めるITインフラ戦略が不可欠です。

【定量的分析】VMware顧客動向データから読み解く市場構造の変化と次世代ITインフラ戦略

最近の市場調査データは、仮想化市場のリーダーであるVMwareの顧客動向に、看過できない変化が起きていることを示唆しています。本稿では、公開されたデータを基に現状を客観的に分析し、企業が今後取るべきデータドリブンな意思決定について考察します。

データが示す顧客動向:約9割程度が代替案を検討

企業向けソフトウェアサポートベンダーRimini Streetが実施した調査によると、VMwareを利用する顧客の約9割程度が、現行システム環境の少なくとも一部について代替案を「既に使用している」「使用を計画している」、または「検討している」と回答しました。

この背景には、2023年11月のBroadcomによるVMware買収以降の、ライセンス体系と製品ポートフォリオの大幅な変更があります。この変化が顧客のIT戦略および予算計画に与える影響は、データによって明確に示されています。

移行検討の主要因:機能への満足とコスト懸念の二律背反

今回の調査データで最も注目すべき点は、顧客が抱える二律背반の状況です。

経済合理性の懸念:

代替案を模索する最も主要な理由として、回答者の約4割程度が「予算の制約」を挙げています。

さらに、約9割程度もの回答者が、今後12〜18ヶ月以内に追加の値上げが発生すると予測しており、将来的なTCO(総所有コスト)の増大と予測困難性に対する強い懸念がうかがえます。

製品機能への高い評価:

その一方で、回答者の約8割程度は、現在利用している永続ライセンス版のVMware製品が「自社のビジネス要件を適切に満たしている」と回答しています。

これらのデータを組み合わせることで導き出される結論は、「顧客のVMware離れの動機は、製品の技術的な欠陥や機能不満ではなく、新たなライセンスモデルと価格設定というビジネス的・経済的要因に起因する」という事実です。永続ライセンスからサブスクリプションモデルへの強制的な移行は、IT資産の所有形態を根本から変えるものであり、多くの企業がその影響を慎重に評価し始めています。

市場への影響と移行の現実性に関する分析

この市場の地殻変動は、競合ベンダーにとって大きな事業機会となっています。特にRed Hat社のコンテナプラットフォーム「OpenShift」や、AWSをはじめとする主要クラウドサービスは、VMware環境からの移行先として積極的に受け入れ態勢を構築しています。

しかし、実際の移行は単純なプロセスではありません。ITインダーProact IT Groupの専門家が指摘するように、特にVMwareのエコシステムに深く依存している大企業にとって、全面的な移行は技術的負債や運用上の観点からリスクが高く、容易ではありません。

企業の規模によって、最適な戦略は異なると考えられます。

大企業: エコシステムへの依存度を定量的に評価し、リスクを最小化する段階的な移行や、VMware環境と他のプラットフォームを併用するハイブリッド戦略を検討する必要があります。

中小規模企業: より迅速に、他のハイパーバイザーや大手クラウドサービスへのフルクラウドシフトを進めることが、コスト最適化の観点から合理的な選択となる可能性があります。

データに基づいた次世代仮想化戦略への提言

この不確実な状況において、企業が取るべきは、憶測ではなくデータに基づいた冷静な意思決定です。データコンサルタントの視点から、以下の3つのステップによるアクションプランを推奨します。

現状資産の定量的評価(As-Is Analysis):

まず、自社が利用するVMware製品の棚卸しを行い、各ワークロードの重要度、アプリケーションの依存関係、そして新ライセンス体系を適用した場合のTCO(総所有コスト)を精密に試算し、現状を可視化します。

代替シナリオの比較分析:

VMware環境の維持・最適化シナリオに加え、Red Hat OpenShiftへのコンテナ化、他のハイパーバイザーへの移行、パブリッククラウドへのリフト&シフトなど、複数の代替シナリオを策定します。それぞれのシナリオについて、移行コスト、ランニングコスト、機能要件充足度、運用負荷、潜在的リスクを定量的に比較評価します。

データドリブンなロードマップの策定:

比較分析の結果に基づき、自社のビジネス戦略と最も整合性の高いITインフラの将来像を定義します。その上で、事業への影響を最小限に抑えつつ、投資対効果(ROI)を最大化するための具体的な移行ロードマップを策定します。

市場の変化はリスクであると同時に、自社のITインフラ全体を再評価し、最適化する好機でもあります。客観的なデータ分析に基づいた戦略策定こそが、この変動期を乗り越えるための鍵となります。

【市場分析】AWSの新戦略が示すハイブリッドクラウド市場の動向とデータに基づいたインフラ選定

2024年12月にAWSが発表した新機能群は、同社の市場戦略における重要な方向転換を示唆しており、企業のITインフラ戦略に新たな評価軸をもたらすものです。本稿では、これらの発表内容をデータに基づき分析し、その戦略的意図と市場への影響を考察します。

データポイント:Amazon EKSの新機能が提供する価値

今回発表されたAmazon EKS(Elastic Kubernetes Service)の2つの新機能は、Kubernetesの運用モデルを大きく変える可能性を秘めています。

Amazon EKS Hybrid Nodes:運用管理の一元化

この機能は、オンプレミスとAWSクラウド上に分散するKubernetesノード群を、AWSが管理する単一のコントロールプレーンから統合制御することを可能にします。従来、EKS Anywhereなどのサービスではコントロールプレーンの管理はユーザー側に委ねられていました。これをAWSのマネージドサービスとすることで、インフラ管理の複雑性が低減され、運用コスト(OPEX)の削減と、一貫したセキュリティ・ガバナンスポリシーの適用が期待できます。

Amazon EKS Auto Mode:運用自動化によるTCO削減

コンピューティングリソース、ストレージ、ネットワークの管理を自動化するこの機能は、プライベートクラウド構築基盤であるVMware Cloud Foundation (VCF) が提供する運用体験を意識したものと分析できます。リソース管理を自動化することで、人的エラーの削減とインフラ運用に関わる工数を削減し、TCO(総所有コスト)の最適化に直接的に貢献します。

戦略分析:AWSのハイブリッドクラウド戦略への明確な転換

これらの機能群が示すのは、AWSの戦略が従来の「AWSへの完全移行」から、「顧客のオンプレミス資産を許容し、AWSのエコシステムに取り込むハイブリッドクラウド戦略」へと大きく舵を切ったという事実です。

HyperFrame Research社の分析にあるように、多くの企業がオンプレミス環境の継続利用やマルチクラウド構築を重視する傾向にあります。AWSは、この市場データを真摯に受け止め、顧客の現実的なニーズに応える形でサービスポートフォリオを拡張したと考えられます。これは、単なる機能追加ではなく、市場の要求に応じた戦略的な方向転換です。

背景と狙い:VMware市場の変動を捉えたエコシステムの拡大

この戦略転換の背景には、BroadcomによるVMware買収以降に生じている市場の不確実性があります。AWSの狙いは、VMwareからの移行を検討する企業にとって、有力な受け皿となることです。

その意図は、2024年12月に発表された生成AIサービス「Amazon Q」に、VMwareワークロードの移行を支援する機能が標準で組み込まれていることからも明確に読み取れます。さらに、移行を検討するユーザーの懸念を払拭するため、以下のようなVMware環境で慣れ親しんだ運用体験を提供する機能強化も進めています。

VM管理用のGUIコンソール: CUI(コマンドライン)操作に不慣れな管理者でも直感的な操作を可能にし、学習コストを低減します。

ストレージの無停止拡張(ホットプラグ): ダウンタイムなしでのリソース拡張を可能にし、事業継続性を高めます。

複数システムでの同時稼働(アクティブ/アクティブ構成)の強化: 高可用性が求められる基幹システムの移行を支援します。

これらは、VMwareからの移行における技術的・心理的な障壁を取り除くための、具体的な戦術であると分析できます。

データドリブンなITインフラ戦略への提言

今回のAWSの発表を受け、企業は自社のITインフラ戦略をデータに基づいて再評価する必要があります。

TCO(総所有コスト)の再評価:

オンプレミス環境の維持、AWSが提供するハイブリッドクラウドへの移行、あるいは他クラウドを含むフルクラウド移行の各シナリオについて、ライセンスコスト、運用人件費、インフラコストを含めた今後3〜5年間のTCOを精密に試算し、比較検討することが不可欠です。

アプリケーション・モダナイゼーションの加速:

KubernetesをベースとするAWSのハイブリッド戦略は、コンテナ化によるアプリケーション・モダナイゼーションを推進する絶好の機会です。どのアプリケーションからコンテナ化を進めるべきか、そのROI(投資対効果)を評価し、具体的なロードマップを策定すべきです。

ベンダー依存リスクの分析:

AWSのマネージドサービスは運用負荷を大幅に軽減する一方、特定ベンダーへの依存度を高める側面もあります。自社の事業戦略における技術的柔軟性の重要度を評価し、メリットとリスクを天秤にかけた上で、最適なプラットフォームを選択するべきです。

【市場動向分析】VMware代替戦略としてのAWSとRed Hatの連携強化とそのデータ的根拠

2023年11月のBroadcomによるVMware買収と、それに続くライセンス体系の変更は、仮想化市場に大きな構造変化をもたらしています。多くの企業でTCO(総所有コスト)やライセンス体系の先行き不透明感に対する懸念が高まっており、これが競合ベンダーにとって新たな市場機会を生み出しています。

本稿では、特にAWSとRed Hatの戦略的連携強化という具体的なデータポイントに基づき、VMwareを中心としたハイブリッドクラウドからの移行パスがどのように構築されつつあるかを分析します。

データポイント:2024年12月のAWSとRed Hatの提携強化

2024年12月に発表された両社の提携強化は、VMwareからの移行を検討する企業に対し、具体的な選択肢を提示するものです。主要な発表内容は以下の2点に集約されます。

Red Hat OpenShift on AWS (ROSA)における仮想マシン実行機能のサポート強化:

AWS上で提供されるマネージドOpenShiftサービス(ROSA)において、仮想マシン(VM)とコンテナを統合管理する「Red Hat OpenShift Virtualization」に対するAWSの技術支援が強化されます。

Amazon EC2ベアメタルインスタンス上でのOpenShift提供:

ユーザーが自社で管理するセルフマネージド型のOpenShiftを、Amazon EC2の物理サーバー上で利用可能になります。これにより、より高度なカスタマイズや厳密なパフォーマンス要件への対応が可能となります。

戦略的インプリケーションの分析

この提携強化は、単なる技術協力に留まりません。データに基づき、その戦略的意図を読み解くと、以下の2点が明確になります。

VMware Cloud on AWSからの移行パス提示:

アナリストの分析によれば、この動きはAWS上でVMware環境を稼働させる「VMware Cloud on AWS」の既存ユーザー、およびVMware製品でオンプレミス環境を構築している企業群を明確なターゲットとしています。ROSAとOpenShift Virtualizationの組み合わせは、VMware環境と同等の機能を、クラウドネイティブな技術スタックで実現するための受け皿として機能します。

データ駆動型での移行候補の特定:

theCUBE Researchのアナリスト、ロブ・ストレチェイ氏が指摘するように、この戦略の核心は「実際のVM移行事例を分析し、OpenShift Virtualizationへの移行に最適なワークロードを見極める」というデータ駆動型アプローチにあります。AWS Marketplaceを通じてRed Hatの移行サービスを提供しやすくすることで、Red HatとAWSは移行プロジェクトのデータを収集・分析し、成功率の高いユースケースを特定して、今後のマーケティングや開発に活かすことが可能になります。

OpenShift Virtualizationの提供価値とその採用データ

OpenShift Virtualizationが移行先として注目される技術的根拠は、その独自のアーキテクチャにあります。

アーキテクチャ: 従来の「VM内でコンテナを動かす」構造とは逆に、「コンテナ内でVMを動かす」というアプローチを採用しています。

提供価値: この構造により、Kubernetesという単一のオーケストレーションツールを用いて、既存のVM資産(レガシーワークロード)と新規のコンテナアプリケーション(モダンワークロード)を、同一基盤上で統合管理できます。これにより、運用サイロが解消され、管理コストの削減が期待できます。

この提供価値は、既に大手金融機関であるGoldman SachsやMorgan Stanleyなどでの採用実績によって裏付けられています。これらの企業は、既存のVM資産を一度に刷新するのではなく、段階的にモダナイゼーション(近代化)を進めるための現実的なプラットフォームとして、この技術を評価・採用しています。

企業が取るべきデータに基づいたアクション

この市場動向を受け、企業は自社の仮想化基盤戦略を再評価する必要があります。

ワークロードの定量的評価:

まず、自社で稼働しているVMワークロードを棚卸しし、各々のビジネス上の重要度、アプリケーションの依存関係、性能要件を定量的に評価します。

移行シナリオのTCO/ROI分析:

OpenShift Virtualization on AWSへの移行シナリオについて、移行コスト、ランニングコスト、運用効率の改善などを基に、TCO(総所有コスト)とROI(投資対効果)を試算し、現行環境の維持コストと比較分析することが重要です。

PoC(概念実証)の実施:

分析結果に基づき、移行候補となるワークロードを選定し、小規模なPoCを実施することで、技術的な実現可能性とビジネス上の効果を実データで検証することを推奨します。

VMwareの戦略転換にどう向き合うか:データに基づいた次世代仮想化基盤の意思決定フレームワーク

1. 定量的リスク分析から始めるITインフラ戦略の再構築

BroadcomによるVMware買収完了後、製品ポートフォリオの再編とライセンス体系の大幅な変更が発表されました。これらの変更は、企業のITインフラにおけるコスト構造、運用リスク、そして将来の技術選択の自由度に直接的な影響を及ぼす重要な変数です。

今、企業のIT部門に求められるのは、この市場環境の変化をデータに基づき客観的に評価し、現状の仮想化戦略が将来にわたって最適かどうかを再検証することです。本稿では、そのための分析フレームワークと、データ駆動型の意思決定を支援する具体的なアプローチを提示します。

2. 影響分析:VMwareエコシステムの変動要因とデータに基づく評価

VMwareは、x86サーバのオープン化という大きな技術トレンドと共に成長し、オンプレミス仮想化市場におけるデファクトスタンダードとしての地位を確立してきました。過去のEMCやDell Technologiesによる買収と比較しても、今回のBroadcomによる戦略転換は、ポートフォリオの選択と集中、そしてサブスクリプションモデルへの完全移行を軸としており、ユーザー企業のコストモデルと運用プロセスに抜本的な見直しを迫るものです。

この変化に適切に対処するためには、まず以下の観点から現状を定量的に分析・評価する必要があります。

TCO(総所有コスト)の再評価:

新ライセンス体系に基づき、今後3〜5年間のランニングコストを再計算し、従来のコストモデルとの差異を明確にします。

機能ギャップと移行コストの分析:

製品SKU(Stock Keeping Unit)の統廃合により、これまで利用してきた機能が利用できなくなる、あるいは代替機能への移行が必要となる可能性を洗い出し、それに伴う技術的・人的コストを算出します。

運用リスクの定量化:

サポート体制の変更や技術スタックの将来性を見極め、技術的負債化するリスクや、事業継続性に与える影響を評価します。

3. データ駆動型インフラ管理へのシフト:具体的なソリューション分析

上記のデータ分析に基づき、次世代の仮想化戦略を検討する際、Red Hat OpenShift VirtualizationとRed Hat Ansible Automation Platformの組み合わせは、リスクヘッジとITインフラのモダナイゼーションを両立する有力な選択肢の一つとなります。このソリューションが提供する価値は、以下のデータによって裏付けられます。

A. 自動化と自己修復による運用効率とサービスレベルの向上

従来の仮想マシン(VM)運用では、構成変更、パッチ適用、再起動といったDay 2オペレーションの多くが手動で行われ、これが運用工数の増大とヒューマンエラーの主要因となっていました。

データポイント: Ansible Automation Platformを導入することで、これらの定型作業を自動化し、関連する運用工数を削減します。さらに、構成が望ましい状態から逸脱したことをデータとして検知し、自動的に修復アクションを実行することで、平均復旧時間(MTTR)を大幅に短縮し、SLA(サービスレベル合意)の達成率向上に貢献します。

B. Infrastructure as Code (IaC) による柔軟性と事業継続性の強化

ミッションクリティカルなシステムを、災害等の理由で別拠点に迅速に立ち上げるシナリオを想定します。従来の手法では、環境差異の吸収や設定作業に多くの時間を要し、目標復旧時間(RTO)の達成が困難でした。

データポイント: OpenShift VirtualizationとAnsibleの連携は、Infrastructure as Code (IaC) のアプローチを可能にします。インフラ構成情報をコードとして一元的なリポジトリ(Gitなど)で管理することで、VM移行プロセスを完全に自動化し、移行にかかる時間を短縮します。コードによる構成管理は、プロセスの再現性と正確性を担保し、監査証跡の確保を容易にするため、ITガバナンスの強化にも繋がります。

VMwareの戦略転換は、単なるコスト問題ではなく、自社のITインフラをよりデータドリブンで効率的な運用モデルへと進化させる好機と捉えるべきです。客観的なデータ分析に基づき、将来を見据えた仮想化戦略を再構築することが、今まさに求められています。

リモートワーク環境のデータガバナンスとセキュリティリスク:既存VDI環境が抱える構造的な課題

リモートワークの恒常化は、企業・組織におけるデータアクセスポイントの爆発的な増加をもたらしました。これに伴い、従来のVDI(仮想デスクトップインフラストラクチャ)環境が、現在のデータ利用実態およびセキュリティ要件に対して限界を露呈しています。

データの流動性拡大が突き付けるVDIの限界

リモートワークの定着は、データ活用の観点からポジティブである一方、情報漏えいリスクの増加というデータガバナンス上の重大な課題を伴います。特に以下の点が、データセキュリティ戦略の再構築を急務としています。

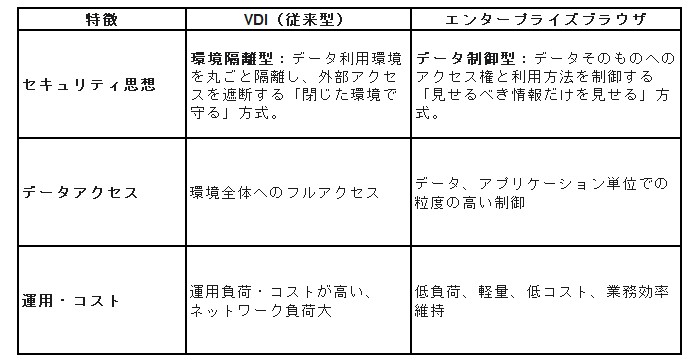

シャドーITとアクセス経路の多様化: 社外PCからのアクセスやSaaS(クラウドサービス)利用の拡大は、従来の「閉じたVDI環境でデータを守る」というアプローチでは追跡・制御しきれないデータ移動経路を生み出しています。

リスク要因の増大と可視性の欠如: マルウェア感染、不正アクセスといったサイバーリスクに加え、VDIがカバーできない**「物理的な脅威」**(例:覗き見、なりすまし、画面撮影によるデータ流出)が業務継続性と機密情報保護に対する現実的な脅威となっています。

非効率なデータアクセス構造: 運用負荷やコスト増に加え、ネットワーク負荷によるVDIの作業効率低下は、現場のデータ活用スピードを損なうボトルネックとなっています。これは、迅速なデータドリブンな意思決定を阻害する要因です。

🎯 データセキュリティのパラダイムシフト:「見せるべき情報だけを見せる」エンタープライズブラウザという選択

現状の課題を解決し、セキュリティとデータ活用効率を両立させるアプローチとして、「エンタープライズブラウザ」が注目されています。

VDIとエンタープライズブラウザの「守り方」の決定的な違い

従来のVDIとエンタープライズブラウザの最大の違いは、データセキュリティのアプローチの根本的な転換にあります。

「脱VDI」は、目的ではなく、現在のデータ利用実態に合わせた「最適なデータガバナンスの構造」へ転換するための戦略的な手段です。

📈 ゼロトラスト実現への合理的ロードマップ:「Mammoth Cyber Enterprise Browser」の活用

エンタープライズブラウザを導入することは、ゼロトラストセキュリティのコンセプトである「すべてを信頼せず、常に検証する」という思想を、最も現実的かつ段階的に実現する第一歩です。

解決できる具体的課題と導入効果

「Mammoth Cyber Enterprise Browser」は、以下の具体的な課題を解決し、IT部門の負担を劇的に軽減しながらセキュリティ体制を強化します。

粒度の高いデータアクセス制御: アプリケーションやデータへのアクセスを個別に制御し、不正アクセス・情報漏えいリスクを最小化します。

運用工数・コストの最適化: 従来のVDI運用と比較し、インフラ維持・管理に関わる工数とコストを削減します。

物理的脅威への対策拡張: 顔認証、覗き見・撮影機器検知が可能な「テレワークサポーター」等との連携により、VDI単体では困難であった物理的なデータ流出リスク(画面撮影や覗き見)を可視化し、防御します。

Mammoth Cyber Enterprise Browserは、データセキュリティを維持しつつ、現場の業務効率を損なわない、現代のリモートワーク環境における現実的でスマートなデータガバナンスの選択肢です。

💡 ぜひご検討いただきたい対象者

貴社におけるセキュリティ戦略とデータガバナンスの見直しにおいて、特に以下の課題意識をお持ちの部門長・ご担当者様は、本ソリューションの検討を強く推奨します。

データセキュリティ要件が高い業務(例:在宅コールセンター、金融、BPO)において、情報漏えいリスクをデータで定量的に制御したいご担当者。

VDIの運用負荷や高コストがデータ活用予算を圧迫し、「脱VDI」による構造改革を模索しているIT部門の管理者・責任者。

社外PCからのアクセスや在宅勤務時のデータ流出リスクに対する不安を具体的なセキュリティ機能で解消したい方。

リモートワーク環境において、セキュリティ体制と業務効率の両立というトレードオフを解消したい企画・経営層。

ゼロトラスト実装を、まずは現実的かつ段階的なブラウザレベルの制御から進めたいシステム部門やセキュリティ担当者。

VDIでは対応しきれなかった「物理的な脅威」への対策を、データ保護の観点から検討している方。