目次

日本のシステム運用の現状

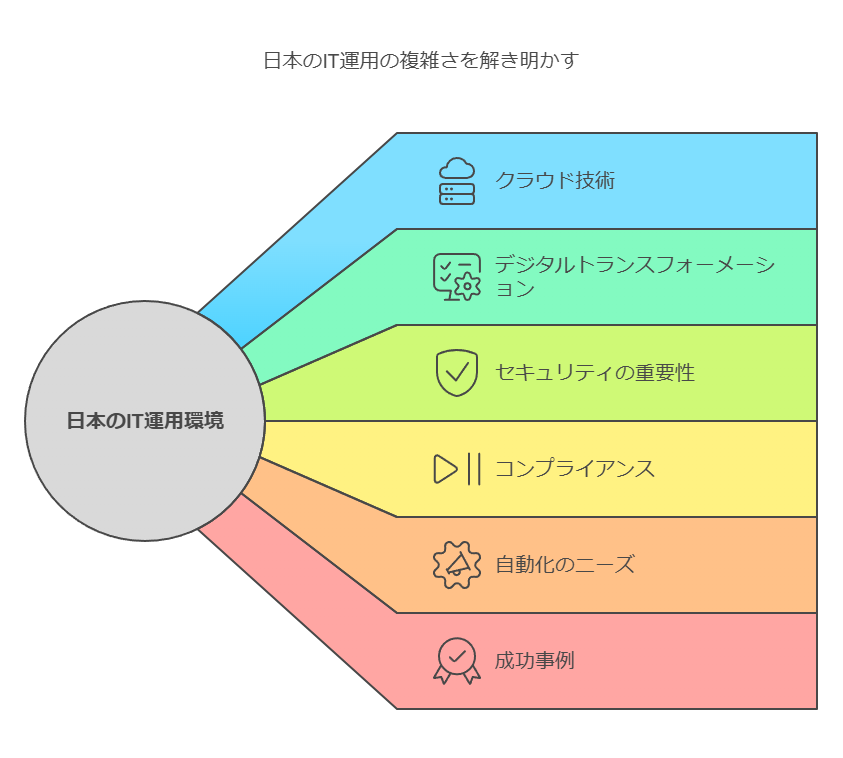

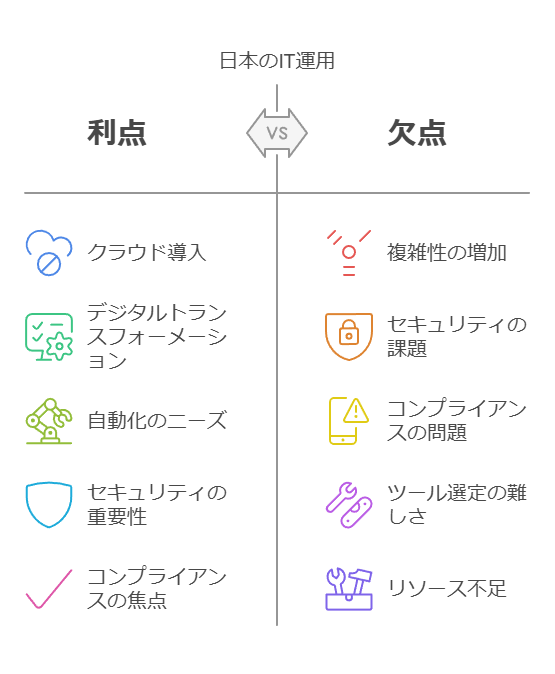

近年、日本企業のIT運用環境は、クラウド技術の普及とデジタルトランスフォーメーション(DX)の加速によって急速に複雑化しています。これに伴い、セキュリティとコンプライアンスの重要性がますます高まっています。従来は、システムの標準化や共通化を通じて省力化を図り、既存のIT資産を活用する運用が主流でしたが、クラウドサービスの利用拡大により、複数の外部サービスの管理が必須となり、これまで以上に多様な運用管理が求められています。

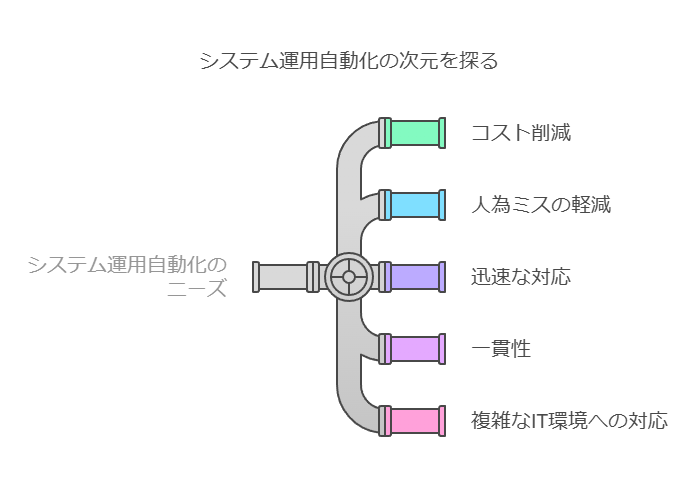

システム運用自動化のニーズと課題

システム運用自動化に対するニーズは、多岐にわたります。コスト削減や人為ミスの軽減、対応の迅速化、一貫性の確保、さらには複雑化するIT環境への対応など、現代のIT運用には高い効率性が求められています。このような要件に対応するため、システム運用自動化ツールの導入が進んでいますが、単にツールを導入するだけでは不十分です。企業は、ツールと既存プロセスの整合性を慎重に見極め、長期的な運用改善に向けた戦略を構築する必要があります。

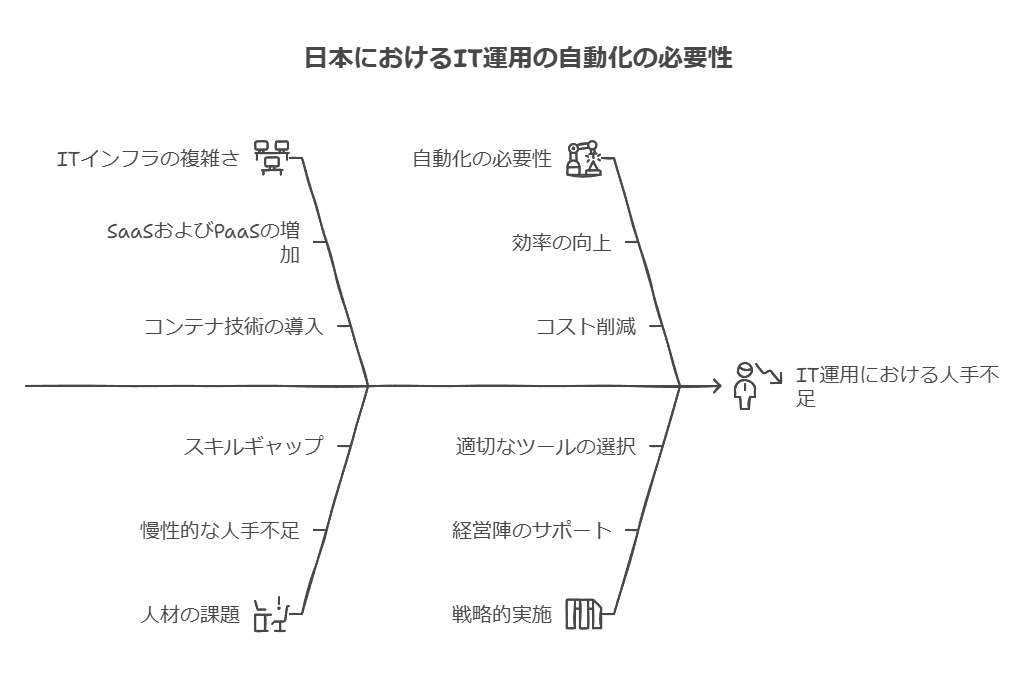

人手不足と自動化の必要性

SaaSやPaaS、さらにはコンテナ技術の導入が進み、ビジネスのスピードはかつてないほど加速していますが、それに伴うIT運用の負荷も増加しています。しかし、日本の多くの企業が直面しているのは、IT人材の慢性的な不足です。単純に運用チームの増員を図るだけではこの問題に対処することは困難であり、むしろ、業務の自動化によって「人手に頼らない運用」を実現することが急務となっています。このため、戦略的な自動化の導入が企業の存続に不可欠な要素となっています。

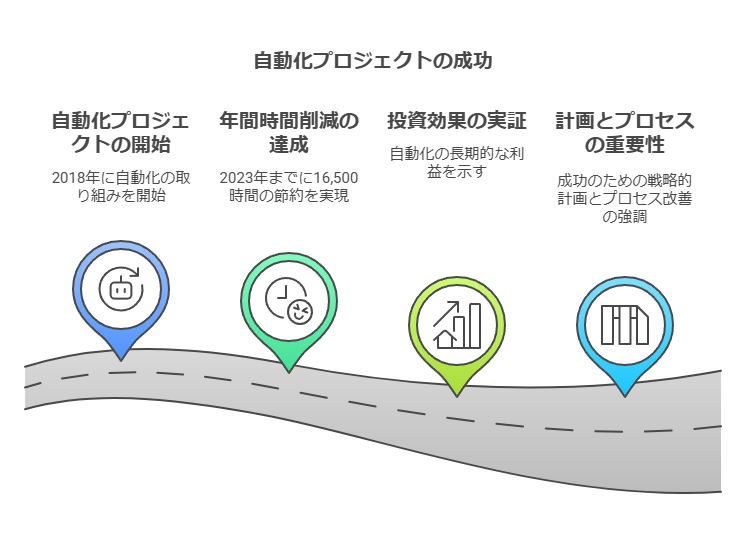

自動化の成功事例

成功事例として、2018年に自動化プロジェクトを開始し、毎年着実に改善を重ねた企業があります。この取り組みにより、2023年には年間16,500時間もの工数削減を達成し、運用コストの大幅な削減とリソースの有効活用に貢献しています。これは、自動化の長期的な投資効果を示す典型例であり、適切な計画とプロセスの見直しによって、企業は持続的な成長を実現できることを示しています。

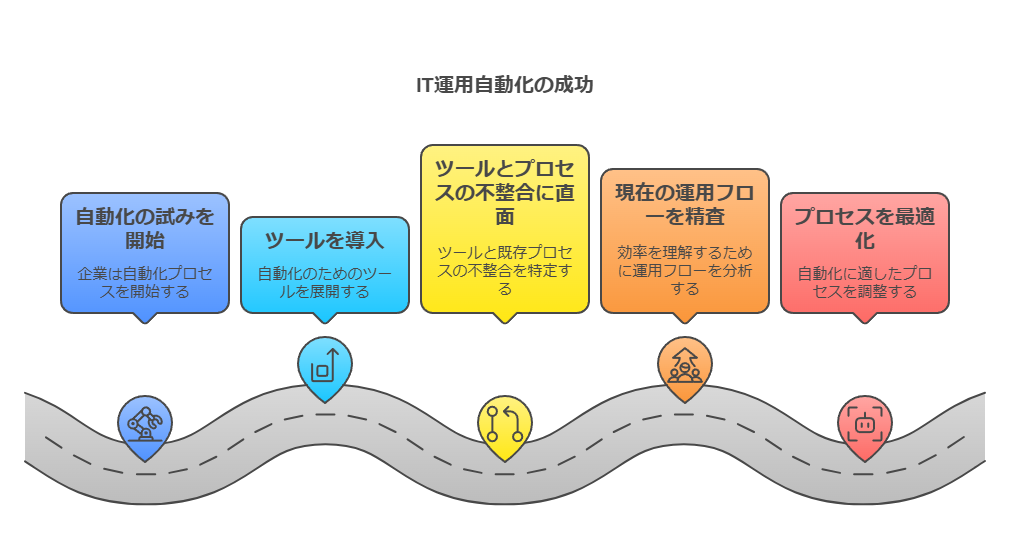

IT運用自動化が失敗に終わる理由

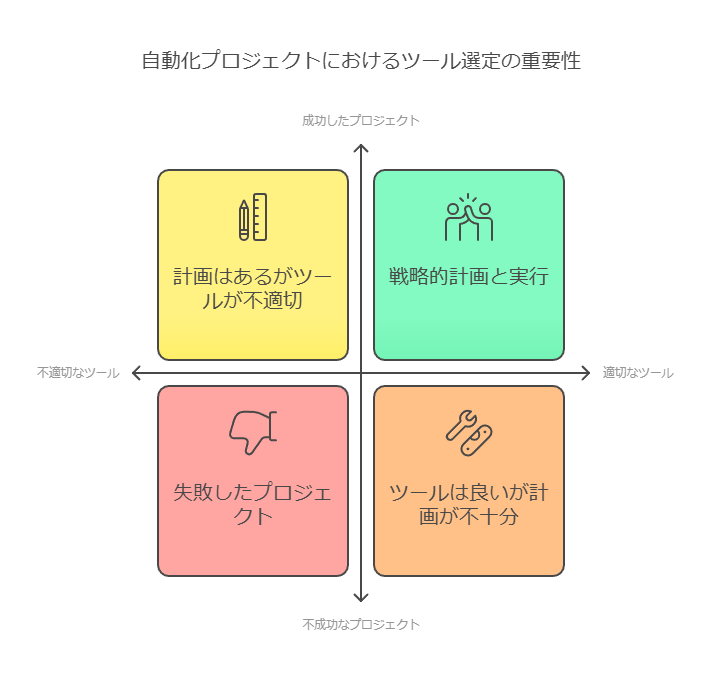

多くの企業がIT運用自動化に取り組む際、ツールの導入を最初のステップとしていますが、ツールだけでは真の効果を引き出すことは困難です。特に、既存の運用プロセスと自動化ツールの整合性が取れていない場合、期待される効果を発揮できないことがよくあります。自動化を成功させるためには、ツール導入前に現状の運用フローを精査し、自動化に適したプロセスへ最適化することが不可欠です。また、自動化の目的を明確にし、その効果を定量的に評価する枠組みを設けることで、投資対効果がより見えやすくなり、プロジェクトが成功する可能性が高まります。

最適なシステムやツール選定の重要性

自動化の目的や目標が明確であっても、適切なツール選定ができなければプロジェクトは設計段階で停滞し、最終的に失敗に至るリスクが大きくなります。ツール選定は、IT運用自動化において最も重要な要素の一つであり、慎重かつ戦略的に進める必要があります。

外資系ツールと日本企業のニーズの違い

外資系の運用自動化ツールは、先進的な技術と豊富なインテグレーション機能を持つ一方で、日本企業特有の運用ニーズや障害対応フローに必ずしも適合していないことがあります。このため、ツール選定に際しては、単に機能の豊富さにとどまらず、自社の運用プロセスに適合するかどうかを慎重に見極めることが必要です。特に、日本の企業文化に適応した障害対応プロセスや、コンプライアンス要件を満たすことが重要です。

自動化ツール選定のポイント

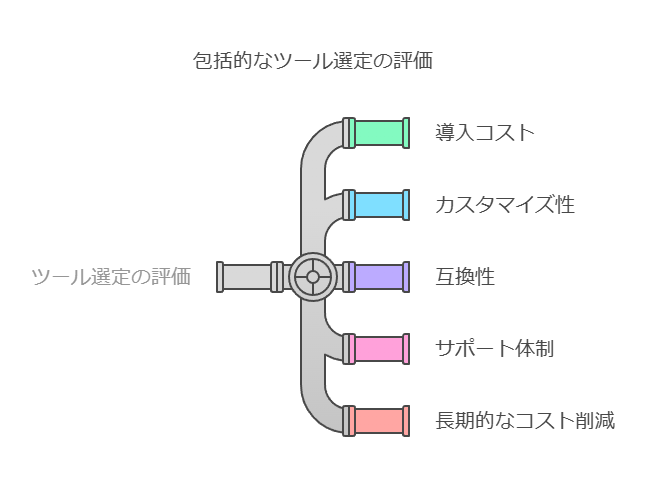

IT運用自動化を成功させるためには、ツール選定が重要な鍵となります。ツール選定の際には、導入コストや機能性だけでなく、自社の運用環境に適したカスタマイズ性、既存のシステムとの互換性、サポート体制の有無も考慮することが重要です。さらに、ツールが自動化の短期的な効果だけでなく、長期的な運用コスト削減やリソースの最適化にどのように貢献するかを評価する必要があります。

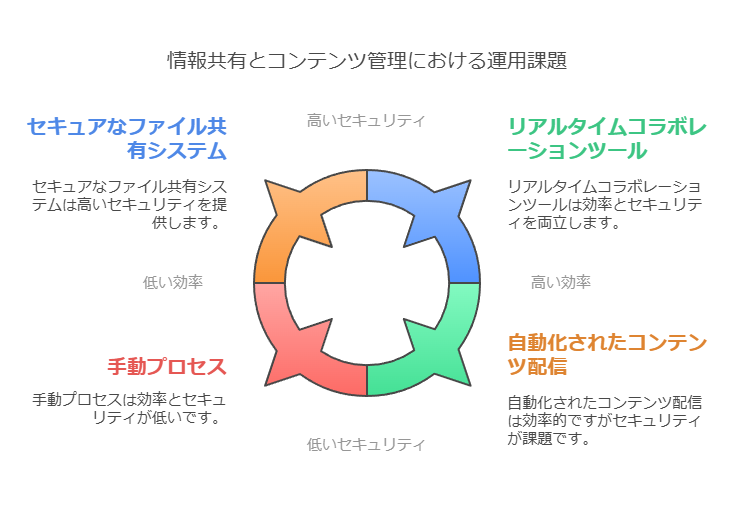

情報共有とコンテンツ管理の課題

大企業において、膨大な従業員、顧客、取引先との情報共有やコンテンツ管理は、しばしば運用上の大きな課題となります。特に、事業部間やグループ企業間での連携が不足しているケースや、社外の顧客・取引先とのリアルタイムな情報共有が難しい環境では、効率化とセキュリティ強化が不可欠です。これらの課題を解決するためには、統合的なポータル構築や自動化された情報共有プロセスの導入が有効です。

レガシーポータルの問題点と脱却

旧来のポータルシステムを使い続けることは、コスト圧迫やセキュリティリスクの増加といった弊害を引き起こします。また、システムが古いために柔軟なカスタマイズや迅速な対応が難しく、特に障害発生時の対応が遅れるリスクがあります。これにより、企業全体のIT運用が停滞し、成長機会を失う可能性もあります。従って、最新のポータルプラットフォームへの移行は、運用効率とセキュリティの観点から急務です。

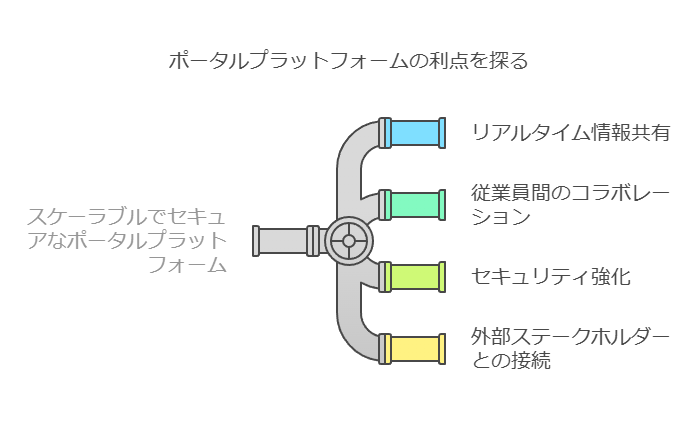

ポータル構築プラットフォームの活用

数万人規模の従業員や膨大な顧客を持つ大企業が抱える情報共有の課題を解決するには、スケーラブルでセキュアなポータル構築プラットフォームが求められます。このようなプラットフォームは、従業員間や社外関係者とのリアルタイムな情報共有を実現し、政府機関にも採用されている高度なセキュリティ基準に基づいて安全性を担保します。また、コンテンツ管理システム(CMS)との違いも明確にし、企業の具体的な運用ニーズに合った最適なツールの選定が可能です。

CMSとの違い

ポータル構築プラットフォームとコンテンツ管理システム(CMS)は、しばしば混同されがちですが、その目的と機能は異なります。CMSは主にコンテンツの作成・管理に特化しており、情報共有やアクセス管理に重点を置いていないことが多いです。一方、ポータルプラットフォームは、広範な情報共有機能やセキュリティ機能を備え、多様なユーザーが利用する場面でも効率的に対応可能です。企業は、自社のニーズに応じてこれらのツールを使い分ける必要があります。

システムの現状の問題提起と背景を整理

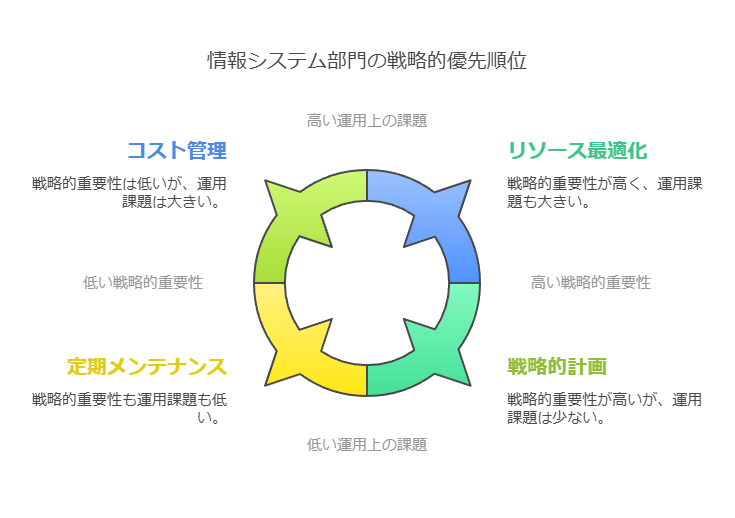

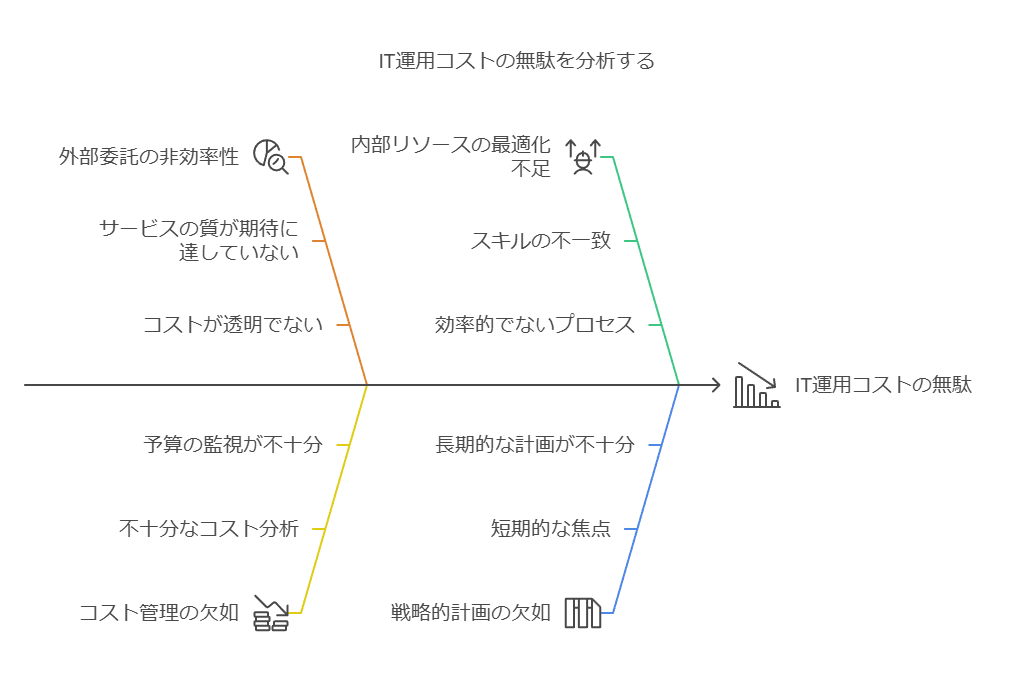

情シスの人材不足、運用コストの増加、DX推進のためのリソース確保が課題となっている企業が多い現状について述べ、ITシステムの運用にかかるコストがいかに最適化されていないかを説明。

情シス部門の役割は、DX推進に伴い戦略的な業務が求められる一方で、既存のシステム運用におけるリソース不足とコスト管理の問題が深刻化しています。特に、多くの企業が外部ベンダーによる運用アウトソーシングに頼っているため、運用コストの最適化が進んでいない状況が見られます。

課題の整理と解決策への導入

現在のIT運用コストがどのように無駄が生じているかを具体的に示し、外部委託を見直す必要性について強調。情シスが限られたリソースでどのように効率化を図るべきかを段階的に提案。

システムの運用コストは、導入後に適切な評価がされず、長期間にわたり同じベンダーに依存する傾向があります。この結果、見直しが困難であるため、コストの無駄が発生しやすい状態です。今後は、コストの適正化を進め、持続的な運用管理の最適化を図るために、ベンダーマネジメントや内製化の検討が重要です。

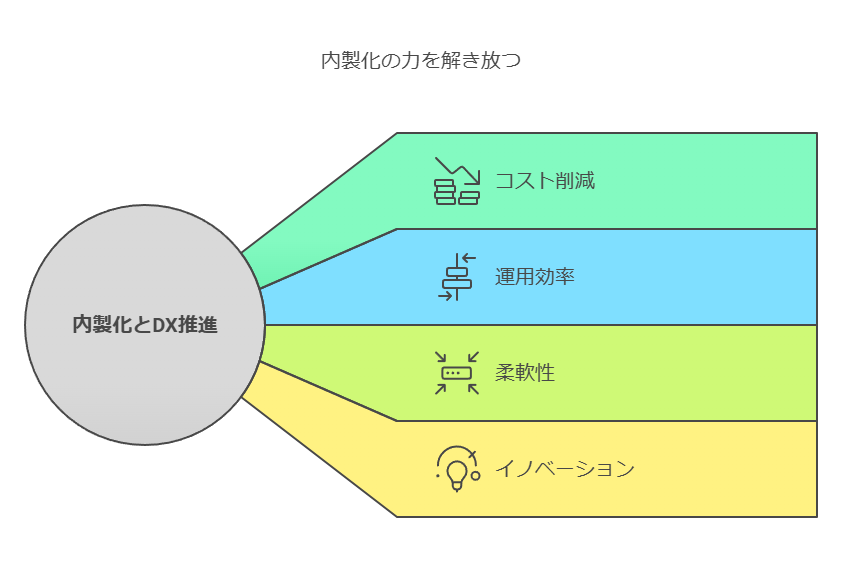

内製化の促進

DX推進とシステム内製化の関連性を強調し、特にDX成功企業の実例や調査データを活用して、内製化による長期的な運用コスト削減の可能性を提示。

情シスが直面する問題に対する解決策として、IT運用の内製化が有力な選択肢となります。近年の調査によると、DXの成功企業の多くはシステム開発や運用の内製化に積極的です。これにより、外部依存を減らし、自社のリソースを効果的に活用することで、柔軟で迅速な対応が可能となり、最適化されたコスト管理が実現できます。

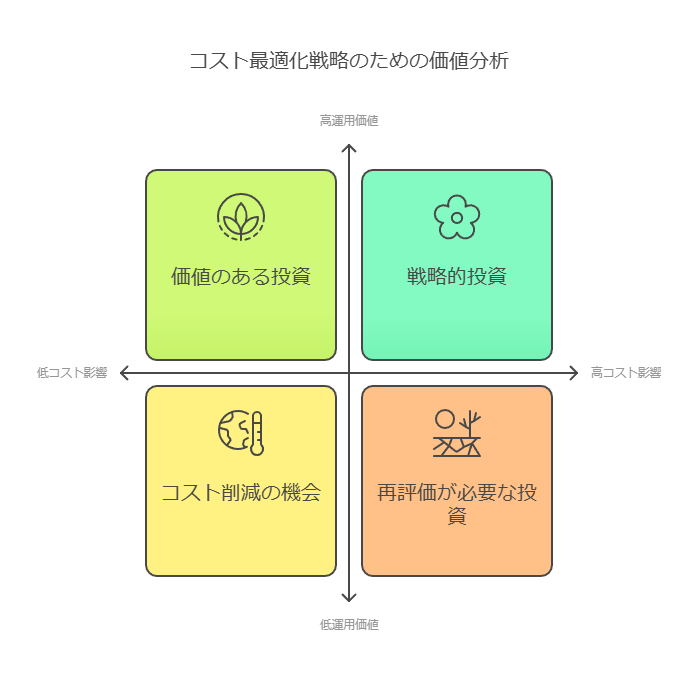

具体的な行動プランの提案

ベンダーマネジメントと運用コストの可視化・最適化を進めるための具体的なプロセスやツールの導入方法についても詳細に説明し、読者がすぐに実行に移せるように情報を整理。

まず、現状の運用コストの価値分析を行い、コスト最適化の方針を明確にする必要があります。その後、ベンダーマネジメントを通じて外部依存のリスクを低減しつつ、内製化による持続可能な最適化を進めることが求められます。また、これを実現するために、IT部門が利用可能なコスト可視化ツールの導入や、定期的な評価プロセスを導入することが効果的です。

このように、現状の課題認識とそれに基づく具体的な行動プランを提示し、IT部門が最適化を進めるための実用的なアプローチを提案できます。

データコンサルタントの視点で改善し、より組織のIT運用における課題と解決策を提示する形に変更する際には、システムの信頼性や運用管理の重要性を強調し、具体的な対応策を示す内容にする必要があります。

現場に即したシステムの品質向上と信頼性強化の重要性

企業が業務運営を効率的に行うためには、安定したシステム運用が不可欠です。IT戦略を立案し、システム化を計画、構築するだけでなく、その後のシステム運用においても継続的な改善が求められます。しかし、実際には、運用に起因するシステム障害が数多く発生しており、企業の経営基盤に重大な影響を及ぼす可能性があります。

システム運用がもたらす課題

運用に起因する障害の割合

運用時に発生するシステム障害の割合は非常に高く、特に重要障害の多くが運用フェーズにおいて発生しています。IPAが公開した調査(2009年)によると、80%近くの障害が保守・運用時に起因しており、SEC journal(2010年~2014年)でも60%の障害が同じフェーズで発生していると報告されています。これらのデータは、システム運用における信頼性向上が喫緊の課題であることを示しています。

実際の障害ケースから学ぶ教訓

以下は、実際に発生したシステム障害のケースです。これらの障害は、運用管理の不備が重大な影響を引き起こした事例として、信頼性強化に向けた改善策を考える上での重要な教訓となります。

障害ケース1: ファーストサーバ データ消失

原因: メールシステムの障害対策として実施したメンテナンス作業中に、不具合のある更新プログラムが使用された。この更新プログラムは、メンテナンス担当者が改変した際に、不要なファイル削除コマンドを除外し忘れたことが原因で、更新対象外のサーバーのデータがプライマリとバックアップの両方で削除されました。

影響: 約5700契約分のデータが消失し、復旧の試みも不十分であったため、さらに12億1900万円の損害が発生しました。

教訓: 更新プログラムの管理プロセスにおけるヒューマンエラーを防ぐための自動化や多段階レビューが必要です。また、バックアップ管理の強化とデータ復旧プロセスの精査が求められます。

障害ケース2: AWS S3サービス停止

原因: 決済システムのサブシステムを停止するためのコマンド入力に誤りがあり、意図しない多くのサーバーが停止しました。この結果、他の重要なサブシステムにも影響が広がり、システム全体の再起動が必要となり、約4時間のS3サービス停止が発生しました。

教訓: 手順書に従った操作でもヒューマンエラーが発生するリスクがあるため、自動化されたオペレーションプロセスやシステム保護メカニズムの導入が不可欠です。また、複数サブシステムに影響が広がるリスクを最小化するための冗長性設計も重要です。

データコンサルタントの視点からの解決策

システム運用における障害リスクを軽減し、信頼性を向上させるためには、以下のアプローチが推奨されます。

運用プロセスの自動化

ヒューマンエラーを最小限に抑えるために、システムのメンテナンスや更新作業の自動化を進めることが重要です。これにより、手動操作によるミスや確認漏れを防ぎ、安定した運用が可能になります。

多層的なバックアップ戦略

データ消失のリスクを回避するために、バックアッププロセスの強化が必要です。オンプレミスとクラウドの両方にまたがるバックアップ戦略を採用し、冗長性を確保することで、データの復旧に失敗するリスクを低減できます。

オペレーションの可視化と監査体制の強化

システム運用の信頼性を高めるために、オペレーションの可視化や監査体制の強化が求められます。リアルタイムでの運用監視や定期的な監査を行うことで、問題発生時の迅速な対応と原因究明が可能になります。

権限管理とアクセスコントロールの強化

特権アクセスや操作ミスによるシステム障害を防ぐために、役割ベースのアクセス制御(RBAC)や多要素認証の導入が有効です。これにより、重要システムへの不正アクセスや誤操作を防止できます。

まとめ

システム運用における信頼性向上は、企業の事業継続性を支える上で不可欠です。データコンサルタントとして、運用プロセスの自動化やセキュリティの強化、バックアップ戦略の見直しを提案することで、企業のIT基盤を強固にし、経営リスクを最小化することが可能です。

ここでは、データコンサルタントとしての視点から、現場の運用課題に対する解決策を提案し、具体的な事例を通じて信頼性向上のためのアクションプランを提示しています。

システム「リノベーション」による効率的なアップグレード戦略

データコンサルタントの視点で、既存システムの有効活用と最適化を図る「リノベーション」というアプローチは、企業のデジタル変革において非常に効果的です。単なる「リプレース」ではなく、「リノベーション」によって、システムの利便性を維持しながら、最新技術への移行が可能になります。

1. リノベーションの利点

「システムのリノベーション」は、以下のようなメリットを提供します。

コストと工数の削減: リプレースに比べて大幅なコスト削減が可能であり、開発や導入工数の削減も実現します。

既存システムの引き継ぎ: 既存の使い勝手や操作感を維持しつつ、バグ修正やコードの最適化が可能です。これにより、ユーザーエクスペリエンスを損なうことなく、システムのパフォーマンスを向上させます。

柔軟な機能拡張: 必要に応じて、新機能の追加や不要な機能の削除が可能で、システムの最適化を図ります。

2. データ連携とラベリングソリューションの重要性

システムのリノベーションにおいて、企業内で使用されるデータやプロセスのシームレスな連携が欠かせません。特に、ラベリングソリューションは、製造やマーケティング、規制対応といった多様な業務と連携し、データの一貫性と正確性を担保する重要な役割を果たします。

ERPシステムとの統合: ERPと完全に統合されたシステムは、企業の各部門が正確なデータを使用し、効率的に作業を進めることができます。ラベル生成プロセスがERPと連携していることで、工場向けのシールラベルやUDI(ユニークデバイス識別)管理などにも柔軟に対応でき、作業効率が大幅に向上します。

3. テンプレートの再利用と一貫性

ラベリング管理システム(LMS)を活用し、デジタル・アセットやテンプレートを再利用することで、業務全体の効率を向上させ、一貫性を保つことが可能です。たとえば、以下のような要素がLMSで管理されます。

部品表(BOM)や機器属性との連携: ラベルの各要素は、BOMや機器属性と連動して管理され、正確かつ最新の情報に基づくラベル作成が可能です。

デジタル・アセット・ライブラリの活用: チーム全体が共通のデータセットを使用することで、最新の製品仕様や説明を反映したラベルデザインを効率的に作成できます。

4. コンプライアンスの確保と統合システム

ラベル管理におけるコンプライアンスチェックは、特に医療機器メーカーや規制が厳しい業界にとって重要です。LMSを導入することで、ラベル・テンプレートやアートワークの再利用を促進し、データ転送やコンプライアンスチェックを容易に行えます。また、工場用ラベルデザインやオンデマンドの印刷管理システムとも統合し、シームレスなデータ連携が可能です。

まとめ

システムリノベーションは、コスト効率や機能性を重視する企業にとって魅力的な選択肢です。また、データ連携やラベリングプロセスの効率化は、業務全体のパフォーマンスを向上させ、正確なデータに基づく迅速な意思決定を支援します。データコンサルタントとしては、こうしたアプローチを通じて企業のデジタル基盤の強化を推進し、競争力向上に貢献することが求められます。

柔軟性の欠如が業務システムに与える影響:データとDX推進の視点

現在、企業はDX(デジタルトランスフォーメーション)への取り組みが急務となっていますが、実際の現場では既存ITシステムが足かせとなり、業務に大きな制約をもたらしているケースが多々見られます。現場が直面している主な課題は、業務プロセスとシステムの間に生じているギャップにあり、これをデータ駆動型のアプローチで解決することが求められています。

現状の課題:システムと業務のミスマッチ

企業が直面している主要な課題の一つは、既存の業務システムが現在の業務プロセスやビジネス環境に適合していないことです。調査結果によると、以下のような問題が多く挙げられています。

システム改修コストの高さ:改修コストが高すぎて、必要な改善が行えない。

UIの非適合:業務フローに合わないシステムUIを無理に使い続けている。

モバイル対応不足:システムがモバイルデバイスに対応していないため、PCに依存した業務が発生。

新規システム導入のコスト負担:新システム開発・導入のコストが高く、移行できない。

OS非対応問題:既存システムが最新OSに対応しておらず、アップグレードが難しい。

これらの問題は、データ分析や業務プロセスの可視化を通じて、どこに無駄や非効率が存在するのかを特定し、その解消に向けた取り組みを加速させる必要があります。現場ではこのギャップを埋めるために、スプレッドシートや手作業による処理が行われており、ここでも多くのリソースが浪費されています。

システム外注依存の構造的問題

要因を分析すると、日本の企業においてはシステム開発を外注する文化が長年根付いており、これがシステムの柔軟性不足に繋がっていることがわかります。システムの開発や保守を外部ベンダーに依存することにより、以下のような問題が生じています。

コストの増加:開発や保守にかかるコストが高騰している。

スピードの遅さ:開発着手からリリースまでの期間が長く、変化への対応が遅い。

柔軟性の欠如:リリース後の改修が迅速に行えず、業務ニーズに追いつけない。

これに対して、企業の競争力を維持・向上させるためには、外部依存を減らし、社内での開発ノウハウを蓄積することが重要です。自社内にデータサイエンスやシステム開発の知見を蓄積し、DX推進をデータドリブンで進めることが、迅速な意思決定と業務改善に直結します。

データ活用によるシステム改善のアプローチ

企業のDXにおいて、データ分析を駆使して既存システムのパフォーマンスを可視化し、適切な改善を行うことが成功の鍵です。具体的には、以下のアプローチが有効です。

プロセスデータの分析:現在の業務フローとシステムの利用データを収集・分析し、どの業務でボトルネックや無駄が生じているかを特定します。

コストベネフィット分析:システム改修や新規システム導入にかかるコストを定量的に評価し、どの投資が最も業務効率化に寄与するかを明らかにします。データに基づく判断は、不要なコスト削減にも繋がります。

リアルタイムモニタリング:システム運用中のデータをリアルタイムでモニタリングし、障害や問題が発生する前に予兆を検知できる仕組みを整えることで、迅速な対応が可能になります。

DX成功のための社内ノウハウ蓄積

さらに、DX推進のためには、社内にデータ活用や開発に関するノウハウを蓄積することが不可欠です。これにより、外部ベンダーへの依存を減らし、システム開発や運用の柔軟性を向上させることが可能になります。

データサイエンティストの育成:データ分析やシステム運用のスキルを持つ人材を社内で育成し、社内データをフルに活用した効率的なシステム改修・運用を行います。

内製化戦略の推進:外注に頼るだけでなく、内部リソースでシステム開発を行うことで、より柔軟で迅速な対応が可能になります。

DXを成功させるためには、業務システムの柔軟性を確保し、データを駆使した業務改善が不可欠です。システム外注依存から脱却し、社内にノウハウを蓄積することで、コスト削減と迅速な業務改善が実現可能になります。企業がデータ駆動型の戦略を採用することで、競争力の強化に繋がり、持続的な成長を支える基盤が構築されます。

データコンサルタントの視点で、内製化と外注のメリット・デメリットを明確にし、データ活用や業務改善の観点から整理しました。

システム開発の外注 vs 内製化:データ活用と業務効率化の視点から

システム開発において、企業は外注と内製化の選択を迫られる場面が多くあります。それぞれにメリットとデメリットが存在しますが、データ駆動型の業務改善やDX(デジタルトランスフォーメーション)推進の観点から考えると、内製化は特に柔軟なシステム環境の構築に効果的です。ここでは、外注と内製化それぞれの特徴をデータの活用や業務フローへの適合性に焦点を当てて整理します。

システム外注のメリットとデメリット

外注の主な利点は、システム開発会社のノウハウや専門知識を活用できるため、一定の品質が保証されやすく、責任の範囲が明確化される点です。また、納品後も保守や機能拡張を外部に任せられるため、社内リソースを使わずに運用が可能です。さらに、担当者の異動や退職時の引き継ぎを外注先に任せられるため、人的リスクを軽減できるのも魅力です。

一方で、外注にはいくつかのデメリットが存在します。開発にかかるコストが高くなりがちで、スケジュールや予算の制約も外部業者との調整が必要です。リリース後の仕様変更や追加が必要な場合、外注ではその対応が遅く、柔軟性が不足する点が挙げられます。また、社内に開発のノウハウが蓄積されないため、長期的にはデジタル戦略における競争力を損なう可能性もあります。

システム内製化のメリット:データ活用と業務最適化の視点

内製化は、特にアジャイル開発のアプローチを採用する場合、DX推進において大きな強みを発揮します。アジャイル型開発では、開発中およびリリース後の仕様変更や追加機能の対応が迅速で、ビジネスの変化に柔軟に追随することが可能です。これにより、企業が蓄積したデータをフルに活用し、システム改修や改善の意思決定をリアルタイムで行えるようになります。

内製化の具体的なメリットとして、以下が挙げられます:

柔軟な対応:開発中およびリリース後に必要な仕様変更や機能追加に対して、迅速かつ柔軟に対応可能。

ノウハウの蓄積:システム開発に関するノウハウが社内に蓄積され、データ分析やITスキルが向上することで、将来的なシステム改善や新規開発に活用できる。

コストの削減:外注と比較してキャッシュアウトを抑えることができ、開発コストは主に「人件費」に集約される。

データの活用:社内システムに蓄積されたデータを自由に分析し、業務の効率化やプロセス改善に繋げることができる。

業務知識の直接反映:業務フローや業務知識に精通した社内担当者が直接開発に関わるため、エンドユーザーのニーズを的確に反映したシステムを構築可能。

コミュニケーションの活性化:システム開発を通じて、社内の部門間のコミュニケーションが活性化し、より緊密な業務連携が期待できる。

内製化の課題と解決策

ただし、内製化にも課題があります。特に初期段階では、開発リソースの確保や社内人材の育成が必要です。しかし、データ分析やITスキルを持つ人材の育成は、DX戦略の一環として進めるべきです。社内でのシステム開発能力が向上することで、システム開発と保守にかかるコストの削減だけでなく、外部依存から脱却し、長期的には競争力の強化に繋がります。

また、業務システムの内製化を進める上では、データドリブンな意思決定を支援するためのリアルタイムデータの活用が重要です。システムの利用データをもとに、改善すべきポイントや効率化の余地を特定し、PDCAサイクルを高速で回すことで、開発スピードと業務効率の向上を実現します。

システムの外注と内製化の選択は、企業のビジネスニーズやDX戦略に大きく依存しますが、特に長期的な視点で見ると、内製化によるデータ活用と業務効率化は、企業の成長に不可欠な要素です。内製化によってシステムの柔軟性と開発スピードが向上し、業務に即した最適なソリューションを迅速に提供できる体制が整います。データコンサルタントとしては、内製化を通じてデータドリブンな業務改善を進め、持続的な競争力を確保することを推奨します。

プロセス、メソッド、ツールのアプローチ

企業が最新のアプリケーション開発能力を迅速に立ち上げ、全社規模でスケールアップするためには、効率的かつ革新的なアプリケーションデリバリー手法が不可欠です。企業には、既存のインフラやスキルセットを基盤にしつつ、競合するイノベーション目標や顧客の期待に応える必要があります。このために、適切なプロセス、メソッド、ツールの選定が極めて重要となります。

クラウドの役割:イノベーションとトランスフォーメーション

クラウドは、イノベーションとトランスフォーメーションを加速する包括的なアプローチを提供します。このアプローチは、企業が新しいアイデアを迅速に生み出し、スケールアップするための基盤となり、ビジネスとITの関係者間でのシームレスな連携を促進します。これにより、業績や成果に劇的な影響を与えることが可能になります。

企業がイノベーションを推進するためには、リスクを最小限に抑えつつ実験的な取り組みを行い、ユーザーエクスペリエンス(UX)や実装、文化的変革を統合する必要があります。このようなアプローチを実現するために、アジャイルなプラクティスを採用することが有効です。

IT投資の強化とモダナイゼーション

企業が既存のIT投資を強化し、モダナイズを図るための具体的な戦略が提供されます。このアプローチは、既存のテクノロジー資産とオープンな戦略を統合し、成熟したテクノロジーと最先端技術の両方を活用します。さらに、多分野にまたがる専門チームが企業を支援し、データから新たなインサイトを引き出し、AIを活用したスマートなビジネスの実現を目指します。

企業スケーリングのための戦略的設計

スピード、スケール、セキュリティを考慮して最初から設計されています。これにより、企業はリスクを管理しつつ、業務を最適化し、成長の各段階で適切なアーキテクチャ上の決定を下すことが可能になります。また、プラットフォーム、顧客チャネル、地域、チームにわたってソリューションを展開する際の支援を行います。

結果重視のアプローチ:ビジネス価値の迅速な実現

最終的には、結果第一を目指し、高度なテクノロジーを目的を持って適用することが求められます。これにより、企業はリスクを最小化し、迅速にビジネス価値を実現することが可能となります。IBM Garageのようなアプローチを活用することで、企業は変化に迅速に対応し、競争力を高めることができるでしょう。

データコンサルタントとしての提言

アジャイルな開発手法とクラウドインフラの活用によって、企業はイノベーションを加速し、迅速にスケールアップする体制を整える必要があります。

既存のIT資産を活用しつつ、最新技術を取り入れることで、企業はデータから新たな価値を引き出し、ビジネスの成長を支援できます。

リスク管理を重視しつつ、スピードとセキュリティを確保した戦略的なITアーキテクチャを構築することが重要です。

1. 課題の明確化: Excelによる手作業管理の限界

多くの企業では、その手軽さからシステム構成管理にExcelを用いるケースが多々見られます。確かにExcelは直感的で広く利用されており、特に小規模な管理には適しています。しかし、管理対象が増加すると、手動での更新作業が煩雑になり、管理ミスが発生するリスクが高まります。結果として、最新情報が反映されない状態が発生し、異常時に正確なシステム状況を把握できず、構成管理が機能しなくなる可能性があります。

2. Excelの利点と欠点

Excelは汎用性が高く、表計算ツールとしてだけでなく、WBS(作業分解構成図)や議事録のフォーマット作成など、多岐にわたる業務に利用されています。しかし、Excelを使った管理は、担当者の裁量や好みに依存しやすく、フォーマットがバラバラになることが問題です。特に、複数の担当者が共同で作業を行う場合、セルに個別の書式や色を使ったり、マクロを使用したりすることで、管理が非効率化する傾向があります。

3. データの整合性と統一性の課題

Excelでの構成管理には、データの正規化(統一された形式での入力)が困難という課題もあります。例えば、「サーバー」や「サーバ」など、微妙な表記の違いがデータの検索やフィルタリングを阻害するケースがあります。このような一貫性のない入力は、特に大規模なデータセットで深刻な問題を引き起こします。

4. マクロの限界

一部の企業では、入力作業を効率化するためにExcelのマクロ機能を活用していますが、これにも問題が潜んでいます。マクロは特定の状況では有用ですが、メンテナンスや運用が個人に依存しやすく、担当者が変更になると修正や理解に時間がかかることがあります。さらに、マクロに依存しすぎると、システムの柔軟性が低下し、他システムとの連携が困難になります。

5. 解決策: 専用の構成管理ツール導入の提案

これらの課題を踏まえると、システムの構成管理にはExcelよりも専用の構成管理ツール(例: ServiceNow、Jira、Ansibleなど)の導入を検討すべきです。これらのツールは、以下の点でExcelを上回ります。

データの一元管理:一貫したデータ入力フォーマットを強制することで、データの整合性を保つことができます。

自動化と更新の簡便化:自動的に最新情報を反映させ、手動更新の手間を削減します。

チームでの協働管理:複数人での同時作業が容易で、アクセス権限の管理も可能です。

6. 運用効率の向上

これにより、構成管理の運用効率が大幅に向上し、異常時にも正確な情報がすぐに参照できるため、問題の特定や解決が迅速に行えるようになります。さらに、長期的なコスト削減にも繋がります。

このように、Excelは特定の場面では便利なツールですが、規模が拡大するにつれてその限界が露呈します。より効果的な管理を実現するために、専門ツールの導入を積極的に検討することが重要です。

1. 障害発生時の課題:正確な情報管理の重要性

システムやサーバー障害が発生した際、正確で最新のシステム構成情報がなければ、迅速かつ効果的な障害対応が難しくなります。特に、システム停止の影響範囲が把握できなければ、影響を受けるユーザーや関係者に適切なアナウンスを行うことができず、信頼性の低下や混乱を招く可能性があります。

加えて、ベンダー対応を依頼する際にも、連絡先や契約情報を探し回る必要が生じる場合があり、対応の遅延が発生します。場合によっては、保守契約を購入しているにもかかわらず、保守登録が行われていないことが発覚し、サービスが受けられないという事態も発生する可能性があります。

2. セキュリティリスク対応:構成管理の重要性

重大なセキュリティアナウンスが出た場合、自社のITインフラが影響を受けるかどうかを迅速に確認する必要があります。システム構成管理が適切に行われていれば、OSやソフトウェアのバージョン、パッチの適用状況をすぐに把握でき、迅速な対応が可能です。

しかし、構成管理が不十分である場合、サーバーに個別にログインして実態を調査する必要があり、対応が大幅に遅れる可能性があります。特に緊急のパッチ適用が必要な場合、セキュリティリスクが高まる時間が発生し、企業にとって大きな脅威となりかねません。

3. 管理すべき構成情報の例

ITインフラの構成管理において、正確に把握・管理しておくべき情報は以下の通りです。

ハードウェア構成情報:モデル、CPU、メモリ、ディスク、その他ハードウェア

周辺機器や連携システム:プリンターや外部システムなどの接続情報

ネットワーク設定:NIC、IPアドレス、ルーティング情報など

ファームウェアやドライバのバージョン:バージョンアップの必要性を把握するため

OSおよびミドルウェア情報:セキュリティパッチ適用状況、インストールソフトウェア一覧

利用者情報:システムを利用するユーザーの詳細情報

設定情報:システム構成やパラメータの詳細設定

保守契約情報:ベンダー連絡先、保守ID、契約状況など

設置場所や環境:機器が設置されている場所、電源状況など

導入時の見積もり情報:コスト管理や契約更新時に参考

特に保守契約情報の管理は、迅速な対応を行うために極めて重要です。保守契約が未登録である場合、ハードウェアの修理やソフトウェアのサポートを受けられなくなる可能性があり、システム運用に支障をきたします。ソフトウェアの場合、バージョンに応じてサポート期間が決まっているため、サポート終了バージョンを使用している場合には、バージョンアップの検討も必要です。

4. 解決策:構成管理の自動化とツールの導入

これらの課題に対処するため、手動による構成管理から、構成管理ツール(CMDBや自動化ツール)の導入が有効です。例えば、ServiceNowやPuppet、Ansibleといったツールを使用することで、システムの全体像をリアルタイムで把握し、以下の利点を享受できます。

障害発生時の迅速対応:リアルタイムで最新の構成情報を提供し、障害の切り分けが効率化されます。

セキュリティリスクの迅速対応:影響を受けるシステムを即座に確認でき、パッチ適用が迅速化します。

保守契約情報の一元管理:契約情報が一元化され、ベンダーへの迅速な連絡やサポート依頼が可能です。

構成管理の自動化により、企業のリスクを低減し、システムの安定性とセキュリティが向上します。