目次

IoTデータ活用を加速させる、戦略的MQTTプラットフォーム選定

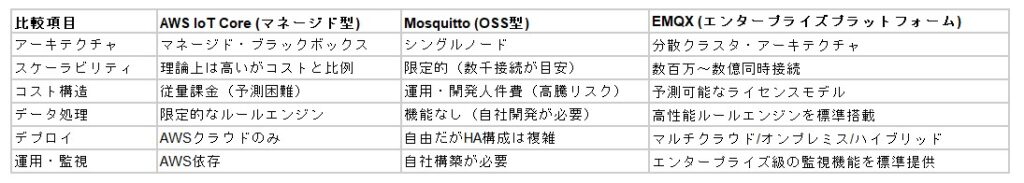

AWS IoT Coreのコスト問題、Mosquittoのスケーラビリティ課題を解消するEMQXのアーキテクチャ的優位性

IoTデータ活用の成否は、PoC(概念実証)段階を越え、本番運用フェーズに移行する際のデータ連携基盤のアーキテクチャ選定に大きく左右されます。多くのプロジェクトが直面する「予測不能なクラウドコストの増大」「接続デバイス数の増加に伴う性能限界」「自社開発による運用負荷の高騰」といった課題は、MQTTブローカーの選定ミスが根本原因であるケースが少なくありません。

本稿では、データ戦略の視点から主要なMQTTブローカー(AWS IoT Core, Mosquitto)のアーキテクチャ上の特性と限界を分析。その上で、エンタープライズグレードのMQTTプラットフォームが、いかにしてこれらの課題を構造的に解決し、データ資産価値を最大化するのかを論理的に解説します。

MQTTブローカー選定の失敗が招く、3つの技術的負債

データ基盤の中核を担うMQTTブローカーの選定は、以下の3つの戦略的視点から評価する必要があります。

スケーラビリティとアーキテクチャ

PoCで有効だったシングルノード構成のブローカー(例: Mosquitto)は、本番環境の数万~数百万という接続規模に耐えられません。後からクラスタ構成を自社開発するアプローチは、多大な工数と技術的リスクを伴います。

TCO(総所有コスト)

マネージドサービス(例: AWS IoT Core)の従量課金モデルは、データ量やメッセージ数の増加に伴い、コストが指数関数的に増大するリスクを内包します。一方、OSSの利用は初期コストを抑えられますが、高可用性やセキュリティ、監視機能の実装・運用にかかる隠れた人件費がTCOを押し上げる要因となります。

データ処理能力と連携性

収集した全ての生データをクラウドへ転送するアーキテクチャは、データ転送コストを増大させるだけでなく、クラウド側での処理負荷を高めます。データソースに近いエッジ/オンプレミス環境で、いかにインテリジェントなデータ処理(フィルタリング、集約、変換)を行えるかが、データパイプライン全体の効率を決定します。

主要ソリューションの比較分析:アーキテクチャの限界とEMQXの提供価値

EMQXが提供する戦略的価値

圧倒的なスケーラビリティと高可用性

EMQXは、設計思想として水平スケール可能なクラスタリングを前提としています。これにより、ビジネスの成長に合わせてシームレスに性能を拡張でき、PoCから数百万デバイスの大規模本番環境まで、単一のアーキテクチャで対応可能です。

インテリジェントなエッジ/オンプレミス処理

標準搭載された高性能ルールエンジンにより、SQLライクな記述でデータフィルタリング、フォーマット変換、集約といった処理をデータソースに近い場所で実行できます。これにより、クラウドへの転送データ量を最適化し、データ転送コストとクラウド側の処理負荷を大幅に削減します。

クラウドロックインからの脱却とTCO最適化

オンプレミス、あらゆるパブリッククラウド、ハイブリッド環境にデプロイできる柔軟性を提供します。これにより、AWS IoT Coreのようなベンダーロックインを回避し、インフラコストを最適化。予測可能なコストモデルにより、データ基盤全体のTCOを可視化・削減します。

データ活用の最大化

40種類以上のデータブリッジ機能を持ち、Kafka、各種データベース、データレイクといった多様なバックエンドシステムとのシームレスな連携を実現。データサイロを解消し、収集したデータをリアルタイムで分析・活用するためのパイプラインを効率的に構築します。

このような課題を持つアーキテクト・IT責任者へ

EMQXは、単なるMQTTブローカーの代替ではありません。将来の拡張性を見据え、TCOを最適化し、データ活用の高度化を実現するための「スケーラブルIoTデータ連携プラットフォーム」です。

データ基盤全体のTCOを算出し、投資対効果(ROI)を最大化する責務を負う方

AWS IoT Coreのコスト構造に懸念を持ち、ハイブリッド/マルチクラウド戦略を検討しているインフラアーキテクト

MosquittoでのPoCを終え、本番環境のスケーラビリティと自社開発・運用負荷に課題を感じている開発リーダー

数万~数百万エンドポイントからのデータをリアルタイムで処理・分析する、ミッションクリティカルなIoT基盤を設計する方

オンプレミス/エッジでの高度なデータルーティングやリアルタイム処理といった、複雑な要件を持つ方

技術的負債を回避し、PoCから本番まで手戻りなくスケールするデータ戦略を描きたい方

OT環境におけるオペレーショナル・レジリエンス戦略

データガバナンスの確立から始める、セキュリティリスクの定量化と「装置の知能化」実現へのロードマップ

DXの進展によりITとOTが融合した現代の事業環境において、OT(Operational Technology)環境のサイバーリスクは、情報漏洩に留まらず、生産ラインの停止や製品品質の劣化といった深刻な事業リスクに直結します。

真の課題は、個別の脅威への場当たり的な対応ではありません。OT環境に接続された全デバイスを「データソース」として網羅的に把握・分析し、潜在するリスクを定量化した上で、事業インパクトに基づいた統制を自動化する仕組み、すなわち「OTデータガバナンス」の欠如こそが、本質的な構造課題です。

本稿では、この課題を解決し、守りのセキュリティ投資を「装置の知能化」のような攻めのデータ活用へと繋げる、一貫したデータ戦略アプローチを提示します。

ステップ1: データガバナンス基盤の確立 ― 統制の第一歩は「データソース」の網羅的把握

OT環境のレジリエンス(復旧力・回復力)向上は、まず現状をデータとして正確に把握することから始まります。環境内に存在するAGV、PLC、センサー、PCといった多様なデバイスは、リスクの潜在源であると同時に、分析の起点となる貴重な**「データソース」**です。

統制の第一歩は、これらのデータソースをエージェントレスで網羅的に特定し、動的な資産インベントリを構築することです。Forescoutプラットフォームは、これを実現し、「どのデバイスが」「どこに接続され」「どのような通信を行い」「既知の脆弱性を内包していないか」という、データガバナンスの根幹をなす情報をリアルタイムに収集・可視化します。

ステップ2: データ分析によるリスクの定量化と統制の自動化

次に、可視化された資産インベントリと通信ログデータに、脆弱性情報や自社のセキュリティポリシーを統合・分析します。これにより、個々のデバイスが事業に与えるリスクを客観的なスコアとして定量化することが可能となります。

このデータドリブンなアプローチにより、勘や経験に頼ることなく、「対処すべき脅威」の優先順位を客観的に判断できます。

さらに、定義したリスクスコアやデバイスの振る舞いをトリガーとし、ネットワークからの隔離やアクセス制御といったアクションを自動実行します。これは、データ分析の結果に基づいた自律的なインシデントレスポンスであり、インシデントの検知から封じ込めまでの時間を劇的に短縮し、セキュリティ運用の高度化と効率化を両立します。

ステップ3: 高度なデータ活用へ ― 「装置の知能化」を支える信頼性の高いデータ連携基盤

近年、製造・物流現場で導入が進むAGV(無人搬送車)やAMR(自律走行ロボット)、画像処理システムといった「インテリジェント装置」は、それ自体が高度なデータ活用アプリケーションです。

これらの装置が自律的かつ安定的に稼働するためには、装置間やサーバーとのデータ連携が、脅威やノイズのないクリーンなネットワーク上で保証されていることが絶対条件となります。未管理デバイスからの予期せぬ通信や、マルウェアによるデータ汚染は、装置の誤作動や生産ライン全体の停止に繋がりかねません。

ステップ1・2で構築したデータガバナンス基盤は、不正デバイスを排除し、通信を可視化・制御することで、この「信頼できるデータ連携基盤」を提供します。この安全な土台があって初めて、AIや高度な制御アルゴリズムといった付加価値の高いソフトウェアを、安心して実装・運用することが可能になるのです。

結論:データ戦略が導く、OT環境の未来

OT環境のレジリエンス向上とは、防御一辺倒のセキュリティ対策を指すのではありません。それは、「①データソースの網羅的把握 → ②データに基づくリスク分析 → ③分析結果に基づく自動制御」というデータドリブンなサイクルを確立し、その安全な基盤の上で「④装置の知能化」といった攻めのデータ活用を加速させる、一貫した戦略です。

データ分析の盲点:「管理外資産」がもたらすリスクと、OT/IoT環境におけるデータ戦略

1. データ分析の基盤:「資産データ」の完全性という課題

デジタル化の進展、特にクラウド、リモートワーク、IoT機器の普及は、企業ネットワークに接続されるアセット(資産)のデータセットを急速に複雑化させています。しかし、これらの全資産データを正確に把握・管理できている企業は多くありません。

シャドーITや一時的に接続されたデバイスなど、**台帳データから欠落した「管理外資産」は、セキュリティリスクを分析する上での重大な「盲点」となります。セキュリティインシデントは、この単一の「欠損データ(見えない資産)」**から発生し得ます。今必要なのは、全ての資産データを網羅的に収集・可視化する、ゼロベースでのデータ棚卸しです。

2. 従来型データ収集の限界と「見えているつもり」というバイアス

多くの企業では、既存の台帳やエージェント型の資産管理ツールを用いています。しかし、これらの手法から得られる資産データセットには本質的な限界があります。

特に、未許可端末、持ち込みデバイス、あるいはメンテナンス業者が一時的に接続する機器など、エージェントを導入できない資産のデータを網羅的に捕捉することは困難です。IT部門の人的リソースの限界もあり、**データの「抜け漏れ」**は構造的に発生しやすい状況です。これは「見えているつもり」というバイアス(認識の歪み)であり、攻撃対象となり得る死角(データ上の盲点)を生み出しています。

3. データドリブンな可視化の実践:データ収集基盤としての「iNetSec SF」

「全資産データをどうやって網羅的に収集するか?」というデータ収集戦略上の課題に対し、現実的かつ効果的なアプローチが必要です。

iNetSec SFは、エージェントレスでネットワーク上の全端末データを自動検出するソリューションです。これにより、未許可PC・持ち込みデバイス・IoT機器までを含む高精度な資産インベントリデータを構築・維持できます。導入負荷も少なく、従来の手法では収集困難だったデータ領域を補完し、データギャップに起因する潜在的リスクを一掃します。セミナーの中では、実際の企業事例データも交えながら、リスク低減に直結する資産データ可視化の進め方をわかりやすく解説します。

4. OT環境におけるデータ分析:最重要KPI「MTTR」の管理

この「資産データの欠損」問題は、製造現場やインフラ設備を支えるOT(Operational Technology)環境において、より深刻な影響を及ぼします。

OT環境では、ダウンタイム(停止時間)というデータが、企業の収益に直接的なマイナスの影響を与えます。したがって、障害からのMTTR(平均修復時間)の最小化が、最重要KPI(重要業績評価指標)の一つとなります。

しかし、閉域ネットワークや旧式OSの継続利用といったOT固有の制約は、IT環境と同様のリスク評価データや資産データの収集を困難にしています。近年はハードウェア故障だけでなく、サイバー攻撃によるダウンタイムリスクも高まっており、「復旧時間(MTTR)をいかに短縮し、事業インパクトを最小化するか」がデータ分析の焦点となっています。

5. データに基づくレジリエンス強化:復旧プロセスの標準化

長期稼働するOT環境に求められる“実践的な復旧力”とは、MTTRというKPIを確実に改善することです。

障害発生時でも現場で迅速かつ安全に対応できる仕組み(プロセス)の構築法をご紹介します。IT専門のデータ人材が不足する環境でも、復旧プロセスを標準化・短縮化する「ワンクリック復元」など、現場の復旧体制をデータ(KPI)で管理可能な仕組みとして整備する具体的な方法を解説します。

6. スマートファクトリーのデータ戦略:PoCの壁を越える「全体設計」

製造現場における労働力不足というマクロデータを背景に、スマートファクトリー化が急速に進んでいます。これは、センサー、エッジデバイス、AIといった技術を活用し、新たなデータを取得・分析する取り組みです。

目標は、作業プロセスの自動化による生産性データ(OEE: 設備総合効率など)の向上、品質データ(不良率など)の安定化とトレーサビリティの確保、エネルギー使用量や設備稼働データの可視化を通じたコスト最適化です。これらはすべて、データ分析によって達成される経営課題の解決です。

しかし、IoTシステム導入において「PoC(概念実証)のデータでは成功したが、本格導入・展開に至らない」という課題が頻発しています。

これは、PoCという小規模なデータ環境から、工場全体の大規模なデータ(量・速度・多様性)を処理・分析する「データ基盤のスケーラビリティ」を見誤っているケースが多いためです。PoCの成功に留まらず、全社展開を見据えたデータアーキテクチャの全体設計力が、IoT導入の成否を分ける重要な要因となっています。

製造業のデータ活用を阻む「PoCの壁」:データ戦略の不在という課題

製造業従事者約500名を対象とした調査データからも、データ活用が進まない組織的な要因が明らかになっています。それは「データ利活用に関する専門知識を持つ人材の不足」や、「データ戦略を推進するリーダーの不在」です。

この結果、「どのデータが業務価値を生むのか」という分析的視点や、データアーキテクチャの全体設計が欠如します。現場では「単なるデータ収集」が目的化し、「そのデータを取得して、どのKPIを改善するのか」「どう業務プロセスに組み込むのか」といった、データ活用の本質的な目的定義が不十分な状態に陥っています。

さらに、IoTデータ基盤の構築には、ハードウェア構成、ネットワーク設計、データ連携(ETL/ELT)、クラウド基盤、セキュリティガバナンスなど、複数領域にまたがる高度な知識と、データアーキテクチャの全体設計力が求められます。導入は単なる機器選定ではなく、業務プロセスの最適化に貢献する、全体最適なデータパイプラインの構築として捉える必要があります。

セキュアなデータパイプライン構築:”IoTセキュアリモートマネジメント(SRM)”

IIJは、産業領域のIoTソリューション「産業IoTセキュアリモートマネジメント(SRM)」を展開しております。

これは、工場内設備のPLC/CNCや各種センサーからデータを収集するゲートウェイ、セキュアな通信サービス、可視化・分析を行うクラウド基盤までをワンストップで提供し、信頼性の高いデータパイプラインを構築するものです。スマートファクトリの実現に向けて、設備稼働監視・工場生産管理・現場映像監視・計測器IoT化といった多様なユースケースをデータで支援し、生産効率(KPI)の改善を加速させます。

PoCで終わらせない:データ戦略とアーキテクチャ設計

導入がPoC(概念実証)止まりとなる背景には、先に述べた調査データが示すようなデータ戦略の欠如があります。

本セッションでは、スマートファクトリー化を加速させるため、IoT導入に必要な技術要素(センサー、ネットワーク、クラウド、セキュリティ)をデータフローの観点から整理します。

さらに、IIJの取り組み事例やユースケースを交え、成果につながるポイントを解説します。また、企業のデータ課題を可視化し、最適な技術構成(データアーキテクチャ)や導入ロードマップを明確にする「製造業向けIoTワークショップ」の取り組みについてもご紹介します。

「データはあるが活用できない」:現場のドメイン知識と分析のギャップ

製造現場では、温度・湿度・圧力などのセンサーデータはIoTで取得されているものの、それらのデータが「活用」フェーズに至っていないケースが多く見られます。データが単なる監視やログ保存(Data Lake)にとどまり、実際の業務改善や品質向上のための分析(Analytics)に活かされていません。

現場の担当者は、「不良の予兆把握」や「品質の安定化」といった明確な業務ニーズ(=分析ニーズ)を持っています。しかし、彼らはITやデータ分析の専門家ではありません。分析ツールの選定や導入、データハンドリングの負荷が高すぎることが、データ活用の民主化(Data Democratization)を阻害しています。

結果として、最も価値を生み出せるはずの現場がアナログな運用に依存し続けるという、非効率な状態が続いています。

現場主導のデータ分析を実現:工場IoT特化型BIツール

この「現場の分析ニーズ」と「ITスキルのギャップ」を埋めるために開発されたのが、このようなツールです。これは、富士電機の工場で実際に現場の課題(ペイン)を基に開発された、工場IoTデータ専用のBIツールです。

特徴は、迅速な分析立ち上げを可能にする監視・分析テンプレート、IT知識を前提としない直感的なUI(ユーザーインターフェイス)、そして現場での改善サイクルに追随できる高い汎用性(設定変更の容易さ)です。

これにより、現場主導でのデータ可vis化・分析・予兆保全といった高度なデータ活用サイクルをクイックに回すことが可能になります。低コストでのスモールスタートが可能なため、データ活用のROI(投資対効果)を測定しやすい点も特徴です。

このようなデータ課題を持つご担当者におすすめします

センサーデータは収集している(Data Lake)が、分析・活用(Analytics)できていない。

品質管理部門で、不良の未然防止や予兆保全といった高度なデータ分析に取り組みたい。

IT部門に依存せず、現場のドメイン知識を活かした分析(=データ民主化)を実現したい。

Excelや紙ベースのアナログなデータ管理から脱却し、データドリブンな運用に移行したい。

データ活用の第一歩(スモールスタート)を、低コストかつ迅速に踏み出したい。

製造現場におけるデータ活用の障壁:サイロ化と分析リソースの不足

多くの製造現場では、IoT技術の進展により、温度、湿度、圧力、寸法といった多様なセンサーデータの収集が可能になっています。しかし、これらの貴重なデータは、単なるモニタリングやログ保存に留まっているケースが散見されます。データが「収集」されているだけで、「分析」や「アクション」に繋がっていないのです。

その背景には、深刻なデータのサイロ化があります。例えば、設備稼働データ(OTデータ)、生産管理システム(L3層)の工程実績データ、販売・SCMデータ(L4層)、さらには設備保全の履歴といった各データが、異なるシステムに分断されて格納されています。これでは、例えば「特定のセンサー値の変動が、最終製品の品質不良や歩留まりにどう影響したか」「どの工程の非効率が原価を圧迫しているか」といった、部門横断的かつ複合的な分析は極めて困難です。

また、現場担当者は生産活動の専門家であり、データ分析の専門家ではありません。不良の予兆検知や品質の安定化といった高度な分析ニーズは存在するものの、データ基盤の構築、分析ツールの選定・導入、そして分析モデルの構築といったプロセスには高度なITスキルやデータサイエンスの知見が求められます。このギャップが、データ駆動型の現場改善を阻む大きな要因となっています。結果として、DXの取り組みが停滞し、経験や勘に依存した従来型のアナログなオペレーションから脱却できずにいる企業は少なくありません。

現場主導のデータ分析を実現し、予兆保全から原価管理までを連携

こうした課題に対し、ノーコードでデータ検索・分析が可能なBIツールと、工場の現場ニーズに特化して開発されたツールを核として、製造業のデータ活用プロセス全体を支援します。

最大の特徴は、現場担当者自身がデータ分析の主体となれる点です。IT部門やデータサイエンティストに依存することなく、直感的なインターフェイスを通じて必要なデータにアクセスし、分析を実行できます。実績ある監視・分析テンプレートの活用により、短期間での立ち上げが可能です。

これにより、現場レベルで「設備データの多角的な可視化」から「統計的な相関分析」、さらには「不良の予兆保全モデルの運用」まで、データ活用のレベルを段階的に引き上げることが可能になります。

本ソリューションの真価は、データの連携にあります。分断されていた設備データ、生産管理データ、販売データを統合的に分析基盤に取り込むことで、これまで見えなかった関係性(例えば、設備コンディションと原価の相関)を明らかにします。これにより、設備保全活動の最適化が原価管理にどう貢献するかを定量的に評価するなど、現場の改善活動を経営判断に直結させるデータインサイトを提供します。低コストでのスモールスタートにも対応しており、ROIを測定しながら段階的に活用範囲を拡大できます。

当日は、実際の導入事例に基づき、データがどのように現場の意思決定を変えたかをデモンストレーションを交えて具体的に解説します。

このようなデータ課題をお持ちの担当者・管理職層に最適です

収集したセンサーデータや保全データを、単なる記録から「品質改善」や「稼働率向上」に繋げる分析手法を探している。

生産管理(L3層)やSCM(L4層)のデータが散在しており、製品別・工程別の「精緻な原価分析」ができていない。

不良発生後の原因究明(事後対応)から脱却し、データ分析による「不良の未然防止」や「予兆保全」の仕組みを構築したい。

データ分析をIT部門任せにせず、現場主導でPDCAサイクルを回せる「セルフサービス分析環境」を整備したい。

データが導く、プロセス製造業の変革:全体最適化へのロードマップ

プロセス製造業は今、外部環境の劇的な変化に直面しています。グローバルな市場競争、サプライチェーンの変動性、そして原材料コストの上昇は、従来のオペレーションに大きな変革を迫っています。同時に、国内の労働力不足は、リソース配分の最適化を待ったなしの課題としています。

このような不確実性の高い環境下で競争優位を維持するには、経験や勘に頼った部分的な改善活動ではなく、データに基づいた迅速かつ正確な意思決定、すなわち「データ駆動型経営」への移行が不可欠です。しかし、多くの企業において、その取り組みは「現場の見える化」に留まり、業務プロセス全体の最適化にまでは至っていません。

なぜ「見える化」で止まるのか:データ活用の壁

変化に対応できる強靭なオペレーションを構築するプロセスは、容易ではありません。特にITリソースやデータ分析のノウハウが限られる中堅・中小企業においては、自社に適したDXの進め方を見出せずにいます。

属人化した改善: 特定の個人の知見に依存した改善活動は、組織的なナレッジとして蓄積・スケールされません。

局所最適なデジタル化: 各部門が個別にツールを導入した結果、データがサイロ化し、部門間連携を前提とした全体最適の分析が妨げられています。

これらの課題は、明確なデータ活用戦略とガバナンスの欠如に起因します。

データ活用戦略の第一歩:「スマートマニュファクチャリング構築ガイドライン」の解読

データコンサルタントの視点から、株式会社日本能率協会コンサルティング(JMAC)が策定した「スマートマニュファクチャリング構築ガイドライン」を解説します。このガイドラインを、単なる理想論ではなく、データ活用の「全体最適」を見据えた実践的なロードマップとして読み解きます。

「見える化」の次へ:IoTデータを継続的改善に繋げる実践ステップ

続く後半では、このガイドラインに基づき、特に中堅・中小企業が直面する「何からデータを収集し、どう分析に繋げるべきか」という問いに答えます。

IoTによって収集されたデータを、単なる「現状把握(記述的分析)」で終わらせず、いかにして「原因究明(診断的分析)」や「継続的な改善プロセス」に組み込んでいくか。実際の導入事例を詳細に分析し、データ活用を組織に定着させるための具体的なアプローチと、その効果を明らかにします。

さらに、データ分析から導き出された課題に対し、インパクトと実現可能性に基づいた「優先順位付け」を行う手法など、データ駆動型の現場改革を推進するための実践的な知見を提供します。

このようなデータ戦略・分析の課題を持つ方に推奨します

現場の業務改革やDX推進を担当し、データに基づいた改善プロセスの確立を目指している。

IoT導入を計画中、または導入済みだが、収集データをどう分析し、経営成果に結びつけるかの具体策に悩んでいる。

スマートマニュファクチャリング構想の実現に向けた、自社のデータ活用ロードマップを策定したい。

OT環境におけるデータ可用性と事業継続性:実践的なリカバリー戦略

製造現場やインフラを支えるOT(Operational Technology)環境において、ダウンタイムは収益機会の逸失に直結します。そのため、障害発生からの迅速な復旧、すなわちRTO(目標復旧時間)の短縮が最重要の経営課題の一つです。

しかし、OT環境は、閉域ネットワークの採用やレガシーOSの継続利用など、IT環境とは根本的に異なる特性を持っています。これにより、IT標準のバックアップやリカバリー手法をそのまま適用できないケースが少なくありません。

近年では、ハードウェア故障といった物理的な障害に加え、サイバー攻撃によるデータ侵害や稼働停止リスクも顕在化しています。「いかに迅速かつ安全にデータを復旧し、オペレーションを正常化させるか」が、事業継続性の観点から強く問われています。

現場のインシデント対応力を高める、レジリエンス強化のシステム的アプローチとは?

長期にわたり稼働するOT環境のレジリエンス(回復力)を高めるには、インシデント発生時に現場担当者自身が迅速かつ安全に対応できる「仕組み」の構築が不可欠です。

IT専門人材が現場に常駐していない状況を前提とし、直感的な操作(例:「ワンクリック復元」)によってリカバリープロセスを実行できる、実践的なソリューションを解説します。これは、属人的な対応を排除し、復旧体制を標準化・システム化する具体的なアプローチです。

「モノ売り」から「データ駆動型サービス(コト売り)」へ:医療機器における付加価値の源泉

医療業界においてもDXが加速しており、医療機器メーカーには、単なる「装置販売(モノ売り)」から、「装置から得られるデータを活用したサービス提供(コト売り)」へのビジネスモデル変革が求められています。

例えば、装置の稼働データを活用した遠隔監視や予知保全による「稼働率の担保」、検査結果データの迅速な連携・共有、さらには収集データをAI等で解析することによる「診断支援」や「予防医療への貢献」などです。このように、機器から生成されるデータをいかに付加価値サービスに転換するかが、製品競争力、顧客満足度、そして収益性の向上に直結しています。

データ活用の障壁:レガシー機器と独自プロトコルの混在

しかし、医療機器のデータ活用(IoT化)を推進する上では、特有の課題が存在します。医療機器は高額であり、厳格な安全規制のもとで長期間運用される特性があります。

その結果、多くの既存装置(レガシーシステム)は外部とのデータ連携を前提として設計されていません。さらに、メーカーや機種ごとに通信プロトコルが異なる(独自仕様が乱立している)ケースが多く、これがデータ収集・統合の大きな技術的負債(ハードル)となっています。

データ活用を目指してIoT接続を試みたものの、この「データの入口」の標準化が困難であり、全社的なデータ統合プラットフォームの構築を断念した事例も少なくありません。

IoT化が困難な医療機器のデータを収集・統合・活用する実践的アプローチ

IoTプラットフォームを用い、こうしたレガシー機器や独自仕様の装置群からデータを「収集・統合」し、それを「可視化」や「サービス化」に繋げる具体的な手法があります。

これらのツールは、多様なプロトコルへの対応力と高い拡張性を持ち、既存の機器環境を活かしたままデータ活用を可能にする、セキュアなIoTデータ基盤です。GUIベースの直感的な操作(ドラッグ&ドロップ)によるデータ処理フローの構築や、閾値超過のアラート発報といったリアルタイム処理も実装しています。

さらに、収集・分析したIoTデータを、実際の保守サービス業務に連携させる事例として別のツールとの統合をご紹介します。もう一つのツールの機能は、保守・点検、修理対応、作業員のアサイン管理など、アフターサービス業務プロセス全体をデジタル化・最適化するソリューションです。

ツールが検知した「装置の異常予兆データ」をトリガーとして自動でサービスチケットを発行し、最適な保守担当者をアサインする。このようなデータ連携により、リアクティブ(事後対応型)な保守から、プロアクティブ(予防保全型)な「止めないサービス」へと変革させることが可能になります。

このようなデータ戦略課題を持つ医療機器メーカーの方におすすめします

医療機器の稼働データを活用した、新たな付加価値サービス(サブスクリプション型保守など)を企画・開発している。

「モノ売り」中心のビジネスモデルから、「コト売り(データサービス)」への転換戦略を模索している。

遠隔監視や予知保全(Predictive Maintenance)の仕組みを構築し、保守サービスの効率化と高度化を図りたい。

既存装置から得られるデータを分析し、サービスの質的向上やオペレーションの最適化を目指している。

データ活用の必要性は認識しているが、具体的な技術選定やスモールスタートの方法論が明確になっていない。

これらの課題を解決するためには、まず「現場起点でのスモールなデータ可視化」から始め、それを全社的な「業務プロセスの最適化」へとスケールアップさせていくための、戦略的なデータ活用基盤が求められます。

成功事例とガイドラインから学ぶ、IoTデータを活用した「失敗しない現場改革」の実行ステップ

プロセス製造業における全体最適の実現という視点から、IoT導入・活用をいかにして具体的な現場改善(アウトカム)に結びつけるか。その具体的な実行プロセスについて、実際の成功事例のデータ分析を交えながら詳細に解説します。

データドリブンな価値創出を加速する:IoTデータの戦略的活用と基盤構築の課題

データドリブンな価値創出を加速する:IoTデータの戦略的活用と基盤構築の課題

近年、IoT(モノのインターネット)の導入は多岐にわたる業種で進展し、センサーやデバイスから得られる膨大なデータは、新たなビジネスモデルや業務効率化の源泉として注目されています。製造業における予知保全、小売業での顧客行動分析、インフラ分野での遠隔監視など、IoTから得られるリアルタイムデータは、企業の競争優位性を左右する重要な資産となりつつあります。

しかし、IoTの導入がそのまま明確な事業成果に直結している事例ばかりではありません。

IoTはあくまでデータを取得・伝送するための手段であり、その真価は収集されたデータをいかに分析し、示唆(インサイト)に変え、ビジネス上の意思決定に活用するかにかかっています。導入コストや運用負荷に見合う**ROI(投資対効果)**が不明確であれば、プロジェクトの継続性は担保されません。

また、データ活用の前提となるインフラ面でも、以下の「壁」が顕在化しがちです。

データ収集・伝送の不安定性: 実運用フェーズでの「通信の不安定化」や「大容量データのリアルタイム伝送における遅延」。

データガバナンスとセキュリティ: デバイス増加に伴う「セキュリティ要件の複雑化」や「データプライバシーの確保」。

スケーラビリティの不足: デバイスやサービスの増加に対応できない「データ処理基盤の拡張性不足」。

その結果、せっかく収集したデータが十分に分析・活用されず、「データ収集」や「ダッシュボードでの可視化」で止まってしまう、データドリブンとは言えないプロジェクトも多く散見されます。

多数のIoTプロジェクトを支援してきた当社の知見に基づき、IoT通信基盤の実態と、データ活用を最大化するための進化の方向性を深掘りいたします。

データコンサルタントおよびデータアナリストの視点から、データの信頼性を担保する安定した収集・伝送、データの安全性を守るセキュリティ、そして将来のデータ量増加に対応する拡張性を軸に、実際の現場で見えてきた「インフラ面の課題」と、それを乗り越え、データ活用に繋げてきた具体的な解決策を解説します。

クラウド、ネットワーク、セキュリティといったフルスタックな技術力を持つ通信事業者としての視点から、データ活用を見据えたIoT基盤の設計・運用における課題解決のヒントや、今後の戦略的なデータ活用に向けた考え方をご提供します。

データ活用を目的としたIoT導入を検討しているものの、データ戦略やPoCの進め方に迷われている方。

通信、クラウド、セキュリティを含めたIoTインフラの堅牢な構築・運用に課題を感じているIT部門・開発部門の方。

PoC(実証実験)から全社展開(本格導入)へのステップにおけるデータ基盤の整備に悩まれている方。

顧客や社内に対し、事業価値に直結するIoTデータ活用提案を行う立場の方。

協業パートナーやデータ通信基盤の選定において、安定性・セキュリティ・拡張性を重視されている方。

OTセキュリティの実践ガイド:制御システムを守るための現場主導のセキュリティ戦略

製造業やインフラ業界において、工場や設備を制御するOT(Operational Technology)システムは、企業活動の根幹を支える重要な存在です。生産ラインの稼働、電力や水道の供給、交通インフラの運用など、社会のあらゆる場面でOTは活躍しています。

しかし近年、OTシステムがサイバー攻撃の標的となるケースが急増しています。従来、閉じたネットワーク内で運用されていたOT環境が、IoTやクラウドとの連携によって外部とつながるようになったことで、ITと同様のセキュリティリスクにさらされるようになったのです。

本記事では、OTセキュリティの基本から、現場で実践すべき対策、そして最新のトレンドまでをわかりやすく解説します。

OTとITの違いとは?

まず、OTとITの違いを整理しておきましょう。

OTは「止められない」「変更しにくい」「安全が最優先」といった特性があり、ITとは異なるアプローチが求められます。

OTセキュリティの主な脅威

1. ランサムウェアによる生産停止

ITシステムを経由してOTネットワークに侵入し、制御システムを暗号化・停止させる攻撃が増加しています。

2. リモートアクセスの悪用

保守や監視のために設けたリモート接続が、攻撃者の侵入口になるケースがあります。

3. 古い機器の脆弱性

長期間更新されていないPLCやHMI(ヒューマンマシンインターフェース)には、既知の脆弱性が残っていることがあります。

4. 内部不正や設定ミス

現場でのUSB使用や設定変更が、意図せずセキュリティホールを生むこともあります。

OTセキュリティの実践ステップ

1. 資産の可視化(アセットマネジメント)

まずは、工場内にどんな制御機器やネットワーク機器があるのかを洗い出し、一覧化します。型番、ファームウェア、接続先なども記録します。

2. ネットワークのセグメンテーション

OTネットワークとITネットワークを明確に分離し、必要最小限の通信だけを許可します。ファイアウォールやVLANを活用しましょう。

3. アクセス制御と認証の強化

制御システムへのアクセスには、IDとパスワードだけでなく、多要素認証(MFA)を導入し、権限も最小限に設定します。

4. パッチ管理と更新計画の策定

制御機器のファームウェアやOSの更新は慎重に行う必要がありますが、脆弱性を放置しないよう、計画的な更新スケジュールを立てます。

5. ログの取得と監視体制の構築

OT機器の操作ログや通信ログを収集し、異常な挙動があれば早期に検知できるようにします。SIEMやXDRの導入も検討しましょう。

6. インシデント対応計画の整備

万が一の攻撃時に備え、対応フローや連絡体制、復旧手順を明文化しておきます。定期的な訓練も重要です。

OTセキュリティにおける現場との連携の重要性

OTセキュリティは、IT部門だけで完結するものではありません。実際に設備を操作・保守する現場の理解と協力が不可欠です。

セキュリティ対策が現場の作業を妨げないよう、現実的なルールを設定する

現場の声を反映した運用フローを構築する

教育や研修を通じて、セキュリティ意識を高める

トラブル時の初動対応を現場と共有しておく

このように、現場とITが一体となって取り組むことで、実効性のあるセキュリティ体制が構築できます。

最近のOTセキュリティトレンド

- ICS専用のセキュリティソリューションの普及

制御プロトコルに対応したIDS(侵入検知システム)や、産業用ファイアウォールの導入が進んでいます。

- ゼロトラストのOT環境への適用

「信頼しないこと」を前提に、すべての通信や操作を検証するゼロトラストの考え方が、OTにも広がりつつあります。

- デジタルツインによるセキュリティ検証

仮想空間上で制御システムの挙動を再現し、攻撃シナリオや対策の効果を事前に検証する取り組みが注目されています。

- 法規制とガイドラインの強化

NIST SP 800-82やIEC 62443など、OTセキュリティに特化した国際標準への対応が求められる場面が増えています。

まとめ:止められない現場を、止めないために

OTセキュリティは、単なる情報漏洩の防止ではなく、「生産を止めない」「安全を守る」ための戦略です。攻撃者は、企業の“止められない事情”を狙ってきます。

だからこそ、現場の実情に即した、実践的で持続可能なセキュリティ対策が必要です。ITとOTの壁を越え、全社一丸となって“守りの現場力”を高めていきましょう。

IoT・OT時代の「データ整理」戦略:現場と経営をつなぐ情報基盤の再設計

近年、製造業をはじめとする多くの業界で、IoT(Internet of Things)とOT(Operational Technology)の融合が進んでいます。工場や設備、物流、建設、エネルギーなど、これまでITとは距離があった現場領域が、センサーやネットワークを通じてデジタル化され、リアルタイムでのデータ取得と活用が可能になりました。

しかし、IoT・OTの導入が進む一方で、現場から収集される膨大なデータを「どう整理し、どう活かすか」が大きな課題となっています。センサーデータ、ログ、アラート、画像、音声など、多様で非構造的な情報を扱うには、従来のITとは異なる視点での「データ整理」が不可欠です。

本記事では、IoT・OTの最新動向を踏まえながら、データ整理の重要性と実践的なアプローチについて解説します。

IoTとOTの融合がもたらす変化

IoTは、あらゆるモノをインターネットにつなげ、データを収集・分析・活用する技術です。一方、OTは、工場やプラントなどの現場で使われる制御・運用技術を指します。これまで独立していたITとOTが連携することで、以下のような変化が起きています。

設備の稼働状況をリアルタイムで可視化

異常検知や予兆保全の自動化

エネルギー使用量やCO₂排出量の最適化

生産性や品質の向上に向けたデータ活用

現場と経営の情報連携による意思決定の迅速化

このように、IoT・OTの融合は、現場のデジタル変革(DX)を加速させる鍵となっています。

なぜIoT・OTに「データ整理」が不可欠なのか?

IoT・OTの導入により、現場からは秒単位・ミリ秒単位で膨大なデータが生成されます。しかし、これらのデータはそのままでは活用できません。以下のような理由から、データ整理が極めて重要になります。

1. データの形式がバラバラ

センサー、PLC、カメラ、音声記録など、データの形式や粒度が異なるため、統合・分析が難しくなります。

2. ノイズや欠損が多い

通信エラーやセンサーの不具合により、データに欠損や異常値が含まれることが多く、前処理が必要です。

3. 意味づけがされていない

「温度:85」「振動:0.02」などの数値だけでは意味が分からず、設備名や場所、時間などの文脈情報(メタデータ)が必要です。

4. 保存・活用ルールが不明確

どのデータをどこに、どのくらいの期間保存するかが決まっていないと、ストレージがすぐに逼迫し、必要なデータが見つからなくなります。

最近のITトレンドとIoT・OT・データ整理の融合

1. エッジコンピューティングの普及

データをクラウドに送る前に、現場(エッジ)で一次処理・フィルタリングを行うことで、通信負荷とデータ量を削減する動きが広がっています。

2. データレイクとデータファブリックの導入

構造化・非構造化データを一元的に蓄積・管理するために、データレイクやデータファブリックの活用が進んでいます。

3. AIによる異常検知と予兆保全

整理された時系列データをAIに学習させ、設備の異常や故障の兆候を自動で検出する取り組みが増えています。

4. OTセキュリティとデータガバナンスの強化

OTネットワークへのサイバー攻撃が増加する中、データの所在・アクセス権限・操作履歴を明確にすることが求められています。

IoT・OTデータ整理の実践ステップ

1. データの棚卸しと分類

どの設備から、どのようなデータが、どの頻度で生成されているかを洗い出し、用途別に分類します。

2. メタデータの付与と構造化

設備名、設置場所、測定単位、タイムスタンプなどの情報を付加し、データに意味を持たせます。

3. ノイズ除去と欠損補完のルール化

異常値の除外や欠損データの補完方法を定め、分析に適した状態に整えます。

4. 保存・アーカイブポリシーの策定

リアルタイム分析用、履歴分析用、監査用など、目的に応じて保存期間や保存先を分けます。

5. 可視化とダッシュボードの構築

BIツールやSCADAと連携し、現場の状況をリアルタイムで可視化・共有できる仕組みを整えます。

まとめ:IoT・OTの価値は「整理されたデータ」から生まれる

IoT・OTの導入は、現場の可視化や自動化を実現する強力な手段です。しかし、その真価を発揮するには、データを「整理」し、意味づけし、活用可能な形に整えることが不可欠です。

「どの情報を、誰が、どこで、どのように使っているか」を明確にし、データ整理とIT基盤を連携させることで、現場と経営をつなぐ情報の流れが生まれます。IoT・OTの未来は、整理されたデータの上にこそ築かれるのです。