目次

データティアリングによる分散データの効率的な活用

現代企業のデータ資産はオンプレミスやクラウド上に点在し、エッジデバイスからもデータ収集が必要です。そのため、企業はネットワークを活用したデータティアリングに注力する必要があります。ネットワークベースのティアリングを通じ、さまざまな環境に配置されたデータ資産をクラウドストレージとシームレスに接続し、閉域網を中心とした安全なネットワーク構成で効率的に管理することが求められます。必要に応じて、パブリッククラウドサービスとの連携も可能で、柔軟なデータ活用が実現します。

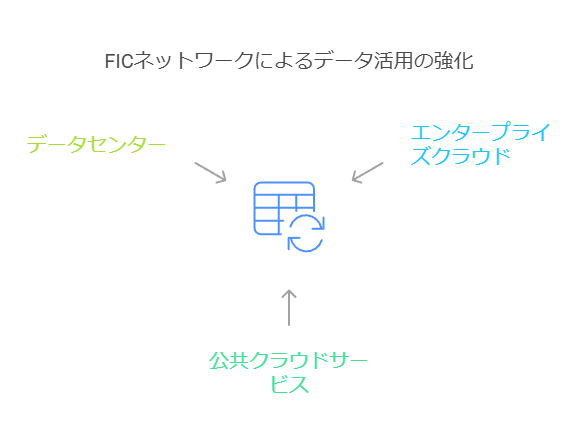

ネットワーク構築の基盤としてのFlexible InterConnect (FIC)

このエンタープライズデータレイクを支えるネットワーク基盤として、次世代インターコネクトサービス「Flexible InterConnect (FIC)」が利用可能です。FICは、エンタープライズクラウドやパブリッククラウドサービス、企業のデータセンター (DC)、データセンター「Nexcenter」を閉域網で安全に接続し、さらに接続先や帯域、セキュリティ設定などを簡単な操作で一元管理することが可能です。このような柔軟なネットワーク環境の提供があります。

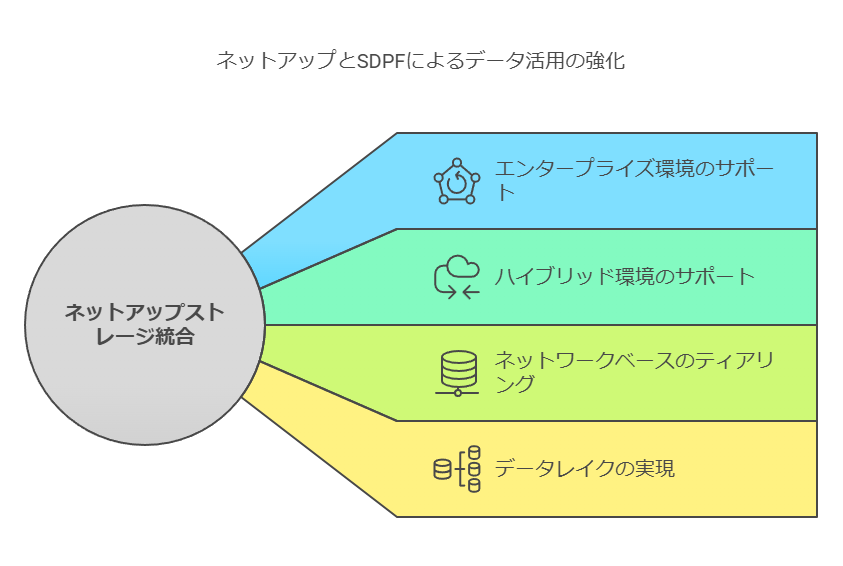

NetApp製品との統合で広がるデータ活用の可能性

NetAppのストレージ製品は、FASやAFFなどのエンタープライズ向けストレージから、パブリッククラウドのCVOやハイブリッド環境を実現するHCIまで幅広く対応し、データレイクの実現をサポートします。SDPF(Smart Data Platform)とNetApp製品の統合によるネットワークベースのティアリングは、企業のデータ活用基盤として最適な環境を提供します。

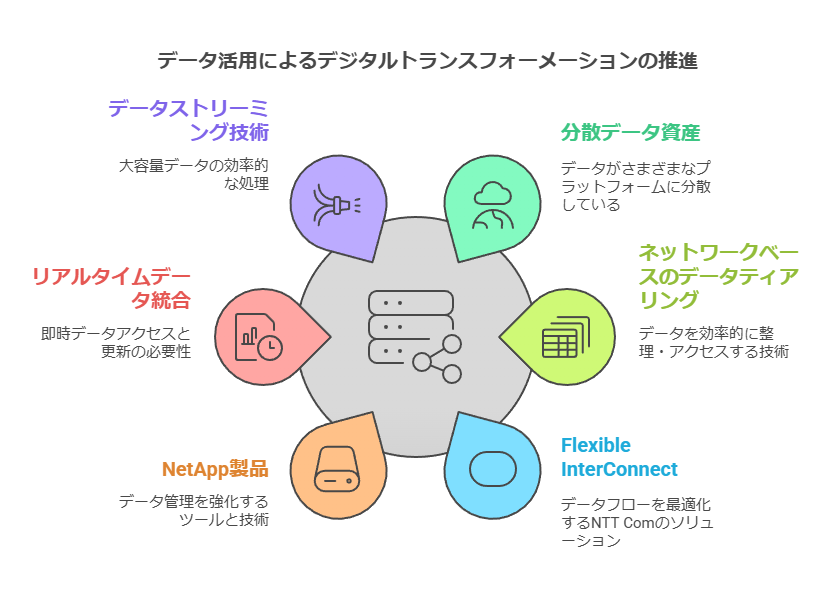

Smart Data Platform (SDPF) と NetApp Data Fabric との共創によるDX推進

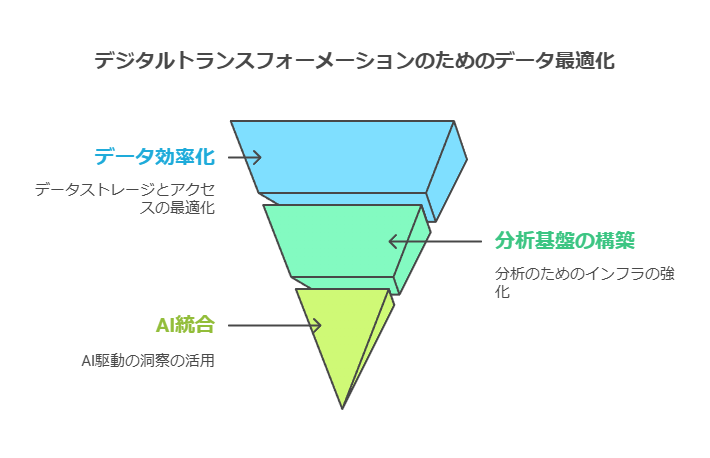

DXの実現には、データの「効率化」「蓄積/分析」「利活用」という段階的な進展が必要です。まず、ファイルサーバーや仮想基盤、データベースを効率化し、その後、DWHやHPC、データレイクなどのデータ分析基盤を整備します。そして最終段階では、AI、機械学習、ディープラーニング、クラウド連携、データパイプラインを活用することで、データからの価値創出を加速します。

NetAppの共創により、このデータ利活用のビジョンが実現し、企業はDX推進に向けたロードマップを確実に進むことができます。

リアルタイムデータ連携が求められる背景と課題

1. リアルタイムデータ連携の必要性が高まる現状

現代のビジネス環境では、意思決定や顧客対応の迅速化が競争優位性を左右する重要な要素となっています。その中で、リアルタイムなデータ連携は次のような分野で不可欠です:

製造業:在庫管理の最適化や異常検知により、ダウンタイムを最小限に。

金融業界:取引モニタリングやリスク管理の即時対応。

IoT:センサーやデバイスからのデータ収集と分析を即時に行い、実行可能なインサイトを提供。

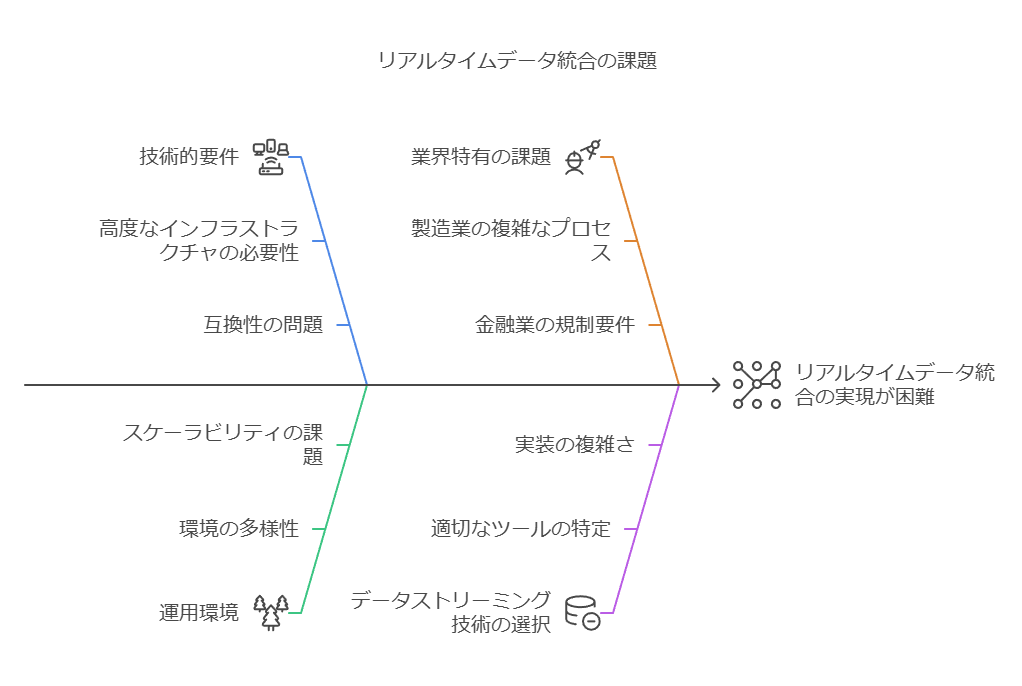

これらの分野では、システム間でのデータ連携が遅延なく行われることが業務効率化やサービス品質向上の鍵となります。しかし、技術的要件や運用環境によって実現の難易度が異なり、適切なデータストリーミング技術を導入することが課題となっています。

2. 適切なデータストリーミング技術を選定する難しさ

データストリーミングはリアルタイム連携を実現するための重要な技術ですが、選定プロセスはしばしば以下の課題に直面します:

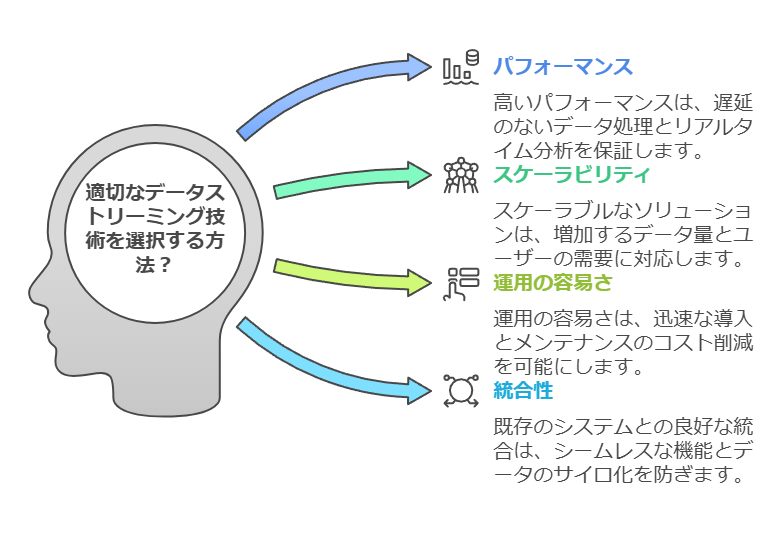

選定基準が多岐にわたる

データストリーミング技術にはさまざまな特徴があり、以下の基準を検討する必要があります:

パフォーマンス:遅延の最小化や高スループットの実現。

スケーラビリティ:データ量の増加に対応できる柔軟性。

運用の容易さ:設定、監視、メンテナンスの負荷を最小化。

統合性:既存のシステムやクラウド環境との適合性。

サポート体制:技術的な支援の充実度やドキュメントの品質。

技術的知識の不足

各サービスやツールの違いを理解し、自社のユースケースに最適なものを選ぶには高度な専門知識が必要です。

リソースの限界

適切な選定を行うためのリサーチや検証に時間とコストがかかるため、選択が遅れることがあります。

3. 実用例で学ぶデータストリーミングサービスの選定基準

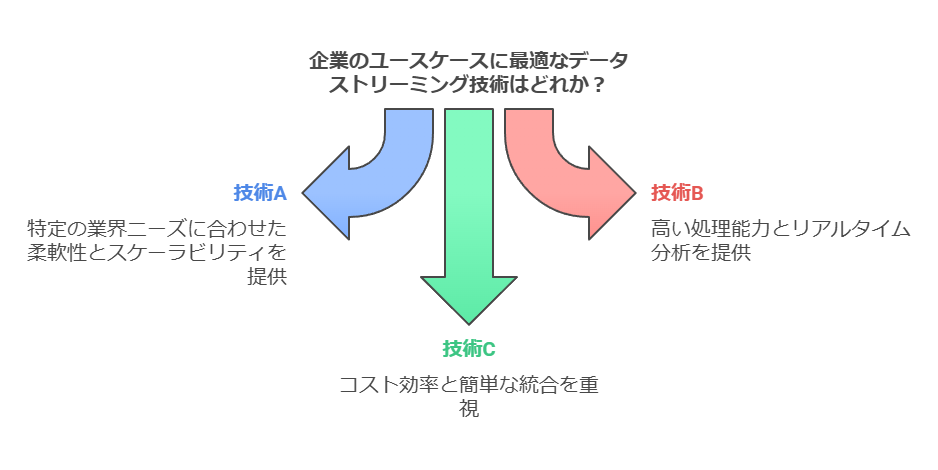

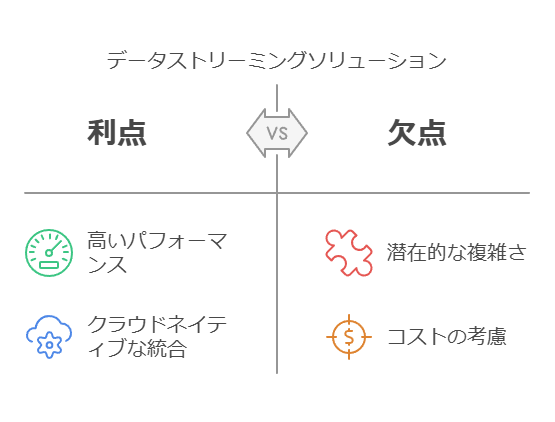

データストリーミングサービスを選定する際には、具体的なユースケースを参考にすることが効果的です。ここでは、ConfluentとGoogle Cloudの事例を通じて、それぞれの特長と利点を解説します:

Confluent:Kafkaを基盤としたエンタープライズ向けソリューション

強み:分散型アーキテクチャにより、高いパフォーマンスとスケーラビリティを提供。

特徴:リアルタイム処理に優れ、大量データを扱う環境での実績が豊富。

ユースケース:製造業や金融業界など、データの即時性が求められる場面で効果的。

Google Cloud:クラウドネイティブな統合プラットフォーム

強み:Google Cloud Platformとの統合が容易で、データ分析基盤を構築しやすい。

特徴:既存のクラウドインフラを活用して簡便にストリーミングソリューションを導入可能。

ユースケース:IoTやEコマースなど、クラウド環境でのリアルタイム処理が必要な分野で有効。

これらの事例をもとに、自社のニーズに合致する技術要件を明確化し、適切なソリューションを選定することが可能です。

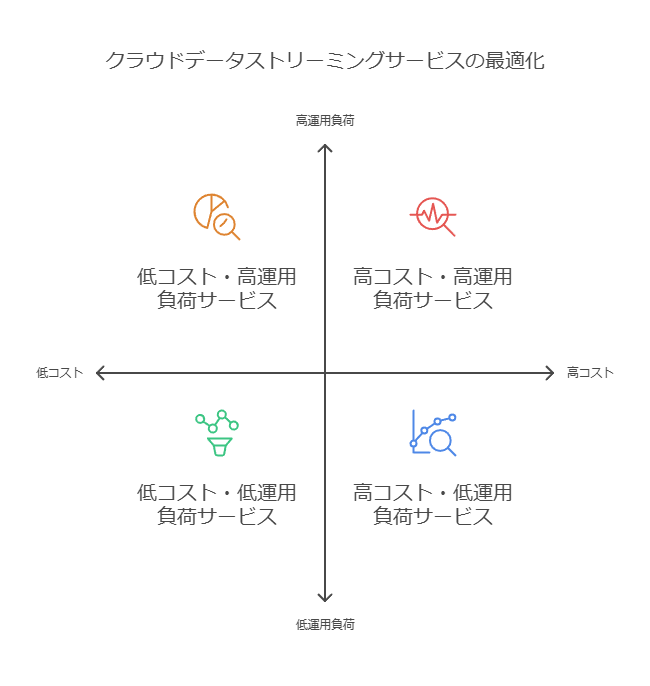

4. クラウド環境でのデータストリーミングの最適化

クラウド環境を活用したデータストリーミングは、初期コストの低減や運用負荷の軽減を実現します。しかし、最適なサービスを選ぶためには、以下のプロセスを検討することが推奨されます:

現状分析:自社システムの要件と課題を特定。

サービス比較:利用可能なストリーミングサービスの特長を比較。

プロトタイピング:小規模な検証環境で導入の効果を評価。

運用計画:長期的な拡張性とコスト効率を考慮した計画を策定。

5. 結論:データストリーミング技術の選定は競争優位性を高める鍵

リアルタイムデータ連携の重要性が高まる中で、適切なデータストリーミング技術の導入は、迅速な意思決定や業務効率化を実現し、企業の競争力を向上させる重要な要素となります。特に、ConfluentやGoogle Cloudといった実績のあるサービスを活用することで、複雑な課題をシンプルに解決する道が開かれます。

データコンサルタントとして、企業のユースケースに合ったソリューション選定をサポートし、最適な運用環境を構築することで、成功へと導くお手伝いができます。

グループウェアからSharePointへの文書データ移行における課題と解決策

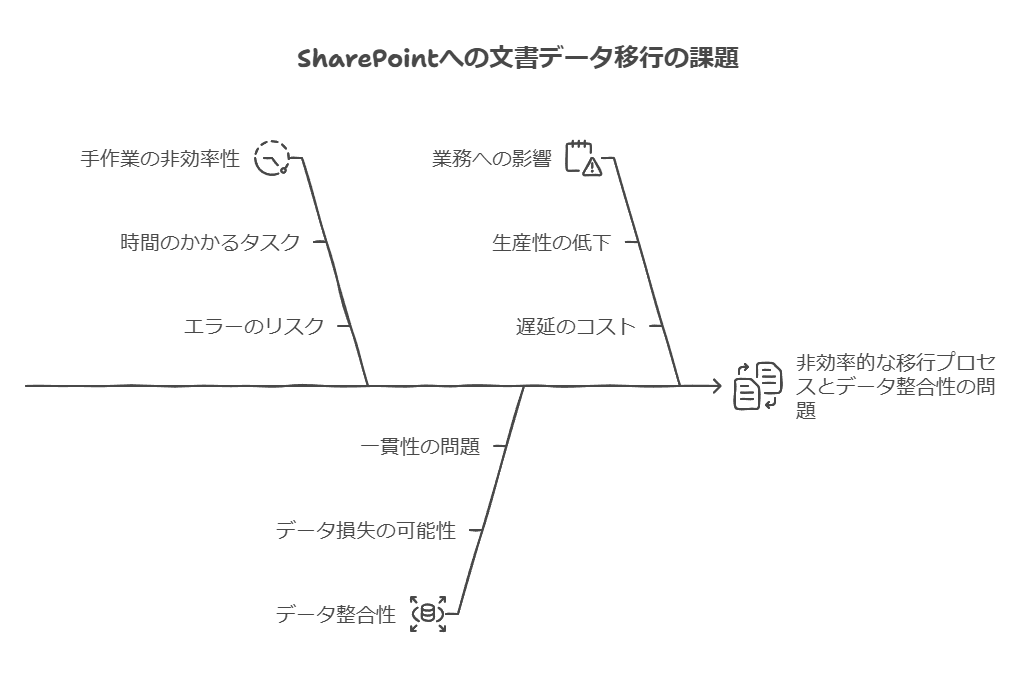

1. 文書データ移行における主要な課題

グループウェアからSharePointへ文書データを移行する際、以下のような課題が移行プロセスを複雑にします:

手作業による非効率性

現実的でない手作業の移行:コピー&ペーストによる対応では、膨大な時間と労力がかかるため非効率です。

データの整合性確保が困難

移行時のデータ整合性問題:SharePointのインポート機能を使用した場合でも、移行前後でデータの不整合が発生することがあります。

データクレンジングの必要性:移行後のデータ整理が必須となるケースが多く、作業負荷を増大させます。

業務への影響

移行中の業務支障リスク:業務で日常的に使用される文書データの移行は、実施タイミングを誤ると業務停止やデータ紛失といったリスクを伴います。

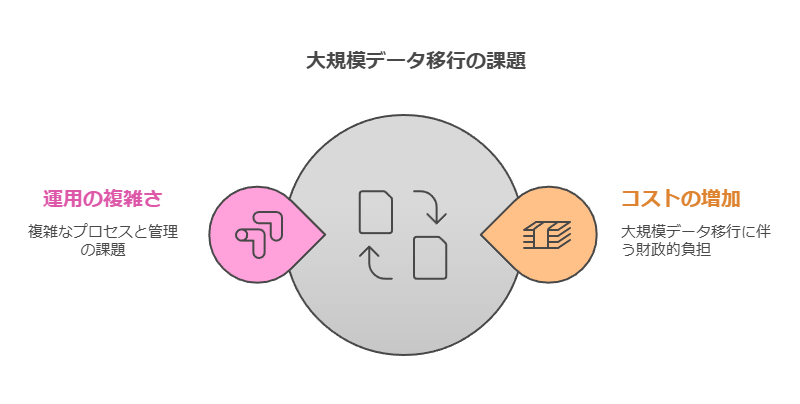

2. 膨大なデータ量がもたらすコストと業務負荷の増大

文書データ移行におけるもう一つの課題は、移行対象データ量が膨大である場合に発生します。

コストの増大

多くの移行ツールはデータ量に応じたライセンス料金体系を採用しており、移行対象が膨大な場合、費用が大幅に増加します。

運用の難しさ

ツールの使用には一定の専門知識が求められる場合があり、利用者側に高いリテラシーが必要となるケースも見受けられます。

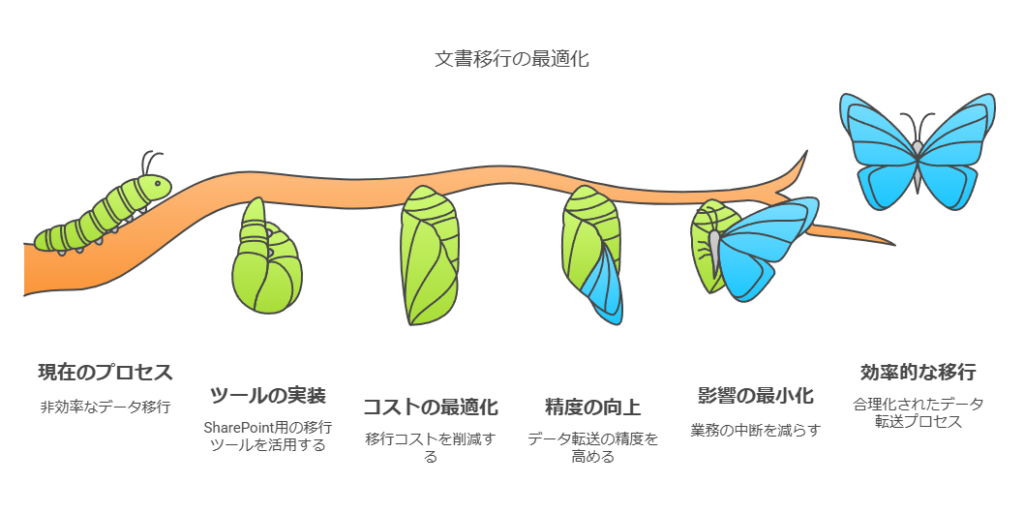

3. 解決策:正確かつ迅速、そして省コストを実現する移行ソリューション

これらの課題を解決するために、特化したソリューションとして**「文書データ移行ツール for SharePoint」**をご提案します。

本ツールの特長

コストの最適化

ライセンスがテナント単位で提供されるため、データ量にかかわらず費用を抑えた移行が可能です。

移行精度の向上

自動化されたプロセスで、移行時のデータ整合性を確保。移行後のクレンジング作業を最小限に抑えます。

業務への影響を最小化

計画的な移行スケジュールとツールの高い信頼性により、業務への支障やデータ紛失リスクを軽減します。

手厚いサポート体制

移行環境の構築支援:移行プロセスをスムーズに開始するための技術サポートを提供します。

トレーニング:ツール操作や移行手順に関する詳細な指導。

不具合時の対応:専任スタッフによる迅速なトラブルシューティング。

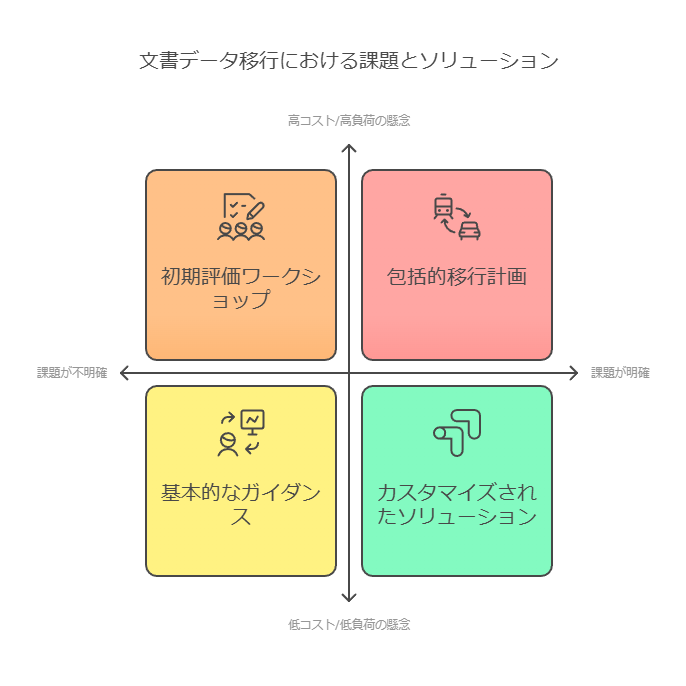

4. 文書データ移行を検討中の方へのおすすめ

本ソリューションは以下のニーズをお持ちの方に最適です:

移行を検討しているが、課題が明確でない方

既に移行を進めているが、コストや運用負荷に不安がある方

膨大なデータ量を扱う企業で、効率的な移行を目指したい方

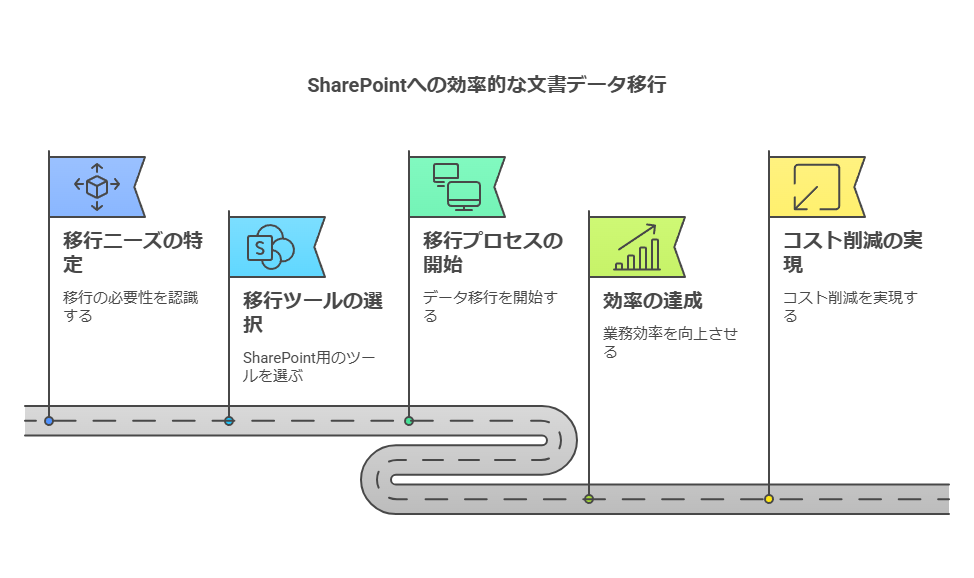

5. 結論:移行成功への第一歩をサポート

グループウェアからSharePointへの文書データ移行は、効率性、正確性、コスト管理が重要です。**「文書データ移行ツール for SharePoint」**を活用することで、これらの課題を解決し、スムーズな移行を実現できます。

移行計画の策定から実行までのすべてのステップで重要です。正確かつ迅速な移行プロセスを実現し、業務効率化とコスト削減を両立させるソリューションを検討してください。

データコンサルタントの視点から、企業がリスク軽減に留まらず、データから価値を創出するための具体的な行動を強調し、成功に向けた戦略的要素に焦点を当てました。

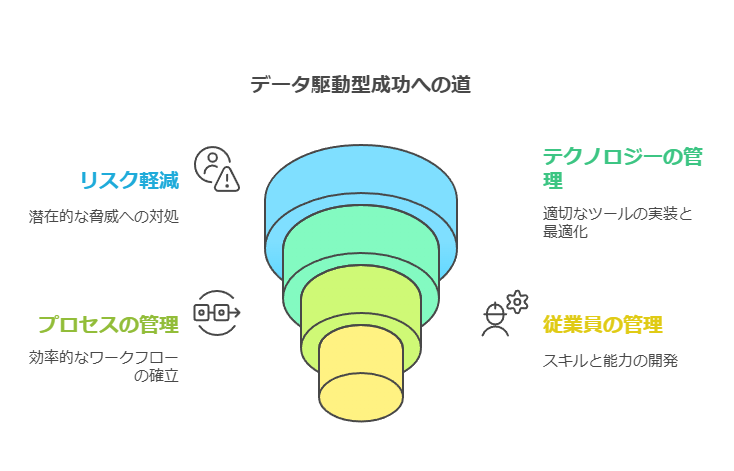

データの価値創出に向けたリーダーシップと戦略的アプローチ

企業がデータを最大限に活用してビジネス価値を創出するためには、単にリスク軽減にとどまらず、データの全体像を把握し、テクノロジー、プロセス、そして従業員を効果的に管理することが求められます。成功している企業は、これらの要素を適切に統合し、データを駆動力として活用するための具体的な行動を取っています。

特に、デジタルトランスフォーメーションの途上にある企業にとって、リーダー企業がどのように異なる行動を取ってきたかを分析することは有益です。リーダーたちは、データポイントの結合、リアルタイムでのデータアクセスと分析、AIを活用したインサイトの自動化など、先進的なデータ戦略を積極的に評価し、推進しています。また、マルチクラウド戦略を強力に推進し、データと分析投資のビジネスインパクトを継続的に測定・報告する文化を持っています。

最も注目すべき点は、これらのリーダーたちがデータ投資の成果を具体的に確認し、収益や採算性、従業員・顧客の満足度、新しいプロダクトやサービスの導入など、主要な業績分野で大幅な成長を達成していることです。これは、データ駆動型の戦略が実際にビジネス成果に結びついていることを示しています。

データ民主化とマルチクラウド管理の課題

この調査では、データからビジネス価値を引き出す際に企業が直面する大きな課題、特にデータの民主化の重要性とそれに伴う課題、マルチクラウド管理、そしてデータ投資のビジネスリターンの測定に焦点を当てています。これらの課題にリーダー企業がどのように対応し、効果的にデータをビジネス価値に転換しているかを詳しく調査することは、他の企業にとって貴重な教訓となります。

成功に導くための戦略

データの活用は戦略的な優先事項であり、リーダー企業はこの認識をもとに継続的な改善を図っています。

一方で、多くの企業が直面している課題は、時間とともに進化した複数のシステムやインスタンス内にデータが分散している点です。このような環境では、データの統合と活用が難しく、企業は立ち往生してしまいます。データを中心とした戦略の重要です。

企業がデータを価値に転換するためには、単にリスクを回避するだけでなく、データ活用の戦略を明確にし、データガバナンスの整備やマルチクラウド環境の管理を推進することが求められます。成功しているリーダー企業は、データ投資の効果を測定し、主要な業績分野での成果を実現しています。他の企業もこれらの戦略を参考に、データ駆動型のビジネスモデルへのシフトを目指すことが重要です。

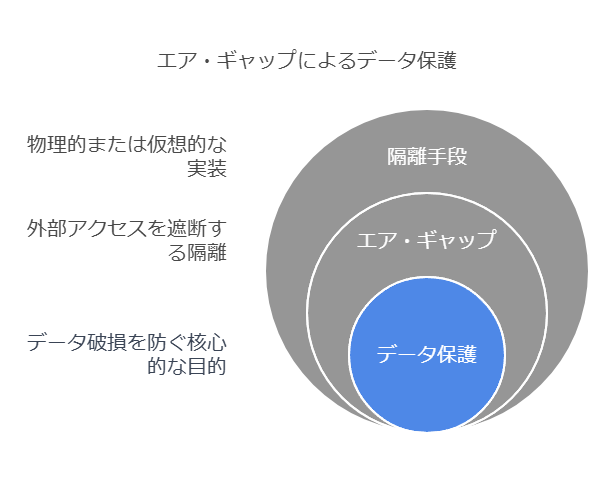

エア・ギャップによる強力なデータ保護

「エア・ギャップ」は、マルウェア感染、システム障害、または人的ミスにより発生するデータ破損を防ぐための重要な概念です。これは、システムやネットワークを物理的または仮想的に隔離することで、外部からのアクセスを遮断します。

具体的には、セカンダリーストレージシステムを定期的にオンラインにして最新のデータをバックアップし、その後再びオフラインにすることで、データ保護を実現します。さらに、スナップショット機能を利用してコピーを作成し、迅速に破損したデータやアプリケーションを回復することが可能です。

しかしながら、コピーされたデータの完全な保護には、いくつかの課題があります。ネットワークやコピーされたデータへのソフトウェアアクセスが存在する場合、真に安全とは言えません。そのため、テープライブラリの「オフライン設計」を活用することで、真の物理的エア・ギャップを提供し、サイバー攻撃に対して最も強力な保護を実現できます。この方法は、WORM(Write Once, Read Many)やその他のセキュリティ機能とも連携し、長期的なデータ保護戦略に組み込むことが可能です。

エア・ギャップやWORMといった技術を含めたテープによるデータ保護のさらなる詳細については、テープソリューションによる最新のソリューション・ブリーフを参照することをお勧めします。

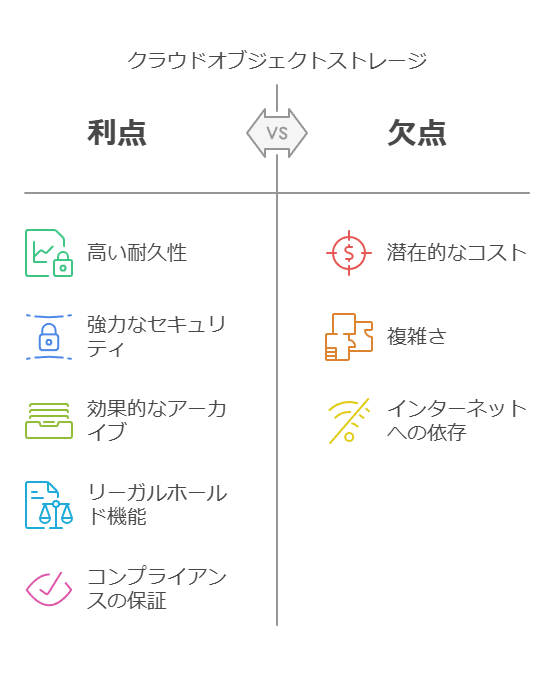

クラウドオブジェクトストレージを活用したデータ保護

クラウドオブジェクトストレージは、データのアーカイブおよび保護において、高い耐久性とセキュリティを提供する手段です。このストレージ方式は、費用対効果が高いだけでなく、データ保存における柔軟性も持ち合わせています。クライアントは、保存ポリシーを設定することで、データの保存期間(デフォルト、最小、最大)を管理し、ビジネスニーズに合わせたデータ保持計画を立てることができます。

さらに、法的な要件に応じてリーガルホールド(法的保持)を設定することも可能で、データが安全に保存されるだけでなく、保存期間終了前に削除されるリスクを排除できます。このような機能により、コンプライアンスを確保しながら、安全で効率的なデータ管理が実現されます。

データコンサルタントの提案

エア・ギャップやクラウドオブジェクトストレージは、異なるデータ保護戦略を補完し合う強力なソリューションです。クライアントのニーズや規模に応じて、両者を適切に組み合わせることで、サイバーリスクに対応した柔軟で強固なデータ保護体制を築くことができます。データのバックアップポリシー、復元戦略、法的要件を総合的に考慮し、最適なソリューションを提案することが重要です。

保護されたスナップショットの効果的な管理

スナップショットを保護する最適な方法として、1つのアプローチは、本番システムからセカンダリー・ストレージ・システムにデータを複製することです。この方法により、本番環境とは異なるシステムでスナップショットを管理でき、リカバリー用のデータとして使用することが可能です。さらに、複製およびスナップショットの管理は、自動化ソフトウェアを使用して効率的に行うことが推奨されます。

重要なのは、非本番環境のストレージをアプリケーション・サーバーに直接接続しないことです。接続は、バックアップ・コピーを受信するための専用ポートに限定し、本番環境との分離を徹底します。この論理的なエアギャップが、マルウェア攻撃や他のリスクからデータを保護する鍵となります。

LDCマルウェア攻撃やリカバリーテストの実施時には、非本番環境に保存されたデータのコピーをリカバリーソースとして利用し、本番システムへの復旧を行います。これにより、非本番システムを利用して、本番データと保護コピー間に安全なエアギャップを設けることが可能です。

物理的なストレージの分離については、設計段階で十分に検討する必要があります。同じデータセンター内であれば、距離が近いほどパフォーマンスの向上とネットワークコストの削減が期待できます。さらに、非本番環境のストレージソリューションを災害対策向けのリモート施設に組み込むことも、強力なリカバリープランの一環として有効です。

メディアを使用したバックアップの強化

機能的なバックアップおよびアーカイブシステムは、データの完全なコピーを管理されたストレージに移行し、変更点を追跡して複数のバックアップバージョンを維持する仕組みです。特に、WORMメディア(書き換え不可メディア)は、リカバリーコピーの保護に非常に有効です。WORM対応のテープカートリッジを使用すれば、上書きや破壊からデータを保護でき、マルウェアによるバックアップ破壊のリスクも低減されます。

ただし、WORMメディアへのバックアップは、スナップショットと比較して、データの移動および復元に時間がかかるため、ビジネスのニーズに応じた設計調整が必要です。スナップショットはスペース効率に優れ、迅速なリカバリーが可能であり、一方でWORMメディアによるフルバックアップは長期保存や高いセキュリティを提供します。

そのため、最適なアプローチは、スナップショットベースのリカバリーとオフラインメディアへのバックアップを組み合わせることです。これにより、迅速な復旧と強固なデータ保護を両立させることが可能となります。

このように、スナップショットとバックアップの運用を最適化し、自動化や非本番環境の活用を取り入れることで、組織はデータ保護をより強固にし、サイバー攻撃からの迅速な復旧を可能にします。

リスク軽減と分析品質を実現するデータ管理に基づいたAIソリューション

AIの導入によってリスクを低減し、期待される分析成果を引き出すためには、信頼性の高いデータ、モデル、プロセスの基盤が不可欠です。本項では、AI活用において特に重視すべきデータ、モデル、プロセスの各要素について、効果的な管理のポイントを整理します。

1. データの信頼性強化

正確で高品質なデータがAIの性能を左右: AIの信頼性と有効性を引き出すためには、正確で信頼性の高いデータの利用が前提となります。これを確保するために、関係者がアクセス可能なセルフサービス型のデータ接続を構築し、データ利活用の利便性と信頼性を向上させます。

複数ソースからのデータ統合: AIモデルではオンプレミスやパブリック/プライベートクラウドなど、異なる環境にある内部・外部のデータソースを統合する必要があります。特に、構造化・非構造化データをシームレスに統合することで、モデルの汎用性と精度を高め、データ駆動の意思決定を促進します。

トレーニングデータの透明性: データの公平性や来歴の追跡、データプライバシーの管理を徹底することで、AIの倫理的・法的リスクも軽減します。セルフサービス分析を提供する際には、データアクセスにおけるプライバシーやセキュリティの確保が重要です。

2. モデルの信頼性強化 – MLOpsの活用

透明性と説明責任の確保: モデル構築から運用までの全過程で、透明性と説明責任を徹底するために、MLOpsを活用します。MLOpsによって、データサイエンスのワークフローを自動化し、モデルの構築・導入・監視における効率性が向上し、リスクの軽減と正確なデータ分析を可能にします。

バイアスやリスクの軽減: MLOpsでは、AIモデルの開発においてバイアスを抑え、ドリフト検出機能を組み込むことで、データやモデルの変動に対する早期対応を実現します。また、説明可能性や公平性の向上も可能となり、ステークホルダーの信頼を獲得しやすくなります。

独自の公平性・頑健性の要素の導入: MLOpsを導入する際、AIモデルには公平性、説明可能性、頑健性を盛り込む機能を設計段階から組み込みます。これにより、AIの持続的な信頼性を確保し、企業全体のAIガバナンス基準に則った活用が進みます。

3. プロセスへの信頼性強化 – AIガバナンスの導入

ライフサイクル全体の自動化による一貫性向上: モデルの構築、配置、管理、監視に至るまでのプロセスを自動化することで、一貫性と効率性を確保します。AIガバナンスの導入により、再現可能なプロセスを確立し、トレーサビリティを確保して、迅速かつ安定したAIの運用を支援します。

本番環境への移行の迅速化: AIモデルの本番環境への移行時間を短縮し、モデルの透明性を高めることで、大規模なAI構築がスムーズに進むようにします。これにより、データの活用価値が最大化され、ビジネスの意思決定を強力にサポートします。

IDCの予測: IDCの報告によれば、2025年までに60%の企業がMLOpsやModelOpsを通じてMLワークフローを運用し、さらにAIOpsを用いたITインフラストラクチャの自動化も進む見込みです。この流れに沿い、AIガバナンスを導入することで競争優位性が確立され、継続的な成長が期待されます。

コンサルタントとしての推奨アプローチ

セルフサービスデータ接続やデータ統合プロセスを通じて、必要なデータへの信頼性を強化し、モデル構築を支援する。

MLOps導入によるモデルの公平性・頑健性の確保で、AI活用のリスクを低減。

AIガバナンスの自動化によって、大規模なAI構築・導入を効率的に推進。

これらのアプローチによって、データの信頼性とガバナンスを強化し、リスクを最小限に抑えつつ、データ駆動の意思決定を支援する堅牢なAI基盤を構築します。

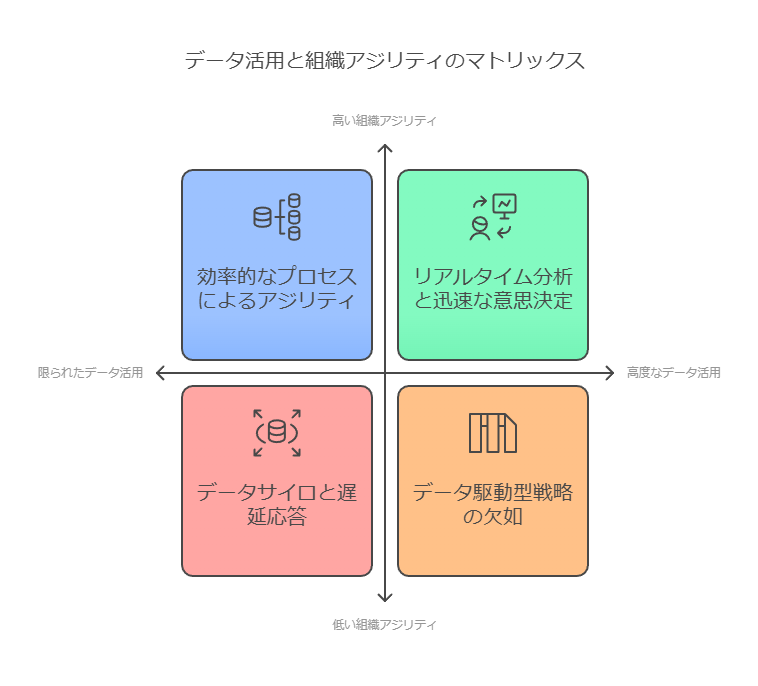

データ、アダプタビリティ、アジリティ

データの価値は、単にその存在だけでなく、ミッション成果を達成するために活用されるデータ分析ツールやプロセスによって創出されます。 今日の急速な変化、不確実性、複雑性に直面するデジタル時代において、組織はデータを柔軟に活用し、環境の変化に迅速かつ効率的に適応するアジリティが求められています。特に、アジリティは、急速な変化やディスラプション(破壊的変革)をチャンスに変える重要な要素です。公共機関やエンタープライズは、IT機能の迅速な提供を通じてイノベーションを促進し、市場のペースに追随する術を学んできました。こうしたIT機能は、繰り返しの改善を通じてさらなる進化を遂げています。

しかし、アジリティを実現するためには、プロセスだけでなくデータそのものもアジャイルである必要があります。 データは、想定外の事態や変化する状況に対応するため、いつでも容易にアクセスできる状態でなければなりません。さらに、データは有意義かつ価値あるものであり、教職員やスタッフにはそのデータを効果的に活用するためのツールとスキルが必要です。

この数年間で、アジャイルソフトウェア開発、DevOps、リーンソフトウェア開発といったIT提供プロセスにアジリティを組み込む手法が広く採用されています。クラウドの活用により、ソフトウェアとハードウェアの両面でIT機能の提供スピードが飛躍的に向上しました。さらに、チームベースの組織構造により、変化するニーズに迅速に対応するためのリソースの迅速なモビライズが可能となり、プロセス全体がよりアジャイルになっています。

ここで鍵となるのは、データを既知の用途だけでなく、未知の用途にも柔軟に利用できるアジリティです。 これこそが、単にアジャイルフレームワークを導入しただけの組織との差別化を生み出し、エンタープライズアジリティを実現する重要な要素です。ビジネスやミッションにアジリティを持たせるためには、まずデータにアジリティをもたらすことが不可欠です。データを正しく理解し、意思決定に活用することで、より優れた判断ができる「データインフォームド」の教育機関や企業だけが、真のアジャイルプロセスとデータアジリティを手に入れることができるのです。

これらにより、データコンサルタントとしての視点が強調され、データの価値を引き出すための戦略的なアプローチが具体的に示されています。特に、データアジリティが企業や教育機関の成長と差別化に不可欠であることが、実践的な内容として強調されています。

データの価値を明確化する

多くの企業において、データは無形資産として十分に評価されておらず、財務諸表にも反映されていません。しかし、データの活用が進むことで、新たな収益機会の創出や顧客体験の改善、さらには業務プロセスの効率化といった明確なビジネス成果が得られるようになってきています。

企業にとってデータの可能性は「収益」「顧客体験」「業務効率」の3つの具体的な価値として捉えるべきです。これにより、データの重要性がより明確になり、実際のビジネス成果を結びつけやすくなります。

2. データの活用率に関する問題提起

データの価値を最大限に引き出すためには、単にデータを所有するだけでなく、積極的に活用する必要があります。ある調査によれば、企業が保有するデータのうち、実際にビジネスに活用されているのはわずか32%に過ぎません。つまり、多くの企業が活用可能な資産を十分に生かし切れていない状況です。

データ活用率が低いことを数値で示し、実際の問題としてクライアントに認識させます。データの「保有」と「活用」の違いを強調し、次の段階に進むための重要なステップを示します。

3. データの価値測定の必要性

データから最大の価値を引き出すためには、まずデータの価値を数値化し、それをビジネス指標として測定する仕組みが必要です。このプロセスを整えることで、企業はデータ戦略を効率的に進め、成果をモニタリングしやすくなります。

データの価値を定量化する必要性を強調します。特に、データを戦略的に活用するためのKPIを設定し、進捗を管理するフレームワークの重要性を指摘しています。

4. データ活用の現状と競争優位性

データを積極的に活用し、競争優位性を確保している企業は、業界内でリーダーシップを発揮し、数多くのビジネスチャンスを手にしています。しかし、同業他社と比較して自社がデータ活用においてリーダーシップを握っていると考える企業は、全体のわずか11%に過ぎないことも事実です。これにより、データ活用を戦略的に進めることで、競合他社との差別化が大きな可能性を秘めていると言えます。

データ活用が競争優位性をもたらす事実を示し、データ活用が不十分な企業に対して行動の必要性を感じさせるように促しています。具体的な数字を引用することで、より説得力を持たせています。

5. データストレージ戦略の重要性

多くの企業は、常に最新のデータを取り込みながら、価値の低くなったデータを低コストのストレージへ移行するという、効率的なデータストレージ戦略を必要としています。データを有効に活用するためには、データレイクがデータスワンプ(無価値なデータの溜まり場)と化さないよう、管理プロセスの最適化が不可欠です。

データ管理の戦略的重要性を説明し、データストレージの最適化の必要性を強調しています。データの質を維持しつつ、コストを削減するための取り組みを具体的に提示しています。

6. データの価値と不確定要素の理解

企業がデータの価値を最大限に引き出すためには、業界やデータの用途、そして収益化の可能性など、多くの不確定要素を考慮する必要があります。データの価値は一律ではなく、これらの要素を見極めながら、ビジネス目標に適したデータ戦略を設計することが成功の鍵です。

データ活用における業界特有の要素や不確定要素を理解し、クライアントに柔軟な戦略を取るようアドバイスしています。特に、カスタマイズされたデータ戦略が必要であることを示唆しています。

データは、企業にとって財務的に測定されることは少ないが、適切に活用すれば大きなビジネス価値をもたらします。データ活用の初期段階としては、データの価値を定量化し、戦略的に活用するプロセスを確立することが重要です。