目次

データとベンチマークに基づくITSM高度化

外部のベストプラクティスやServiceNowユーザーコミュニティで共有される知見は、自社のITサービスマネジメント(ITSM)の成熟度を測るための貴重なベンチマークデータとして活用すべきです。定性的な情報に留めず、自社のKPIと比較分析することで、客観的な改善機会を特定します。

インシデント管理におけるデータ活用

インシデント管理プロセスの各段階で取得されるデータを分析し、継続的な改善サイクルを構築します。

インシデントデータの分類と傾向分析: インシデントカテゴリを構造化し、データを集計・分析することで、発生頻度の高い事象やビジネスインパクトの大きいカテゴリを特定します。これは、自動ルーティングの精度向上だけでなく、根本原因分析(RCA)と恒久対策の優先順位付けに不可欠なインプットとなります。

チャネルシフトの効果測定: メールなどの従来型チャネルから、AIを活用したセルフサービスポータルへの移行を推進します。その際、チャネルごとの問い合わせ件数、自己解決率、平均修復時間(MTTR)を継続的に計測し、運用工数の削減効果と顧客満足度の向上を定量的に評価します。

ナレッジのROI評価: ナレッジベースの参照回数、解決貢献度、最終更新日といったデータを分析し、ナレッジの利用率とインシデント削減効果の相関を可視化します。陳腐化したナレッジを特定し、更新プロセスを回すことで、ナレッジ資産の投資対効果(ROI)を最大化します。

バックログのボトルネック分析: ビジュアルタスクボードやダッシュボードを用いて、インシデントバックログの滞留時間やステータスを時系列で分析します。これにより、特定のチームやプロセスに潜むボトルネックをデータに基づいて特定し、リソースの再配分やプロセス改善を客観的に判断できます。

データガバナンスの中核としての構成管理データベース(CMDB)

CMDBは単なるIT資産台帳ではなく、データドリブンな意思決定を支える「単一の信頼できる情報源(Single Source of Truth)」として位置づける必要があります。

データガバナンス体制の構築: CMDBの設計と運用を主導するリーダーシップチームを設置し、データのオーナーシップと責任を明確化します。サービス自動化、ビジネスインパクト分析、資産管理といった利用目的に応じて、データモデルと収集・維持の品質基準を定義します。

データ品質のKPI管理: CMDB内のデータの品質を、「正確性」「完全性」「適時性」といったKPIで継続的に測定します。サービスの自動検出やサービスマッピングツールによるデータ収集と、人的な監査・レビューを組み合わせ、設定したKPIを維持・向上させるためのプロセスを構築します。

リスクとコンプライアンスの定量化: 各構成アイテム(CI)をビジネサービスと関連付けることで、特定のコンポーネント障害が事業に与える影響(潜在的損失額など)を定量的に評価できます。これにより、コンプライアンスやリスク管理の優先順位をデータに基づいて決定することが可能になります。

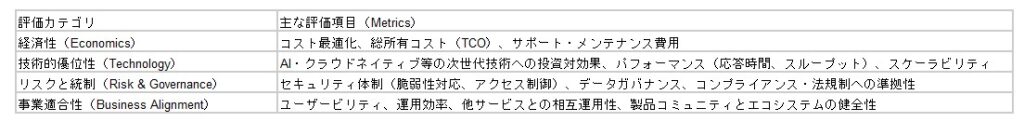

ITインフラ戦略の定量的評価フレームワーク

ITインフラ戦略を策定する際には、以下の評価軸に基づいた多角的な分析とスコアリングが不可欠です。

データドリブンなサービスポートフォリオ管理

提供するITケイパビリティは、単なる機能やインフラの集合体ではなく、提供価値を定量的に評価できる「サービス」として定義・管理する必要があります。各サービスに対しては、明確なサービスレベル目標(SLO)やサービスレベル合意(SLA)を設定し、そのパフォーマンスを継続的に測定します。

サービス定義とKPI設定のフレームワーク

各サービスの定義に際しては、以下のデータポイントを明確化します。

責任と役割(RACI)の定義: スポンサー、サービスマネージャー、運用チームといった各役割の責任範囲を明確にし、それぞれのパフォーマンスを評価するためのKPI(重要業績評価指標)を設定します。

サービスカタログのデータ項目: サービスの可用性、パフォーマンス目標、コスト、利用資格、要求プロセスといった主要メトリクスを定義し、サービスカタログに明記します。これは、ユーザーへの透明性確保と同時に、サービス評価の基準となります。

運用効率の測定: サービスの提供とサポートに関するプロセスを標準化・文書化し、自動化率、手動介入件数、解決時間といった運用効率を測るKPIを設定・モニタリングします。

データに基づく継続的改善: 定期的なサービスレビューを実施し、SLA/SLOの達成状況、コスト、ユーザー満足度といった定量的データに基づき、改善アクションの優先順位を決定します。また、変更管理プロセスにおいては、変更のリードタイムや変更失敗率(Change Failure Rate)を計測し、プロセスの有効性を客観的に評価します。

データプラットフォームによるITインフラの分析と洞察

手動タスクに依存した運用モデルはスケーラビリティに乏しく、ヒューマンエラーのリスクを内包するため、データに基づく自動化と可視化が不可欠です。IT運用基盤は、単なる監視ツールではなく、データから実用的な洞察(Actionable Insight)を導き出すための分析プラットフォームとして機能すべきです。

データ収集と依存関係のマッピング: まず、自動ディスカバリー機能を用いて、オンプレミスとクラウドにまたがるITインフラコンポーネントの構成情報(CI)を網羅的に収集します。次に、サービスマッピング機能により、これらのCIとビジネスサービス間の依存関係をモデル化し、影響範囲分析や相関分析の基礎となるデータモデルを構築します。

CMDBを分析の中核に: 単一の信頼できる情報源(Single Source of Truth)として機能する構成管理データベース(CMDB)により、特定のインフラ障害がどのビジネスサービスに、どの程度のインパクトを与えるか(例:影響ユーザー数、潜在的損失額)を即座に特定できます。これにより、トラブルシューティングの焦点を迅速に定め、対応の優先順位をデータに基づいて決定します。

予測的・予防的な問題解決へのシフト: レポート、BI分析、生成AIを活用して、蓄積されたインシデントと問題管理データを分析します。これにより、インシデントのクラスタリングによる傾向の把握や、根本原因分析(RCA)の高度化が可能になります。最終的には、障害の予兆を検知し、同様のインシデントの再発を未然に防ぐ、プロアクティブな運用モデルへと変革します。

ペルソナ別の意思決定支援ダッシュボード: 経営幹部、サービスオーナー、現場のエンジニアといった各ステークホルダー(ペルソナ)が、それぞれの意思決定に必要なKPIを明確に把握できるカスタムレポートとダッシュボードを構築します。単なる情報の羅列ではなく、次にとるべきアクションを示唆する洞察を提供することが目的です。

IT資産の財務分析: インベントリ管理の範囲を、物理的・論理的な存在情報だけでなく、IT資産の取得コスト、減価償却、運用コストといった財務ライフサイクルデータにまで拡張します。これにより、各サービスの総所有コスト(TCO)や投資対効果(ROI)を正確に算出し、IT投資の最適化に貢献します。

データドリブンITオペレーションの実現:生成AIによる生産性・投資対効果の定量的評価

ITインフラ部門は、事業継続性を支える基盤であると同時に、イノベーション創出の源泉でなければなりません。しかし、多くのITチームが、繰り返される定常業務や障害対応といった「守り」のタスクにリソースを割かれ、戦略的な「攻め」の活動へシフトできていないのが実情です。この構造的な課題を解決するためには、オペレーションの現状をデータで可視化し、テクノロジーによっていかに生産性を向上させるかを定量的に示す必要があります。

本稿では、生成AI(GenAI)を、単なる効率化ツールとしてではなく、**「ITオペレーションから得られる膨大なデータを分析し、価値へと変換するエンジン」**として位置づけ、その導入効果をデータに基づき解説します。

現状分析:ITオペレーションのボトルネックをデータで特定する

生成AIの導入効果を最大化する最初のステップは、現状のオペレーションを客観的なデータで把握することです。

チケットデータの分析: サービスデスクに蓄積されたインシデント、リクエスト、問い合わせのチケットデータを分析します。カテゴリごとの発生頻度、解決までの平均時間(MTTR)、担当者ごとの処理件数を可視化し、最も時間と工数を要している業務領域(ボトルネック)を特定します。

ナレッジベースの活用度分析: 既存のナレッジ記事の閲覧数、評価、解決率を分析し、「自己解決(ゼロタッチIT)率」の現状値を算出します。これにより、ナレッジの質の課題と、生成AIによる改善ポテンシャルを定量化します。

開発・自動化プロセスの計測: 新規の自動化スクリプトやカスタムアプリケーションの開発に要するリードタイムと工数を計測します。これにより、生成AIのテキストtoコード機能導入後の開発速度の向上率を算出するためのベースラインを設定します。

生成AIによるITオペレーションのデータ活用変革

現状分析で得られたデータに基づき、生成AIがもたらす具体的な価値を定量的に示します。

IT生産性の飛躍的向上(ROIの最大化):

生成AIは、チケットデータ(インシデント内容、過去の類似対応履歴)を瞬時に分析し、最適な解決策を提示します。これにより、チケット1件あたりの平均対応時間を〇%短縮し、創出された時間をより高度な分析や企画業務へ再配分することが可能になります。これは、人件費換算で年間〇〇円のコスト削減効果に相当します。

リスクの定量的低減とガバナンス強化:

過去のインシデントデータや構成情報(CMDB)を学習させることで、障害の予兆を検知するモデルを構築します。Predictive Intelligence(予測インテリジェンス)は、構成変更がもたらす潜在的なリスクをスコア化し、サイバー攻撃のパターンを検知します。これにより、重大インシデントの発生率を〇%低減させ、データに基づいたプロアクティブなリスク管理とガバナンスを実現します。

データに基づいた従業員エクスペリエンスの最適化:

全従業員からの問い合わせログやフィードバックデータを分析し、潜在的なニーズや不満点を可視化します。このインサイトを基に、セルフサービスポータルのUI/UX改善や、FAQの最適化を継続的に実施。従業員満足度スコアや自己解決率の向上といったKPIの改善に直結させます。

アジャイルな価値創出サイクルの確立:

顧客からのフィードバックや製品利用ログといった非構造化データを要約・分析し、開発優先度を客観的なデータに基づいて決定します。さらに、テキストtoコード機能を活用することで、PoC(概念実証)開発のリードタイムを従来の1/Nに短縮し、市場の要求に対して迅速に価値を提供するアジャイルなサイクルを構築します。

結論として、生成AIの戦略的導入は、ITインフラチームをコストセンターからバリュードライバーへと変革させるための鍵です。オペレーションをデータで計測し、AIによって改善効果を定量化し続けることこそが、継続的なイノベーション創出の基盤となります。

データが示すITインフラの次なる一手:AI導入による生産性向上の定量分析

現代のビジネス環境において、ITインフラチームは単なる「コストセンター」から、ビジネス価値を創出する「プロフィットセンター」への変革を迫られています。しかし、多くの組織では、ITチームがインシデント対応や定型的な情報収集といった運用タスクに追われ、戦略的な業務にリソースを割けないという構造的な課題を抱えています。

本稿では、データコンサルタントの視点から、この課題をいかに定量的に捉え、AIと自動化プラットフォームの導入がITインフラチームの生産性、ひいては事業全体の価値向上にどう貢献するのかを、具体的なユースケースと想定されるKPI(重要業績評価指標)を交えて解説します。

現状の課題:データで見るIT運用のボトルネック

AI導入のROI(投資対効果)を議論する前に、まず現状のIT運用が抱える非効率性をデータで可視化することが不可欠です。例えば、以下のような指標は多くの組織で改善の余地を示しています。

平均解決時間(MTTR – Mean Time to Resolution): インシデント発生から解決までの平均時間は、ビジネスインパクトに直結します。この時間が長引くほど、機会損失や顧客満足度の低下といった損失が増大します。

オペレーターのアラート対応時間: 複雑で大量のアラート(アラートストーム)の中から、対応すべき重要なインシデントを特定するまでに費やされる時間は、貴重な人的リソースの浪費に他なりません。

開発者の非開発業務時間の割合: アプリケーション開発者がコード記述やリファクタリングといった本質的な業務ではなく、ドキュメント作成や環境構築、バグ修正の調査に費やす時間の割合は、開発生産性を測る上で重要な指標です。

これらの指標をデータとして捉えることで、AI導入が解決すべき具体的なターゲットが明確になります。

AIがもたらす生産性向上の定量インパクト

ServiceNowの「Now Platform」と生成AI機能のインテリジェントなプラットフォームは、前述の課題に対し、データに基づいた具体的な解決策を提供します。その効果は、各業務領域において以下のようなKPIの改善として測定可能です。

1. ITサービス管理(ITSM):インシデント解決の迅速化

生成AIは、過去のインシデントデータやナレッジベースを瞬時に分析し、インシデントの要約や類似チケットの提示、解決策の提案を行います。これにより、エージェントは情報収集の時間を大幅に削減できます。

目標KPI:

平均解決時間(MTTR)の約30%削減

初回コール解決率(FCR)の約15%向上

エージェントのチケット処理能力の約25%向上

2. IT運用管理(AIOps):プロアクティブな問題検知と対応

膨大な監視アラートをAIが分析・相関付けを行い、ノイズを除去して根本原因を特定します。これにより、オペレーターは深刻なインシデントに集中でき、プロアクティブ(予兆検知型)な対応が可能になります。

目標KPI:

重要インシデントの検知時間の約50%短縮

オペレーターにエスカレーションされるアラート量の約70%削減

システムダウンタイムの削減による可用性の向上

3. 戦略的ポートフォリオ管理(SPM):データ駆動型の製品開発

顧客からのフィードバックや市場データといった非構造化データをAIが要約・分析し、開発優先度の高い機能を特定します。これにより、勘や経験に頼らない、データに基づいた製品戦略の立案が可能になります。

目標KPI:

製品フィードバックの分析時間を約80%削減

機能要求から開発着手までのリードタイム短縮

データに基づいた機能実装による顧客満足度(CSAT)の約10%向上

4. アプリケーション開発:開発ライフサイクルの高速化

生成AIによるコード生成、テストコードの自動作成、コードレビュー支援、ドキュメント作成の自動化は、開発プロセス全体を加速させます。これにより、開発者はより創造的で付加価値の高い業務に集中できます。

目標KPI:

コード記述に要する時間の約40%削減

新規開発者のオンボーディング期間の短縮

市場投入までの時間(Time to Market)の約20%短縮

結論:AIはコスト削減ツールではなく、事業価値向上のための戦略的投資

AIをITインフラに導入する目的は、単なる業務効率化やコスト削減に留まりません。その本質は、これまで計測が難しかった業務プロセスをデータ化し、継続的な改善サイクルを回すことで、ITチームが創出するビジネス価値を最大化することにあります。

導入の意思決定においては、汎用的なLLM(大規模言語モデル)やドメイン特化型LLMといった技術仕様の比較だけでなく、「自社のどのKPIを、どの程度改善したいのか」という明確な目標を設定し、その達成度を測定できるプラットフォームを選択するという、データに基づいたアプローチが不可欠です。AIという強力なエンジンを搭載することで、ITインフラチームは組織全体の生産性と持続可能性を向上させる中核的な役割を担うことができるようになります。

データ分析が示すIT運用の限界と、事業成長を加速させるプラットフォーム戦略

1. 運用データの分析が示す、ITインフラの構造的課題

企業のIT環境は、オンプレミスとクラウドが混在するハイブリッド構成が一般化し、その管理対象ノード数と依存関係の複雑性は指数関数的に増加しています。この現実に対し、情報システム部門の人的リソースは有限であり、担当者一人当たりの運用負荷をデータとして可視化すると、多くの企業で限界値に達していることが明らかになります。

特に、MTTR(平均復旧時間)やインシデント対応工数といったKPIの悪化は、事業機会の損失に直結する重要な経営指標です。既存の監視ツールが発する大量のアラート(ノイズ)と、本当に対応すべき根本原因(シグナル)の比率を分析すれば、従来の人力による運用モデルが、すでに機能不全に陥っていることは明白です。この属人的な運用プロセスは、再現性の欠如や対応品質のばらつきといったリスクを内包しており、データに基づいた抜本的な改革が求められています。

2. AIOpsによる、データ駆動型IT運用への変革

これらの課題に対し、AIOpsはデータドリブンな解決策を提示します。AIOpsの本質は、サイロ化された各システムから収集されるログ、メトリクス、トレースといった膨大な運用データを統合的に分析し、障害の予兆検知、根本原因の特定、そして対応の自動化を実現するアプローチです。

HPE OpsRamp Softwareは、まさにこのデータ分析基盤として機能します。AIによる相関分析が、人間では不可能な速度と精度でアラートの因果関係を解明し、対応すべきインシデントを自動的に絞り込みます。例えば、「MTTRを従来の20時間から1時間へ短縮する」という目標は、サービス停止による機会損失額を定量的に算出し、セキュリティ投資のROI(投資対効果)を経営層に提示するための具体的なKGI(重要目標達成指標)となり得ます。AIOpsは、感覚的な運用から脱却し、データに基づいた意思決定を可能にするための戦略的投資です。

3. 開発生産性データが明らかにする、ビジネス成長のボトルネック

市場における企業の競争力は、Four Keys(デプロイの頻度、変更のリードタイム、変更障害率、サービス復元時間)といった具体的なメトリクスによって定量的に測定できます。これらの数値の改善が、ビジネスの仮説検証サイクルを高速化し、市場への適応能力を直接的に左右します。

しかし、多くの組織において、これらのメトリクス改善を阻害している真のボトルネックは、アプリケーション開発そのものではなく、それを支えるインフラ提供のプロセスに存在します。開発者がインフラ環境を申請してから実際に利用可能になるまでのリードタイムを計測すれば、開発者の総労働時間のうち、価値を生まない「待ち時間」がどれほどの割合を占めているかが可視化されます。この「開発者体験(Developer Experience)」の低下は、生産性の低下に留まらず、優秀なエンジニアのエンゲージメント低下や離職にも繋がる、定量化可能な経営リスクです。

4. データ基盤としてのプラットフォームが実現する、開発者体験とガバナンスの両立

このボトルネックを解消し、開発生産性を最大化するアプローチが、プラットフォームエンジニアリングです。これは、開発者が必要なインフラリソースを、標準化・自動化されたセルフサービス型の「プラットフォーム」を通じてオンデマンドで利用できる環境を構築する取り組みです。

CloudHarborのようなソリューションは、このプラットフォームを迅速に提供します。その価値は、単なるインフラ提供の高速化に留まりません。セキュリティポリシーやガバナンス統制をコード化し、プラットフォームに「ガードレール」として組み込むことで、開発の自由度と企業として必須の統制をデータに基づいて両立させることが可能です。

さらに、このプラットフォームは、Four Keysをはじめとする開発生産性データを継続的に収集・可視化するデータ基盤としても機能します。これにより、開発プロセスにおける新たなボトルネックを客観的なデータで特定し、継続的な改善サイクルを回すことが可能になります。ビジネスの要求に迅速に応え続ける体制は、このようなデータ駆動型のプラットフォームの上にこそ構築されるのです。

データに基づかない意思決定が招く、IT部門の構造的課題

IT部門が直面する課題の本質は、経験や勘といった属人的な判断に依存し、客観的なデータに基づいた意思決定がなされていない点にあります。

例えば、システム運用におけるインシデント対応時間のばらつき、あるいは開発プロセスにおけるリードタイムの遅延は、感覚的に語られるべきではありません。これらは、MTTR(平均復旧時間)やFour Keys(デプロイ頻度、変更のリードタイムなど)といった定量的なKPIとして計測・分析されて初めて、改善に向けた具体的なアクションに繋がります。

市場に存在する多数のソリューションやツールも、データによる現状分析なくしては、その投資対効果を正確に評価することは不可能です。「どのツールが自社に適しているか」という問いは、「自社のどのKPIを、どれだけ改善する必要があるのか」というデータに基づいた問いに置き換える必要があります。

IT運用データの分析が導く、プロセスの最適化と自動化

サービス品質のばらつきや業務の非効率性は、運用データの中にその根本原因が隠されています。担当者ごとのチケット処理時間、インシデントの発生パターン、初回解決率(FCR)といったデータを収集・分析することで、これまで見過ごされてきたプロセスのボトルネックが可視化されます。

ITSM(ITサービスマネジメント)ツールの導入価値は、単なる自動化による工数削減に留まりません。真の価値は、これらの運用データを一元的に収集し、継続的な改善サイクルを回すためのデータ基盤を構築することにあります。

例えば、「リモートサポートの人員不足」という課題は、「オペレーター1人あたりの対応件数と解決時間の相関分析」によって、最適な人員配置やスキルセットを導き出すことが可能です。また、ツールの選定においては、各製品が取得できるデータの種類と粒度、そして分析機能が、自社のKPI改善にどう貢献するかという視点での定量的評価が不可欠です。

開発生産性データの計測が実現する、ビジネススピードの向上

市場の競争力を左右する「仮説検証のスピード」は、開発生産性に関するデータによって客観的に測定できます。開発環境の提供に数日を要する、あるいは承認プロセスが複雑で手戻りが多いといった問題は、「開発者の体感」ではなく、「開発者の総労働時間に占める、価値創出に直結しない時間の割合」としてデータ化すべきです。

この「開発者体験」の低下は、開発生産性の低下、ひいては事業機会の損失に直結します。これを解決するアプローチが、データ駆動型のプラットフォーム構築です。

プラットフォームの本質は、開発プロセス全体をデータ化し、ボトルネックを継続的に特定・改善するための計測基盤として機能する点にあります。CloudHarborのようなソリューションは、インフラの提供を自動化するだけでなく、セキュリティポリシーの遵守状況やリソースの利用効率をデータとして可視化し、ガバナンスと開発スピードの両立を実現します。

最終的に、ITインフラや購買、セキュリティといった一見関連性の低い課題群も、「データの一元管理」と「プロセスの非効率性の定量化」という共通の軸で捉え直すことで、全社的な生産性向上に向けた具体的な戦略へと昇華させることが可能になります。

データ分析が解き明かす、インフラ老朽化の真のリスクと戦略的投資への転換

1. 稼働データが示す、ITインフラのライフサイクルコスト問題

企業のITインフラに関する意思決定は、保守期限(EOL)という形式的な節目だけでなく、機器の稼働年数と障害発生率、そして運用コストの相関データに基づいて行われるべきです。多くの企業において、EOLを迎える機器は、故障率が指数関数的に上昇し始める変曲点に達しており、これは事業継続に対する定量化可能なリスクとなります。

現状の課題は、インフラのTCO(総所有コスト)が正確に計測・分析されておらず、リプレイス先送りがもたらす潜在的な機会損失額が過小評価されている点にあります。特に、グローバルな部品供給データや人材市場の動向を考慮すると、障害発生時のMTTR(平均修復時間)は悪化の一途をたどると予測されます。

2. 投資ポートフォリオの最適化:データに基づく「攻め」と「守り」の再定義

企業のIT投資は、「攻めのDX投資」と「守りのインフラ維持コスト」という二元論で語るべきではありません。これらは企業の投資ポートフォリオとして統合的に分析・最適化されるべきものです。

守りのコスト、すなわち老朽化インフラの保守・更新費用をデータに基づいて最適化することは、単なるコスト削減活動ではありません。それは、攻めのDX投資に再配分可能な原資を創出し、企業全体の投資対効果(ROI)を最大化するための戦略的な財務活動です。この意思決定には、正確なコストデータとリスクの定量的評価が不可欠です。

3. リスクの定量化とビジネスインパクト分析の必要性

EOLを迎えた機器を継続利用するリスクは、**ビジネスインパクト分析(BIA)**を通じて具体的に数値化されなければなりません。例えば、障害発生によるシステムのダウンタイムは、1時間あたりの売上損失額や生産性低下コストとして算出できます。また、サポート終了後の修理不能状態は、復旧までのリードタイムを無限大にし、事業継続そのものを不可能にするリスク要因です。

これらのリスクをデータとして可視化し、「安定稼働しているから継続利用する」という感覚的な判断から、「障害発生確率と予測される損失額を天秤にかけた上で、最適な保守戦略を選択する」というデータドリブンな意思決定へと移行することが求められます。

4. データ駆動型の保守戦略:第三者保守による資産価値の最大化

EOL後の保守戦略を策定する上で、第三者保守は、コスト、リスク、パフォーマンスの3つの軸でデータを比較検討すべき有効な選択肢です。これは、IT資産のライフサイクルをデータに基づいて最適化し、その価値を最大化するアプローチと言えます。

NetOne NEXTが提供する延命保守サービスは、過去35年以上にわたる膨大な障害対応データと、業界有数の保守部材在庫データを基盤としています。このナレッジベースは、特定の機器における障害発生の予兆を検知し、再生品の活用によってサプライチェーンリスクをヘッジするなど、データに基づいたプロアクティブな保守を可能にします。その結果、コスト最適化と安定稼働を両立させ、保守コストという「固定費」を「戦略的投資」へと転換させることができます。

5. 統合データ基盤としてのITSM:属人化からの脱却とガバナンス強化

インフラの老朽化問題は、IT運用全体の課題と密接に関連しています。クラウド環境とオンプレミスが混在し複雑化する中で、属人的な運用プロセスは、対応品質のばらつきや非効率性の温床となります。

ITSMツールは、これらの課題を解決するための統合データ基盤として機能します。インフラ資産のEOL情報、保守契約、障害履歴、構成情報といったデータを一元管理・分析することで、これまで見過ごされてきた運用プロセスのボトルネックを可視化します。データに基づいたプロセスの標準化と自動化は、属人化を排除し、厳格化するITガバナンス要求に応えるための必須要件です。

EOLデータの分析から見直す、ITインフラ投資戦略

企業インフラを構成する多くのICT機器が、導入から数年を経て保守期限(EOL)を迎える時期に差し掛かっています。このEOLに関するデータを正確に把握せず、機器リプレイスの判断を先送りにする選択は、短期的なキャッシュアウトの抑制にはつながるかもしれません。しかし、データに基づかない老朽化機器の継続利用は、保守部材の調達難易度の上昇や、障害発生率の上昇といった定量化すべきリスクを内包しています。

特に製造業など、グローバルなサプライチェーンに依存する業界においては、部品供給の遅延や技術者不足といった外部環境データも複合的に影響し、事業継続計画(BCP)への影響度が重大な経営課題として認識され始めています。

一方で、多くの企業ではDX(デジタルトランスフォーメーション)投資が加速しています。その結果、既存インフラの維持・更新に必要な「守りの投資」と、新たなビジネス価値を創出する「攻めの投資」の最適な配分を、データに基づいて判断するという新たな経営アジェンダに直面しています。

老朽化機器の保守・更新に関わるTCO(総所有コスト)を正確に算出し、最適化戦略を実行できれば、そこから創出された予算をDX推進の原資として再配分することが可能になります。インフラの稼働データや保守履歴データを分析し、延命や保守戦略をデータドリブンで見直すことは、単なるコスト削減策にとどまりません。それは、DXへの再投資を可能にする、攻めと守りを両立するデータに基づいた経営判断そのものです。

事業継続リスクをデータで可視化する:EOL対応の必要性

EOLを迎えた機器の稼働データを分析せずに放置することで顕在化するリスクは、多角的な分析が不可欠です。

代表的なリスクシナリオとしては、突発的な機器故障による業務停止が挙げられます。この場合、想定される停止時間や影響範囲のデータから、事業影響額(Business Impact Analysis)を試算し、リスクを定量化することが重要です。また、メーカーサポート終了後の修理不能状態は、復旧までのリードタイム(MTTR)を著しく長期化させる可能性があります。

特に、障害対応が必要なタイミングで保守部材の調達が不可能であると判明するケースでは、その影響はシステム全体や関連業務へと連鎖的に拡大する危険性があります。これらのリスク発生確率と影響度は、データ分析によって定量的に評価されるべきです。

このようなリスク分析の一方で、多くの企業には「安定稼働している現行システムの稼働データを評価し、EOL後も継続利用の是非を判断したい」「システム全体の保守コストデータを精査し、TCOを削減したい」「限られたIT予算の投資対効果(ROI)を最大化したい」といった、データに基づいた現実的なニーズがあります。

さらに、大規模なシステムを保有する企業では、全ICT機器の資産データを管理し、一度にリプレイスすることは現実的ではありません。そのため、機器の重要度、利用状況、リスク評価に基づいた段階的な導入計画の策定が不可欠です。

EOL対応は、もはや単なるリスク回避のオペレーションではありません。インフラの安定稼働、TCOの最適化、そして戦略的なDX投資。これらを同時に実現するための、データに基づいたIT資産ポートフォリオ管理の視点が求められています。

第三者保守と再生品活用データが導く、”攻めと守り”の投資最適化

EOL機器を継続利用する際に顕在化する「障害発生率の上昇」「セキュリティ脆弱性の残存」「コンプライアンス違反」「部材調達不可による長期停止」といった重大リスクを、まずはデータに基づいて具体的に整理・特定します。そして、それぞれが事業活動やキャッシュフローにどのような影響を及ぼすかを定量的に試算・可視化することが、対策の第一歩です。

その上で、EOL後の機器を安全かつ効率的に活用し続けるための方策として、第三者保守の活用が有効な選択肢となります。その導入効果は、明確なTCO削減データとして測定可能です。

NetOne NEXTの延命保守サービスは、35年以上にわたり蓄積された保守ナレッジデータベースと、現場での豊富な障害対応実績データに基づいています。業界最高基準の検査体制と、業界有数の規模を誇る保守部材の在庫データベースが、その信頼性を裏付けています。

再生品の活用実績データや、多拠点に展開する保守網のデータを駆使することで、機器の安定運用とTCOの最適化を両立させます。これにより、”保守切れ”という漠然とした不安要素を、管理可能な「リスクデータ」へと転換し、事業継続に貢献する実践的なアプローチを具体的な事例データとともに解説します。

老朽化機器のリスク分析と、DX時代における投資戦略の最適化を両立するための、データに基づいた具体的なプランをご提案します。ぜひご相談ください。

1. データ処理量増大に伴うインフラの熱・電力問題の定量化

AI学習やHPC(高性能コンピューティング)によるデータ処理量の指数関数的な増加は、企業インフラにおけるGPUや高性能CPUの導入を加速させています。

しかし、この高性能化は、サーバ1ラックあたりの消費電力と発熱量の急増という深刻な運用課題を直接引き起こしています。従来の空冷方式では冷却が追いつかず、サーバルーム全体の**PUE(電力使用効率)の悪化や、ホットスポット発生による運用リスク(機器故障率の上昇)がデータとして顕在化し始めています。これらはすべて、ITインフラのTCO(総所有コスト)**の増大に直結する喫緊の課題です。

2. 液冷導入におけるデータ分析と意思決定の欠如

高い冷却効率を持つ「液冷方式」は有力な選択肢ですが、多くの企業で導入の意思決定が進んでいません。その本質的な障壁は、技術的な不安以前に、判断材料となるデータの不足にあります。

現状の熱密度(W/ラック)の正確な把握

将来のワークロード増加に伴う発熱量の予測シミュレーション

空冷維持コストと液冷導入コストのTCO比較分析

これらのデータ分析なしに、設備改修や漏水といったリスクアセスメントと期待されるROI(投資対効果)を定量的に評価することは不可能です。運用体制への不安も、導入後の運用データをいかに収集・分析し、異常検知や最適化に活かすかというデータマネジメント戦略が未整備であることに起因しています。

3. EOSL(保守切れ)に依存したIT資産管理の非効率性

インフラ課題はサーバだけではありません。特に製造業の現場などでは、膨大な数のネットワーク機器(L2/L3スイッチ、無線APなど)が存在します。

これらの機器管理において、メーカー保守の終了(EOSL)のみをトリガーとした画一的なリプレイスが繰り返されているケースが多く見受けられます。これは、「まだ十分に利用可能なIT資産」を、データに基づかない画一的なルールで廃棄していることに他なりません。

サステナビリティの観点に加え、キャッシュフローの最適化という観点からも、この運用は非効率です。機器の実際の稼働データ(使用率、トラフィック、故障率、セキュリティリスク)に基づいた、IT資産のライフサイクル全体を通じたコストとリスクの最適化が求められています。

4. 運用工数を圧迫する属人的な資産管理

「製造業務に直結しない」とされるネットワーク機器の管理が、情シス・総務部門の運用工数を著しく圧迫している実態も見過ごせません。

これらの課題は、資産管理台帳の不備や廃棄プロセスの煩雑さといった、データ管理と業務プロセスの問題です。手動かつ属人的な管理が続く限り、工数(コスト)は削減できず、担当者は本来注力すべきコア業務(例:DXの推進、セキュリティ戦略の立案)にリソースを割けません。

現場から「製造設備のようにネットワーク機器も長期利用したい」という声が上がるのは、IT資産の運用実態とコスト構造に基づいた、極めて合理的な要求です。

5. NaaS導入によるネットワークインフラのデータドリブン化

これらのネットワーク機器に関する課題を解決するには、運用モデル自体の変革が必要です。

ネットワンネクストが提供する「NEXT-NaaS」のようなサブスクリプション型サービス(NaaS)は、単なる機器の調達手段の変更ではありません。これは、ネットワークインフラの「資産」を「サービス利用」へと転換(オフバランス化)し、資産管理、保守、廃棄に関連する運用工数とコストを可視化・最適化する経営戦略的なアプローチです。

サービス提供者が専門的な知見に基づき運用データを集約・分析することで、利用企業はネットワークインフラのTCO削減と運用効率化をデータに基づいて実現し、貴重な社内リソースをコア業務へ再配分することが可能になります。