目次

- 1 アイデンティティ・データのサイロ化:現代企業が抱える計測困難なセキュリティ負債

- 2 人事イベント起点データフローの分断がもたらす、ガバナンスとセキュリティの潜在的負債

- 3 データドリブン・アイデンティティセキュリティ:インシデント予測とリスク定量化のための評価フレームワーク

- 4 データ駆動型アプローチによるIDアクセス管理(IAM)の高度化

- 5 データ分析で実現するプロアクティブな脅威検知とインシデント対応

- 6 サイロ化したデータが生むセキュリティリスク:統合IDデータ基盤への変革

- 7 データが示すIAM戦略の転換点:フィッシング耐性MFAによるリスク低減効果の定量化

- 8 認証要素のデータ駆動型評価フレームワーク:保証レベル、リスク、ユーザビリティの最適化

- 9 データ駆動型IAMフレームワークの構築:OktaによるIDシグナルの一元化とリスク分析

アイデンティティ・データのサイロ化:現代企業が抱える計測困難なセキュリティ負債

企業のデジタル・アセットがSaaS、PaaS、IaaS、そしてオンプレミスへと多様化・分散する中、「アイデンティティ・データ」のサイロ化が深刻な経営リスクへと直結しています。システムごとに独立したID/パスワード管理は、事実上、組織のセキュリティ・ガバナンスに無数の抜け穴を生み出している状態です。

ユーザーによる認証情報の使い回しは、単なる個人の行動問題ではありません。これは、単一の認証情報漏洩が、システム横断的な不正アクセス(Lateral Movement)へと発展する蓋然性を著しく高める、アーキテクチャ上の脆弱性です。この「セキュリティ負債」は、インシデント発生時の被害範囲(ブラスト半径)を際限なく拡大させる要因となります。

この課題に対し、アイデンティティ情報を一元的に管理・保護する「IDaaS(Identity as a Service)」は、もはや単なるツールではなく、ゼロトラスト・セキュリティの基盤を成す戦略的投資として位置づけられます。

評価基準:真の統合性は、ハイブリッドIT全体のデータ可視性にある

特に従業員1,000名以上のエンタープライズ環境では、SaaSだけでなく、オンプレミスの基幹システムや内製アプリケーションが企業データの根幹を支えています。IDaaSの導入効果を最大化するには、これらハイブリッドIT環境全体にまたがるアイデンティティ情報を、単一の信頼できる情報源(Single Source of Truth)として統合できるかが、最も重要な評価指標となります。

SAMLやOpenID Connectといった標準プロトコルへの対応は当然の前提です。評価の焦点を当てるべきは、むしろレガシーシステムとの連携性や、SCIM(System for Cross-domain Identity Management)を通じたユーザーライフサイクル管理の自動化レベルです。これにより、入退社や異動に伴うプロビジョニング・デプロビジョニングの即時性が担保され、アクセス権の不正残留リスクを排除できます。

MFA:静的防御から、リスクベースの動的制御へ

多要素認証(MFA)の導入は必須ですが、その実装方法によってセキュリティレベルは大きく異なります。システムごとに個別導入されたMFAは、管理の複雑化を招き、統一的なポリシー適用を困難にします。

IDaaSを介してMFAを統合管理することで、セキュリティは新たな次元へと進化します。それは、ユーザーの場所、時間、デバイス、振る舞いといったコンテキストデータをリアルタイムに分析し、リスクレベルに応じて認証要件を動的に変更する「アダプティブ認証(適応型認証)」です。これにより、低リスクなアクセスには利便性を、高リスクなアクセスには強固な検証を、という合理的なセキュリティ制御が実現します。

【エンタープライズ向け】IDaaS選定のデータドリブン・フレームワーク

中堅・大手企業におけるIDaaS製品の選定は、単なる機能比較に留まるべきではありません。以下の3つの軸に基づき、自社のITアーキテクチャとガバナンス要件への適合性を定量的に評価することが求められます。

統合カバレッジと連携深度: 全社アプリケーションのうち、何%をIDaaSの管理下に置けるか。API連携やカスタムコネクタによる拡張性は十分か。

ガバナンスと可監査性: アクセスログはSIEM等と連携し、異常検知に活用できるか。誰が・いつ・何にアクセスしたかの監査レポートは、コンプライアンス要件を満たすか。

運用効率の改善効果: IDaaS導入により、パスワードリセットに関するヘルプデスクへの問い合わせ件数や、棚卸しにかかる工数を、具体的にどれだけ削減可能か。

これらの評価フレームワークに基づき、主要3製品の特性をデータドリブンに分析・解説しました。

人事イベント起点データフローの分断がもたらす、ガバナンスとセキュリティの潜在的負債

入退社・異動・出向といった人事イベントは、アイデンティティ・データのライフサイクルにおける最も重要なトリガーです。しかし、多くの組織では、このトリガーを起点としたデータフローが各システム(Active Directory, オンプレミスアプリケーション, SaaS)間で分断され、手動でのデータ同期に依存しています。このアーキテクチャは、運用上の非効率性だけでなく、計測可能なリスクを内包しています。

手動オペレーションに起因する対応の遅延や設定ミスは、退職者アカウントの残留(ゴーストアカウント)や過剰な権限付与といった具体的なセキュリティホールを直接生み出します。特にイベントが集中する期末・期初などでは、処理能力がボトルネックとなり、ガバナンスが機能不全に陥るリスクが顕在化。これは、監査指摘のリスクであると同時に、事業継続性を脅かす深刻な負債です。

データサイロ化による信頼性の欠如:アクセス権棚卸しの形骸化

部門やシステムごとに人事データやアカウント情報が独立して管理されている状態は、組織内に無数の**「アイデンティティ・データのサイロ」**を形成します。データの形式や更新粒度が異なるため、全社横断でのデータ一貫性が失われ、どの情報が正なのかを特定することが困難になります。

このような環境下でのアクセス権の棚卸し作業は、信頼性の低いデータに基づいた「点検」に過ぎず、多大な工数をかけてもその正確性は担保されません。属人化した運用はスケールせず、組織の成長と共にデータガバナンスの基盤そのものを侵食していきます。

解決策:SSoTの確立とIGA導入によるデータフローの再設計

この構造的課題を解決する唯一の方法は、アーキテクチャレベルでのアプローチです。すなわち、人事情報を信頼できる唯一の情報源(SSoT – Single Source of Truth)として定義し、そこを起点として各システムへのデータフローを自動化するIDガバナンス(IGA)の仕組みを導入することです。

ディレクトリサービスとアカウントコントロール機能をハブとした実践的なアーキテクチャを提示します。人事イベントをトリガーに、SSoTから取得した正規のデータをAD、オンプレ、SaaSといったターゲットシステムへ自動的に伝播(プロビジョニング)させることで、手動作業を撤廃。これにより、アイデンティティ・ライフサイクル管理のリードタイム短縮、オペレーションコストの削減、そして監査対応可能なレベルでのガバナンス強化を同時に実現します。ハイブリッド環境におけるID管理の高度化を目指す、すべてのIT・ガバナンス担当者にとって必須のセッションです。

データドリブン・アイデンティティセキュリティ:インシデント予測とリスク定量化のための評価フレームワーク

【パラダイムシフトの必要性】

現代のサイバー攻撃において、正規の認証情報を窃取・悪用する「なりすまし」や「権限昇格」がインシデントの主要な原因となっています。これは、従来の静的なID管理や境界型防御が、もはや有効に機能しないことを示唆しています。

真に効果的なセキュリティ戦略は、アイデンティティ関連のデータを継続的に収集・分析し、リスクをリアルタイムに評価・対処する**「データドリブンなアプローチ」**を中核に据える必要があります。貴社のアイデンティティセキュリティ戦略が、このパラダイムシフトに対応できているか、以下のフレームワークを用いて評価することを推奨します。

【評価フレームワーク】

1. 動的リスク評価に基づくアクセス制御(Contextual & Adaptive Access)

静的なロールベースのアクセス許可は、今日の動的な脅威環境では不十分です。アクセス要求の都度、リスクを定量的に評価し、制御を適応させるデータ基盤が求められます。

評価項目1-1: ユーザー、デバイス、ロケーション、アクセス時間、アプリケーションといったコンテキストデータをリアルタイムに収集・分析し、アクセス要求のリスクを動的にスコアリングするメカニズムは実装されているか。

評価項目1-2: リスクスコアに基づき、要求される認証レベルを動的に変更(例:パスワードレス認証から多要素認証へステップアップ)する、適応型認証(Adaptive Authentication)は機能しているか。

2. 特権アクセスの定量的リスク管理(Privileged Access Management & Monitoring)

特権アカウントは、侵害された際のビジネスインパクトが最も大きいアタックサーフェスです。そのリスクは、データに基づいて可視化され、最小化されなければなりません。

評価項目2-1: 「最小権限の原則」は、勘や慣習ではなく、データに基づいて適用されているか。不要な管理者権限は棚卸しされ、JIT(Just-In-Time)アクセスなどにより、特権の保有時間は最小化されているか。

評価項目2-2: 特権ユーザーの操作ログは、単なる記録(Record)ではなく、常時監視・分析される監査データ(Audit Data)として扱われているか。特に、ITサポートスタッフによる特権操作など、利益相反のリスクを持つ活動は、分離・制限・監査されているか。

評価項目2-3: 特権昇格やパスワードリセットといった高リスク操作の要求時には、目視確認やアウトオブバンド認証など、データに基づいた厳格な本人確認プロセスが自動的に実行されるか。

3. 行動分析による異常検知(User and Entity Behavior Analytics – UEBA)

インシデントの予兆は、個々のログではなく、データの「振る舞い」に現れます。平常時の行動パターンを学習し、逸脱を検知する分析能力は不可欠です。

評価項目3-1: 個々のユーザーやデバイスの平常時の行動(ログイン時間、アクセスするリソース、データ転送量など)を機械学習によってベースライン化し、そのモデルを継続的に更新するシステムは存在するか。

評価項目3-2: ベースラインから逸脱した異常行動(例:深夜の大量ファイルダウンロード、休眠アカウントからのアクセス)を自動検知し、セキュリティ担当者にアラートを発するだけでなく、リスクスコアへ即座に反映させる仕組みは確立されているか。

4. サプライチェーンのゼロトラスト監査(Third-Party Zero Trust Verification)

サードパーティは、もはや信頼すべきパートナーではなく、データに基づいて継続的に「検証」すべきリスク要因です。

評価項目4-1: サードパーティのアクセスに対し、「暗黙の信頼」を完全に排除しているか。彼らのセキュリティ態勢(デバイスの健全性、認証強度など)を、接続の都度データで検証し、アクセス権を動的に制御しているか。

評価項目4-2: サードパーティによる操作ログを自社で収集・監査し、契約やポリシーへの準拠を継続的にモニタリングするデータガバナンス体制は構築されているか。

【結論:統合データ基盤としてのアイデンティティセキュリティ】

上記の項目に一つでも「No」があれば、それはアイデンティティ起因のセキュリティインシデントが発生するリスクが、定量的に高い状態にあることを示唆します。

これらの要件は、分断されたソリューションの寄せ集めでは達成できません。統合されたアイデンティティデータプラットフォームの上で、アクセス管理、インシデント対応、リスク管理のサイクルを回すことではじめて、プロアクティブで予見的なセキュリティが実現します。貴社のサイバーセキュリティ戦略は、このデータ中心のアプローチへと進化しているでしょうか。

データ駆動型アプローチによるIDアクセス管理(IAM)の高度化

現状のIDアクセス管理(IAM)は、インシデント発生後の対応や、チェックリストに基づいた形式的な運用に留まっていないでしょうか。本質的なセキュリティレベルの向上と運用効率化を実現するためには、各種ログデータや利用状況を定量的に分析し、リスクを可視化・評価するデータ駆動型のアプローチが不可欠です。

以下に、貴社のIAMを次のステージへ引き上げるための主要な分析・評価軸を提示します。

1. アクセス認証強度とリスクの定量分析

認証はセキュリティの第一線です。その実効性をデータで評価する必要があります。

MFA(多要素認証)の網羅性と有効性の評価: フィッシング耐性を持つMFAの導入率をユーザー群・システム群ごとに算出します。導入されていない領域のリスクレベルを定量化し、導入の優先順位付けをデータに基づいて決定します。

認証ライフサイクル全体の分析: 従業員のオンボーディングから退職、アカウント回復に至る全プロセスにおいて、認証ログを分析します。これにより、特定のプロセスにおける脆弱性や形骸化している手順を特定します。

リスクベース認証の導入評価: 「MFA要素のリセット」「新規デバイスからのアクセス」といったハイリスクイベントの発生頻度と、それに対する自動通知・ステップアップ認証の成功率を計測します。これらのデータを基に、ユーザーの行動パターンから逸脱した異常アクセスを検知するモデルを構築します。

2. IDライフサイクル管理の自動化と効率測定

ID管理プロセスに潜む非効率性や潜在的リスクをデータで明らかにします。

プロビジョニングのKPI設定: オンボーディング・オフボーディングにおけるID発行・権限付与・権限剥奪の所要時間(Mean Time to Provision/Deprovision)を計測し、自動化による改善効果を可視化します。

休眠・孤児アカウントの定義と検出: 「最終ログイン日時」「利用実績のない権限」などのデータに基づき、休眠・孤児アカウントの明確な基準を定義します。HRデータとアクセスログを定期的に突合し、これらのアカウントを自動的に検出・棚卸しするプロセスを確立します。

アクセス権レビューの形骸化防止: 定期的に実施されるアクセス権レビューについて、承認率、却下・修正率、レビュー完了までの期間をトラッキングします。AIを活用し、ユーザーの所属部署や役職に対して統計的に異常な権限付与パターンを検出し、レビュー担当者に提示することで、レビューの精度と効率を向上させます。

3. 特権ID・サービスアカウントのリスク分析と統制

最もリスクの高い特権IDとサービスアカウントは、特に重点的なデータ分析の対象とします。

PAM(特権アクセス管理)ソリューションのデータ活用: PAMツールで取得される操作ログを分析し、「誰が」「いつ」「どの資産に」「何をしたか」を可視化します。平常時のアクセスパターンを機械学習でモデル化し、逸脱した振る舞いをリアルタイムで検知・警告する仕組みを構築します。

サービスアカウントの認証情報管理: パスワードの定期ローテーションや、都度発行される短期的な認証情報の利用率を計測します。ハードコードされた認証情報が残存していないか、ソースコードや設定ファイルを静的解析し、リスクを洗い出します。

4. ガバナンスとコンプライアンス遵守状況の可視化

IT全般統制の観点から、IAM戦略がベストプラクティスに準拠していることをデータで証明します。

職務分掌(SoD)違反のプロアクティブな検知: 静的なルールセットに基づくチェックだけでなく、権限付与の相関関係を分析することで、「毒性のある権限の組み合わせ」のリスクをスコアリングします。これにより、潜在的なSoD違反リスクをプロアクティブに特定します。

外部委託先・サードパーティアクセスの監視: 外部ユーザーによるアクセスログを常時監視し、契約範囲外のシステムへのアクセス試行や、活動時間外の不審な挙動を自動検知します。

5. リアルタイム脅威検知へのデータ活用

セッションデータは脅威インテリジェンスの宝庫です。

セッション情報の一貫性分析: ユーザー認証時のIPアドレスと、その後のAPI・Webリクエストで観測されるIPアドレスの整合性をリアルタイムで監視します。不一致が検知された場合、セッションを自動的に無効化するルールの有効性を評価します。

ネットワークインテリジェンスの活用: 匿名化プロキシ(Torなど)や既知の悪性IPアドレスからのアクセス試行をブロックした実績をログから集計・分析し、脅威トレンドの把握と対策の有効性評価に繋げます。

データ分析で実現するプロアクティブな脅威検知とインシデント対応

「The State of Secure Identity Report 2023」によれば、Webアプリケーション侵害の86%が漏洩した認証情報に起因し、MFA(多要素認証)試行の12.7%がバイパスを狙ったものでした。これらのデータは、アイデンティティがサイバー攻撃の主要な標的であり、その防御が極めて重要であることを客観的に示しています。

インシデント発生後の対応(修復・軽減)に留まらず、各種ログデータを常時分析し、攻撃の予兆をプロアクティブに検知・対処するデータ駆動型のアプローチこそが、セキュリティ態勢を本質的に強化する鍵となります。

以下に、貴社の脅威検知と対応能力をデータ分析の観点から評価し、高度化するための分析軸を提示します。

1. インシデント対応能力のデータドリブン評価

インシデント対応プロセスは、その有効性をデータで測定し、継続的に改善する必要があります。

特権アクセスログの定量的リスク評価: 特権アカウントの操作ログを分析し、ベースラインから逸脱した異常行動の検知率、検知から対応までの平均時間(MTTD/MTTR)をKPIとして設定・計測します。これにより、監視体制の実効性を定量的に評価します。

ユーザー行動分析(UBA)データの戦略的活用: UBAソリューションを単なるアラートツールとしてではなく、戦略的なデータソースとして活用します。ユーザー毎の行動ベースラインを統計的にモデル化し、そこからの逸脱度をリスクスコアとして算出。このスコアを他のセキュリティシグナル(例:アクセス元のIPレピュテーション、デバイスのセキュリティ状態)と組み合わせた相関分析を行い、複合的なリスク判断の精度を高めます。

構成変更の監査と影響分析: Active DirectoryのエージェントやIdP(Identity Provider)の設定など、重要な構成への変更ログを常時監視・分析します。変更がもたらす潜在的なリスク(例:意図しない権限昇格、セキュリティ設定の無効化)を自動的に評価し、アラートの優先順位付けを行います。

Infrastructure-as-Code(IaC)による構成ドリフトの定量的管理: IaCを用いてアイデンティティプラットフォームを管理している場合、コードとして定義された「あるべき姿」と、実環境の構成との差分(ドリフト)を継続的に監視・測定します。ドリフトの発生頻度や規模をデータで把握し、構成管理の安定性とセキュリティを確保します。

2. 攻撃検知と防御ロジックの高度化

攻撃者の手口は常に進化しています。防御側も、静的なルールベースの対策から、データ分析に基づく動的で適応的な防御へとシフトする必要があります。

ログイン試行データの統計分析: ブルートフォース攻撃やクレデンシャルスタッフィング攻撃を検知するため、ログイン試行に関する多角的なデータを分析します。IPアドレス、デバイスフィンガープリント、試行回数、時間間隔、成功/失敗率などを基に統計モデルを構築し、個々のユーザーや組織全体における異常な試行パターンをリアルタイムで特定します。

地理空間データとアクセスパターンの相関分析: ユーザーのアクセス元IPアドレスから得られる地理空間データと、過去のアクセスパターンを分析します。物理的に移動不可能な速度でのアクセス(Impossible Travel)や、ユーザーの典型的な活動地域から逸脱したアクセスを検知し、リスクに応じた追加認証を要求するロジックを構築します。

脅威インテリジェンスの活用と有効性測定: 匿名化プロキシ(Torなど)や既知の悪性IPアドレスからのアクセスをブロックするだけでなく、そのブロック実績をログから集計・分析します。どの地域の、どの種の脅威からの攻撃が多いかを可視化し、脅威インテリジェンスフィードの有効性を評価すると共に、将来の脅威トレンド予測に繋げます。

APIトラフィック分析による不正トークン利用の検知: マシン間(M2M)通信におけるOAuthトークンのライフサイクルと利用状況を監視します。トークンの発行、更新、失効のプロセスや、アクセス先のAPIエンドポイント、リクエスト頻度などを分析し、トークンハイジャックやリプレイ攻撃といった異常な利用パターンを検出します。

複数シグナルに基づくボット行動のスコアリング: 単一のシグナル(例:IPレピュテーション)に頼るのではなく、複数のデータソースを統合してボットの可能性をスコアリングします。サードパーティのボット評価スコアに加え、マウスの軌跡、クリック位置、タイピング速度といったクライアントサイドで収集される振る舞いに関するシグナルを総合的に分析し、「人間らしさ」を定量化することで、巧妙なボットをより正確に識別します。

セッション管理の最適化: ユーザーエクスペリエンスとセキュリティのバランスを取るため、セッション管理ダッシュボードを構築し、アクティブなセッション数、セッション維持時間、タイムアウト率などのKPIを監視します。これらのデータを分析し、アプリケーションの特性やユーザーのリスクレベルに応じた最適なセッションポリシーを策定します。

サイロ化したデータが生むセキュリティリスク:統合IDデータ基盤への変革

データ分析を阻害する「ポイントソリューション」の限界

多くの組織では、MFA、SSO、IDガバナンス、侵害検知といった機能を、個別の「ポイントソリューション」を組み合わせて実現しています。しかしこのアプローチは、データ分析の観点から深刻な課題を内包しています。

各システムから出力されるログは、形式も粒度もバラバラな状態でサイロ化します。これでは、脅威の全体像を捉えるための横断的な分析は実質的に不可能です。インシデント発生時、関連データを複数のシステムから抽出し、手作業で突合・正規化する必要が生じるため、原因特定までの平均時間(MTTR)が著しく長期化します。これは、攻撃者にとっては格好の隠れ蓑となり、侵害の拡大を許す直接的な要因となります。

統合IDプラットフォームを「データ基盤」として捉え直す

この課題への解決策は、単にツールを一つにまとめることではありません。統合IDプラットフォームを、すべてのアイデンティティ関連データを一元的に収集・正規化する「データ基盤」として捉え直すことにあります。

このデータ基盤が実現することで、初めて認証ライフサイクル全体を俯瞰した、高度なデータ分析が可能になります。

結論:事後対応コストから、データ分析への戦略的投資へ

2023年におけるデータ漏洩の平均コストは約400万ドルに達しました。この莫大な金額は、インシデントが発生した後の「事後対応コスト」に他なりません。

多くのセキュリティリーダーは、依然として「認証時」という一点の防御に注力しがちです。しかし、真の課題は、認証の前後を含めたアイデンティティ・ジャーニー全体をデータで可視化し、攻撃の連鎖をいかに早期に断ち切るかにあります。

統合IDデータ基盤への投資は、単なるツール導入コストではなく、この約500万ドルという潜在的損失を未然に防ぐための、極めてROI(投資対効果)の高い戦略的投資であると結論付けられます。

データが示すIAM戦略の転換点:フィッシング耐性MFAによるリスク低減効果の定量化

現状分析:脅威データと従来型セキュリティの限界

今日のサイバー攻撃は、マルウェア、ハッキング、フィッシングといった多様な手口を駆使し、その主たる攻撃ベクトルは「ID(アイデンティティ)」へとシフトしています。これらの攻撃がもたらす事業インパクトは、認証情報の窃取、アカウント侵害、そして最終的なデータ流出へと連鎖的に発生します。

データに基づき現状を分析すると、オンプレミスのアプリケーションやファイアウォールといった境界型防御に依存した従来のセキュリティアプローチでは、IDを標的とする高度な攻撃に対する脆弱性が顕在化しています。インシデント発生後の分析では、硬直的かつ複雑に連携した断片的なセキュリティ基盤が、脅威の検知遅延や対応コストの増大を招く要因であることが特定されています。これは、組織と従業員を保護するためのセキュリティ投資対効果(ROI)を著しく低下させる要因です。

データインサイト:IT/セキュリティリーダーの課題とMFAの進化

OktaとIDGが実施した共同調査から、ITおよびセキュリティ部門のリーダーが直面する認証セキュリティに関する具体的な課題が、統計データとして明らかになりました。この調査結果は、フィッシング耐性を持つ多要素認証(MFA)が、単なるセキュリティ要件ではなく、事業継続性を担保する上での戦略的投資対象であることを示唆しています。

さらにデータは、MFAを取り巻く環境が静的なものではなく、動的に変化していることを示しています。具体的には、以下の2点が重要なトレンドとして観測されています。

パスワードレス認証への移行: 認証プロセスにおける脆弱性の根源であるパスワードを排除する動きが加速しており、ユーザー体験とセキュリティレベルを両立させるための主要な解決策として注目されています。

管理/非管理デバイスの識別: ゼロトラストの原則に基づき、あらゆるデバイスからのアクセスを信頼せず検証するアプローチが標準化する中で、デバイスの状態を正確に評価・識別する能力が、セキュリティ態勢を評価する上での新たな重要指標となっています。

本レポートが提供する価値

本レポートは、これらのデータインサイトに基づき、MFAの導入効果を最大化するための実践的なベストプラクティスと、パスワードレス認証への戦略的アップグレードの指針を提供します。OktaとIDGの共同調査結果を基に、現代の認証セキュリティにおけるIDアクセス管理(IAM)の戦略的重要性を論証し、IT/セキュリティリーダーに共通する優先課題と技術採用トレンドを分析します。

さらに、効果的なMFAソリューションを設計・実装する上で不可欠な、以下の要素についてデータドリブンなアプローチで解説します。

フィッシング耐性の実装と効果測定: 導入前後におけるフィッシング攻撃の成功率の変化を測定し、リスク低減効果を定量的に評価する手法。

ポリシーと規制への準拠: 各種規制要件とMFAポリシーの整合性を評価し、コンプライアンス遵守を証明するためのデータ管理フレームワーク。

アクセスニーズの動的分析: ユーザーのアクセスパターンデータを分析し、リスクレベルに応じた動的なアクセスポリシーを設計・最適化するアプローチ。

最終章では、Oktaのエンジニアリングチームおよび製品チームが実案件で得た知見に基づき、既存アプリケーションへMFAを実装する際の技術的課題と、その解決に向けた具体的なアーキテクチャパターンを提示します。これにより、実装プロジェクトにおけるROIの最大化に貢献します。

認証要素のデータ駆動型評価フレームワーク:保証レベル、リスク、ユーザビリティの最適化

認証要素の体系的分類とMFAの基本原則

認証とは、提示されたアイデンティティが正当なものであるかを検証するプロセスです。この検証には、国際的な標準(例:NIST SP 800-63)に基づき、以下の3つの独立した要素タイプが定義されています。

知識要素 (Something you know): パスワード、PINコードなど、本人のみが知り得る情報。

所有要素 (Something you have): スマートフォン、ハードウェアトークン、スマートカードなど、本人のみが物理的に所有する物。

生体要素 (Something you are): 指紋、顔認証など、本人固有の身体的・行動的特徴。

多要素認証(MFA)は、これら3タイプの中から2つ以上の異なる要素を組み合わせることで、単一要素認証に比べてセキュリティ強度を飛躍的に向上させるための論理的なフレームワークです。現在主流となっているのは、知識要素(パスワード)に、所有要素(モバイルアプリへのプッシュ通知やOTPトークン)または生体要素を組み合わせるハイブリッドアプローチです。しかし、各認証アプローチには、セキュリティ強度、導入コスト、ユーザー体験において明確なトレードオフが存在するため、データに基づいた客観的な評価が不可欠です。

認証器の保証レベル(Assurance Level)に基づくリスク評価

認証器(Authenticator)とは、認証要素を検証するための具体的な手段やツールを指します。これらの認証器は、その技術的特性により、なりすましや攻撃に対する耐性が異なります。我々はこの耐性のレベルを「保証レベル」として定義し、客観的なリスク評価の指標とします。

以下は、Oktaが定義する保証レベルに基づく認証器の分類と、そのデータ分析的考察です。

低保証レベル:

該当認証器: パスワード、セキュリティ質問、SMS/音声/メールによるOTP、時刻同期式OTPアプリ(TOTP)。

データ分析的考察: これらの認証器は、フィッシングやクレデンシャルスタッフィング攻撃に対して脆弱であることがインシデントデータから明らかになっています。特にSMSやメールを伝送路とするOTPは、SIMスワップや大規模なフィッシング攻撃(AiTM: Adversary-in-The-Middle)によって容易に傍受されるリスクが定量的に確認されており、保証レベルは著しく低いと評価せざるを得ません。

中保証レベル:

該当認証器: モバイルプッシュ通知、物理トークンによるOTP。

データ分析的考察: 暗号化された通信路を利用するため、単純な盗聴には耐性があります。しかし、ユーザーを騙して承認させる「プッシュ疲労攻撃」や、洗練されたAiTM攻撃に対しては依然としてリスクが残存します。

高保証レベル:

該当認証器: FIDO2/WebAuthn(生体認証等と連携)、PIV/CACスマートカード。

データ分析的考察: 公開鍵暗号基盤を利用し、認証リクエストのオリジン(ドメイン)を検証するため、フィッシング攻撃やAiTM攻撃に対して原理的に高い耐性を持ちます。これらの認証器の導入は、アカウント乗っ取りインシデントの発生率を劇的に低下させることが実証されています。セキュリティ強化における投資対効果(ROI)が最も高い選択肢です。

データに基づく戦略的提言:保証レベルとユーザー体験の最適化

認証戦略を策定する上で、保証レベルは最も重要な評価指標ですが、それだけが唯一の判断基準ではありません。ユーザーの受容性(ユーザビリティ)や導入の容易さも、MFAの導入率と定着率を左右する重要な変数です。

例えば、SMS認証は、スマートフォンの普及率の高さからユーザーカバレッジが広く、初期導入の障壁が低いという利点があります。しかし、前述の通りセキュリティインシデントの発生率データを鑑みると、その利用は低リスクなユースケースに限定すべきです。

したがって、データに基づいた最適な戦略とは、リスクとユーザビリティのバランスを取ることにあります。Okta Verify Pushのようなプッシュ通知や、WebAuthnを利用した生体認証は、高いセキュリティ(中〜高保証レベル)と優れたユーザー体験を両立させる現実的なソリューションです。特に、フィッシング耐性を持つWebAuthnは、セキュリティを最優先するシナリオにおいて強く推奨されます。

最終的な目標は、アクセスされるリソースの重要度や、検知されたリスクレベルに応じて、要求する認証レベルを動的に変更する「アダプティブ(リスクベース)認証」を実装することです。この高度なセキュリティモデルを実現するためには、高保証レベルの認証器をポートフォリオに組み込むことが不可欠となります。

データ駆動型IAMフレームワークの構築:OktaによるIDシグナルの一元化とリスク分析

課題:分散したIDデータと静的なセキュリティルールの限界

現代の事業環境は、正社員、契約社員、リモートワーカー、サードパーティパートナーといった多様なユーザーによって構成され、そのアクセス対象はオンプレミスとクラウドに分散しています。この複雑なエコシステムは、膨大かつ多岐にわたるアイデンティティ関連のデータ(シグナル)を生成し続けています。

データ分析の観点から見ると、従来のセキュリティアプローチの多くは、これらの分散したデータを横断的に分析できず、静的なルールセットに依存しているという課題を抱えています。その結果、洗練されたフィッシング攻撃やセッションハイジャックといった脅威に対する検知精度が低下し、リスクの定量的評価が困難になっています。

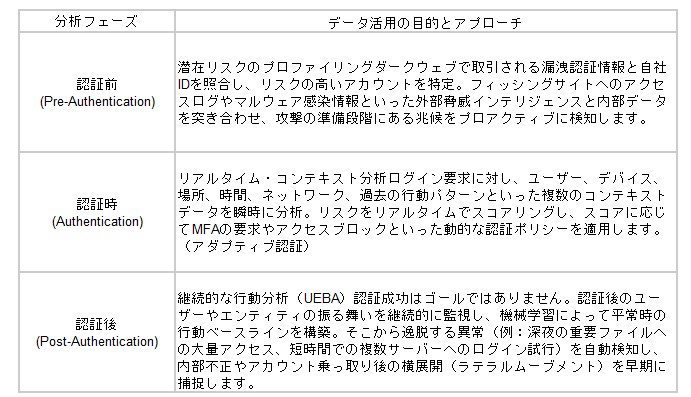

Oktaは、これらの課題に対し、組織内に散在するIDシグナルを単一のプラットフォームに集約・統合するデータ中心のアプローチを提案します。既存のIdPやSaaSアプリケーションとのシームレスな連携により、IDライフサイクル全体(認証前・認証時・認証後)にわたる包括的なデータ可視化を実現し、IAM(IDおよびアクセス管理)を「ルールベース」から「データ駆動型」へと転換させます。

フェーズ1:認証時のポリシー適用とデータ品質の確保

強力なセキュリティ態勢の基盤は、高品質なデータ収集から始まります。認証プロセスは、リスクを判断するための最初の、そして最も重要なデータ収集ポイントです。

フィッシング耐性を持つ認証器の導入: これは、入力されるデータ品質を最大化する施策です。FIDO2/WebAuthn準拠の生体認証のような高保証レベルの認証器は、「誰が」アクセスしているかというデータの信頼性を飛躍的に高めます。これにより、ノイズの多いシグナル(例:漏洩したパスワード)を排除し、後続の分析フェーズの精度を向上させます。

IDライフサイクルの自動化(プロビジョニング): 従業員の入社・異動・退職に伴うアクセス権の変更を自動化することは、IDデータの整合性を維持するために不可欠です。これにより、過剰な権限付与(Privilege Creep)やゴーストアカウントといった、重大なセキュリティリスクに直結するデータ異常を未然に防止します。

動的なアクセス権限の付与: 機密リソースへの「期限付きアクセス」や、特権アカウントのパスワード管理(パスワードボールト)といった機能は、アクセス要求のコンテキスト(誰が、何を、いつ、なぜ)に基づき、リスクを最小化するためのデータ制御手法です。

フェーズ2:認証後の継続的なリスク分析とシグナル相関

脅威は静的なものではなく、認証後も常に変化します。このフェーズでは、収集したIDシグナルを継続的に分析し、異常を検知します。

複数ソースからのリスクシグナル統合: Oktaのプラットフォームは、自らが生成するファーストパーティデータに加え、EDRやSIEMといったサードパーティのセキュリティ製品からのシグナルを取り込み、相関分析を行います。これにより、単一のシステムでは見過ごされがちな脅威の兆候を捉えます。

AIによるリスクスコアリング: 収集された多様なシグナル(デバイス情報、地理的位置、時間帯、過去の行動パターンなど)をAIエンジンが分析し、ユーザーおよびセッションごとにリアルタイムでリスクスコアを算出します。この定量化されたスコアが、客観的な意思決定の根拠となります。

リアルタイムでの異常検知: 確立されたベースラインから逸脱するユーザー行動、コンプライアンス違反の可能性があるアクセス、潜在的な設定不備などをリアルタイムで分析・特定します。

フェーズ3:分析データに基づく自動化されたリスク対応

データ分析から得られたインサイトは、具体的なアクションに繋がらなければ価値がありません。このフェーズでは、リスクスコアに基づき、最適化された対応を自動で実行します。

リスクレベルに応じた動的な対応:

低リスク: シームレスなアクセスを許可。

中リスク: 追加の認証要素を要求するステップアップMFAを適用。

高リスク: セッションを強制的に終了させ、ユーザーアカウントを一時的にロックアウトする。

このようなリスクベースの自動化された対応は、セキュリティチームのインシデント対応時間(MTTR)を大幅に短縮します。

自動化されたSecOpsワークフロー: 高リスクなイベントが検知された場合、単にアクセスをブロックするだけでなく、アクセス権の見直し(アクセスレビュー)プロセスの自動起票や、SIEM/SOARへのアラート通知といった、一連のSecOps対応を自動で実行します。