目次

製品やハイブリッドクラウド・マルチクラウドの試験導入に対するデータコンサルタント視点での検討

ハイブリッドクラウドを活用した製品・サービスの試験導入

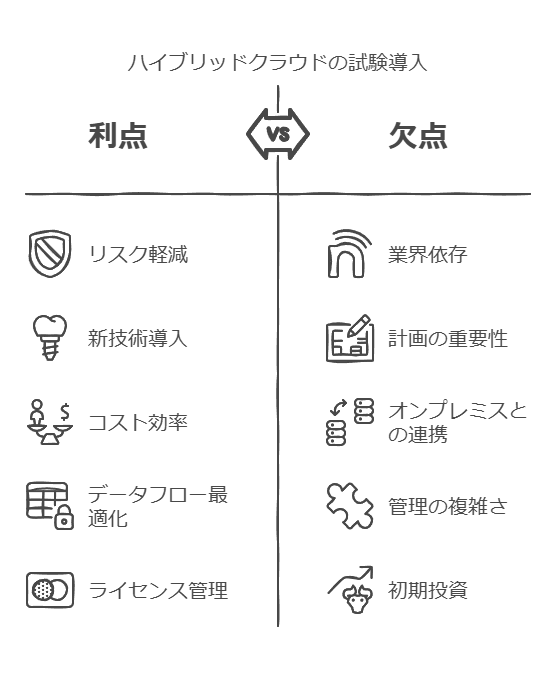

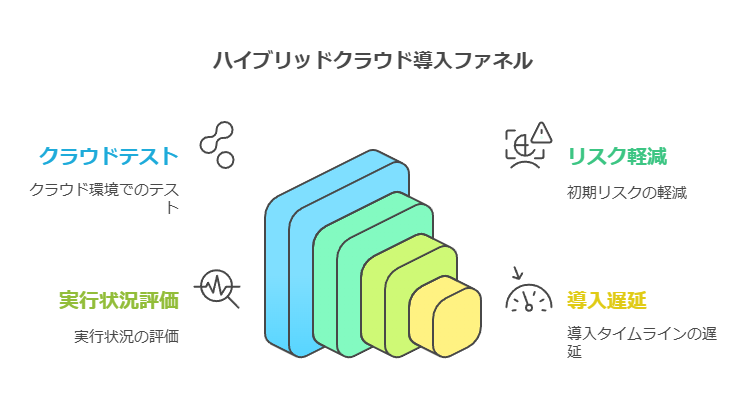

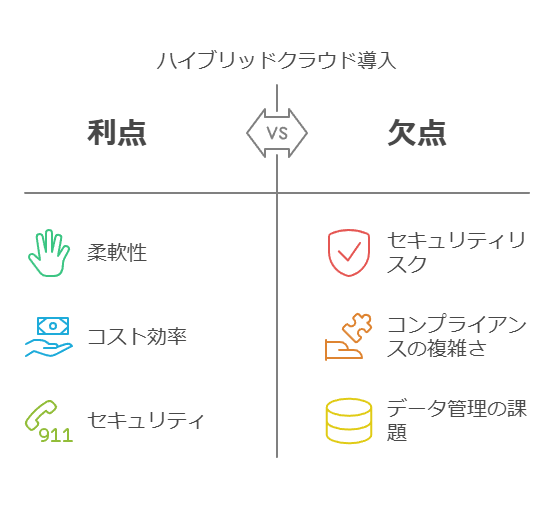

ハイブリッドクラウドの構築により、企業は特定のベンダーの製品やサービスを大規模に導入する前に、まずクラウド上で試験的に導入することができます。これにより、初期の導入リスクを軽減しつつ、実際の運用状況を確認できます。しかし、こうした試験導入が結果的に実導入のタイムラインを遅らせるリスクもあります。

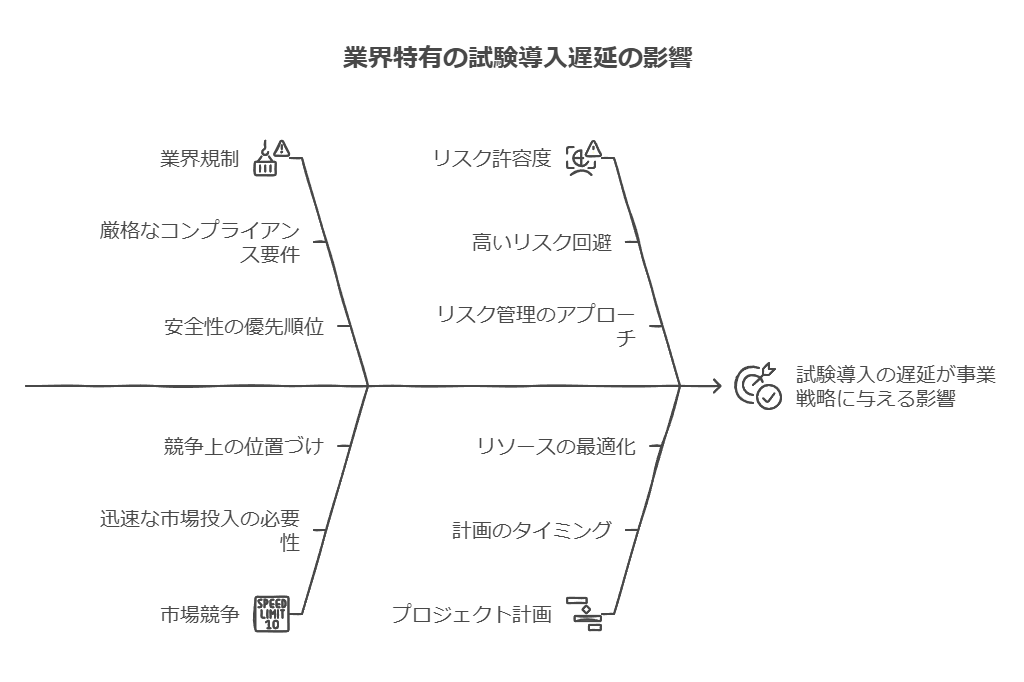

試験導入のリスクと業界による違い

金融や医療などリスク回避を優先する業界では、試験導入の遅れはそれほど大きな問題とならない場合が多いです。これらの業界では、安全性や法令順守が最重要であり、実導入の遅れが許容されることが多いためです。一方で、スタートアップなどスピードが競争力に直結する企業では、試験導入の遅れが事業戦略に悪影響を与えるリスクがあります。迅速に市場に出たい企業にとって、ハイブリッドクラウドの導入がかえって進行を遅らせる場合があるため、適切なプロジェクト計画が重要です。

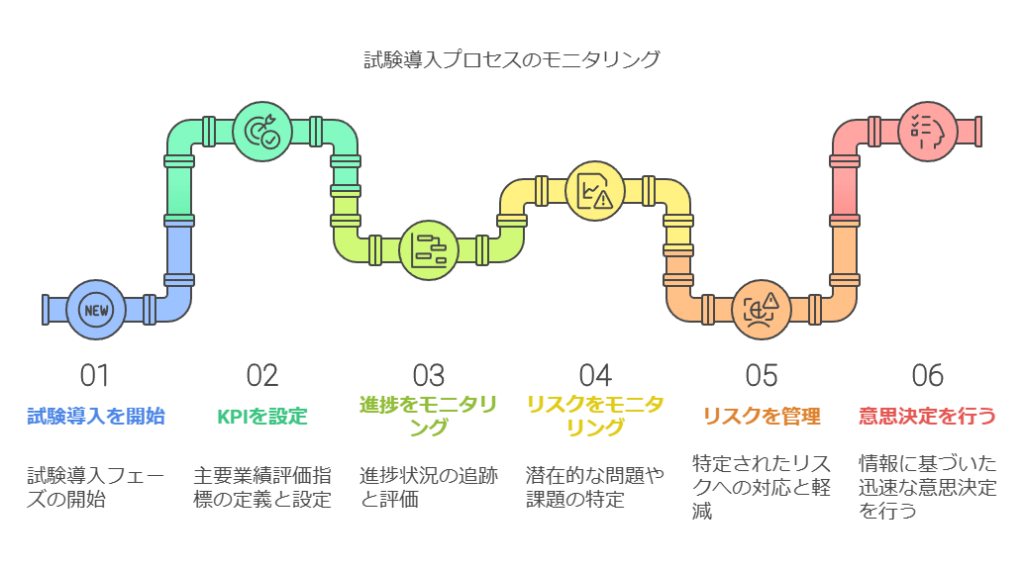

データコンサルタント視点: 試験導入の段階で、適切なKPI(重要業績評価指標)を設定し、導入の進捗とリスクをモニタリングすることが肝要です。リスクの特定と管理により、迅速な意思決定が求められる企業においても、スムーズな導入を実現できます。

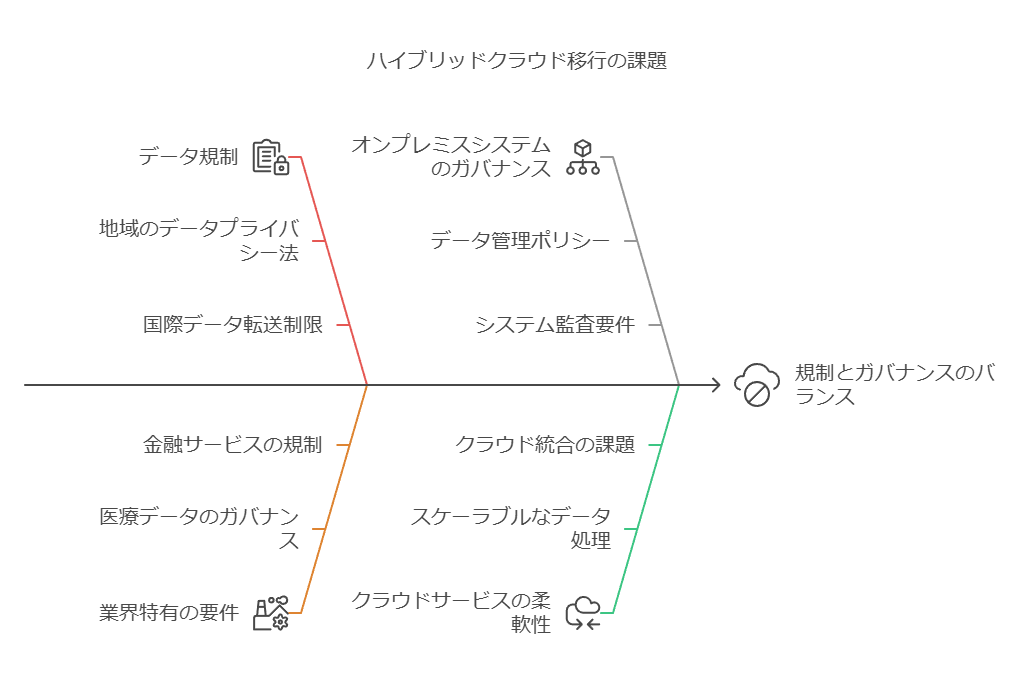

クラウドが利用できない場合のハイブリッドクラウドの価値

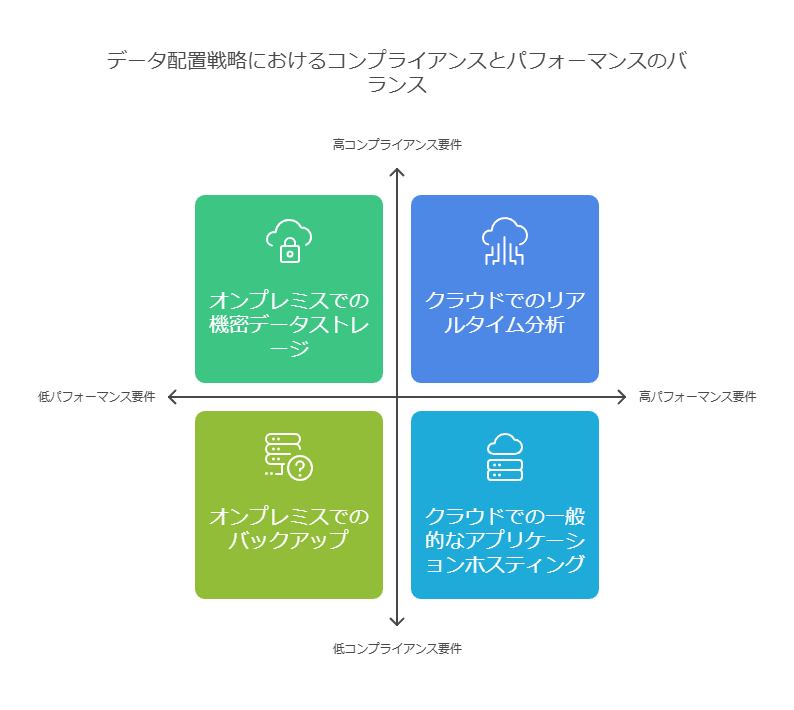

企業がクラウドを利用したいにもかかわらず、データの規制や業界特有の要件で完全な移行が難しい場合、ハイブリッドクラウドは効果的なソリューションとなり得ます。特にオンプレミスシステムのガバナンス要件を維持しつつ、クラウドサービスの柔軟なデータ処理能力を活用することで、データの安全性と運用効率を両立させることが可能です。

データ活用のガバナンスと自由度の両立

企業のオンプレミスシステムには、法令順守や機密性を重視し、クラウドに移動できないデータがあります。こうしたケースにおいて、ハイブリッドクラウドを導入することで、既存のガバナンスやリスク管理要件を維持しながら、クラウドの強力なデータ処理ツールを利用することができます。

例えば、オンプレミスでデータ分析を実行し、その結果のみをクラウドに送信するアプローチは、データの安全性を保ちつつクラウドの柔軟性を活用する良い例です。

データコンサルタント視点: ハイブリッドクラウド導入時には、データフローを最適化し、どのデータをオンプレミスに残すか、どの部分をクラウドで処理するかを慎重に決定することが必要です。これは法規制やデータ主権の要件に対応するための重要なポイントです。

オンプレミスとクラウドサービスの連携課題

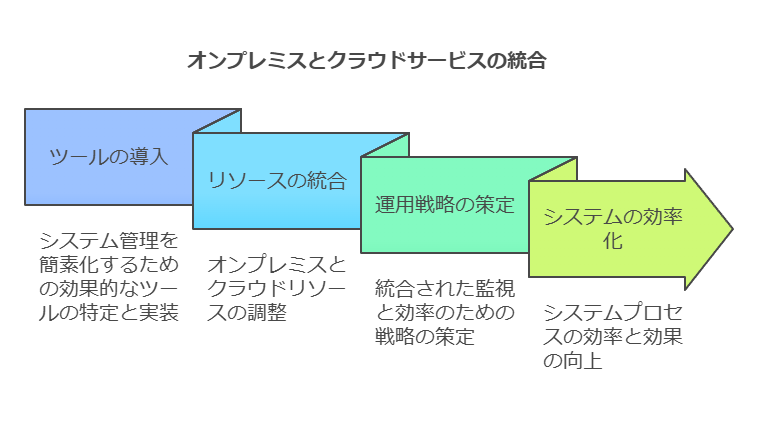

ハイブリッドクラウドでは、オンプレミスのインフラとクラウドサービスを効果的に連携させることが課題となります。現在では、こうした連携を容易にするための管理ツールが提供されています。例えば、Microsoftの「Azure Arc」やGoogleの「Anthos」などがその代表例です。これらのツールにより、オンプレミスとクラウドのリソースを一元的に管理し、ハイブリッド環境での一貫した運用を実現できます。

データコンサルタント視点: 効果的なツールの導入は、システム管理の複雑さを軽減し、オンプレミスとクラウド間のスムーズな連携を確保する鍵となります。クラウドとオンプレミスのリソースを統合的に監視し、効率化するための運用戦略を策定することが不可欠です。

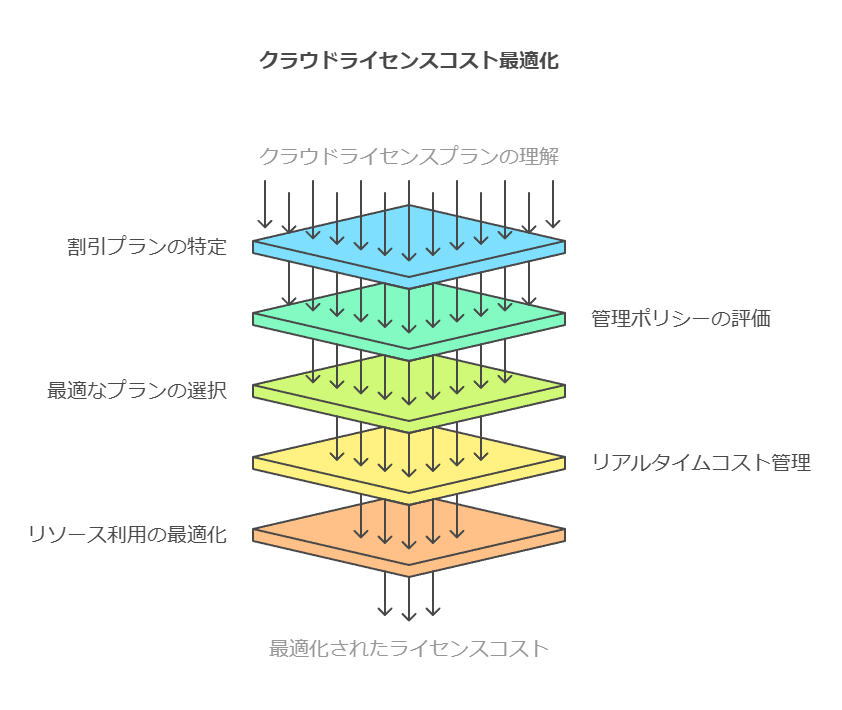

ライセンスコストの最適化

ハイブリッドクラウドを活用することで、オンプレミスとクラウド両方で稼働しているソフトウェアのライセンスコストを最適化することが可能です。例えば、MicrosoftやOracleは、自社のクラウドサービスを利用する企業に対してライセンス料金の割引プランを提供しています。これにより、クラウド移行のコスト負担を軽減することが可能です。

データコンサルタント視点: ライセンスコストを最適化するには、各クラウドベンダーの提供する割引プランやライセンスの管理ポリシーを深く理解し、最適なプランを選択することが重要です。また、使用状況に応じたライセンスの適正管理を行うため、リアルタイムでのコスト管理とリソース利用の最適化も求められます。

結論

ハイブリッドクラウドの試験導入は、リスクを軽減しながら新しいテクノロジーの導入を行うための効果的な手段ですが、業界や事業スピードに応じた計画が重要です。また、オンプレミスとクラウド間のデータフローやライセンス管理を最適化し、コスト効率を高めることで、ハイブリッドクラウドの最大限の効果を引き出すことが可能です。

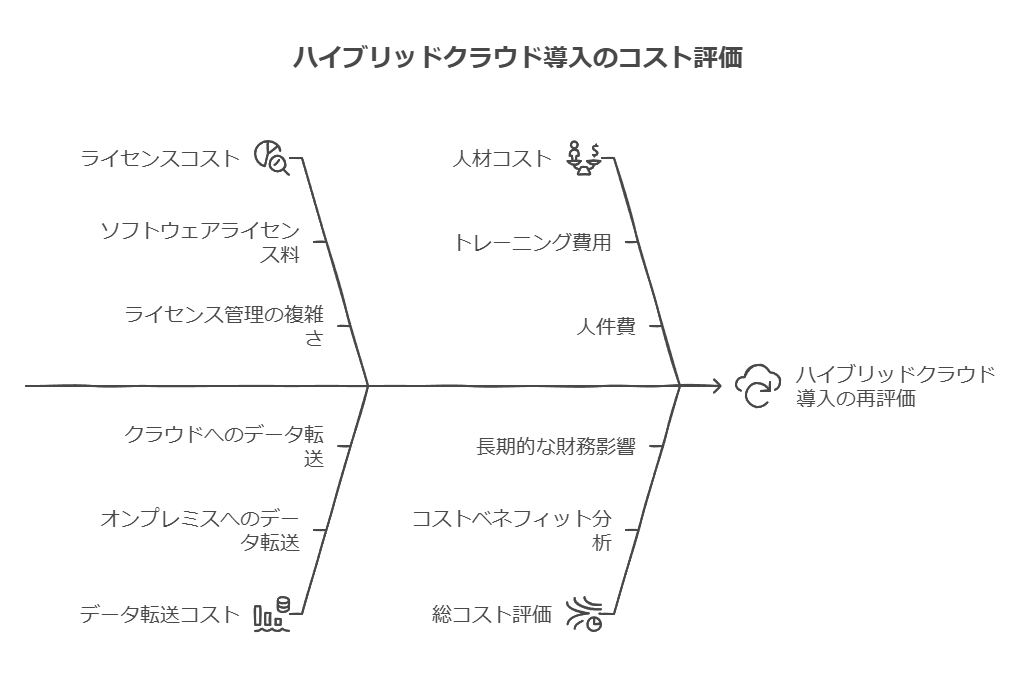

コスト要因とハイブリッドクラウドの構築判断

企業は、ライセンスコストに加え、オンプレミスとハイブリッドクラウド・マルチクラウド間でのデータ送受信にかかるコストや、ハイブリッドクラウド運用に必要な人材コストも考慮する必要があります。これらの要素を総合的に評価し、オンプレミスでの運用コストを上回る場合、ハイブリッドクラウドの導入が適切か再検討するべきです。

データコンサルタント視点でのコスト分析

ライセンスコスト: 企業はクラウドベンダーが提供する割引を活用できますが、これだけでコスト削減が可能かどうかは慎重に評価する必要があります。特に、ライセンスの長期的な費用対効果や、サービスの更新時の変動に注意が必要です。

データ送受信コスト: ハイブリッドクラウドの利用では、オンプレミスとクラウド間でのデータ移動が頻繁になるため、送受信料金が大きな負担となることがあります。特に、大量のデータを扱う企業においては、このコストを最小化するためのデータ管理戦略が必要です。

人材コスト: ハイブリッドクラウドの運用には、オンプレミスとクラウドの両方に精通した専門家が必要です。これには追加のトレーニングや新たなスタッフの雇用が必要となり、人材コストが増加する可能性があります。

セキュリティとコンプライアンスの課題

ハイブリッドクラウド導入におけるセキュリティとコンプライアンスの要件も、企業が慎重に考慮すべき重要な側面です。特に業界や法制度によって、データ保管場所やアクセス権限が厳しく規定されている場合、クラウド導入のハードルとなることが多いです。

セキュリティとコンプライアンスへの対処法

データセットごとの要件の違い: Deloitte Consultingのデビッド・リンティカム氏によると、データごとに異なるセキュリティ・コンプライアンス要件に対応することが、ハイブリッドクラウド運用の大きな課題です。法規制によりデータを特定の国や地域に保管する義務があったり、クラウドサービスで必要なセキュリティ機能が提供されていなかったりする場合、オンプレミスでのデータ管理が必要になります。

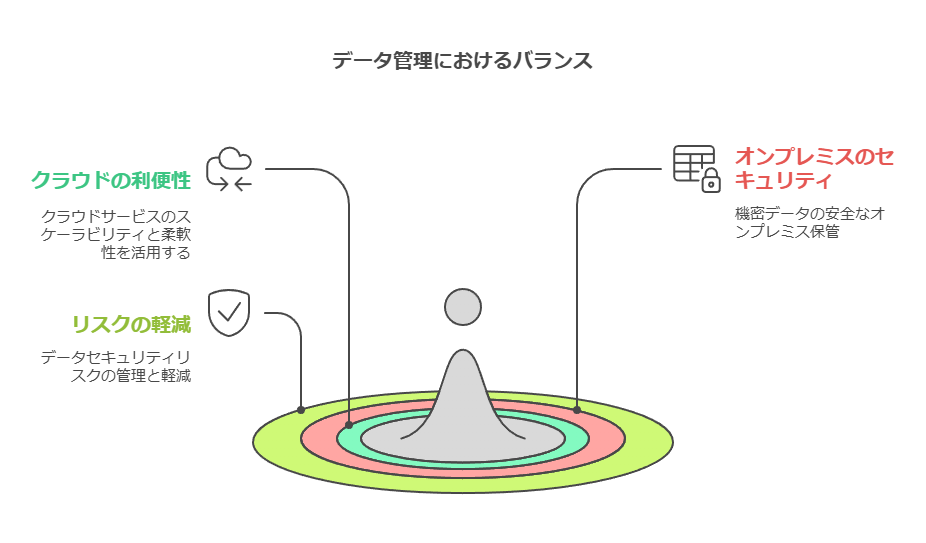

クラウドベンダーの対応: クラウドベンダーはセキュリティやコンプライアンス機能を改善しており、クラウドで扱えるデータの種類が増加しています。しかし、すべてのリスクを完全に解消することは難しいため、企業はクラウドの利便性とセキュリティのバランスをとる必要があります。特に、機密性の高いデータをオンプレミスに保持しつつ、クラウドのスケーラビリティや柔軟性を活用する戦略が求められます。

ハイブリッドクラウドの意義と導入ステップ

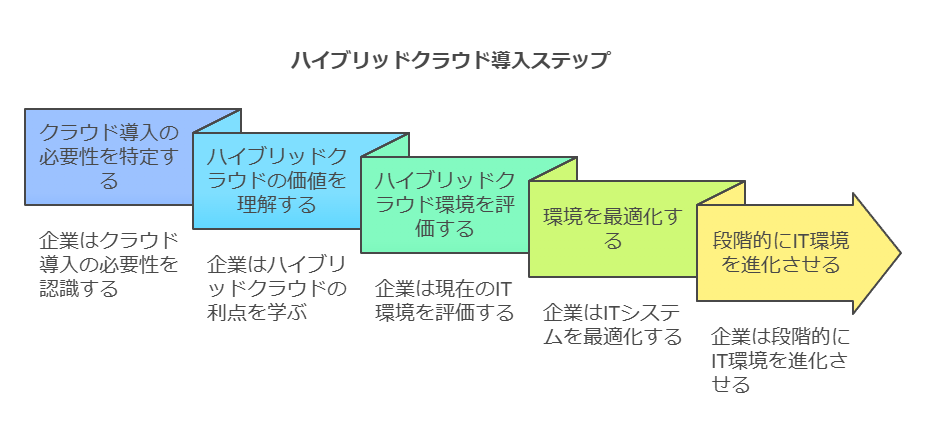

クラウド導入において、企業のIT環境は従来の「オンプレミスのみ」から「ハイブリッドクラウド」へと変化していきます。この変化は、単なるITインフラの移行ではなく、業務プロセスやデータ管理の根本的な再設計を伴います。

段階的導入のステップ: 企業は「クラウド導入への5ステップ」を通じて、段階的にIT環境を進化させることが求められます。このプロセスでは、特にハイブリッドクラウド環境の意義や価値を理解し、適切に評価・最適化することが重要です。

データコンサルタント視点: データの所在や利用方法を包括的に見直し、セキュリティやコンプライアンスの要件に対応しつつ、クラウドとオンプレミスの両方の強みを最大限に活かすためのデータ戦略を策定します。

結論

企業がハイブリッドクラウドを検討する際には、ライセンス、データ移動、人材など複数のコスト要因を慎重にバランスさせる必要があります。セキュリティとコンプライアンスに対処しつつ、クラウドの利便性を最大限に活用するためには、包括的な戦略と高度な専門知識が求められます。ハイブリッドクラウドは、リスクを管理しつつ効率的なITインフラの構築を支援する有力なソリューションとなりますが、企業ごとの状況に応じた最適な導入アプローチを見つけることが重要です。

ハイブリッド環境を使用したアプリケーションのワークロード効率化に期待するテックリーダー

多くのテックリーダーは、現在のアプリケーションワークロードの構成が、デジタルトランスフォーメーション(DX)のビジョンを実現するには十分ではないと感じています。調査では、半数以下のITリーダーが自社のインフラが俊敏性をサポートするに十分と回答し、わずか32%がアプリケーションとインフラの簡素化に成功していると述べています。これは、アプリケーションのワークロード効率が、合理的なコストと適切なタイムラインでいかにビジネス価値を推進するかに依存していることを示しています。

デジタルトランスフォーメーションの成功には、以下の4つの主要領域がビジネス価値に直結すると考えられています:

魅力的な顧客体験の創出

新たな顧客インサイトの導出

オペレーショナルパフォーマンスの向上

ビジネスプロセスの効率化

これらの領域で成功するためには、ワークロードの最適化が不可欠です。

アプリケーションワークロードの効率化を阻む障壁

アプリケーションのワークロード効率を最適化するにあたり、回答者はパブリッククラウド、プライベートクラウド、従来型インフラの利用における主な課題を特定しました。その結果、特定のインフラタイプに限らず、これらの課題がすべてのインフラに共通していることがわかりました。つまり、どのインフラを選択しても、すべてのワークロードニーズを満たすことはできず、ハイブリッドプラットフォームにワークロードを分散する必要があるのです。

回答者が特に指摘した課題は次の点に集約されます:

課題1:専門知識の不足

継続的なサポートには、高度な技術的専門知識が不可欠ですが、クラウドやインフラ全体をサポートするために求められるスキルは日々進化しています。技術的な進化に伴い、これらのスキルを持つ専門家の需要が急増しており、企業が対応するのはますます困難でコストがかかるようになっています。

Forresterの調査によると、2020年にはクラウドコンピューティング関連の求人が35万件以上あり、クラウド技術者に対する人材不足が深刻な課題となっていることが示されています。この傾向は今後も続くと予想され、クラウド利用が増加するに伴い、技術人材の確保が引き続き大きなチャレンジとなるでしょう。

データコンサルタントの視点:次のステップ

このような課題に対して、テックリーダーはインフラを選定する際にハイブリッドクラウド戦略を積極的に検討する必要があります。ハイブリッド環境は、各プラットフォームの特性を最大限に活用し、アプリケーションワークロードを効率的に分散させることができます。また、技術スキルの不足という課題には、自動化ツールの導入やマネージドサービスの活用が有効です。これにより、インフラの運用負担を軽減し、専門知識への依存を減らすことができます。

企業は、自社のビジネスニーズに合ったインフラの選定と効率的な運用を目指しつつ、今後の成長に向けて人材育成や外部リソースの活用を戦略的に進めていくことが求められています。

データコンサルタント視点から見る進化するアプリケーション環境とデータ駆動型運用

データコンサルタントの視点から見ると、組織のアプリケーション環境は絶えず変化しており、新しいアプリケーションのデプロイ、ツールやプロセスの更新に伴い、継続的にデータとトランザクションを生成するサイクルが生まれています。これらのアプリケーションが最終的にサポートするプロダクションワークロードは、生成・活用するデータを通じて、組織の従業員、パートナー、およびエンドユーザーに具体的なビジネス価値をもたらす源泉となります。アプリケーションは単なる機能の集合体ではなく、データ生成・活用のエコシステムとして捉えるべきです。

生成AIによるデータ活用の拡張:エッジとクラウド

生成AI技術の恩恵をクライアントに提供する際には、ローカル(スマートデバイス上、エッジ)とクラウドの両環境でのデータ処理・分析の可能性をデータ視点から検討することが重要です。モデル圧縮技術の進化は、個人のスマートデバイス上でのデータ処理(推論実行)を可能にし、プロンプトベースのインタラクションに留まらず、ユーザー行動データの分析に基づくUXの最適化など、多様な実行形態でのデータ活用を可能にします。デバイス上での閉じた形での推論実行は、ユーザーの許諾なしにいかなるデータもデバイスの外に持ち出されないという、データプライバシーとデータガバナンスの観点から重要な特徴であり、特定のデータ要件を持つユースケースに適しています。

データ量の増加と管理の複雑性に対するデータ駆動型自動化

データの増加速度と、モダナイズされたワークロードおよびハイブリッドITインフラストラクチャの管理の複雑性は、IT管理者にとって非生産的な繰り返し作業(運用工数データ)の増大を招いています。この課題に対処するためには、データ駆動型自動化を積極的に推進し、運用データ分析に基づいて自動化プロセスを継続的に最適化する必要があります。これにより、IT管理者はより戦略的かつ革新的なデータ関連業務にリソースを振り向けられるようになります。同時に、予知が困難なリアルタイムで発生する要求(データスパイク、セキュリティイベント、インフラ障害など)に対しても、運用データに基づいた迅速な対応能力が求められます。データに基づいたアラート、予測分析、および自動化された対応ワークフローの構築が不可欠です。

ハイブリッドクラウド導入を見据えたデータインフラストラクチャ戦略

現時点でまだハイブリッドクラウド環境に移行していない組織であっても、今後その導入を予定している場合、データコンサルタントとしては、ITインフラストラクチャのソリューションを、将来のハイブリッドクラウド環境でのデータ管理(データ収集、処理、移行)を想定して構築することを強く推奨します。これは、クラウド環境と非クラウド環境にまたがるデータの一貫性、共通のデータ監視・管理パラダイム、シンプルかつ効率的なデータの移行(データパイプラインの構築)、およびパブリッククラウドの幅広いデータサービスサポートが必要となるためです。ベンダーのロードマップが、進化するハイブリッドクラウド環境におけるデータ管理の要件(例: 分散データのカタログ化、データ連携APIの提供など)に連動しているかどうかも評価すべき重要なポイントです。

グローバルな管理インテリジェンスとデータサイロの解消

ハイブリッドクラウド環境を最も効果的に管理しようとするIT組織にとって、管理インテリジェンスの「サイロ化」は深刻なデータ管理上の課題となります。異なる環境から取得される運用データ(センサーデータやその他の監視データ)が個別のシステムに分散し、統合的に分析できない状況は、全体的なデータに基づく状況把握や運用最適化を妨げます。

データコンサルタントとしては、これらの運用データをクラウドと非クラウドのロケーションから一様に収集し、AI/MLを活用したデータ分析を行い、ローカルのサイロだけでなく、ハイブリッドクラウド構成全体で管理推奨事項を最適化する中央リポジトリに保存することを推奨します。クラウドベースの予測分析プラットフォームは、この運用データ分析課題に対する理想的なソリューションであると考えられます。しかし、効率を最適化するためには、ストレージ層だけでなく、サーバー、ネットワークデバイスといったその他のインフラストラクチャハードウェアやソフトウェア、およびパブリッククラウド環境から生成される運用データも含め、幅広い種類のデータを収集・統合する必要がある点を強調します。これは、データ統合、運用データ分析、および予測分析によるデータに基づいた運用最適化、そしてデータガバナンスの確保に不可欠です。

データコンサルタント視点から見るデジタルビジネス要求とデータ駆動型運用変革

データコンサルタントの視点から見ると、デジタルビジネスのスピードと適応性に対する要求は、組織のIT運用目標、すなわちデータ可用性、データレジリエンス(回復力)、データセキュリティの向上、および運用コストの継続的削減という目標との間に典型的なジレンマを生み出しています。これは、限られたリソース(コストデータ、運用工数データ)の中で、データ保護・データ復旧能力を高めつつ、システムのスケーラビリティとセキュリティをデータに基づき確保し、かつ迅速な変化に対応する必要があるという、現代のデータ運用における根深い課題です。

データ分析に基づく変革プロジェクトの開始

この複雑な課題に対処するため、Red Hat ITが変革プロジェクトを開始するにあたり、徹底的な「データ分析」を行った点は注目に値します。Open Innovation Labsチームとの連携を通じて、組織が抱える運用コスト高やシステム非効率性など、運用データに基づいた具体的なビジネス上の課題を特定し、それらをテクノロジーとプロセス変更によって解決するためのオプション、喫緊の問題に対処するための選択肢、およびデータ運用プロセスの長期的・継続的な改善に向けたロードマップに関して、「包括的なデータに基づいた洞察」を獲得しました。これは、データ駆動型の意思決定が組織変革の強力な起点となりうることを示す好事例です。

データ分析に基づく変革の内容:データ基盤と開発手法の最適化

このデータ分析の結果として促進されたRed Hat ITのプロセス変化は、データ基盤とデータ活用・開発手法の最適化に焦点を当てています。

ハイブリッドクラウド・インフラストラクチャへの転換: マルチロケーションに展開していたオンプレミスのフェイルオーバー・インフラストラクチャからハイブリッドクラウド・インフラストラクチャへの転換は、データ資産の最適な配置、データモビリティの向上、および地理的なデータ分散によるデータレジリエンス強化を目的としています。パブリッククラウドゾーンを当初の1プロバイダーから2つの異なるプロバイダーへと拡大したことは、特定のベンダーへの依存(ベンダーロックインリスク)を軽減し、データ処理環境の多様性を高める戦略です。

コンテナベースのクラウドネイティブ開発への移行: コンテナをデプロイメントの主要ユニットとして使用するモードへの移行は、アプリケーションとそれに付随するデータ処理ロジックの標準化されたパッケージングを可能にし、データデプロイメントとスケーラビリティ(データ量や処理要求に応じたリソース拡張能力)の向上に貢献します。

ソフトウェア開発テクノロジーおよび手法の変更: 各アプリケーションのニーズに応じて多種多様なプログラミング言語を使用できるようにしたことは、特定のデータ処理要件やデータ分析タスクに最適な言語を選択できる柔軟性の向上を意味します。アプリケーション・プログラミング・インタフェース(API)導入の増加と、これらのアプリケーションを接続する手法としてのアジャイル統合は、異なるシステム間のデータ連携の標準化と効率化、およびデータパイプラインの柔軟かつ迅速な構築・変更を可能にするものです。

運用コスト削減と信頼性向上: コンテナの使用によるコスト削減は、リソース利用効率の向上に伴う運用コストデータの削減として測定できます。また、稼働系と代替系の2系統を使用したフェイルオーバー体制からActive/Active/Activeクラスタ体制への移行は、データ可用性・信頼性データ(RTO/RPO短縮、サービス中断時間削減)の劇的な向上と、更新の迅速化(運用効率データ向上)に貢献しています。

変革による観測可能・測定可能な成果

このデータ分析に基づいた変革は、2021年9月時点で当初の目標を上回る成果をデータとして観測・測定されました。しかも、このプロセスは新たな課題や機会に応じて進化し続けており、データに基づいた継続的な改善文化が根付いていることを示唆しています。具体的な成果データとしては、アプリケーションあたりの測定可能なフットプリント(各アプリケーションが使用するリソースデータ:CPU,メモリ,ストレージ)を55%以上削減したことに加え、コンテナ化されたアプリケーションがポートフォリオの35%を占めるようになり、オンプレミスリソースの29%を廃止することで技術的負債(古いシステムに紐づく保守コスト高、データ連携困難性といったデータ関連の負債)が削減されました。物理的なインフラストラクチャにおいても、機器を設置するラックが150から約20に大幅に減少し、全体としてアプリケーションのホスティングに使用するベアメタルサーバーが大幅に減少したことは、データ処理基盤の集約と効率化に伴う具体的なインフラコストデータ削減を示しています。これらの測定可能な成果データは、データ駆動型の変革がビジネス目標達成に大きく貢献したことを明確に証明するものです。

データコンサルタント視点から見るハイブリッドクラウド導入におけるデータ管理の課題と変革

ハイブリッドクラウド環境の導入は、組織のデータ管理戦略において大きな変革をもたらしますが、同時にいくつかのデータ管理上の課題や難しさを伴います。データコンサルタントの視点から見ると、主な課題は以下の点に集約されます。技術的な課題としては、異なるオンプレミス環境とクラウド環境間でのデータ接続・連携、データ移行、および運用データの収集・統合といったデータパイプラインとデータ統合の複雑性が挙げられます。コスト面では、異なるクラウドプロバイダー間のデータ転送コスト、多様な課金モデルの管理、およびデータ保管場所に応じたコスト最適化の難しさといったコストデータ管理の複雑性が問題となります。セキュリティ管理の難しさは、分散するデータ資産に対する一貫したデータセキュリティポリシーの適用、データアクセス制御の一元化、およびログデータ収集・分析に基づく脅威検知の課題といったデータガバナンスとデータセキュリティの観点から重要です。また、ハイブリッド環境におけるデータ管理、データ分析、およびセキュリティに関する専門知識を持つデータ人材の確保と育成は、人材データおよびトレーニングデータに関する課題となります。導入までの時間は、データ移行計画策定・実行、および分散データ管理ツールの導入にかかる時間として考慮が必要です。

ハイブリッドクラウド導入に際して必要なデータ管理関連サポート

ハイブリッドクラウド導入に際しては、データ管理の観点から以下のようなサポートが必要となります。技術的なサポートは、異なる環境間でのデータ接続設計、データ移行計画策定、およびデータ統合ツール導入に関する支援として提供されます。運用支援としては、分散するデータ資産の監視、管理、およびデータ復旧プロセスを含むマネージドサービスによるデータ運用効率化の支援が有効です。セキュリティ上の支援は、ハイブリッド環境におけるデータセキュリティポリシー策定、データアクセス制御設定、およびログデータ分析に基づく脅威検知・対応に関する専門的な支援として提供されます。人材研修や教育体制構築支援は、ハイブリッド環境でのデータ管理やセキュリティに関するスキルギャップを埋めるためのトレーニング提供として、組織のデータ活用能力向上に貢献します。主要なクラウドサービスの統合またはマネジメント支援は、異なるクラウドプロバイダー上に分散するデータ資産の統合的な管理、データ移行、および運用データ収集・分析に関する支援として、データ管理の複雑性軽減に寄与します。

ハイブリッドクラウド環境が提供するデータ管理上の利点

複数のオンプレミスの場所を備えたハイブリッドクラウド環境は、データ管理の観点から以下の点で大きな利点を提供します。

場所間でのデータエクスペリエンスの一貫性: 同じオペレーティングシステムバージョンやパッチレベルといったシステム要素を可能な限り多くの環境で利用できる点が、異なる場所に分散するデータ処理環境の標準化を促進し、データ管理プロセス(データ収集、処理、デプロイメント)の一貫性を高めます。これにより、データ管理の運用効率が向上します。

オンプレミス、仮想化、プライベートおよびパブリッククラウドシステム全体のデータ統合管理: ITインフラストラクチャ全体(異なる場所に分散するデータ資産)を同じ方法でより簡単に追跡、監視、管理できる点を、データ統合管理の観点から説明できます。これは、運用データ収集とデータ可観測性を向上させ、データに基づいた迅速な意思決定を支援します。

データセキュリティとコンプライアンスの制御: さまざまなクラウドとデータセンターにデータが分散・増加している場合でも、一貫したデータセキュリティポリシーの適用、データアクセス制御、およびコンプライアンス(規制遵守に関するデータ)の制御を維持することが引き続き重要です。ハイブリッド環境は、これらのデータガバナンス要件を満たすためのデータ管理機能を提供します。

安定性、アジリティ、データ可用性の向上: インフラストラクチャ拡張の目的がフェイルオーバーと冗長性のために容量を追加することにある場合、これらのデプロイメントに対して一貫したデータ管理アプローチを取ることが重要です。一貫性がない場合、特定の「外れ値」環境(異なる構成や管理方法の環境)がデータ保護の信頼性を損なう(データ損失リスク、データ復旧失敗リスク)可能性があり、データ可用性とデータレジリエンスに悪影響を与えます。一貫したアプローチは、データ可用性とデータレジリエンスを向上させるために不可欠です。

コンテナとコンテナプラットフォームによるハイブリッドクラウドデータ管理の変革

複数のクラウド環境にわたる一貫したプラットフォームの作成に加え、ここ数年、コンテナとコンテナプラットフォームの使用が、ハイブリッドクラウドにおけるデータ管理とデータデプロイメントの新たな優先事項として浮上しています。コンテナは、アプリケーションとそれに付随するデータ処理ロジック、および実行に必要なすべてのファイル(データ)をパッケージ化して分離するため、データデプロイメントの単位として優れています。コンテナプラットフォームを介した迅速なデプロイメントと容易な管理により、コンテナプラットフォームが利用可能な場所であればどこでも、アプリケーションインスタンスとそれに付随するデータ処理機能をデプロイ、更新、拡張できます。コンテナとコンテナプラットフォームは、ハイブリッドクラウド上のクラウドネイティブ・コンピューティングのビジョン、特に分散データ処理とデータデプロイメントの柔軟性を真に実現するものです。

ハイブリッドクラウド環境では、コンテナプラットフォームを使用すると、すべてのデータセンターとクラウド環境で、データ処理のためのコンピュータ環境に一貫性を持たせることができます。

各場所に同一のコンピューティング・インフラストラクチャ提供: 基盤となるリソース上に抽象化レイヤーを作成し、データ処理のためのコンピューティング環境をどこでも再利用可能で一貫性のあるものにします。

パッケージ化されたコンテナの修正なしでの実行: アプリケーションとそれに付随するデータ処理ロジック、およびデータを含むパッケージ化されたコンテナを、修正なしでハイブリッドクラウド環境内のどこでも実行できる点が、データデプロイメントとデータモビリティの柔軟性を高めます。

運用チームによる分散データ処理ワークロードの確認: 運用チームがさまざまなコンテナクラスタ全体で実行されているデータ処理ワークロード(リソース使用状況、パフォーマンスデータ、エラーログなど運用データ)を確認できる点が、分散データ処理環境のデータ可観測性を向上させ、データに基づいた運用監視を可能にします。

各場所でのリソーススケーラビリティサポート: コンテナプラットフォームが、データ量や処理要求に応じて各場所でデータ処理リソースのスケーラビリティをサポートします。

KubernetesベースのRed Hat OpenShift®は、上記のようなデータ管理とデータデプロイメントに関連する機能(抽象化レイヤー、コンテナ実行環境、運用データ可観測性、リソーススケーラビリティなど)を提供します。現在のハイブリッドクラウド環境では、Amazon Web Services (AWS)、Google Cloud Platform、およびMicrosoft Azureといった主要なパブリッククラウドのそれぞれでホストされているオファリングを組み合わせて使用することが可能であり、これは異なるクラウド上のデータ資産との連携や、データモビリティの実現に貢献します。ハイブリッドクラウドでのコンテナ使用に関する詳細情報は、データコンサルタントが提供する資料に記載されています。

データコンサルタント視点から見るマルチクラウド/ハイブリッド環境におけるデータセキュリティの課題とデータ駆動型保護

クラウドアーキテクチャの採用は、組織のデータ活用においてトランスフォーメーションを実現し、柔軟性、効率性、スピード、イノベーションを加速させるメリットをもたらします。しかしながら、データコンサルタントの視点から見ると、これらの利点は同時にいくつかの新たなデータセキュリティ上の課題を生み出します。クラウド環境は本質的に複雑で動的であるため、分散し変化し続けるデータ資産に対する構成エラー、脆弱性、および脅威からの適切なデータ保護を従来のセキュリティアプローチで実現することは困難です。

Amazon Web Services (AWS)、Google Cloud、Microsoft Azure、Kubernetesといった複数のクラウドプロバイダーやオーケストレーションプラットフォームを組み合わせるマルチクラウド/ハイブリッドインフラストラクチャにおいて、最も重要なのは、これらの環境に保管・処理されるデータ資産と、それらが配置されるワークロードおよびアカウントをデータに基づき保護することで、ビジネスのデータ継続性を確保することです。Laceworkのようなソリューションは、自動化されたエンドツーエンドのセキュリティデータ収集・分析を提供し、グローバルかつ安全で信頼できるデータ環境を実現することで、これらの課題解決を支援する役割を果たします。これにより、マルチクラウドやコンテナ化された環境のワークロードやアカウントに対する脅威をデータに基づいて監視し、データとリソースを安全な状態に保つことができます。

マルチクラウドにおけるデータリスクと運用効率データへの影響

マルチクラウド環境のセキュリティを優先すべき理由は数多く存在しますが、データリスクと運用効率データの観点から見ると、その重要性はさらに増します。サイバー攻撃は、ビジネス上の損害やデータ損失といった直接的なデータリスクを引き起こし、結果として運用コストデータが増大し、顧客の信頼度データが失われる可能性があります。どのような規模のセキュリティチームであっても、分散するデータソースからのセキュリティ関連データを手動で収集・監視することは時間がかかり、貴重な運用工数データを浪費する恐れがあります。さらに、業界に適用される法規制や顧客からの要求によって、コンplianceをデータに基づき継続的に証明する必要がある場合は、関連するコストデータが増大し、多くの運用時間データを費やすことになる可能性を示唆します。

Laceworkのようなソリューションは、これらのニーズに対応し、データ駆動型セキュリティを高度化する支援を提供します。真の脅威データ(不正なデータアクセスパターン、マルウェアデータなど)をデータ分析によって自動的に発見し、データ分析に基づかない誤検知やアラートデータ量を減らすことで、セキュリティ担当者が真のリスクデータに注力できるようにします。これにより、リスクをデータに基づき未然に防止できるようになります。また、強力なデータ保護機能を提供しつつ、ソリューション自体のメンテナンスにかかる運用コストデータを最小限に抑える点をメリットとして挙げられます。

構成評価とデータ可視性の向上

マルチクラウド環境のすべての資産(データが配置されるリソース、ワークロードなど)に関するデータの検索、監視、インベントリ作成を自動化することを可能にすることで、組織のクラウド構成をデータに基づき正確に理解できるようになります。Laceworkのような単一のプラットフォームを活用して構成変更データ、脆弱性データ、および脅威データ(関連ログ)を容易に追跡し、データ分析することで、構成の評価プロセスがデータ駆動型かつ効率的になります。クラウドプロバイダーの個別コンソールにアクセスすることなく、チームメンバー全員が利用できる統合ビューは、分散するセキュリティ関連データの「データ可視性」を向上させる上で極めて有効な機能です。

クラウドおよび業界コンプライアンスの監査におけるデータ活用

Laceworkのようなソリューションは、クラウド環境および業界固有の規制に関するコンliance監査に必要なデータ(構成データ、アクティビティログ、セキュリティイベントデータなど)を自動的に収集・管理し、データに基づいたコンlianceレポート作成を支援する機能を備えています。これにより、コンpliance遵守をデータに基づき証明し、監査証跡データを提供することが容易になります。データコンサルタントとして、このようなデータ管理機能を持つセキュリティソリューションは、コンpliance遵守と監査プロセス効率化の両面で組織に貢献できると評価します。

データコンサルタント視点から見るテクノロジー変革、データ活用、そしてITインフラ戦略

データコンサルタントとして、テクノロジー変革がもたらすイノベーションの増大を日々観測しています。デジタル・トランスフォーメーション(DX)や事業戦略の遂行を支えるITインフラ(データ処理・保管基盤)の活用や刷新への取り組みは、ユーザー調査データからもその現状と課題が明らかになっています。これらの課題に対処するためには、データコンサルタントの視点からの詳細な分析と、データに基づいた適切なITインフラ戦略の選択が不可欠です。

お客様アンケート結果に見るデータ管理と運用の効果

お客様アンケート結果は、特定のセキュリティソリューション(Laceworkのようなツールを想定)の導入が、データ管理、運用効率、コスト、リスク、およびデータ活用の側面において具体的な成果をもたらしていることを示しています。

コスト削減とセキュリティベンダー統合: データ管理ツールやセキュリティベンダーの統合は、データ管理にかかるコストデータ削減効果に貢献しています。

マルチクラウド環境の詳細なデータ可視化: 分散するデータ資産やワークロードに関するセキュリティ関連データの可視性が向上し、データに基づいた状況把握が可能になりました。

アラート調査速度向上と生産性向上: セキュリティアラートデータ分析にかかる時間が以前より4倍速くなったというデータは、運用担当者の運用工数データ削減と全体的な生産性データ向上に繋がった効果を示しています。

ビジネス価値拡大とコンプライアンス監査準備: セキュリティ強化によるビジネス活動上のリスクデータ低減が、新たなビジネス機会創出や既存ビジネスの拡大といったビジネス価値データ拡大に貢献し、コンプライアンス監査に必要なデータ収集・管理の準備が容易になった点を評価できます。

セキュリティ開発プロセス組み込みによるリスク低減: セキュリティ対策を開発ライフサイクルに組み込むことで、アプリケーションに起因するセキュリティ脆弱性データやデータ侵害リスクデータを早期に発見・低減できた効果は、データリスク管理の観点から非常に重要です。

特定のユーザーからのコメントにも、マルチクラウド環境へのデータ移行やデータ処理環境の拡大が進んでいる現状が示されています。この拡大に伴い、異なるクラウド環境へのソリューション展開が運用工数データに与える影響をデータに基づき測定することに関心が寄せられています。ソリューションが、組織のデータ戦略(クラウド利用拡大)が正しいことを示す「証拠データ」(セキュリティ強化、運用効率向上といったデータ)を提供することに期待している点は、データに基づいた効果測定の重要性を物語っています。「Azure を導入した段階で作業時間がどれ位短縮できるか、興味深いところです。 Lacework が Azure クラウドを保護するガイダンスとなり、 自分たちの選択が正しいことを示す証拠を提供してくれることでしょう。」というコメントは、特定のクラウド環境におけるデータ保護が運用効率データに与える影響を定量的に把握し、データに基づいた意思決定の正当性を裏付けたいというニーズを示しています。

ハイブリッドクラウド環境の構築に向けたデータインフラストラクチャの選択肢

本調査レポートでは、テクノロジー変革がイノベーションの増大をもたらしつつある現在、デジタル・トランスフォーメーション(DX)や事業戦略の遂行を支えるITインフラ(データ処理・保管基盤)の活用や刷新における現状の課題について、ユーザー調査データの結果を踏まえて詳細に分析しています。その上で、高信頼/高可用かつ高いセキュリティ機能を実装したLinux専用オープンハイエンドシステムであるIBM LinuxONEのようなプラットフォームが、大量データのバッチ処理やミッションクリティカルなデータ処理など運用データに基づいた特定の課題を持つITバイヤーにとって、新たなデータインフラストラクチャの選択肢となり得るかをデータ視点から考察しています。これは、ワークロード特性とデータ要件に基づいた最適なデータ処理基盤を選択する上での重要な示唆となります。

テクノロジー変革がもたらすデータ活用とイノベーションの増大

クラウドを始めとする「第3のプラットフォーム」が世界のICT市場に現れてから10年余りが経過し、その市場規模は国内でも従来型ITである「第2のプラットフォーム」をデータ量および投資規模の観点から上回るようになりました。そして、単にその規模が拡大しただけでなく、AI(人工知能)、IoT(モノのインターネット)、ロボティクス、AR/VR(拡張現実/仮想現実)といった新たなテクノロジーと密接に結び付いています。データコンサルタントの視点から見ると、これらのテクノロジーは膨大な種類のデータを生成・活用し、企業や社会におけるデータに基づいたイノベーションを飛躍的に拡大させようとしています。多くの企業が社内外のアイデアとデータを集約するためにエコシステムを形成し、大規模なデータ共有とその収益化(データマネタイズ)を加速させている現状は、データがビジネスの中心となりつつあることを示しています。さらに、2020年には5Gの商用サービスが開始されました。5Gはデータ活用の範囲を大幅に広げ、データ収集・分析やサービス提供の処理速度を格段に高速化する新技術として、これまでのビジネスプロセスをデータ駆動型に変革するばかりか、新たなビジネスモデルを生み出す原動力となる可能性をデータ視点から展望できます。これは、データコンサルタントとして、お客様のデータ戦略策定と実行を支援する上で常に考慮すべき重要なトレンドです。

データコンサルタント視点から見るマルチクラウド/ハイブリッド環境のデータセキュリティ管理

マルチクラウドおよびハイブリッドクラウド環境の導入は、組織のデータ活用に変革をもたらす一方で、その本質的な複雑性と動的性から、データセキュリティ管理において新たな課題を生み出しています。従来のセキュリティアプローチでは、分散し継続的に変化するデータ資産に対する構成エラー、脆弱性、および脅威からの適切なデータ保護をデータに基づき実現することが困難です。

Laceworkのようなソリューションは、データコンサルタントの視点から見て、これらの課題解決をデータ駆動型アプローチで支援します。Amazon Web Services (AWS)、Google Cloud、Microsoft Azure、Kubernetesといった多様なクラウド環境におけるデータ保護において、ワークロードやアカウントに関連するセキュリティデータを自動的に収集・分析し、グローバルかつ安全で信頼できるデータ環境の実現に貢献します。

構成評価と継続的なデータコンプライアンスチェック

Laceworkは、組織のクラウド環境における構成データをデータ分析に基づき継続的に評価し、業界標準(SOC2、ISO 27001、HIPAA、HITRUST、PCI、NIST、FISMA、PII、CIS Benchmarksなど、コンplianceに関連するデータ)に照らして自動的にチェックできる機能を備えています。構成データの変更を日次で監査し、問題のある変更があればデータに基づいたアラートで通知することで、マルチクラウド環境における継続的なコンplianceをデータに基づき可能にします。PDFやCSV形式でのレポート生成機能は、監査に必要なデータ(構成データ、コンpliance違反データ、修復状況データなど)を提供し、コンテキストリッチな提案は、データに基づいた改善策の提示を支援します。JiraやSlackなどのツールとの統合は、修復作業に関連するデータ(課題、ステータス、担当者など)の連携を効率化し、データに基づいたワークフロー管理を支援する機能として有効です。

AWS、Google Cloud、Azure向けの最新CISベンチマーク提供は、主要なクラウド環境におけるセキュリティ態勢をデータに基づき評価し、セキュリティの経過的な改善を測定するための基準データを提供します。コンテナイメージの開発やコンテナのデプロイ段階でのスキャンは、データ保護とセキュリティ対策を開発ライフサイクルの早期に組み込むことの重要性を示唆する機能です。

脅威検知におけるデータ分析と異常検知

LaceworkのPolygraphによる異常検知機能は、マルチクラウド環境におけるデータ分析に基づいた脅威検出の中核を担います。アラートノイズ(誤検知データ)を低減し、最も重要なセキュリティイベントデータのみを特定することで、セキュリティ担当者が真のリスクデータに注力できるようにします。運用データ(データセンターの振る舞い)のベースラインモデルをデータ分析に基づき自動的に構築・更新し、実用的なアラートは、異常なデータパターン(外部IPアドレスとの通信開始など、通常のデータフローから逸脱した振る舞い)に関するデータを提供することを意味します。自動検知によりルールの記述が省略される点は、データ分析モデルによる自動化のメリットであり、必要に応じてカスタムポリシー(特定のデータパターンに対する検知ルール)を柔軟に作成できることも重要です。

脆弱性管理における脆弱性データ分析とリスク評価

Laceworkのエンドツーエンド脆弱性管理機能は、ホストおよびコンテナに関する脆弱性データ(既知の脆弱性情報、システム構成情報、脅威インテリジェンスデータなど)の早期発見とプロアクティブな管理を支援します。コンテナイメージやホストに存在する新しい脆弱性データだけでなく、既存の脆弱性データの変化(リスクレベルの上昇など)も継続的に評価する点を強調します。マルチクラウド環境に最大のリスクをもたらす脆弱性が特定された場合に提示されるリスクスコアは、脆弱性データをリスクレベルに変換し、データに基づいた対応優先順位の設定に役立つ機能です。

Laceworkを選択する理由:データ駆動型セキュリティのメリット

データコンサルタントとして、Laceworkのようなソリューションを選択する理由を、データ保護、セキュリティ運用、およびリスク管理の観点から以下のように評価します。

継続的な監視による脆弱性評価: ビルド段階とランタイム段階の両方で脆弱性データとランタイムアクティビティデータを継続的に監視し、脆弱性データを評価できる点は、セキュリティリスクを早期に特定する上で重要です。

データ分析によるランタイム異常検知(ルール不要): ルール定義なしに、ランタイムにおける異常なアクティビティデータ(データアクセスパターン、通信パターンなど)をデータ分析(AI/ML活用)によって検知できる点は、未知の脅威に対する検出能力を高めます。

データ可視化による調査迅速化: Polygraphのビジュアル表示が、特定のセキュリティイベント発生前、発生中、発生後のデータ(関連ログ、システム状態、ネットワークアクティビティなど)を時間軸に沿って可視化することで、インシデント調査にかかる時間(運用効率データ)をデータに基づき短縮できる点は、運用上の大きなメリットです。これは、データ可視化とデータ分析による調査効率化を示唆します。

これらの機能は、マルチクラウド/ハイブリッド環境におけるデータセキュリティ、データガバナンス、コンpliance、運用効率をデータ駆動型アプローチで改善するための基盤を提供します。