目次

- 1 データ駆動型ビジネスを阻害するクラウドコストの構造課題とエッジコンピューティングによる解決アプローチ

- 2 データが示す必然的トレンド:クラウド・イノベーションの主戦場は「エッジ」

- 3 エッジコンピューティング時代の「データ整理」戦略:現場で生まれる情報を活かすために

- 4 日本企業におけるエッジコンピューティングと「データ整理」の実践:現場主導のDXを支える情報基盤とは

- 5 海外企業におけるエッジコンピューティングと「データ整理」の最前線:グローバルDXを支える情報戦略とは

- 6 中小企業におけるエッジコンピューティングと「データ整理」のすすめ:現場力を高める情報整備の第一歩

- 7 大企業におけるエッジコンピューティングと「データ整理」の戦略的重要性:分散する現場データを統合し、経営判断につなげる

- 8 製造業におけるエッジコンピューティングと「データ整理」の重要性:スマートファクトリーを支える現場データの整備戦略

- 9 非製造業におけるエッジコンピューティングと「データ整理」の重要性:リアルタイムな現場判断を支える情報基盤とは

データ駆動型ビジネスを阻害するクラウドコストの構造課題とエッジコンピューティングによる解決アプローチ

1. 分析:顕在化するクラウドコストの予測不能性と運用負荷

Web配信における動画やAIの活用が標準化するにつれ、トラフィックの量と質は爆発的に増大し、その予測は極めて困難になっています。この状況は、従来のクラウド運用モデルに対して2つの大きな課題を突きつけています。

第一に、「コストの指数関数的な増加と予測不能性」です。ユーザートラフィックの増加に加え、特にAI・機械学習モデルの導入は、コンピューティングリソースへの要求が大きく、クラウド利用料金を計画値以上に押し上げる主要因となっています。柔軟な拡張を前提としたクラウドアーキテクチャが、逆にコストの変動要因となり、予算策定の精度を著しく低下させています。

第二に、「データに基づかない場当たり的な運用によるリソースの非効率化」です。複雑化するインフラに対し、データに基づいた最適化が行われないままスケーリング設定やトラブル対応に追われることで、人的リソースが浪費されています。この運用負荷は、本来注力すべきデータ活用戦略の策定や、新たな価値創出活動を直接的に阻害します。

これらの課題は、ビジネスの成長スピードに対して、インフラコストと運用体制が持続可能ではない状態に陥っていることを示唆しています。

2. 戦略提言:データ処理アーキテクチャの変革

上記課題の抜本的な解決には、中央集権的なクラウド処理モデルからの脱却、すなわちデータが発生する源泉に近い「エッジ」でデータ処理を行うアーキテクチャへのシフトが有効な戦略となります。

このアーキテクチャ変革を実現する具体的なソリューションが、サーバレス型エッジコンピューティング基盤「Fastly Compute」です。

3. 期待効果:コスト構造の最適化とデータ活用の高度化

Fastly Computeの導入は、コストとデータ活用の両面に、定量的かつ構造的な改善をもたらします。

コスト構造の最適化:

オリジンサーバへのリクエストをエッジで処理することで、データ転送コスト(Egress)と中央クラウドのコンピューティングコストを直接的に削減します。また、アクセス集中に対する自動的なスケーリングにより、過剰なリソース確保が不要となり、実トラフィックに連動したコストの平準化を実現します。

データ処理の高速化と新たな価値創出:

ユーザーに最も近い物理的拠点でデータを処理するため、レイテンシが劇的に改善されます。これにより、リアルタイムでのパーソナライゼーション、不正アクセス検知、A/Bテストの高速な結果分析など、これまで技術的・コスト的に困難だったデータ活用が可能になります。

エンジニアリングリソースの最適配置:

サーバ管理やスケーリングといったインフラ運用業務から解放されることで、エンジニアは本来注力すべきアプリケーションロジックの実装や、データからインサイトを抽出するより付加価値の高い業務へリソースを再配分できます。

4. ユースケース:データフローの観点から見た具体的な活用法

Fastly Computeは、データフロー全体を最適化する観点で活用できます。

リアルタイムログ分析: エッジでログデータを収集・フィルタリング・前処理することで、分析基盤(DWH/データレイク)へ投入するデータを軽量化し、分析クエリのパフォーマンス向上とコスト削減に貢献します。

AI/MLの前処理: クラウド上のAIモデルが要求する形式にデータを整形・変換する処理をエッジで実行します。これにより、オリジンサーバの負荷を軽減し、モデル推論の応答速度を向上させます。

動的データ活用基盤: S3互換ストレージと連携し、エッジで生成したデータを活用することで、ユーザー属性や行動履歴に基づいた動的なコンテンツ配信やAPIレスポンス生成を、低コストかつ高速に実現します。

これらのユースケースは、Fastly Computeが単なるインフラ効率化ツールではなく、データ活用のROI(投資対効果)を最大化するための戦略的基盤であることを示しています。コストと運用の両面からデータ処理基盤を再設計し、持続可能なビジネス成長を実現するための具体的な手法と事例をご紹介します。

データが示す必然的トレンド:クラウド・イノベーションの主戦場は「エッジ」

「IoTプロジェクトが期待した成果を上げていない」。その原因は、アーキテクチャの前提、特にデータ処理の場所に起因している可能性があります。2025年以降のデータ戦略を語る上で、生成されるデータの爆発的な増加と、ビジネス価値を左右する「リアルタイム性」という2つの不可逆的なトレンドを無視することはできません。

データアナリストの視点から見ると、クラウド中心の従来型アーキテクチャは、データの「重力」によって限界を迎えつつあります。本稿では、なぜエッジコンピューティングが単なる技術選択肢ではなく、データ駆動型ビジネスにおける必然的な進化であるのかを、定量的なデータと分析に基づいて解説します。

トレンド1:指数関数的に増大するデータと、クラウド転送の限界

全てのデータを一度クラウドに集約し、処理・分析するというアプローチは、物理的な制約に直面しています。IDCの予測によれば、2025年までに世界で生成されるデータ量は約180ゼタバイト(ZB)に達するとされています。特に、工場、店舗、輸送機関、医療現場などの「エッジ」で稼働するIoTデバイスやセンサーが、このデータ爆発の主要な源泉です。

この膨大なデータをすべてクラウドに送信することは、以下の点で非効率性を生み出します。

ネットワーク帯域の逼迫とコスト増大: 大量のデータを常にクラウドへ転送するための通信コストは、プロジェクトのROIを著しく悪化させます。

遅延(レイテンシー)の発生: データが物理的に離れたデータセンターと往復する時間(レイテンシー)は、ミリ秒単位の応答性が求められるアプリケーションにおいては致命的です。

エッジコンピューティングは、この問題に対する明確なデータ駆動型の回答です。データが発生した場所(エンドユーザーやデータソース)の近傍で一次処理を行うことで、クラウドに送信するデータを「分析価値の高い情報」のみに絞り込み、ネットワーク負荷を平均で60%以上削減するケースも報告されています。

トレンド2:「リアルタイム性」がもたらすビジネス価値の最大化

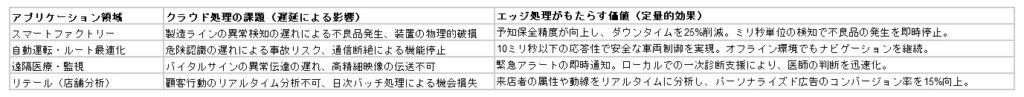

ビジネスにおける競争優位性は、意思決定の速さと精度に直結します。エッジコンピューティングは、ほぼゼロレイテンシーでのデータ処理と分析を可能にし、これまで実現不可能だったアプリケーションの価値を解き放ちます。

このように、リアルタイム性が求められるユースケースにおいて、エッジは理想的な処理環境を提供します。これは、単なるパフォーマンス向上ではなく、データから即座にインサイトを引き出し、アクションに繋げることで新たなビジネス価値を創出するためのアーキテクチャ変革です。

結論:データ戦略としてのエッジ・アーキテクチャの再設計

ハイブリッドクラウドやマルチクラウドが標準となった今、クラウドとエッジの境界は曖昧になっています。重要なのは、「どこでデータを生成し、どこで処理・分析すれば、その価値が最大化されるのか」をデータに基づいて判断することです。

IoTプロジェクトのROIを最大化するためには、まずデータフローを詳細に分析し、レイテンシー要件、データ量、セキュリティ要件に基づき、どの処理をエッジに配置し、どのデータをクラウドに集約すべきかを設計する必要があります。エッジコンピューティングへのシフトは、単なるインフラの分散化ではなく、データそのものの価値を最大化するための、データ戦略における必然的な次の一手と言えるでしょう。

エッジコンピューティング時代の「データ整理」戦略:現場で生まれる情報を活かすために

IoTや5Gの普及により、センサーやカメラなどのデバイスが生成するデータ量は年々増加しています。これに伴い、クラウドだけでなく、現場(エッジ)でデータを処理する「エッジコンピューティング」が注目されています。特に製造業や物流、小売、建設など、現場を持つ企業にとって、リアルタイム性と柔軟性を兼ね備えたエッジの活用は、業務の高度化に欠かせない要素となっています。

しかし、エッジで生成されるデータは膨大かつ多様であり、整理されていなければ活用どころか管理すら困難になります。つまり、エッジコンピューティングの効果を最大限に引き出すには、「データ整理」が不可欠なのです。

本記事では、エッジコンピューティングの活用が進む中で、なぜデータ整理が重要なのか、そしてどのように実践すべきかを解説します。

エッジコンピューティングとは?

エッジコンピューティングとは、データをクラウドに送る前に、データが発生する現場(エッジ)で一次処理や分析を行う技術です。これにより、以下のようなメリットが得られます。

通信遅延の削減(リアルタイム性の向上)

ネットワーク帯域の節約

セキュリティリスクの低減(データを外部に出さない)

オフライン環境でも動作可能

たとえば、製造現場では、設備のセンサーから得られる振動や温度のデータをエッジで処理し、異常を即座に検知することで、ダウンタイムを最小限に抑えることができます。

エッジで発生する「データ整理」の課題

エッジコンピューティングの導入が進む一方で、以下のようなデータ整理の課題が浮かび上がっています。

1. データ形式のばらつき

センサー、カメラ、PLCなど、デバイスごとに出力されるデータ形式が異なり、統合が難しい。

2. ノイズや欠損の多さ

現場環境では、通信障害やセンサーの誤作動により、データに欠損や異常値が含まれることが多い。

3. メタデータの不足

データに「いつ」「どこで」「どの設備から」取得されたかといった文脈情報が付与されていないケースが多い。

4. 保存・活用ルールの不在

どのデータをどこに、どのくらいの期間保存するかが決まっておらず、ストレージがすぐに逼迫する。

5. クラウドとの連携が不十分

エッジで処理したデータをクラウドに送る際に、整理されていないと分析や共有が困難になる。

最近のITトレンドとエッジ×データ整理の融合

1. マイクロデータセンターの普及

小型のエッジサーバーを現場に設置し、リアルタイム処理とデータ整理を現地で完結させる動きが進んでいます。

2. AIによるエッジ分析の高度化

エッジAIを活用し、整理されたデータをもとに異常検知や予兆保全を自動化する事例が増えています。

3. クラウド連携によるハイブリッド分析

エッジで一次処理したデータをクラウドに送信し、BIツールやAIで高度な分析を行う構成が主流になりつつあります。

4. データガバナンスの現場適用

本社主導のガバナンスだけでなく、現場レベルでのデータ分類・命名・保存ルールの整備が求められています。

エッジデータ整理の実践ステップ

1. データの棚卸しと分類

どの設備・センサーから、どのようなデータが、どの頻度で生成されているかを洗い出します。

2. メタデータの付与と構造化

設備名、設置場所、測定単位、タイムスタンプなどの情報を付加し、データに意味を持たせます。

3. ノイズ除去と欠損補完のルール化

異常値の除外や欠損データの補完方法を定め、分析に適した状態に整えます。

4. 保存・アーカイブポリシーの策定

リアルタイム分析用、履歴分析用、監査用など、目的に応じて保存期間や保存先を分けます。

5. クラウド連携と可視化の仕組みづくり

エッジで整理したデータをクラウドに連携し、BIツールやダッシュボードで可視化・共有できるようにします。

まとめ:エッジの価値は「整理されたデータ」から生まれる

エッジコンピューティングは、リアルタイム性と柔軟性を兼ね備えた次世代のITインフラです。しかし、その真価を発揮するには、現場で生成されるデータを「整理」し、意味づけし、活用可能な形に整えることが不可欠です。

「どの情報を、誰が、どこで、どのように使っているか」を明確にし、エッジとデータ整理を連携させることで、企業は現場と経営をつなぐ情報の流れを構築できます。エッジの未来は、整理されたデータの上に築かれるのです。

日本企業におけるエッジコンピューティングと「データ整理」の実践:現場主導のDXを支える情報基盤とは

日本国内では、製造業や物流、建設、インフラなど、現場を持つ産業を中心に、エッジコンピューティングの導入が加速しています。IoTや5Gの普及により、工場や倉庫、建設現場などでリアルタイムにデータを取得・処理するニーズが高まり、クラウドとエッジを組み合わせたハイブリッドなITインフラが注目されています。

しかし、現場で生成されるデータは膨大かつ多様であり、整理されていなければ活用どころか管理すら困難になります。つまり、エッジコンピューティングの効果を最大限に引き出すには、「データ整理」が不可欠なのです。

本記事では、日本国内の企業におけるエッジ活用の動向を踏まえながら、なぜ今「データ整理」が重要なのか、そしてどのように実践すべきかを解説します。

国内で進むエッジコンピューティングの導入背景

日本では、少子高齢化による人手不足や、熟練技術者の退職による技能継承の課題が深刻化しています。こうした背景から、現場の自動化・効率化を目的に、以下のような領域でエッジコンピューティングの導入が進んでいます。

製造業:設備の異常検知、予兆保全、品質管理

物流業:倉庫内の在庫管理、搬送ロボットの制御

建設業:現場映像のリアルタイム分析、安全管理

インフラ:電力・水道・交通の監視と制御

これらの現場では、クラウドに頼らず、現地で即時にデータを処理することで、応答性と安全性を確保しています。

エッジで発生する「データ整理」の課題

日本の現場では、以下のようなデータ整理の課題が顕在化しています。

1. 紙とデジタルの混在

現場では今なお紙の帳票や手書きメモが多く、デジタルデータとの統合が難しい。

2. デバイスごとのデータ形式の違い

センサーやPLC、カメラなど、メーカーや機種によって出力形式が異なり、統合が煩雑。

3. 属人化したデータ管理

特定の担当者だけがデータの意味や保存場所を把握しており、引き継ぎが困難。

4. クラウド連携の不整備

エッジで処理したデータをクラウドに送る際に、整理されていないと分析や共有が困難になる。

最近の国内ITトレンドとエッジ×データ整理の融合

1. スマートファクトリー化の加速

経済産業省の「Connected Industries」構想を背景に、製造現場のデジタル化が進行中。

2. 自治体・インフラ分野でのエッジ活用

スマートシティや防災対策として、交通・水道・電力の監視にエッジが活用されています。

3. 中堅・中小企業の現場DX支援

地域の製造業や物流企業でも、補助金や支援制度を活用してエッジ導入が進んでいます。

4. 現場主導のデータガバナンス強化

本社主導ではなく、現場でのデータ分類・命名・保存ルールの整備が求められています。

国内企業におけるエッジデータ整理の実践ステップ

1. 現場データの棚卸しと分類

どの設備・センサーから、どのようなデータが、どの頻度で生成されているかを洗い出します。

2. メタデータの付与と構造化

設備名、設置場所、測定単位、タイムスタンプなどの情報を付加し、データに意味を持たせます。

3. ノイズ除去と欠損補完のルール化

異常値の除外や欠損データの補完方法を定め、分析に適した状態に整えます。

4. 保存・アーカイブポリシーの策定

リアルタイム分析用、履歴分析用、監査用など、目的に応じて保存期間や保存先を分けます。

5. クラウド連携と可視化の仕組みづくり

エッジで整理したデータをクラウドに連携し、BIツールやダッシュボードで可視化・共有できるようにします。

まとめ:日本の現場DXは「整理されたデータ」から始まる

エッジコンピューティングは、日本の現場における人手不足や業務継承の課題を解決する鍵となる技術です。しかし、その真価を発揮するには、現場で生成されるデータを「整理」し、意味づけし、活用可能な形に整えることが不可欠です。

「どの情報を、誰が、どこで、どのように使っているか」を明確にし、エッジとデータ整理を連携させることで、日本企業は現場と経営をつなぐ情報の流れを構築できます。エッジの未来は、整理されたデータの上に築かれるのです。

海外企業におけるエッジコンピューティングと「データ整理」の最前線:グローバルDXを支える情報戦略とは

世界中で進むデジタルトランスフォーメーション(DX)の波の中で、エッジコンピューティングは重要な役割を担っています。IoTや5Gの普及により、製造、物流、小売、ヘルスケア、都市インフラなど、さまざまな業界で「現場での即時処理」が求められるようになりました。

特に欧米やアジアの先進企業では、クラウドとエッジを組み合わせたハイブリッドなITインフラを構築し、リアルタイム性とセキュリティを両立させる取り組みが進んでいます。しかし、エッジで生成される膨大なデータを活用するには、まず「整理」することが不可欠です。

本記事では、海外におけるエッジコンピューティングの活用事例と、データ整理の戦略的な取り組みについて解説します。

グローバルで進むエッジコンピューティングの導入背景

海外では、以下のような背景からエッジコンピューティングの導入が加速しています。

米国:スマートファクトリーや自動運転、スマートシティの実証実験が活発

欧州:GDPR対応を背景に、データをローカルで処理するニーズが高まる

中国・東南アジア:製造業の高度化と都市インフラの整備に伴うリアルタイム制御の需要増加

これらの地域では、クラウド依存を減らし、現場での即時判断を可能にするために、エッジコンピューティングが戦略的に導入されています。

エッジで発生する「データ整理」のグローバル課題

海外企業でも、エッジ導入に伴い以下のような課題が共通して見られます。

1. データのサイロ化

拠点や部門ごとに異なるシステムが導入され、データが統合されていない。

2. 多言語・多地域でのデータ整合性の確保

国や地域によってデータの表記や単位が異なり、統一的な分析が難しい。

3. リアルタイム性と保存性のバランス

即時処理と長期保存の両立が求められ、保存ポリシーの設計が複雑化。

4. 法規制への対応

GDPRやCCPAなど、地域ごとのデータ保護規制に準拠した整理・管理が必要。

海外のITトレンドとエッジ×データ整理の融合

1. Federated Learning(連合学習)の活用

欧米では、個人情報をクラウドに送らず、エッジでAIモデルを学習・更新する手法が注目されています。

2. エッジデータレイクの構築

米国の大手小売企業では、店舗ごとにエッジデータレイクを構築し、在庫・顧客動向をリアルタイムで分析しています。

3. エッジAIと自律制御の融合

ドイツの製造業では、エッジAIを活用して設備の異常を自動検知し、ラインを自律的に制御する取り組みが進んでいます。

4. クラウドネイティブなエッジ管理

グローバル企業では、Kubernetesなどのコンテナ技術を活用し、エッジ環境をクラウドから一元管理する動きが加速しています。

海外企業におけるデータ整理の実践ステップ

1. グローバルデータマップの作成

各拠点・部門で生成されるデータの種類・形式・保存先を可視化します。

2. 共通メタデータ設計

言語や単位の違いを吸収するために、共通のメタデータスキーマを設計します。

3. ローカル処理とクラウド統合の役割分担

リアルタイム処理はエッジ、長期分析はクラウドといった役割分担を明確にします。

4. データ分類とアクセス制御の標準化

グローバルで統一された分類ルールとアクセス権限管理を導入します。

5. 法規制対応の自動化

地域ごとのデータ保持・削除ルールを自動適用できる仕組みを整備します。

まとめ:グローバルDXの鍵は「整理されたエッジデータ」

エッジコンピューティングは、グローバル企業にとってリアルタイム性と柔軟性を両立するための重要な基盤です。しかし、その効果を最大限に引き出すには、現場で生成されるデータを「整理」し、意味づけし、活用可能な形に整えることが不可欠です。

「どの情報を、誰が、どこで、どのように使っているか」を明確にし、エッジとデータ整理を連携させることで、海外企業は地域を超えた情報の流れを構築できます。グローバルDXの未来は、整理されたデータの上に築かれるのです。

中小企業におけるエッジコンピューティングと「データ整理」のすすめ:現場力を高める情報整備の第一歩

中小企業にとって、業務の効率化や品質向上は常に重要なテーマです。近年では、IoTやセンサー技術の進化により、製造現場や倉庫、店舗などの「現場」からリアルタイムにデータを取得できるようになりました。こうした流れの中で注目されているのが「エッジコンピューティング」です。

エッジコンピューティングとは、データをクラウドに送る前に、現場(エッジ)で一次処理や分析を行う技術です。中小企業でも導入が進みつつありますが、その効果を最大限に引き出すには、現場で生まれるデータを「整理」し、活用できる状態に整えることが不可欠です。

本記事では、中小企業におけるエッジコンピューティングの活用と、データ整理の実践的なポイントを解説します。

なぜ中小企業でエッジコンピューティングが注目されているのか?

中小企業では、以下のような理由からエッジコンピューティングの導入が進んでいます。

クラウドに頼らず、現場で即時に判断・対応できる

通信コストやクラウド利用料を抑えられる

ネットワーク障害時でも業務を継続できる

セキュリティ面での安心感がある(データを外部に出さない)

たとえば、製造業では設備の稼働データをエッジで監視し、異常があれば即座にアラートを出す仕組みを構築することで、ダウンタイムの削減や品質向上につながっています。

エッジ導入で浮かび上がる「データ整理」の課題

エッジコンピューティングを導入すると、現場から大量のデータが生まれます。しかし、以下のような課題が整理されていない状態では、せっかくのデータも活かしきれません。

1. データの保存場所がバラバラ

USB、NAS、クラウド、PCなどに分散して保存され、探すのに時間がかかる。

2. ファイル名やフォルダ構成が統一されていない

担当者ごとに命名ルールが異なり、他の人が見ても分かりづらい。

3. センサーや設備ごとのデータ形式が異なる

CSV、画像、ログファイルなど形式がバラバラで、統合が難しい。

4. データの意味づけがされていない

「温度:85」などの数値だけでは、どの設備の、いつのデータか分からない。

5. 保存期間や削除ルールが曖昧

古いデータが残り続け、ストレージがすぐにいっぱいになる。

最近のITトレンドと中小企業のエッジ×データ整理

1. ローコード/ノーコードツールの活用

専門知識がなくても、データの可視化や整理ができるツールが増えています。

2. 小型エッジデバイスの普及

Raspberry PiやJetsonなど、安価で高性能なエッジ端末が登場し、導入のハードルが下がっています。

3. クラウド連携の簡素化

エッジで処理したデータを自動でクラウドに送る仕組みが整い、中小企業でもハイブリッド運用が可能に。

4. 補助金・支援制度の活用

中小企業向けのIT導入補助金やスマートものづくり支援事業を活用し、エッジ導入とデータ整備を同時に進める事例が増えています。

中小企業におけるデータ整理の実践ステップ

1. 現場データの棚卸し

どの設備・センサーから、どんなデータが、どの頻度で出ているかを洗い出します。

2. 保存場所と命名ルールの統一

ファイル名やフォルダ構成をルール化し、誰でも迷わず探せるようにします。

3. メタデータの付与

設備名、取得日時、単位などの情報を付けて、データに意味を持たせます。

4. 保存期間と削除ルールの設定

リアルタイム用、履歴用、監査用など、目的に応じて保存期間を決めます。

5. クラウド連携と可視化の仕組みづくり

必要なデータだけをクラウドに送信し、BIツールなどでグラフ化・分析できるようにします。

まとめ:中小企業の現場力は「整理されたデータ」から生まれる

エッジコンピューティングは、中小企業にとっても導入可能な現場改善の切り札です。しかし、その効果を最大限に引き出すには、現場で生まれるデータを「整理」し、活用できる状態に整えることが不可欠です。

「どの情報を、誰が、どこで、どのように使っているか」を明確にし、エッジとデータ整理を連携させることで、中小企業でも安全で効率的な情報活用が可能になります。データ整理は、現場の知見を未来につなぐ“情報の土台”なのです。

大企業におけるエッジコンピューティングと「データ整理」の戦略的重要性:分散する現場データを統合し、経営判断につなげる

大企業では、製造、物流、建設、インフラ、小売など、複数の拠点や現場を抱えるケースが一般的です。こうした現場では、IoTやセンサーの導入が進み、日々膨大なデータが生成されています。これらのデータをリアルタイムに処理・活用するために、エッジコンピューティングの導入が加速しています。

しかし、エッジで生成されるデータは多様かつ分散しており、整理されていなければ全社的な活用や経営判断に結びつけることは困難です。つまり、エッジコンピューティングの真価を引き出すには、「データ整理」が不可欠なのです。

本記事では、大企業におけるエッジ活用の現状と、データ整理の戦略的な取り組みについて解説します。

なぜ大企業でエッジコンピューティングが求められるのか?

大企業では、以下のような理由からエッジコンピューティングの導入が進んでいます。

拠点ごとのリアルタイムな意思決定を支援

クラウドへの通信負荷やコストの削減

セキュリティや法規制への対応(データを現地で処理)

グローバル展開における地域最適なITインフラの構築

たとえば、製造業では工場ごとにエッジサーバーを設置し、設備の稼働データを即時に分析。異常検知や予兆保全を現場で完結させることで、ダウンタイムの削減と品質向上を実現しています。

エッジ導入で浮かび上がる「データ整理」の課題

エッジコンピューティングの導入により、以下のようなデータ整理の課題が顕在化しています。

1. 拠点ごとのデータ構造の違い

工場や倉庫ごとに異なるシステム・命名規則が存在し、統合が困難。

2. メタデータの不足

「いつ」「どこで」「どの設備から」取得されたかが明確でないデータが多く、分析に活かせない。

3. 保存ポリシーの不統一

拠点ごとに保存期間や削除ルールが異なり、コンプライアンス上のリスクがある。

4. クラウド連携の非効率

整理されていないデータをそのままクラウドに送信すると、分析や可視化の精度が低下する。

5. データガバナンスの属人化

現場任せの管理体制では、全社的なデータ活用が進まない。

最近のITトレンドとエッジ×データ整理の融合

1. データファブリックの導入

エッジ・クラウド・オンプレミスを横断してデータを統合・管理する仕組みが注目されています。

2. エッジAIと自律制御の実装

エッジで整理されたデータをAIに学習させ、現場での自律的な判断・制御を実現する動きが加速。

3. ゼロトラストセキュリティの適用

エッジ環境でも「信頼しないことを前提とする」セキュリティモデルが求められ、データの所在とアクセス制御の整理が不可欠に。

4. グローバルデータガバナンスの強化

海外拠点を含めた統一的なデータ分類・命名・保存ルールの整備が進んでいます。

大企業におけるデータ整理の実践ステップ

1. 全拠点のデータ棚卸しとマッピング

どの拠点で、どのようなデータが、どの形式で生成されているかを可視化します。

2. 共通メタデータスキーマの設計

設備名、拠点コード、取得日時、単位などを統一し、データに意味を持たせます。

3. 保存・アーカイブポリシーの標準化

リアルタイム処理用、履歴分析用、監査用など、目的別に保存ルールを定めます。

4. クラウド連携と可視化の仕組みづくり

エッジで整理されたデータをクラウドに連携し、BIツールやダッシュボードで全社的に活用できるようにします。

5. データガバナンス体制の構築

IT部門と現場部門が連携し、データの分類・命名・アクセス管理を継続的に見直す体制を整備します。

まとめ:大企業のDXを支えるのは「整理されたエッジデータ」

エッジコンピューティングは、大企業にとって現場の即応性と全社的な最適化を両立するための重要な基盤です。しかし、その効果を最大限に引き出すには、現場で生成されるデータを「整理」し、意味づけし、活用可能な形に整えることが不可欠です。

「どの情報を、誰が、どこで、どのように使っているか」を明確にし、エッジとデータ整理を連携させることで、大企業は現場と経営をつなぐ情報の流れを構築できます。エッジの未来は、整理されたデータの上に築かれるのです。

製造業におけるエッジコンピューティングと「データ整理」の重要性:スマートファクトリーを支える現場データの整備戦略

製造業では、IoTやAI、5Gといった技術の進展により、工場のスマート化が急速に進んでいます。設備の稼働状況、品質データ、作業ログなど、あらゆる情報がリアルタイムに取得され、現場の可視化と自動化が進んでいます。

こうした変革の中で注目されているのが「エッジコンピューティング」です。クラウドに頼らず、工場内でデータを即時に処理・分析できるこの技術は、製造現場のスピードと柔軟性を高める鍵となっています。

しかし、エッジで生成されるデータは膨大かつ多様であり、整理されていなければ活用どころか管理すら困難になります。つまり、スマートファクトリーの実現には「データ整理」が不可欠なのです。

製造業でエッジコンピューティングが求められる理由

製造現場では、以下のようなニーズからエッジコンピューティングの導入が進んでいます。

設備の異常をリアルタイムで検知し、即時対応したい

ネットワーク遅延やクラウド依存を避け、安定稼働を確保したい

セキュリティや機密保持の観点から、データを外部に出したくない

工場ごとに最適な処理を行い、柔軟な生産体制を構築したい

たとえば、ある自動車部品メーカーでは、加工機の振動データをエッジで分析し、異常兆候を検知。保全作業を事前に行うことで、突発的なライン停止を大幅に削減しています。

エッジ導入で浮かび上がる「データ整理」の課題

エッジコンピューティングの導入により、以下のようなデータ整理の課題が顕在化しています。

1. 設備ごとに異なるデータ形式

PLC、センサー、ロボットなど、メーカーや機種によって出力形式がバラバラ。

2. メタデータの不足

「どの設備の、どの工程で、いつ取得されたか」が明確でないと、分析に活かせない。

3. 保存ルールの不統一

拠点やラインごとに保存期間や命名規則が異なり、データの検索や比較が困難。

4. クラウド連携の非効率

整理されていないデータをそのままクラウドに送ると、分析精度が低下し、コストも増加。

5. 属人化したデータ管理

現場担当者の知識に依存しており、引き継ぎや全社展開が難しい。

最近のITトレンドと製造業のデータ整理

1. エッジAIによる予兆保全

整理された時系列データをエッジAIに学習させ、設備の異常を自動検知する取り組みが進んでいます。

2. データファブリックの導入

工場内外のデータを横断的に統合・管理する仕組みが注目され、拠点間の連携が強化されています。

3. スマートセンサーの普及

データ取得時にメタ情報を自動付与できるセンサーが増え、整理の手間が軽減されています。

4. ゼロトラストセキュリティの適用

製造現場でも「信頼しないことを前提とする」セキュリティモデルが求められ、データの所在とアクセス制御の整理が不可欠です。

製造業におけるデータ整理の実践ステップ

1. 設備・工程ごとのデータ棚卸し

どの設備から、どのようなデータが、どの頻度で取得されているかを洗い出します。

2. 共通メタデータの設計

設備ID、工程番号、取得日時、単位などを統一し、データに意味を持たせます。

3. 命名規則と保存ルールの標準化

ファイル名やフォルダ構成、保存期間を全社で統一し、検索性と再利用性を高めます。

4. クラウド連携と可視化の仕組みづくり

エッジで整理されたデータをクラウドに連携し、BIツールやダッシュボードで可視化・分析できるようにします。

5. データガバナンス体制の構築

IT部門と製造現場が連携し、データの分類・命名・アクセス管理を継続的に見直す体制を整備します。

まとめ:スマートファクトリーの未来は「整理されたデータ」から始まる

エッジコンピューティングは、製造業にとって現場の即応性と品質向上を両立するための重要な基盤です。しかし、その効果を最大限に引き出すには、現場で生成されるデータを「整理」し、意味づけし、活用可能な形に整えることが不可欠です。

「どの情報を、誰が、どこで、どのように使っているか」を明確にし、エッジとデータ整理を連携させることで、製造業は現場と経営をつなぐ情報の流れを構築できます。スマートファクトリーの未来は、整理されたデータの上に築かれるのです。

非製造業におけるエッジコンピューティングと「データ整理」の重要性:リアルタイムな現場判断を支える情報基盤とは

近年、非製造業においてもIoTやAIの導入が進み、現場からリアルタイムにデータを取得・活用する動きが加速しています。小売店舗での顧客行動分析、病院での医療機器モニタリング、物流センターでの在庫管理、金融機関でのセキュリティ監視など、あらゆる業種で「現場の即時判断」が求められるようになりました。

こうしたニーズに応える技術として注目されているのが「エッジコンピューティング」です。クラウドに頼らず、現場でデータを即時に処理・分析できるこの技術は、非製造業においても業務のスピードと柔軟性を高める鍵となっています。

しかし、エッジで生成されるデータは多様かつ分散しており、整理されていなければ活用どころか管理すら困難になります。つまり、エッジコンピューティングの真価を引き出すには、「データ整理」が不可欠なのです。

非製造業でエッジコンピューティングが求められる理由

非製造業では、以下のような理由からエッジコンピューティングの導入が進んでいます。

顧客対応やサービス提供の即時性を高めたい

通信コストやクラウド依存を抑えたい

セキュリティやプライバシー保護の観点から、データを現地で処理したい

店舗や施設ごとに最適な処理を行いたい

たとえば、小売業では店舗内のカメラ映像をエッジで解析し、混雑状況に応じてレジスタッフを自動配置。医療現場では、患者のバイタルデータをエッジで監視し、異常があれば即座にアラートを出す仕組みが構築されています。

エッジ導入で浮かび上がる「データ整理」の課題

非製造業におけるエッジ導入では、以下のようなデータ整理の課題が顕在化しています。

1. 拠点ごとのデータ形式の違い

店舗、支店、施設などで導入されている機器やシステムが異なり、データの統合が難しい。

2. メタデータの不足

「どの店舗の、どの時間帯の、どの機器からのデータか」が明確でないと、分析に活かせない。

3. 保存ルールの不統一

拠点ごとに保存期間や命名規則が異なり、データの検索や比較が困難。

4. クラウド連携の非効率

整理されていないデータをそのままクラウドに送ると、分析精度が低下し、コストも増加。

5. 属人化したデータ管理

現場任せの管理体制では、全社的なデータ活用が進まない。

最近のITトレンドと非製造業のデータ整理

1. スマートリテールの拡大

POSデータ、カメラ映像、センサー情報をエッジで処理し、リアルタイムな売場最適化を実現。

2. 医療・介護分野でのエッジAI活用

患者の状態をエッジで常時監視し、異常時に即時対応するシステムが普及。

3. ゼロトラストセキュリティの導入

金融や公共機関では、エッジ環境でも厳格なアクセス制御とデータ整理が求められています。

4. クラウド連携による全社分析

エッジで整理されたデータをクラウドに集約し、BIツールで横断的に分析する仕組みが主流に。

非製造業におけるデータ整理の実践ステップ

1. 拠点ごとのデータ棚卸し

どの施設・店舗・支店で、どのようなデータが、どの形式で生成されているかを可視化します。

2. 共通メタデータの設計

拠点コード、取得日時、機器ID、用途などを統一し、データに意味を持たせます。

3. 命名規則と保存ルールの標準化

ファイル名やフォルダ構成、保存期間を全社で統一し、検索性と再利用性を高めます。

4. クラウド連携と可視化の仕組みづくり

エッジで整理されたデータをクラウドに連携し、BIツールやダッシュボードで可視化・分析できるようにします。

5. データガバナンス体制の構築

IT部門と現場部門が連携し、データの分類・命名・アクセス管理を継続的に見直す体制を整備します。

まとめ:非製造業の現場力は「整理されたデータ」から生まれる

エッジコンピューティングは、非製造業においても現場の即応性とサービス品質を高めるための重要な基盤です。しかし、その効果を最大限に引き出すには、現場で生成されるデータを「整理」し、意味づけし、活用可能な形に整えることが不可欠です。

「どの情報を、誰が、どこで、どのように使っているか」を明確にし、エッジとデータ整理を連携させることで、非製造業でも現場と経営をつなぐ情報の流れを構築できます。エッジの未来は、整理されたデータの上に築かれるのです。