目次

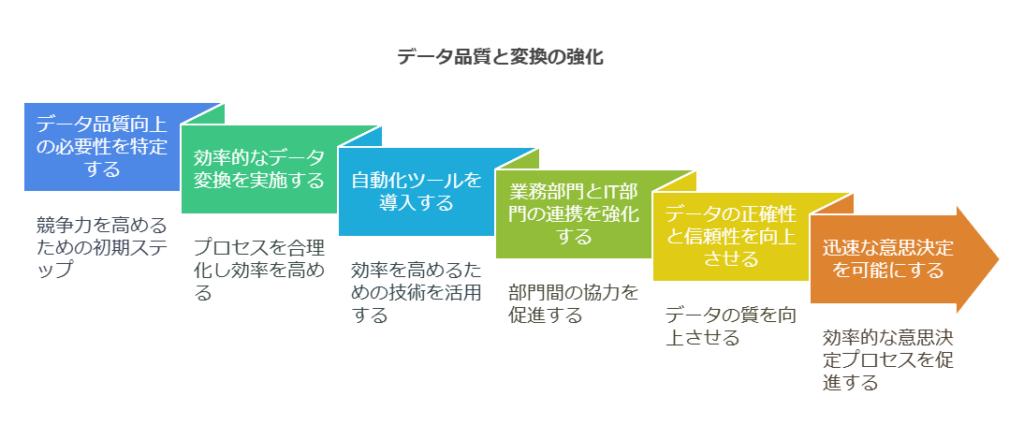

データ品質向上と効率的なデータ変換の重要性

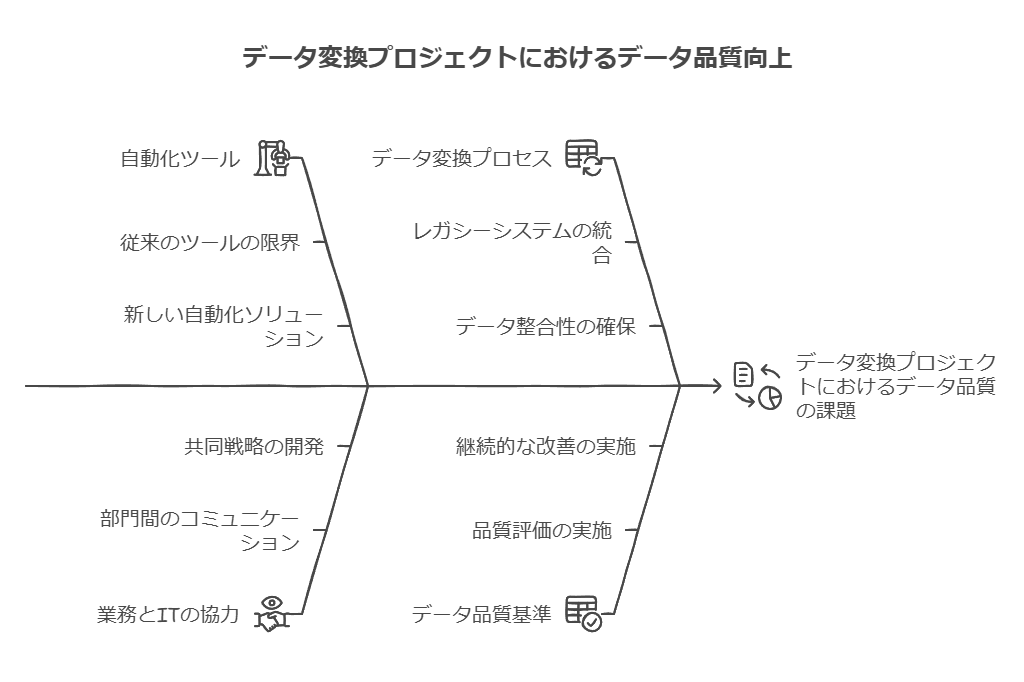

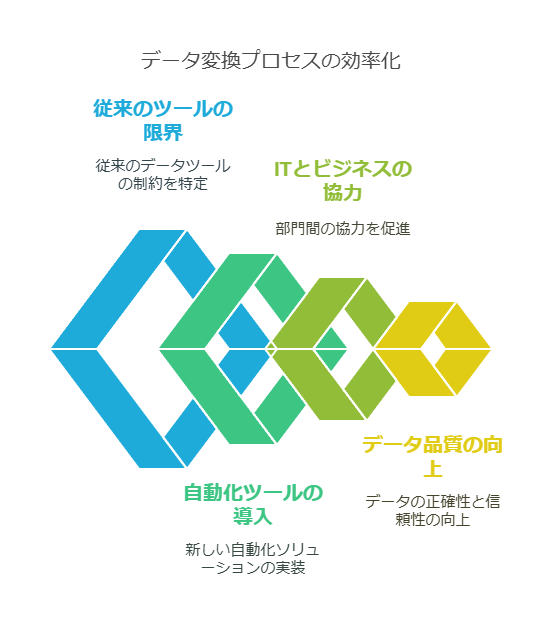

M&Aやレガシーシステムの更新に伴い、データ変換プロジェクトは頻繁に発生し続けます。従来のツール、例えばSAPのLSMWのようなソリューションでは、データ変換に時間がかかり、業務部門とIT部門の間にストレスや負担を生じることが多々ありました。しかし、データ変換プロセスの効率化を図るためには、より柔軟かつ直感的なアプローチが求められています。

効率化のアプローチとして、旧システムのデータをSAP対応のExcelワークブックに直接読み込む方法があります。旧システムがこれをサポートしている場合、データは直接または中間ステップ(例: SQLデータベース)を介して読み込むことが可能です。その後、業務部門がビジネスルールに従ってデータのクリーンアップを実施し、検証されたデータをSAPに1クリックで読み込むことができます。これにより、データ変換プロセスが劇的に加速され、IT部門の負担を軽減し、データの品質向上にもつながります。

ITと業務部門の橋渡しとしての自動化ツール

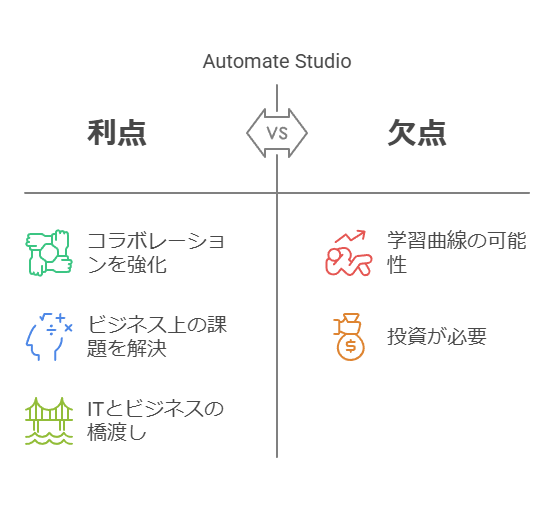

データ変換の効率化において、Automate Studioのような自動化ツールは、IT部門と業務部門の協力を促進する重要な架け橋となります。これにより、業務部門がデータに対する深い知識を活かしつつ、IT部門と協力して業務課題に対するソリューションを構築できます。自動化によって、手動での作業を迅速化し、両部門間の効率的な連携が実現されるため、より高度なプロジェクトにリソースを振り向けることができます。

顧客の声: 「Automate Studioは、私たちのようにITと業務の橋渡しを必要とする企業に最適なツールです。ビジネス上の課題を解決するために、両部門が協力してソリューションを構築できるようになりました。」

データ活用によるより優れた意思決定の実現

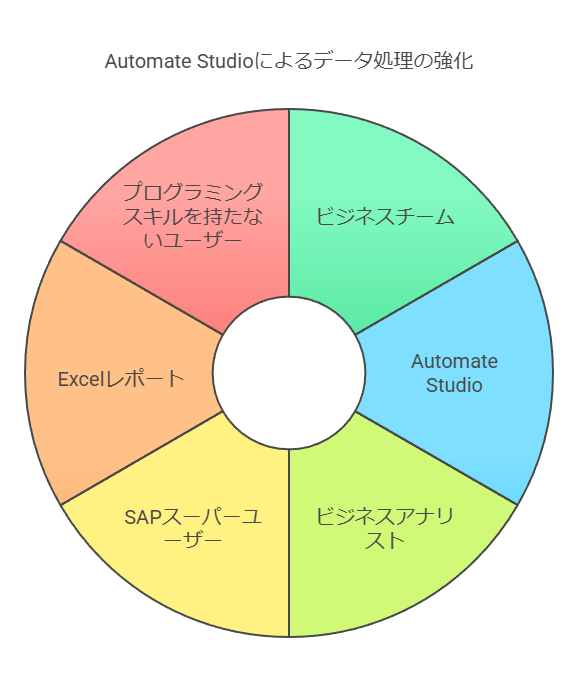

ビジネスチームがより優れた意思決定を行うためには、SAPデータを迅速かつ理解しやすい形式で取得し、分析できる環境が不可欠です。Automate Studioを使用することで、ビジネスアナリストやSAPスーパーユーザー、さらにはビジネスユーザーは、複数のSAPテーブルからExcelベースのレポートをすばやく構築することができます。これにより、プログラミングスキルを持たないユーザーでも、データ抽出や分析が可能となり、より迅速な意思決定が可能になります。

ポイント:

迅速なデータ抽出: Automate Studioを活用することで、SQVIや他のプログラミングスキルが不要な状態で、複数のSAPテーブルからデータを抽出できます。

分析可能な形式でのデータ提供: データはすぐに使い慣れたExcelで処理できるため、業務部門がデータのクリーンアップ、分析を簡単に行えます。

データコンサルタントの提言

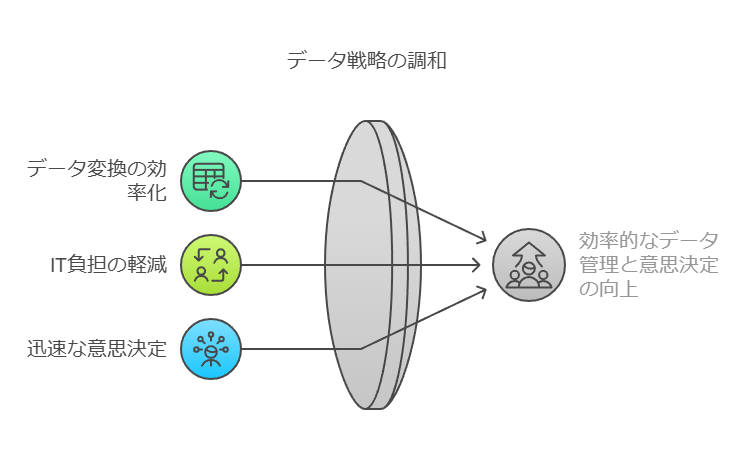

データ変換の効率化: 旧システムからのデータ移行をExcelベースで自動化することで、業務部門とIT部門の連携を強化し、変換プロセスのスピードアップと品質向上を実現しましょう。

IT部門の負担軽減: 自動化ツールを活用することで、手動作業の削減を図り、IT部門のリソースをより高度なプロジェクトに投入できるようにします。

データ活用による迅速な意思決定: 使い慣れたツールでビジネスユーザーがデータにアクセスし、意思決定を迅速化できる環境を提供し、ビジネスの競争力を強化しましょう。

SAPデータ品質の改善とITリソースの最適化

ITチームの負担軽減

多くの企業において、SAP ITチームはしばしば多くの業務やプロジェクトに追われています。その中には、ビジネス部門からの膨大なデータリクエストや修正作業が含まれています。しかし、Automate Studioのような自動化ツールを導入することで、ITチームは複雑で高付加価値のプロジェクトに専念できるようになり、より戦略的な業務に時間を割けるようになります。

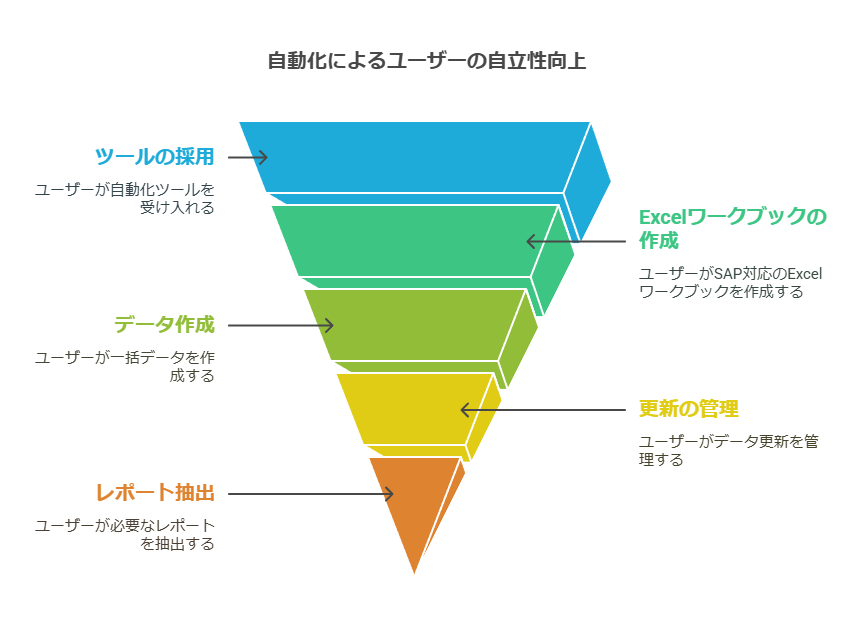

ユーザーの自立性向上

ビジネスユーザーは、SAP対応のExcelワークブックを自身で構築・利用することができ、これにより一括データ作成・更新からレポート抽出まで、業務を自ら完結させることが可能です。これにより、IT部門への依存度が下がり、運用効率が大幅に向上します。さらに、ユーザーがアクセスできるデータはSAPの認証情報に基づいて厳密に制御されているため、特別な監視やセキュリティ対策を強化する必要もありません。

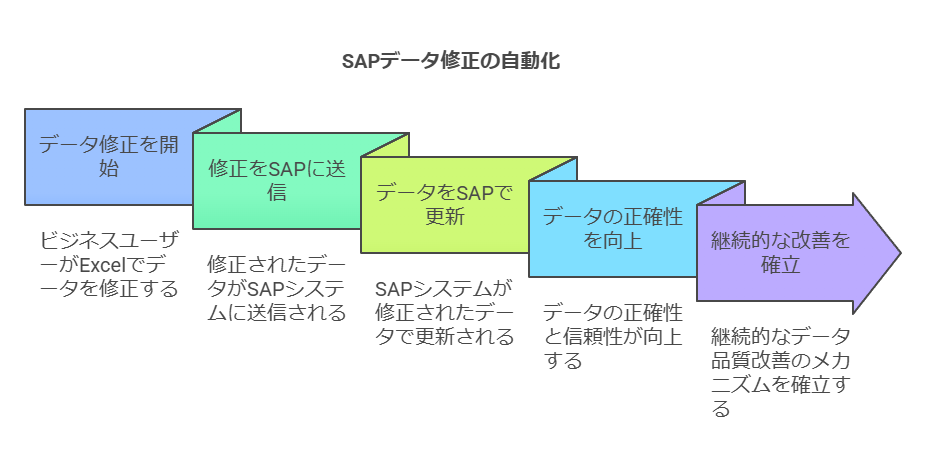

ラウンドトリップ機能によるデータ品質の向上

システムに存在する誤ったデータを修正する作業は、ビジネスの成果に直結します。Automate Studioのラウンドトリップ機能を使用すれば、ビジネスユーザーがSAPシステム内のデータをExcel上で直接修正し、すぐにSAPへ反映することができます。これにより、データの正確性と信頼性が向上し、データ品質を継続的に改善する仕組みが実現します。

ITリソースの最適化によるROIの向上

多くの企業で直面している課題の一つは、ITリソースが限られている中での業務効率の向上です。Automate Studioのようなソリューションは、SAPデータ管理における自動化とビジネスユーザーの自立を支援し、結果的にIT部門の作業負荷を大幅に軽減します。

例えば、多くのユーザーがコメントしているように、自動化ソリューションの導入により次のような効果が得られています。

年間コスト削減効果: 「プログラミング不要で、データ入力のワークロードとサービスレベル契約を削減し、年間約190万ドルのコスト削減を実現しました。」

生産性の向上: 「より重要なことは、ユーザーが生産性を向上させ、データの正確性を向上させるためのツールを手に入れたことです。」

ROIの向上: 「Precisely Automateソフトウェアの導入により、ERP投資のROIが向上し、パフォーマンスの問題もなく、SAPの利用が増加しています。」

データコンサルタントの提言

自動化による業務効率化: Automate Studioを活用し、ビジネスユーザーが自立的にデータ管理やレポート作成を行える環境を整え、ITリソースを最適化しましょう。

ITチームの役割転換: IT部門はSAPシステムの基盤構築や高度なプロジェクトに集中し、日常的なデータリクエストや修正作業はビジネスユーザーが担える体制を作ることで、企業全体の効率を向上させます。

データ品質の継続的改善: ラウンドトリップ機能により、リアルタイムでデータのクリーンアップが可能になるため、データ品質を常に維持・向上できる環境を整備しましょう。

データ品質向上と従業員の生産性向上

効率的なオンボーディング

従業員が新しい役割に就く際、SAP GUIの操作に慣れるまで時間がかかることは一般的な課題です。しかし、SAP対応のExcelワークブックを使用することで、従業員は親しみやすいインターフェースでSAPタスクを管理でき、学習期間が大幅に短縮されます。これにより、SAPスーパーユーザーのサポート負荷も軽減され、チーム全体の生産性が向上します。新しい担当者、たとえば経理や保守計画、人事などの各部門においても、データ管理やレポート作成、データ移行などを迅速かつ効率的に進めることが可能です。

コメント例:

「Automate Studioを導入することで、エンドユーザーは自分たちでプロセスを完結でき、システムがシンプルなので作業の仕組みをすぐに理解できるようになりました。」

士気向上と業務の付加価値化

従業員にとって、単純なデータ入力作業に多くの時間を費やすことは、モチベーションの低下に直結し、結果として離職率の上昇を引き起こす可能性があります。しかし、Excelベースの自動化ソリューションを活用すれば、繰り返しの作業を排除し、従業員はよりクリエイティブな業務や意思決定に集中できるようになります。これにより、従業員はビジネスの付加価値を創出する時間が増え、結果として仕事に対する満足度も向上します。

コメント例:

「時間の節約やデータの正確性の向上はもちろん重要ですが、それ以上に単純作業が排除され、業務により大きな価値を付加できるようになることで、従業員の満足度が上がるのです。」

データ移行と品質管理の最適化

データ移行プロジェクトでは、移行前のデータクレンジングとプロファイリングが極めて重要です。適切なツールと手順を使用して、信頼性の高いデータのみが移行されるようにすることが求められます。特に、クラウドデータウェアハウスに移行する際には、データカタログツールを用いて、データと関連メタデータを把握し、移行対象を正確に判断することが推奨されます。

質問例:

移行前に使用するデータプロファイリングおよびクレンジングの手順やツールはどのようなものですか?

信頼できる高品質のデータを移行するためのプロセスはどのようにしていますか?

クラウドへの移行に際し、データカタログツールを導入していますか?

運用データ移行のガバナンスの観点

クラウドへのデータ移行は技術的な課題だけでなく、ガバナンスやコンプライアンスの側面も慎重に検討する必要があります。クラウドは高度なセキュリティを提供しますが、一部のデータには法的規制や契約上の制限がある場合があり、これに違反しないようにすることが重要です。

検討すべきポイント:

データ要素の配置に関する規制は守られているか?

クラウドコンピューティングのセキュリティ基準は自社の要件に合致しているか?

ガバナンスの観点から、運用データの移行による組織への影響はどのように評価されていますか?

データコンサルタントからの提言:

オンボーディングの効率化: Automate Studioを活用し、SAPユーザーの学習期間を短縮し、従業員の生産性を早期に向上させましょう。

自動化による士気向上: 単純作業を自動化し、従業員が付加価値の高い業務に集中できるようにすることで、組織全体の士気を高め、業務効率を向上させましょう。

データ移行プロジェクトの最適化: データクレンジングやプロファイリングを徹底し、信頼性の高いデータ移行を実現し、クラウド移行に際してはガバナンス面での検討も忘れずに行いましょう。

データ品質の検証と評価

データの品質は消費者(データコンシューマ)ごとに異なる要件が求められるため、まず各コンシューマの期待値を正確に記録することが重要です。そのためには、データ品質を評価し、継続的にモニタリングするための技術・ツールの導入が不可欠です。また、データの出所(データリネージ)を把握しておくことで、コンシューマは自分が何を受け取っているのか正確に理解することができます。

データ品質管理プロセスには、以下の要素が含まれます:

検証時の制御手法の策定

品質モニタリングとレポート作成の自動化

データインシデント発生時のトリアージプロセス(深刻度の評価)

根本原因分析と修復措置の自動化

データインシデントの追跡システムの実装

これらの手法により、データ品質の継続的な向上を図ることができます。

データアクセスの管理

データアクセスのガバナンスには2つの側面があります。まず1つ目は、必要なデータにアクセスできる環境の提供です。データコンシューマが自分の業務に必要なデータへアクセスできるサービスを用意することが重要です。幸い、多くのクラウドプラットフォームでは、データサービスの開発を支援するツールやフレームワークが提供されています。

2つ目は、不正アクセスの防止です。これを実現するためには、ID、グループ、ロールを定義し、適切にアクセス権を割り当てることが不可欠です。このようなアクセス制御を整えることで、コンプライアンスの確保とセキュリティの強化が実現されます。

監査、追跡、モニタリング

どの組織においても、システムが期待通りに機能しているかを確認するための継続的な評価が必要です。特に、モニタリング、監査、追跡を行うことで、システム内の動き(誰が、いつ、何を、どのような情報で操作したか)を把握できます。このデータをもとに、セキュリティチームは潜在的な脅威を特定し、ビジネスに影響が及ぶ前にリスクを軽減することが可能です。

迅速な脅威対応を行うためには、制御の有効性を確認しつつ、定期的な監査を実施して、システム全体の健全性を総合的に評価することが重要です。

データの保護

ITセキュリティチームは、データの保護において境界セキュリティを確立し、許可されていないユーザーによるアクセスを防ぐことに努めていますが、これだけでは十分ではありません。特に、インサイダーによる不正アクセスや機密データの漏洩を防ぐのは非常に困難です。そこで、以下の追加の対策が推奨されます:

保存時および転送時の暗号化

機密データのマスキング技術の導入

**役割ベースのアクセス制御(RBAC)**の強化

これらの対策により、万が一データが流出した場合でも、内容が容易に解読されることを防ぎ、ビジネスに対するリスクを最小限に抑えることができます。

データコンサルタントからの提言:

データ品質管理の強化: データリネージを活用し、品質モニタリングと修正プロセスを自動化することで、品質を継続的に向上させる仕組みを整えましょう。

アクセスガバナンスの最適化: アクセス制御の強化により、必要なデータへのアクセスを提供すると同時に、不正アクセスのリスクを低減しましょう。

監査・モニタリング体制の整備: 定期的な監査を通じて、システムの健全性を保ち、潜在的なセキュリティリスクを迅速に発見し対応できる体制を構築しましょう。

データ保護の強化: 境界セキュリティに加え、暗号化やデータマスキングなどの追加のセキュリティ対策を導入し、データの保護を強化しましょう。

全部調べる君を活用したデータ品質向上とシステムの進化

全部調べる君は、データエコシステムを進化・拡張する強力なプラットフォームであり、アプリ、ダッシュボード、コネクタ、アルゴリズム、ソリューションなど、さまざまなツールを提供しています。これにより、企業は自社のデータ管理や分析を最適化し、ビジネスプロセス全体のパフォーマンスを向上させることができます。

パートナープログラムや開発者コミュニティを通じて、カスタマイズ可能なソリューションやベストプラクティスの共有が可能です。これにより、特定の業種、部門、職位に対応したアプリケーションやダッシュボードを迅速に導入でき、企業は自社に合ったデータドリブンソリューションを構築できます。

カスタマイズ機能の利活用

お客様はアプリケーションを通じて、既存のプラグアンドプレイソリューションを選択し、すぐに利用を開始できます。例えば、業界固有のユースケースに基づいて設計されたダッシュボードやアプリケーションは、迅速な意思決定をサポートし、業務効率を向上させます。さらに、SDKやDesign Studioを活用して、カスタムソリューションを開発し、特定のビジネスニーズに対応することも可能です。

データドリブンな組織への変革

OneData株式会社の「全部調べる君」といったツールを活用することで、データへのアクセスが容易になり、意思決定のスピードと精度が大幅に向上します。しかし、データドリブンな組織を実現するためには、単なるデータの統合や可視化にとどまらず、データクレンジング、機械学習、部門間のコラボレーションなど、包括的なデータ管理機能を統合的に利用する必要があります。

全部調べる君のシステムによる継続的な進化

OneData株式会社の全部調べる君は、単なるツールではなく、データ全体の進化をサポートします。オープンプラットフォームを活用することで、開発者コミュニティやパートナーシップを通じて、他の企業や開発者と協力し、知見やノウハウを共有できます。これにより、最新のソリューションを迅速に市場へ投入し、ビジネス価値を最大化することが可能です。

全部調べる君のプラットフォームの力—7つのコンポーネント

OneData株式会社の全部調べる君の Platformは、以下の7つのコンポーネントで構成され、組織全体のデータ活用と意思決定プロセスに革命をもたらします:

データ接続: 様々なデータソースから簡単にデータを統合

データ処理: 高度なデータクレンジングと加工機能

可視化: ダッシュボードでの迅速な可視化

予測と分析: 機械学習による予測精度の向上

コラボレーション: 部門間での効率的な情報共有

自動化: 業務プロセスの自動化で手作業を削減

アラートと通知: 重要なビジネス指標の変化を即時に通知

これにより、組織はデータを活用した迅速な意思決定が可能となり、業績向上や競争優位性の確立に貢献します。

データコンサルタントからの提言:

データの統合・クレンジングを自動化し、リアルタイムで信頼性の高いデータを提供する仕組みを整えることで、より正確な分析と意思決定をサポートします。

カスタムアプリとダッシュボードを活用し、特定のビジネスニーズに最適化されたソリューションを迅速に導入し、プロセス効率を向上させましょう。

データエコシステムの拡張とコミュニティを活用し、他企業やパートナーとの協力を強化し、最新の技術やノウハウを活用した新しいビジネスモデルの開発を推進します。

データ品質とリアルタイムコラボレーションの強化

データを活用した意思決定プロセスを加速するため、データに基づいたリアルタイムコミュニケーションをサポートする仕組みを導入することが重要です。この仕組みにより、関係者が重要なKPI(重要業績評価指標)に基づく会話が発生した際、メールやSMSで通知を受け取り、即座に議論に参加できる環境を提供します。さらに、アクセス権限を設定することで、必要なメンバーを迅速にディスカッションに加え、チーム全体での協議が可能になります。

これらのコミュニケーション履歴はすべて保存されるため、過去の議論を遡って確認し、意思決定の透明性を高めることができます。また、モバイルデバイスにも対応しており、外出先でもリアルタイムでデータの変動に対応し、議論を継続しながら、次の対応策やタスクの割り当てを迅速に行えます。

ケーススタディ—データ共有の革新

某通信会社では、ヨーロッパおよび北米で通信事業を展開しており、従来の方法では担当者がスクリーンショットを電子メールで共有する手間と、タイムラグが課題となっていました。次のアクションを迅速に取ることが難しかったのです。

アプリケーションの機能を導入したことで、リアルタイムのデータ共有と意思決定のスピードが大幅に向上しました。担当者はスクリーンショットを使わずに、データをリアルタイムで関係者と共有し、議論を通じて迅速な対応策を講じることができるようになりました。この機能は、T-Mobileにとってまさにゲームチェンジャーとなり、ビジネスの意思決定に劇的な改善をもたらしました。

未来を見据えた予測機能の重要性

多くの企業がデータの蓄積・統合・可視化を行っていますが、これらはあくまで過去データの分析に留まります。データドリブンな組織として一歩進むには、未来を予測し、それに基づいた対策を講じることが必要です。

膨大なデータを活用することで、これを機械学習の教師データとして利用し、将来のトレンドやリスクを予測できます。ただし、このプロセスには高度な機械学習エンジンと洗練されたアルゴリズムが必要となります。

今後のデータプラットフォームには、過去データを基にした現状把握だけでなく、未来の予測機能が求められています。これにより、企業は競争力を維持しつつ、より迅速かつ正確な意思決定を行うことが可能となるでしょう。

データコンサルタントからの提言:

リアルタイムのデータ共有とコラボレーション機能を活用して、意思決定プロセスを加速させ、チームのパフォーマンスを最大化しましょう。

機械学習と予測モデルを導入することで、将来のリスクやビジネスチャンスを迅速に特定し、適切な対応策を事前に計画できるようにします。

企業内でのデータガバナンスの強化を図り、アクセス権限の管理やコミュニケーション履歴の追跡を通じて、透明性とセキュリティを向上させましょう。

データ品質の向上: 効率的なデータクレンジング、結合、変換機能の重要性

現代のビジネスにおいて、データは企業の意思決定に欠かせない資産です。しかし、そのデータの形式やフォーマットは非常に多様であり、データが分散している状況では一貫した分析を行うことが困難です。通常、異なるデータセットを統合し、分析可能な形に整えるためには、専門的な技術者が時間をかけてデータのクレンジング、結合、変換を行う必要があります。このプロセスは、コストがかかり、しかも非生産的です。

さらに、市場の動向やビジネスニーズが変化する中で、データのフォーマットや内容が更新されるたびに、再度データの前処理をやり直す必要が生じるため、これも企業のリソースに大きな負担をかけます。ビジネスの変化に迅速に対応するためには、柔軟かつ効率的なデータ変換システムが不可欠です。

効率的なデータ変換エンジン: 自動化と柔軟性を実現

この課題に対処するために、データ変換エンジンは強力なソリューションとなります。接続された全てのデータセットが、「Store」によって自動的にクレンジング、整形、結合され、分析可能なデータに変換されます。このプロセスは完全に外部のツールや専門的な技術が不要で、ビジネスユーザーでも利用できる点が大きな利点です。

さらに、データの種類や特性に応じたアルゴリズムの事前カスタマイズが可能であり、組織ごとのデータ要件に柔軟に対応できます。これにより、変化するビジネスニーズやデータ形式の変化にも即座に対応でき、データ変換の効率を最大化することが可能です。

ケーススタディ: DHLの効率化事例

例えば、物流大手では、Prepare機能を活用することで、従来手作業で行っていたデータクレンジングやチューニング作業を自動化しました。カスタマイズされたアルゴリズムを設定することで、手動によるデータ前処理作業の完全な自動化を実現し、データ処理の時間を大幅に短縮しています。

以前は、データを収集し、Excelでクレンジングやピボットテーブルを作成し、チームに共有するのに1週間を要していましたが、Domoの導入後はそのプロセスが大幅に簡略化され、ビジネスの意思決定が迅速に行えるようになりました。

データコンサルタントからの提言:

自動化されたデータクレンジング、結合、変換プロセスにより、時間とリソースを節約し、ビジネスのスピードを加速させましょう。

アルゴリズムのカスタマイズ機能を活用して、組織のデータ特性に最適化されたデータ処理を実現し、柔軟に変化するニーズに対応する環境を整えます。

データの整形から分析までのプロセスを効率化し、リアルタイムのビジネスインサイトを迅速に取得できるようにすることが、競争優位性を高めるカギとなります。

データ品質の重要性:ビジネス価値を生むデータ活用の基盤

企業がデジタル競争力を高め、持続的なビジネス成長を実現するためには、質の高いデータの管理と利活用が不可欠です。データの品質を確保することで、データがビジネス上の課題の原因とならないようにすることができます。とりわけ、新型コロナウイルスによる社会や働き方の変化は、多くの企業にとってデジタルトランスフォーメーション(DX)の必要性を加速させ、データ管理の強化を求める契機となりました。

DXを推進するうえで重要な要素は、データの「利活用」に最適化されたデータ蓄積の仕組みです。データ利活用の基盤として、データレイクの活用は非常に有用です。従来、企業のデータ分析にはデータウェアハウス(DWH)が主に利用されていましたが、DWHの構造は予めスキーマ化されているため、分析に便利な一方で、未加工の膨大なデータの多くが取り込まれず、必要な情報が廃棄されるリスクがありました。

近年、クラウドの普及やIoTデバイス、5Gなどの高速通信技術の進化により、企業が収集できるデータの量や種類は飛躍的に拡大しています。多種多様なデータソースの登場により、データサイエンティストやデータアナリスト、ビジネス部門のユーザーはAIを活用した高度なデータ抽出や分析手法にアクセスできるようになりました。そのため、企業がデータから価値を生み出すためには、「すべてのデータを加工せずに保存」し、未加工のまま自由に分析できる環境が必要不可欠です。このような環境が整うことで、データからより深いインサイトを引き出し、ビジネスに革新をもたらすことが可能になります。

データレイクの導入によって、データエッジ領域から得られる未加工データを効率的に蓄積し、あらゆる部門が必要に応じて迅速にアクセス・分析できるインフラを構築することが、データ品質の向上とビジネス価値の創出につながるのです。

データレイクの課題と解決策:データ品質維持の重要性

データレイクは、デジタルトランスフォーメーション(DX)を加速させる上で不可欠な基盤として登場しましたが、正しく管理されなければビジネス価値を生むどころか、コストと複雑性が増す原因となります。効果的なデータレイク運用のため、以下の課題と対応策について検討が必要です。

データスワンプ化のリスク データレイクは「全てのデータを蓄積する」アプローチですが、ただ放置して蓄積すれば良いというものではありません。どこにどのデータがあるのか、アクセス権限を持つユーザーが把握できる状態を維持しなければ、データが使われない「データスワンプ(沼)」に陥ってしまいます。このため、データレイクにはタグ付けやメタデータの管理、データのカタログ化といった活用性を向上させる仕組みが欠かせません。これにより、データ活用の機会損失を防ぎ、データ品質の低下を避けられます。

ストレージとトラフィックコストの増加 データレイクはクラウド上で運用されることが一般的で、スキーマレスな構造により低コストで容量を確保できるメリットがあります。しかし、画像や動画、音声といった大容量データの活用が増加し、企業のデータ量は予想を超えて増加しています。その結果、ストレージおよびデータ転送にかかるトラフィックコストも増大し、クラウド活用のコスト面での優位性が薄れていることもあります。必要なデータの整理、アーカイブ戦略、アクセス頻度に応じたコスト管理が求められます。

データのサイロ化による統合の難しさ データサイロ化とは、部門や拠点ごとに独自のデータストレージやクラウドサービスを導入し、データが分散・隔離される現象です。この結果、データレイクを一元化して構築しようとした際に、オンプレミスや複数のクラウドからデータを統合するのが困難になります。解決策として、データ仮想化技術やデータ統合ツールを導入し、データレイクへのスムーズなアクセスを実現する方法が有効です。統一されたデータアクセスとセキュリティ基準の策定も必要です。

データレイクをビジネスの価値創出基盤とするためには、これらの課題を把握し、データ品質の確保と効率的な管理体制の構築が欠かせません。