コンセプトの明確化と主張の強化

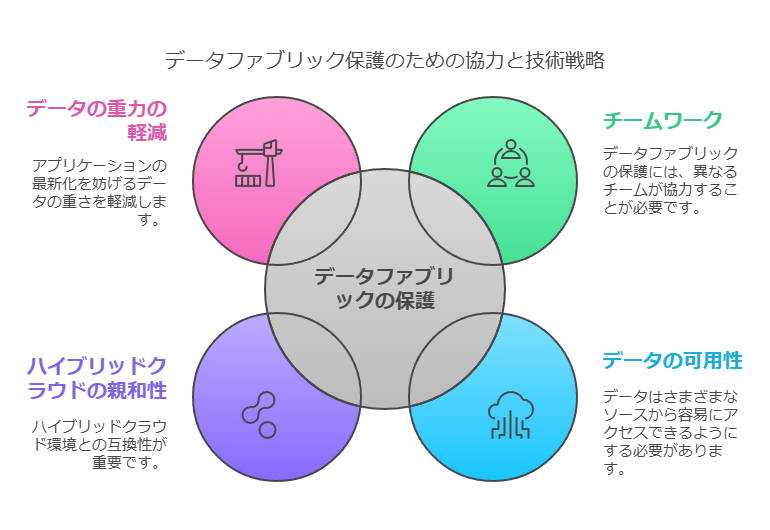

データ・ファブリックの保護は、チーム全体が協力するアプローチの好例です。データ・ファブリックの基本的な考え方は、データを固定された保存場所(データベース、データウェアハウス、データマート、データレイクなど)として捉えるのではなく、ITランドスケープ全体にわたってどこでもすぐにアクセス可能なネットワークとして捉えることです。データ・ファブリックは、アプリケーションの最新化を阻む「データ・グラビティー(データの重さ)」の影響を軽減するため、ハイブリッドクラウド環境との親和性が高く、非常に強力な組み合わせとなります。

ビジネス視点の強化とデータドリブンな考察

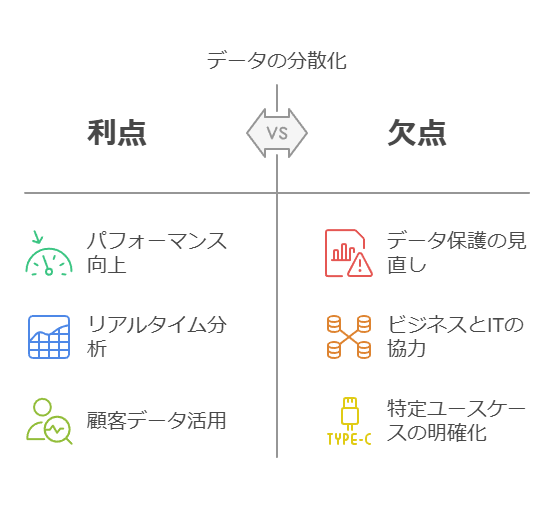

データの分散化を進めることで、ハイブリッドクラウドのパフォーマンスがさらに向上します。ただし、そのためには、特定のビジネスニーズに応じたユースケースを明確にし、それに基づいたデータ保護の方法を見直す必要があります。たとえば、ハイブリッドクラウドを利用する多くの企業では、リアルタイムのデータ分析や、顧客データの迅速な活用が求められています。これを実現するには、ビジネス部門とIT部門が協力し、データセキュリティを最適化することが不可欠です。

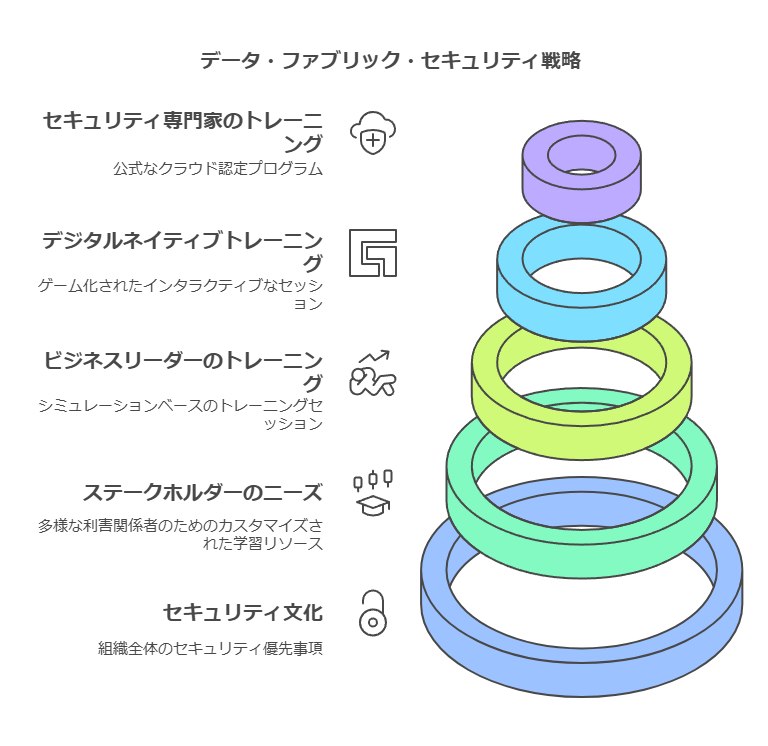

チーム全体での関与と多様な役割に応じた学習アプローチ

データ・ファブリックをセキュアに設計・実装するためには、たとえCDO、CTO、CIOが主導した場合であっても、全チームが連携して取り組む必要があります。このようなアプローチが効果を発揮するには、組織全体にセキュリティを最優先する文化が根付いていることが重要です。文化を醸成するための鍵は、さまざまな利害関係者のニーズに対応する学習リソースを提供することです。例えば、ビジネスリーダーにはシミュレーションベースのトレーニングが効果的であり、デジタルネイティブな利害関係者にはゲーム形式のトレーニングが適している可能性があります。セキュリティ担当者には、公式なクラウド認定研修が推奨されます。

データ統合とセキュリティポリシーの最適化

さらに、単一のクラウドプラットフォームを使用し、調和の取れたセキュリティポリシーや一貫性のある手順を採用することで、セキュリティ対策の効果を最大化できます。これにより、学習リソースもさらに具体的で実用的なものとなり、各メンバーの役割に応じた内容を提供することが可能です。特にデータ・ファブリックの保護においては、各部門やチームが果たすべき役割を明確にし、統合されたアプローチを強化することが不可欠です。

このように、データコンサルタントとしては、技術的な詳細をビジネスの成果と結びつけ、戦略的なデータ管理とセキュリティアプローチの重要性を強調することで、実務に即したアドバイスが提供できます。

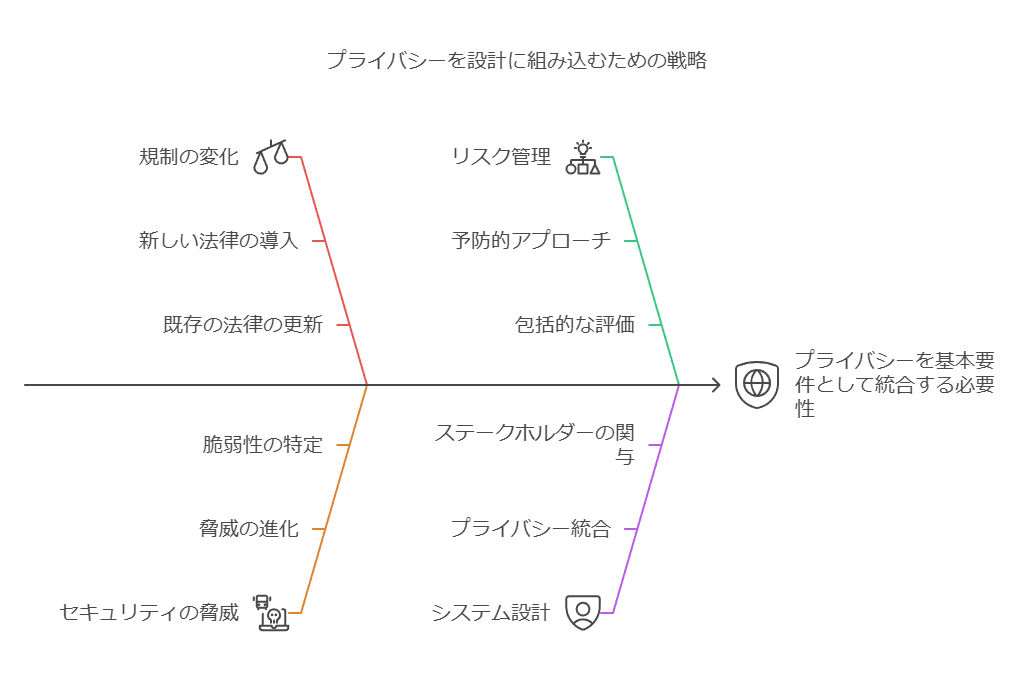

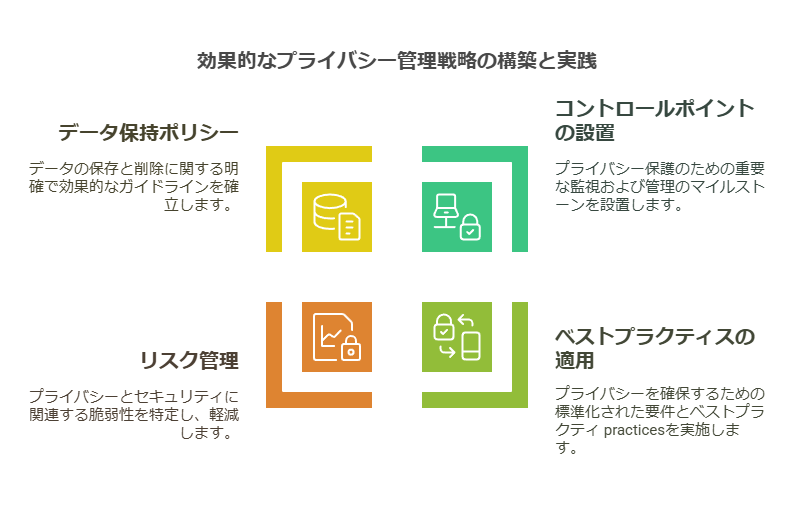

プライバシーバイデザインを組み込んだデータ管理戦略の採用

急速に変化する規制や新たなセキュリティ脅威に対して、受け身で対応するだけでは不十分です。企業は、システムやソリューションの設計・実装の段階で、プライバシーを基本要件として組み込む「プライバシーバイデザイン」を採用することで、積極的にリスク管理を行うべきです。

プライバシーバイデザインでは、企業は以下の要素を組み込む必要があります:

プライバシー保護のためのコントロールポイントの設置

プライバシーに関する要件やベストプラクティスの適用

プライバシーとセキュリティに関連するリスクおよび脆弱性の管理

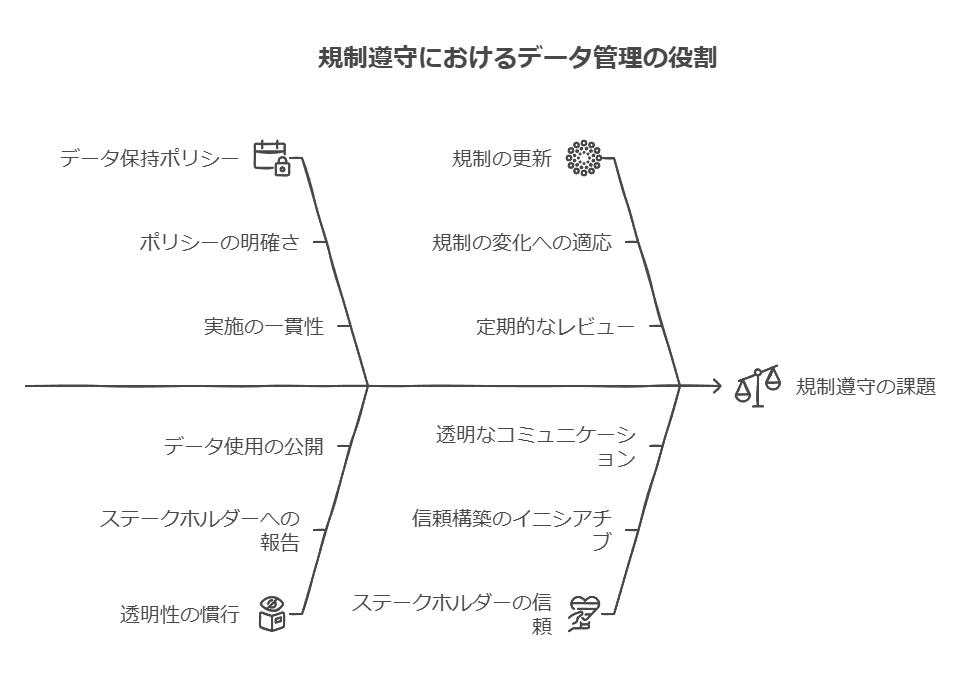

データ保持ポリシーの明確化

これにより、企業は規制を順守しつつ、データに関する信頼性と透明性を確保することが可能です。

具体例: 新規アプリケーションやベンダーの評価プロセス

新しいアプリケーションやプロジェクト、ベンダーの導入時には、正式な承認プロセスの一環として、個人データを扱うかどうかのスクリーニングを行い、リスクを評価する必要があります。初期段階でプライバシーを重視することで、データ保護に関する規制違反のリスクを低減し、長期的な信頼を築くことができます。

データ主体からのプライバシー要求への対応

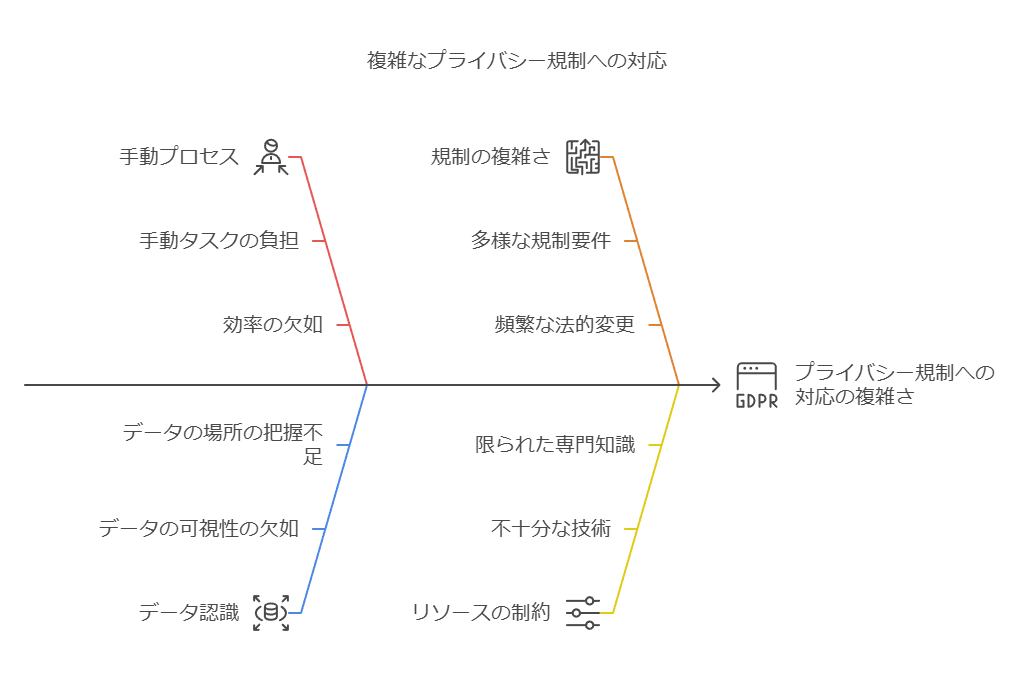

異なるプライバシー規制への対応は複雑であり、適切な対応方法を見つけることは大きな課題となります。データ管理の基本は、保有しているデータの内容とその保管場所の把握です。手動でプライバシー管理を行っている場合、プライバシー要求に対応することが困難になる可能性があります。

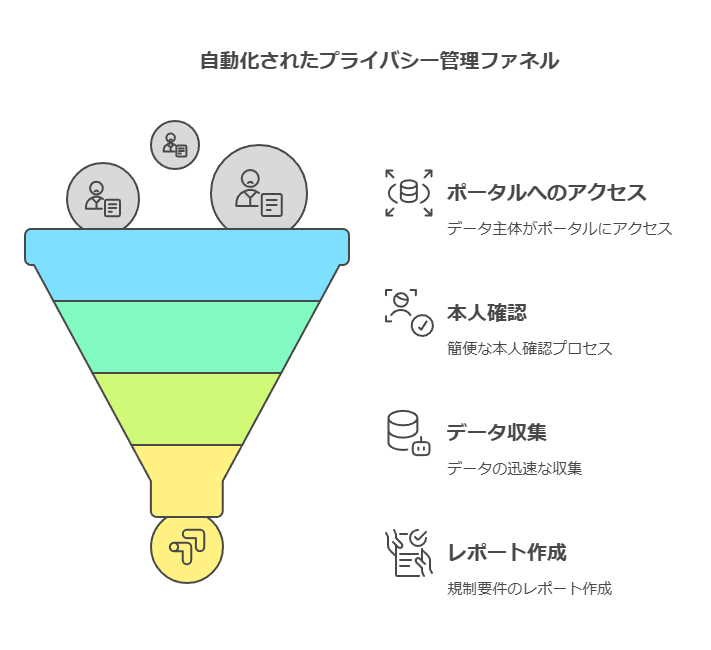

自動化されたプライバシー管理の利点

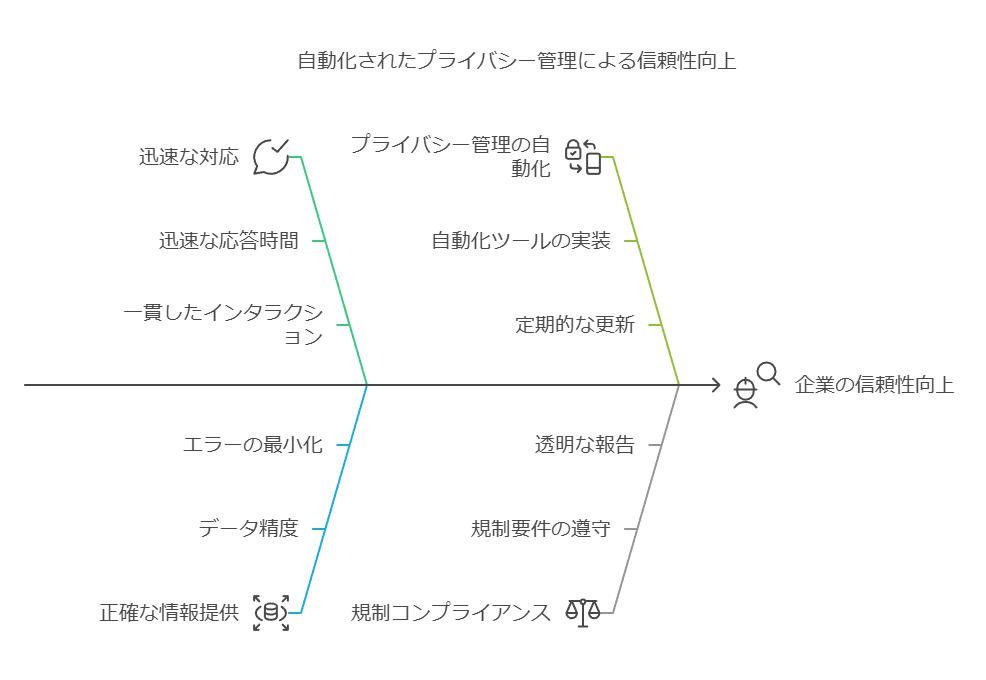

一方、プライバシー管理を自動化し、以下の要素を取り入れることで、より効率的に対応できます:

データ主体がアクセス可能なポータルの提供

簡便な本人確認プロセス

データの収集とレポート作成の迅速化

規制要件に対応するため、定期的にレポートを提供する体制

このように、データ主体に対して迅速かつ正確な対応が可能となり、企業の信頼性が向上します。

これにより、企業は規制の順守とリスクの軽減を実現しながら、より効率的なデータ管理体制を構築できます。

問題点の分析にデータ駆動型のアプローチを取り入れ、自動化のメリットを最大限に引き出すためのデータ管理や可視化の重要性を提示しました。

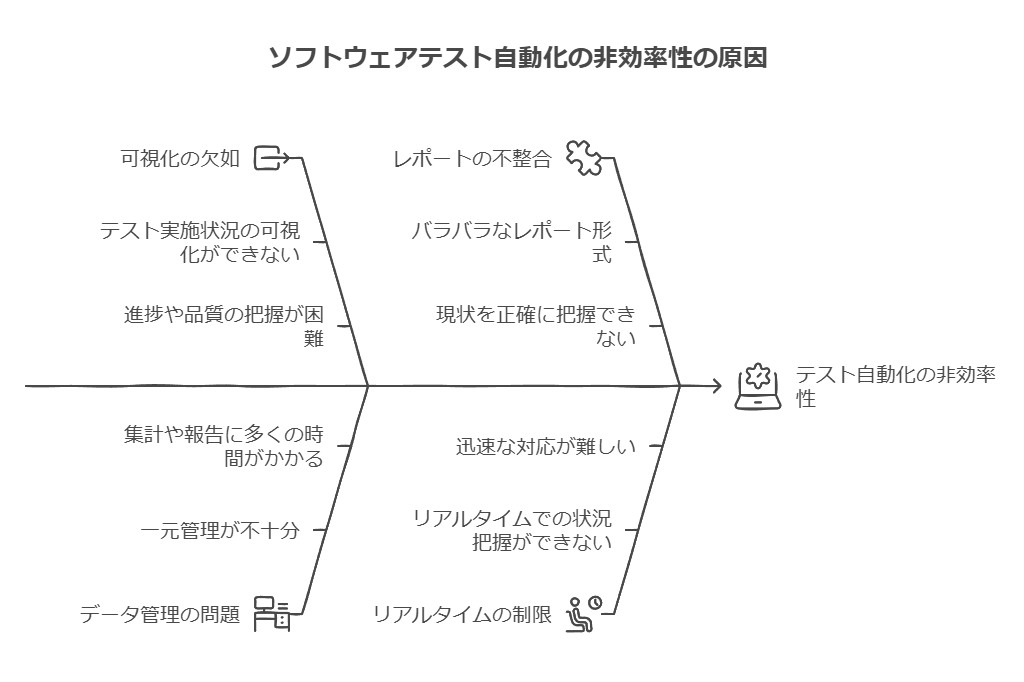

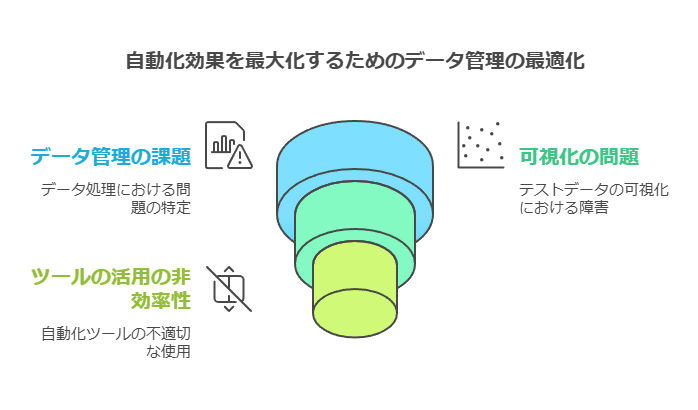

自動化を導入したものの、メリットを最大限に生かし切れていない、その原因とは?

多くの業界でソフトウェアテストの自動化が進んでいます。しかし、自動化を導入しても、その効果を十分に引き出せていない現場も多く見られます。原因の多くは、データの管理・可視化の不足や、ツールの活用方法が適切でないことにあります。現場から報告される具体的な問題点は次の通りです。

テスト実施状況の可視化ができず、進捗や品質の把握が困難

データの一元管理が不十分で、集計や報告作業に多くの時間がかかる

バラバラなレポート形式により、現状を正確に把握できない

リアルタイムでの状況把握ができず、迅速な対応が難しい

これらの課題を放置すると、自動化が進む一方で、開発プロセス全体の効率は低下し、手作業の修正や遅延が発生しやすくなります。データを基にした問題分析と、適切な管理ツールの導入が、自動化効果を最大化する鍵となります。

自動化成功のためのデータ駆動型アプローチ

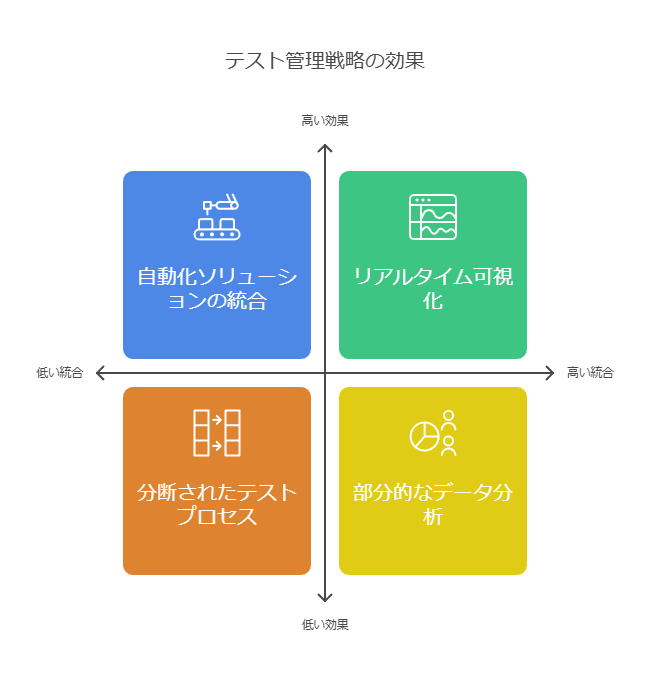

ソフトウェア開発においてスピードと品質を両立するためには、データ管理の重要性を再認識する必要があります。テスト管理者やテストマネージャーにとって最も重要なのは、テスト工程が開発スピードを遅らせないことです。このためには、以下のアプローチが効果的です。

テスト状況のリアルタイム可視化: テスト進捗、品質メトリクス、不具合情報などをリアルタイムで多角的に分析することで、データに基づいた意思決定が可能になります。これにより、迅速な問題解決が促進され、開発サイクル全体のスピードが維持されます。

テスト管理ツールと自動化ソリューションの統合: テスト管理ツールと自動化ソリューションを組み合わせて導入することで、シナジー効果が期待できます。テスト資産の再利用が容易になるため、品質向上に寄与しつつ、テスト管理工数の削減も実現できます。

自動化の効果を最大化するためのベストプラクティス

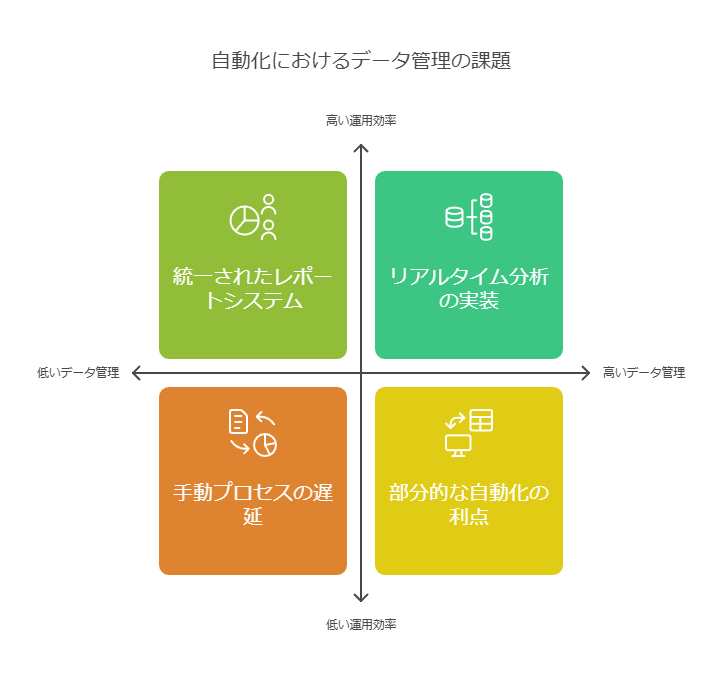

多くの企業はDX(デジタルトランスフォーメーション)に取り組み、業務の自動化による効率化とコスト削減を目指しています。IT運用部門でも、自動化の導入によって「生産性向上」「業務スピードアップ」「人的ミス削減」が期待されています。しかし、これらの効果を最大化するためには、業務プロセスのデータを一元管理し、可視化することが不可欠です。

データコンサルタントの視点から見ると、自動化が成功するためには次の要素が重要です。

データの統合管理と可視化: 分散したデータを一元管理し、可視化することで、現状把握が容易になり、迅速な意思決定を可能にします。

リアルタイムモニタリング: データをリアルタイムで追跡し、進捗や品質の変化に即座に対応する体制を整えることが、開発スピードを維持する鍵となります。

ツールの適切な選定と運用: 業務やテストに適したツールを導入し、効率的なワークフローを構築することが、生産性と品質の両立に重要です。

問題点の原因をデータの視点から分析し、効果的な解決策を提示しています。また、可視化と統合管理の重要性を強調し、ツールの選定と活用方法に焦点を当てています。

データ管理とビジネス成長の関係性

データを適切に管理・活用することは、現代のビジネス成長に不可欠な要素です。特に、Salesforce との統合によるデータの一元管理は、業務効率化だけでなく、部門横断的なデータ活用を促進し、さらなる相乗効果を生み出します。このような統合を実現することで、SaaSビジネスやサブスクリプション型モデルでの成長を加速させ、競争優位性を高めることが可能です。

データ統合の優位性: Salesforceなどの主要システムとデータを連携させることで、顧客データや営業活動の透明性が向上し、迅速かつデータドリブンな意思決定が可能になります。

データの重要性と現状の課題

企業経営におけるデータの重要性は日々高まっています。多様なソースから生成される大量のデータ(ビッグデータ、クラウドデータなど)は、迅速な意思決定を支える資産であると同時に、適切な管理を欠くと負担にもなります。これまで企業は部門ごとに最適化されたツールを導入してきましたが、それによりデータのサイロ化(データが部門間で孤立する現象)が進行し、データの一元的な活用が困難になっています。

データのサイロ化: 各部門ごとに異なるシステムを使用することで、データが分散し、統合的な分析や意思決定が難しくなっています。

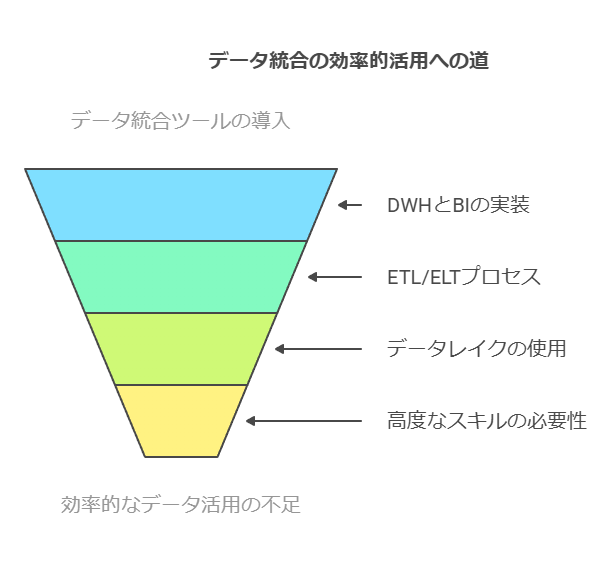

従来のデータ活用基盤の課題

企業はこれまで、DWH(データウェアハウス)やBI(ビジネスインテリジェンス)ツール、ETL/ELTプロセス、データレイクといったソリューションを導入してきました。しかし、これらのツールは手間やコストがかかる上、使いこなすのに高度なスキルが求められるため、データ統合の本来の目的である効率的なデータ活用が十分に実現されていないことが多く見られます。

課題解決の視点: サイロ化されたデータを効果的に統合し、データドリブンな意思決定を可能にする柔軟なインフラ構築が不可欠です。

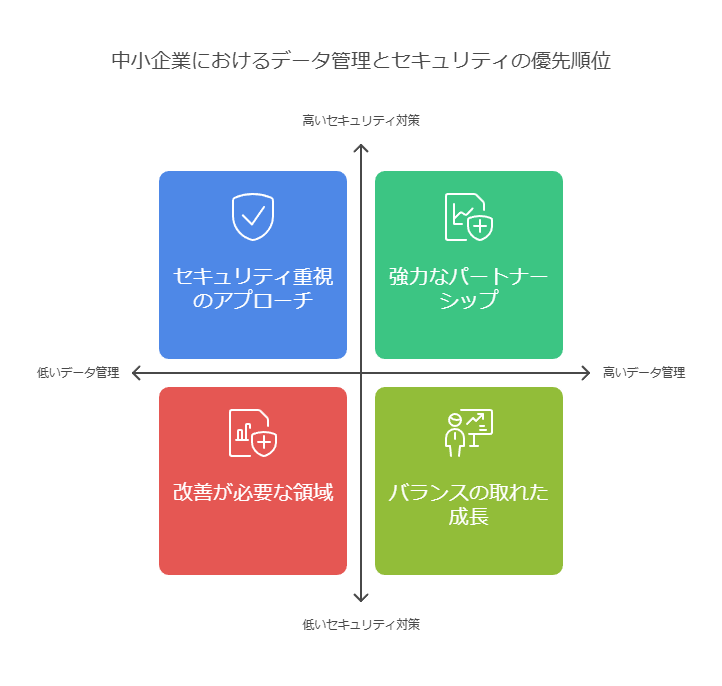

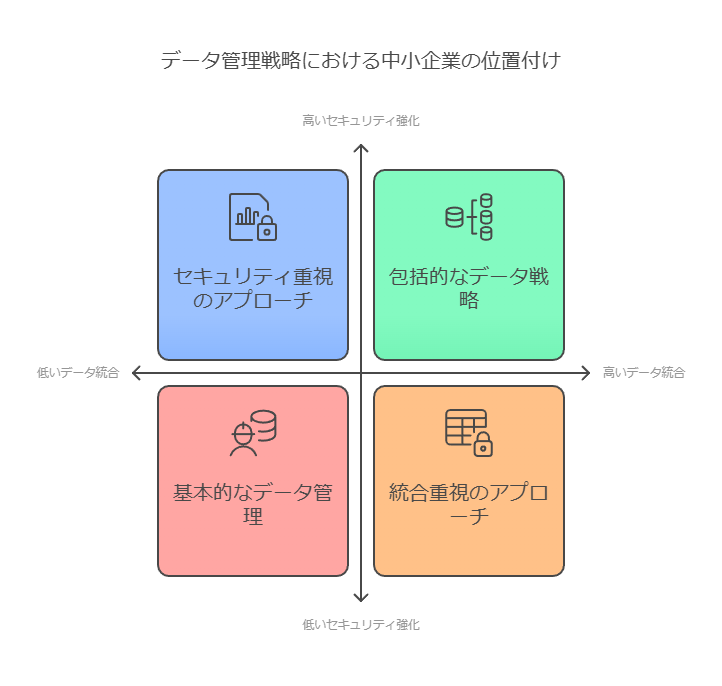

中小企業にとってのデータ管理とセキュリティの重要性

特に中小企業にとって、統合的なデータ管理とセキュリティは最重要課題です。ITインフラの運用やセキュリティの保守を担う**MSP(マネージドサービスプロバイダー)やMSSP(マネージドセキュリティサービスプロバイダー)**にとっても、顧客のデータ保護を万全にすることがビジネス継続の要件となっています。

REvilサプライチェーン攻撃の教訓: 2021年に発生した国際的なサプライチェーン攻撃では、MSPやMSSP事業者自身が標的となり、大きな被害を受けました。今後は、自社だけでなく顧客へのサービス提供にも影響を与える可能性があるため、より堅牢なITインフラとセキュリティ対策が求められます。

中小企業のための統合的アプローチ

中小企業が成長するためには、データ管理における統合的なアプローチが欠かせません。顧客データ、販売データ、カスタマーサービスデータなど、複数のデータソースを一元化することで、運用効率が向上し、迅速な意思決定が可能になります。また、強固なセキュリティ体制を確立することで、データ保護のリスクも軽減されます。

実現手法: 統合データプラットフォームの導入とセキュリティ強化を進め、コスト効率の高いデータインフラを構築することが、中小企業にとっての成長戦略となります。

データ管理は企業の競争力を高めるための重要な要素です。Salesforceなどの主要なプラットフォームとデータを一元管理することで、サブスクリプション型ビジネスやSaaS企業における成長をさらに加速させることができます。また、データのサイロ化やセキュリティリスクを解決するための統合的なアプローチが、企業全体のパフォーマンスを向上させる鍵となります。

データ主導型インフラ最適化によるビジネス価値創出

1. 大規模データ分析基盤と予測能力

10万システムを超える(サーバー、ストレージ等を含む)グローバルなインフラから収集される膨大なテレメトリデータを集約・分析する基盤が構築されています。このデータに基づきAI/MLを活用した予測分析を実行することで、潜在的な問題を早期に検知し、影響が顕在化する前に対処することが可能です。

2. 高度な分析手法:ワークロード・プロファイリングとグローバル学習

この分析能力は、以下の二つの主要なデータ分析アプローチによって強化されています。

ワークロード・フィンガープリンティング: 各アプリケーション固有の稼働パターンやリソース消費特性をデータとして捉え、プロファイリングします。これにより、標準的な挙動からの逸脱や特異な負荷変動を正確に把握できます。

グローバル学習: 広範な導入実績から得られる匿名化された運用データを基に、インフラ構成やワークロードに対する最適な設定・運用に関する知見(推奨事項)を導き出します。これにより、個々の環境における性能、設備稼働率、可用性、効率性、およびコスト効率の目標達成をデータに基づいて支援します。

これらの分析に基づき、I/Oの急増やワークロードの変動、潜在的な障害予兆といった環境変化をリアルタイムで捉え、インフラ設定を動的に調整することで、ビジネス目標の継続的な達成を支援する適応能力を備えています。

3. 分析プラットフォーム:HPE InfoSight

このデータ分析能力の中核を成すのが、HPE InfoSightというクラウドベースの予測分析プラットフォームです。これは、元々Nimble Storageによって開発され、業界における先駆的な存在であり、現在、最も成熟したプラットフォームの一つと評価されています。InfoSightは、導入環境の性能、稼働率、可用性、効率性をデータに基づいて最適化し、コスト効率を高める能力により、高い価値を提供してきました。

HPEによる買収後、その適用範囲はNimble Storage製品群から、3PAR StoreServ、ProLiantサーバー、Apolloサーバーへと拡大され、将来的にはSimpliVity HCIプラットフォームなど、さらに多くの製品ラインからのデータ統合が計画されています。この適用範囲の拡大は、分析対象となるデータソースの多様化とデータ量の増大をもたらし、分析モデルの精度と適用可能性を継続的に向上させています。

4. フルスタック・データ可視性の価値

このアプローチの最大の価値は、インフラの物理層(HPEハードウェア)に留まらず、ストレージOS、管理ソフトウェア、データ保護ツール、オーケストレーションツール、仮想化プラットフォーム(VMwareなど)、さらには主要なエンタープライズ・アプリケーション(例:SQL Server)に至るまで、ITスタック全体を横断する広範なデータ可視性を実現している点にあります。

具体的には、以下の分析機能を提供します。

仮想マシン(VM)レベルの監視と分析: VMの稼働状況を詳細に監視し、性能ボトルネックや異常を検知。その根本原因特定を支援します。

リソース最適化提案: ワークロードの偏りを是正するためのVM移行や、リソースを浪費している可能性のある休眠状態(アイドル)VMの特定など、具体的な最適化アクションを推奨します。

アプリケーション・ワークロードの可視化: SQL Serverのようなビジネスクリティカルなワークロードの稼働状況を可視化し、インフラがアプリケーション性能に与える影響を分析します。

このような「フルスタック」でのデータ収集と相関分析能力こそが、高精度な予測、効果的な最適化、効率的な管理、そしてデータに基づいた自己修復機能を実現する上での基盤となります。これは、特定のレイヤーに限定された分析や、依然として人手による調査・判断に大きく依存する従来型のアプローチに対する明確な技術的優位性であり、データ主導でのインフラ運用高度化を実現する上での重要な差別化要因です。