目次

デジタル化によるデータアクセスの急増

デジタル化が進展し、企業が扱うデータ量は急激に増加しています。トランザクションデータやその他のデジタルチャネルから生成される情報が増大し、データの処理や活用がビジネスにおいて重要な役割を担うようになりました。特にAIや機械学習(ML)の技術発展に伴い、大量のデータを活用する分析手法が浸透し、企業はこれを競争優位として活かしています。

しかし、こうした膨大なデータ量を迅速かつ効率的に処理するためのデータベース(DB)基盤は、依然として十分な進化を遂げていない点が課題です。データの増加に伴うニーズに応じたDB基盤の柔軟なスケーリングが必要ですが、現行の多くのシステムでは負荷管理に運用コストがかかる状況です。

トランザクションの急増とシャーディングによる負荷分散の課題

トランザクション数が急増すると、単体のデータベースでは処理能力が限界を迎えます。従来のスケーラビリティ対応策として、シャーディングによる負荷分散が広く用いられていますが、この方法ではシステムが複雑化し、メンテナンスコストが増加します。特に、物理的にテーブルを複数のDBに分割することで、クエリの管理が複雑になり、データの整合性や可用性の確保が難しくなることがあります。

多くのシャーディングツールが市場に登場し、運用の効率化を図っていますが、本質的な解決には至っていないのが現状です。

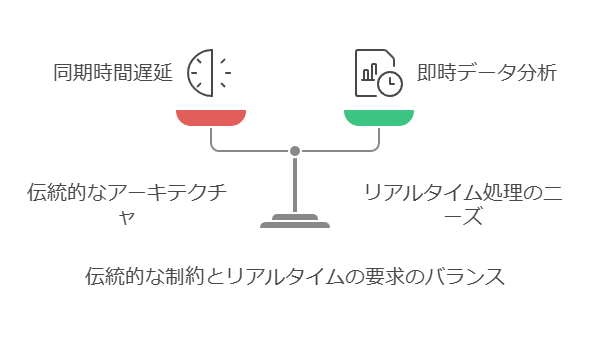

リアルタイム分析の必要性と従来のアーキテクチャの限界

データ活用が進む中で、ビジネスではよりリアルタイムに近いデータの分析が求められるようになっています。しかし、従来のデータベースアーキテクチャでは、リアルタイム処理を実現するのが難しいという問題が顕著です。

トランザクション処理(OLTP)とデータ分析処理(OLAP)を別々のシステムで行う従来のアーキテクチャでは、同期のタイムラグが発生し、リアルタイム分析に支障をきたします。システムを統合する方法もありますが、アーキテクチャの複雑化やパフォーマンスの低下が課題となります。

金融業界におけるDBアーキテクチャ改善の事例

近年、特に金融やフィンテック業界では、リアルタイム性を重視したトランザクション処理とデータ分析を統合するニーズが高まっています。これに対応する一例として、HTAP(Hybrid Transaction Analytical Processing)データベースが注目されています。これは、スケーラビリティとトランザクション性能、リアルタイム分析を兼ね備えた次世代のデータベース技術です。

HTAPアプローチによって、ビジネスにおいて即時のデータ分析が可能となり、システム全体のパフォーマンスを向上させることが期待されています。対象者 上記の課題に直面しているCTO、システムアーキテクト、データベース管理者、アプリケーション開発者に対し、具体的な解決策や最新のデータベース技術の導入方法を展開しました。

データ移行を成功させるための8つのヒント(1/2)

コスト分析にダウンタイムを織り込む

データ移行プロジェクトにおいて、各アプリケーションのダウンタイムがビジネスに与える影響を定量化し、正確なコスト分析を行います。これにより、計画時に予期しないコストを防ぎ、プロジェクト全体のコスト効率を向上させます。

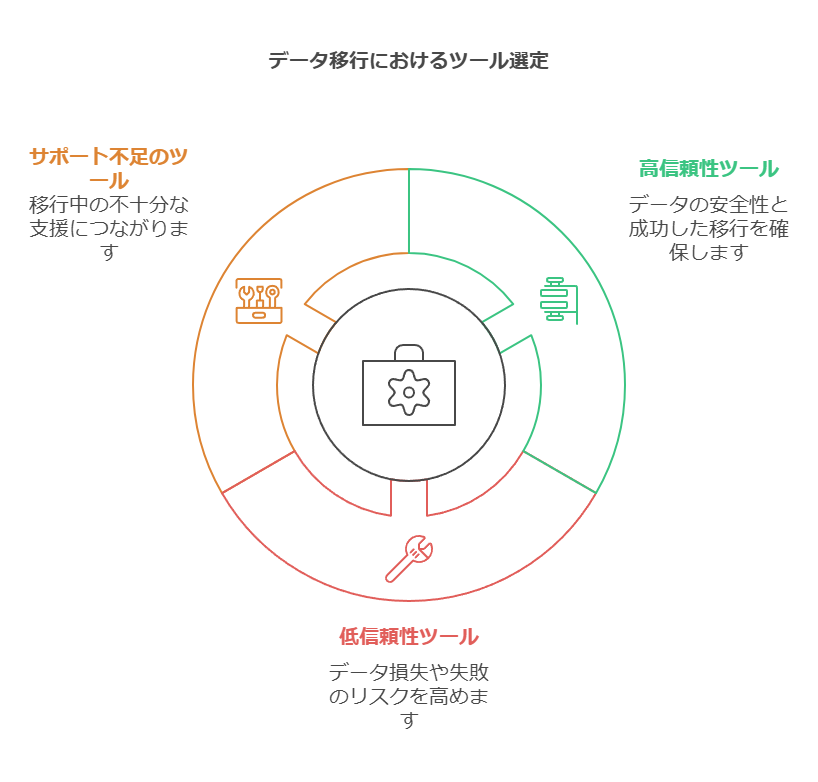

適切なツールの選定

移行プロセスで使用するツールは、信頼性が重要です。無料のツールやサポートが不十分なツールを選定することで、データ損失や移行の失敗リスクが高まる可能性があります。データの安全性を確保するため、機能性と信頼性の高いツールを活用しましょう。

移行リバート計画の策定

移行先のプラットフォームで問題が発生することも想定し、元の環境へ戻すためのリバート計画を事前に準備します。この計画により、新しいデータを失わずに迅速に対応できます。

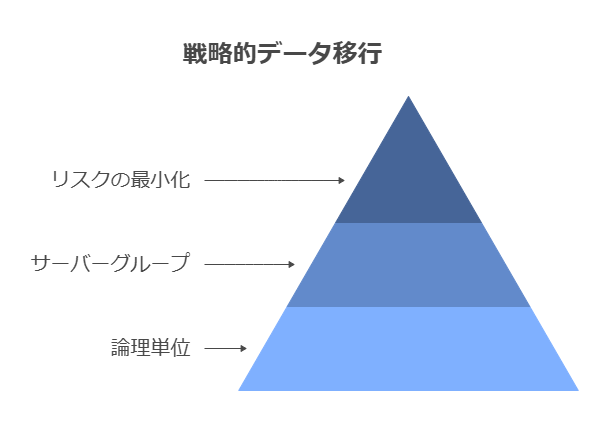

ワークロードの分割と段階的移行

プロジェクトを論理的な単位に分割し、それぞれのサーバーグループを段階的に移行することで、リスクを最小限に抑え、問題の特定と対応を容易にします。

包括的な機能テストの実施

データ移行後に、システム全体の機能を包括的にテストすることは、移行プロジェクトの成功に欠かせません。データの整合性とシステムのパフォーマンスを確認し、不具合の発生を防ぎます。

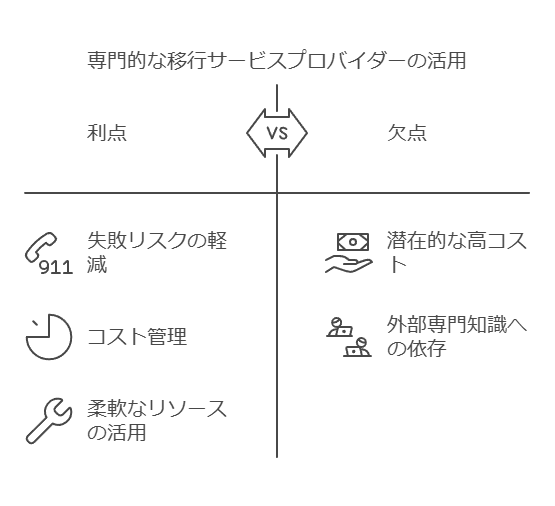

専門家の支援を活用する

専門的な知識を持つ移行サービスプロバイダーの活用は、プロジェクトの失敗リスクを軽減し、コスト管理にも貢献します。必要に応じて外部リソースを活用する柔軟な対応が重要です。

製品ライフサイクル全体を通じてラベリングの品質を向上

デジタル・ソリューションを活用することで、ラベリングプロセスの複雑さを軽減し、規制に準拠した迅速で効率的なプロセスを実現します。以下のポイントが重要です。

データ中心のアプローチによるトラッキングの強化

ラベル作成と管理の一貫性を確保し、設計から出力までのプロセスをデータ統合により効率化します。これにより、製品のライフサイクル全体を通じて、ラベルデータの正確性とトレーサビリティを確保できます。

並行処理とデータ統合の推進

設計とエンジニアリングの並行処理を可能にし、製品の市場投入までの期間を短縮します。縦割り構造を解消し、部門間でのデータ共有を円滑に行うことで、業務効率の最大化が図れます。

市場要件に準拠したUDI管理

各市場の規制要件に合わせ、UDIの管理や記録が確実に行える方法を提供し、グローバルなコンプライアンスを達成します。

テンプレートによる効率的なラベルデザイン

テンプレートを使用してラベルデザインを迅速に作成し、承認プロセスの効率化を図ります。データが更新され次第、適切にデザインに反映させることで、一貫性と柔軟性の両立が可能です。

データコンサルタントとして、これらの戦略は単に技術的な解決策に留まらず、データ管理やガバナンスに対する組織全体のアプローチを見直すきっかけとなり、ビジネス全体の最適化に貢献します。

データ移行を成功させるための8つのヒント(2/2)

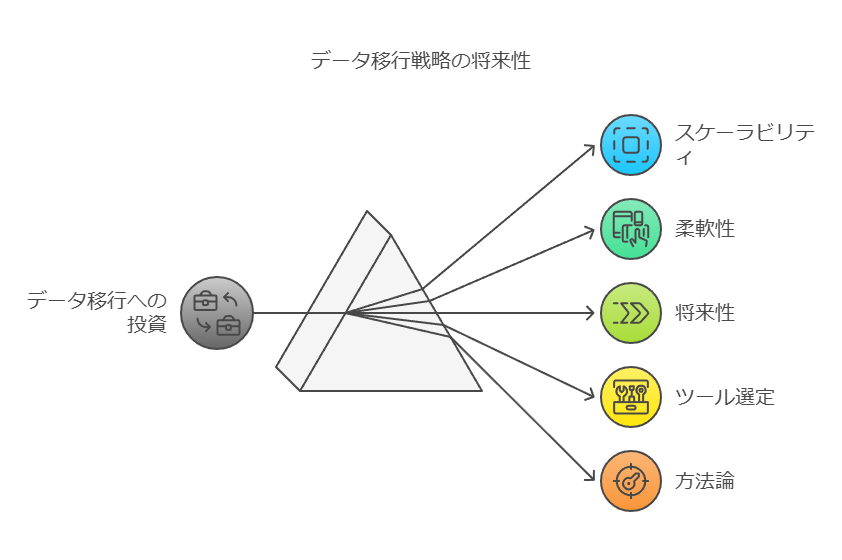

長期的な視野を持つ

データ移行は一度限りの作業ではなく、将来的なプロジェクトでも再度移行が必要になる場合があります。そのため、現在の移行プロジェクトにおいても、将来に向けたスケーラビリティや柔軟性を持つツールや手法に投資することが重要です。これにより、次回の移行時に再度のコストやリソースの無駄を避け、継続的な効率性を確保できます。

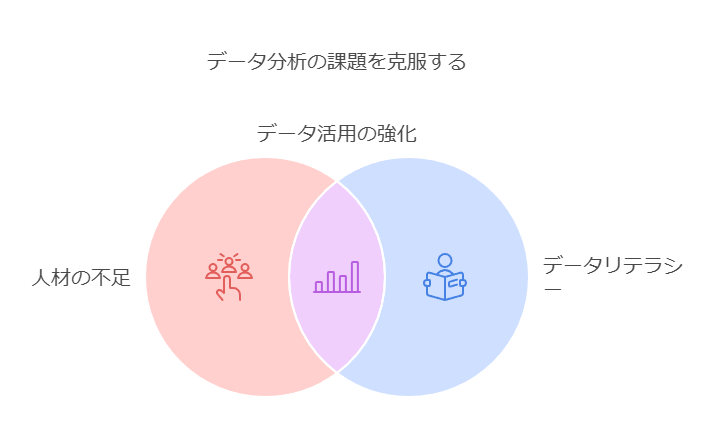

データ活用・分析の取り組みにおける課題

データ活用や分析の取り組みで最も多くの企業が直面する課題は「人材の不足」です。データ分析は、ツールやスキルによっては高度な専門知識が必要であり、そのため、多くの企業がその対応に苦慮しています。また、企業全体でのデータリテラシーの不足が、この課題をさらに深刻にしています。

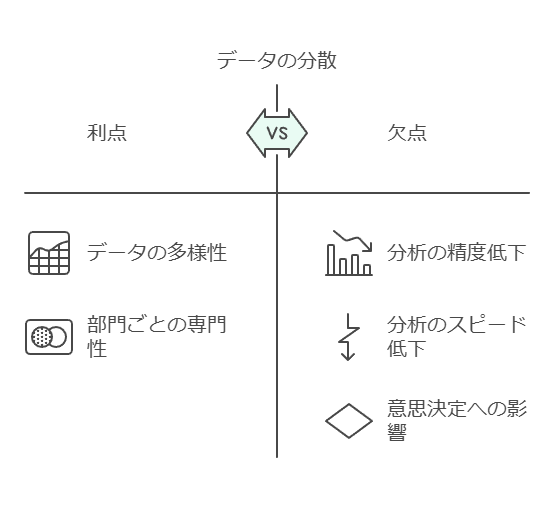

もう一つ大きな課題は「必要なデータが分散していること」です。特に、企業全体にデータが散らばっている場合、必要なデータにアクセスできなければ、データ分析の精度やスピードが低下し、最終的にはビジネスの意思決定にも影響を与えます。

さらに、「データの加工やクレンジングに手間がかかる」という課題も見逃せません。優れたデータ分析人材がいても、分析対象のデータがクリーンでなければ、その価値を最大限に引き出すことは困難です。データが整理されていないままでは、データサイエンスやAIを活用しても効果的なインサイトを得ることができません。

企業がデータを集約しても、データ検索性が低いとアクセスに時間がかかるケースもよくあります。検索性が低いと、必要なデータを迅速に集めることができず、全社的なデータ活用への障害となります。これでは、データの利活用のメリットを享受できず、分析を通じた意思決定が遅延する恐れがあります。

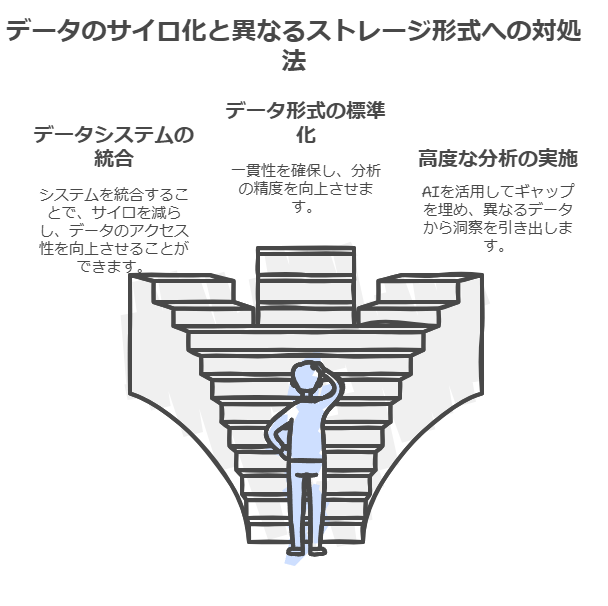

正しいデータ分析を妨げる「データ品質」の課題

前述の「必要なデータが分散している」という課題に関連して、もう一つの重要な問題は「データ品質」です。データのサイロ化や異なる形式での保存は、企業がデータを正確に分析する上で大きな障害となります。ここでのポイントは次の通りです:

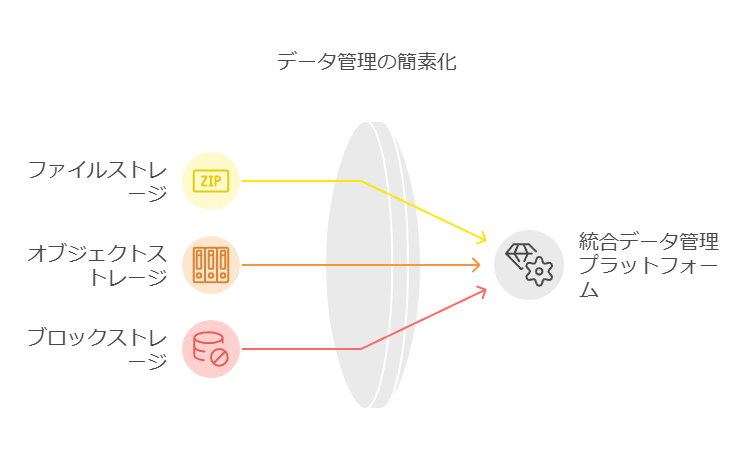

サイロ化の解消

ファイル、オブジェクト、ブロックストレージのデータを単一の統合プラットフォームに集約し、管理を簡素化します。これにより、データのアクセス性が向上し、業務効率が高まります。

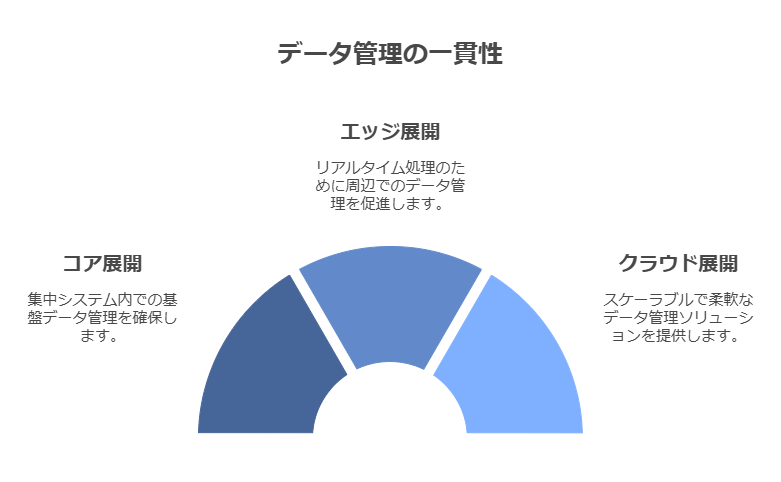

AIの展開におけるデータ管理の統合

AIを活用する際、コア、エッジ、クラウドのどこで展開する場合でも、データ管理の一貫性を保つことが不可欠です。これにより、AI分析の正確性を向上させ、全社的なデータ活用の基盤を強化します。

データコンサルタントの視点から見ても、これらの課題は単なる技術的な問題にとどまらず、企業全体のデータ戦略の見直しが必要です。適切なツール選定やデータガバナンスの改善を通じて、企業はより効率的でインパクトのあるデータ活用を実現できるでしょう。

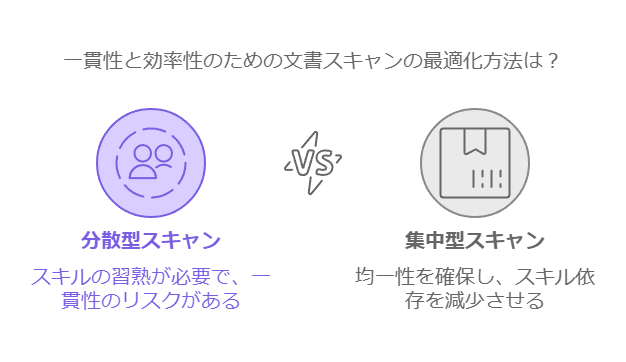

拠点でのスキャンの課題と効率化の必要性

紙文書を各拠点でスキャンし、データ化するというアイデアは一見すると合理的に思えるかもしれません。しかし、各拠点でスキャンを実施する際、いくつかの実務的な課題が浮上します。各拠点の担当者はスキャナー操作や設定、画像品質の確認といった作業に習熟している必要があり、そのスキルに依存するため、作業効率と品質が拠点ごとにばらつくリスクがあります。

このような現場依存の課題を放置すると、全体的な業務プロセスのデジタル化が滞るだけでなく、紙文書のデータ化が遅れ、業務の効率化を阻害する原因にもなりかねません。

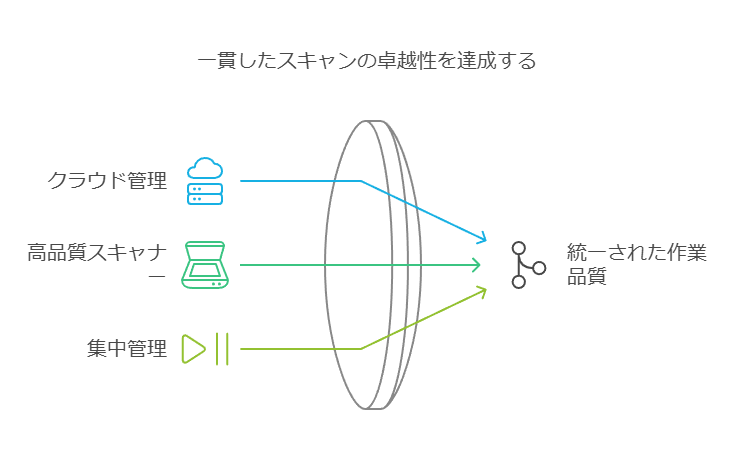

サブスクリプション型クラウドスキャナーの導入提案

この課題に対するソリューションとして、サブスクリプション型のクラウド管理対応高品質スキャナーの導入が有効です。これにより、各拠点の担当者のスキルに依存することなく、スキャナー設定や操作を一元管理でき、全体の作業品質を均一化できます。本セミナーでは、このソリューションを利用して、情報伝達のデジタル化を実現する方法について解説します。

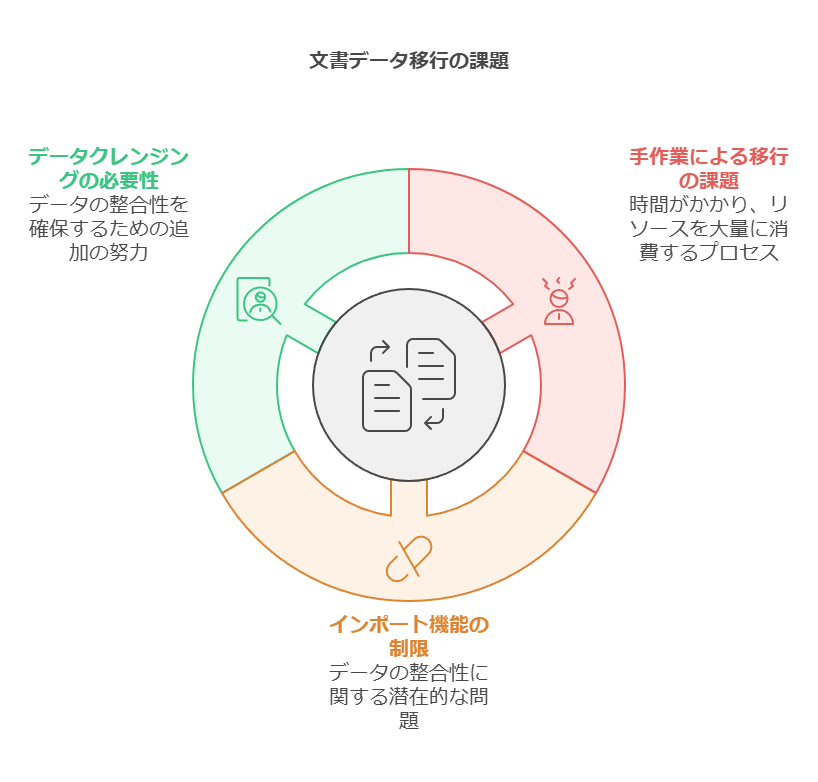

SharePointへの文書データ移行における課題

次に、文書データを既存のグループウェアからSharePointに移行する際の課題です。データ量が多い場合、手作業による移行は現実的ではなく、時間と人的リソースを大量に消費する結果となります。仮に、SharePointのインポート機能を活用しても、移行時や移行後にデータの整合性が取れないケースがあり、データクレンジング作業が追加で必要になることがよくあります。また、移行対象のデータは日常業務で頻繁に利用されているため、移行実施のタイミングを誤ると、業務に支障をきたしたり、データが一時的にアクセス不能になるリスクもあります。

膨大なデータ量がコストと業務負荷を増大させる問題

さらに、データ量が膨大な場合、移行ツールを使用してもそのコストと業務負荷が増大する傾向があります。特に、ツールのライセンス費用がデータ量に応じた料金体系になっている場合、データ量が増えればそれだけ費用がかかり、予算超過のリスクが高まります。また、移行ツール自体の操作に高度なリテラシーが求められることも多く、ツールの使用を管理できる人材の確保が重要な課題となります。

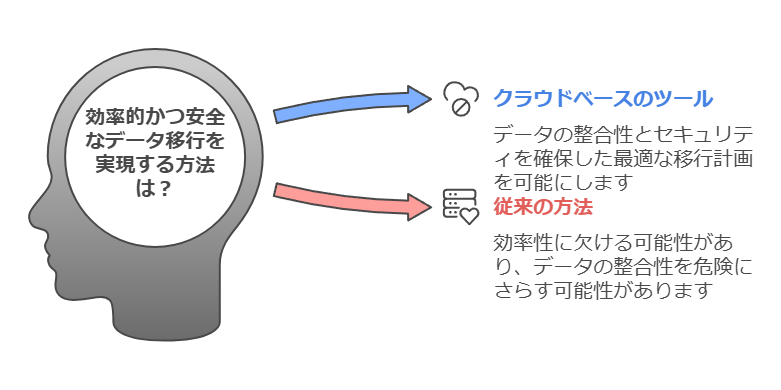

効率的かつコストを抑えた文書データ移行ソリューション

これらの課題に対して、コンサルタントとしては、正確かつ迅速な移行を実現し、コストを最小限に抑えるソリューションを提案します。クラウドベースのデータ移行ツールを活用することで、データ量に応じた最適な移行計画を立案し、データの整合性とセキュリティを確保しながら、業務への影響を最小限に抑えることができます。また、自動化されたデータクレンジング機能やリアルタイムの移行モニタリングを導入することで、業務効率を飛躍的に向上させ、人的リソースを削減することが可能です。

ここでは、課題に対する具体的な解決策やデジタル化に向けたプロセスの効率化に焦点を当て、データコンサルタントとしての視点を強調しています。

なぜ「十分に良い」データでは、もはや十分ではないのか

現代のビジネス環境で成功を収めるために、企業は急速に変化する市場や不確実性に対応し、リスクに備えるだけでなく、次なる課題を予測して素早く行動する必要があります。このために必要な道筋を提供するのがデータです。

データは、かつて見えなかった顧客の行動パターンや、新たなコスト効率化の手段、さらには未解決の問題を浮き彫りにします。しかし、これまで効果を発揮していたデータ管理の手法では、今や急速に進化するビジネスニーズに応えられなくなっています。多くの企業が、そもそも必要なデータの収集や活用に苦労しているのが現状です。

データ量の急増とアクセスの複雑化 企業が扱うべきデータの量はかつてない規模に膨れ上がっています。事実、現在のデータ総量は、宇宙の星々よりも多いとさえ言われます。加えて、SaaSアプリケーションの普及に伴い、多くの企業では100以上のデータソースを統合しなければならない状況に直面しています。このような複雑さを解消しなければ、貴重なデータが情報サイロに閉じ込められ、経営に活かすことができなくなります。

現に、企業が保有するデータ全体の73%は利用されておらず、その大半はアクセスが困難な状況にあります。データの量だけでなく、そのクオリティも重大な課題です。基本的な品質基準を満たしているのは、企業のデータのわずか3%に過ぎず、これが米国企業だけでも年間3兆ドルの損失を引き起こしているのです。

データ駆動型組織の構築の失敗と課題 こうした背景から、企業の3分の2が「データ駆動型の組織の構築に失敗している」と報告しているのは驚くべきことではありません。しかし、これに甘んじている余裕はありません。世界はかつてない速さで変化しており、企業は正しい意思決定と投資を行うことで未来への備えをしなければならないのです。

データ戦略の必要性 データの専門家であるJohn LadleyとThomas C. Redmanも指摘するように、適切に統合されたデータは、ビジネスプロセスを最適化し、意思決定者に力を与え、企業の戦略を加速させます。今後のビジネス成長を実現するためには、単なるデータ収集から脱却し、データの品質、可視性、統合を高めることが急務です。

そのため、企業は以下の点に注力する必要があります。

データガバナンスの強化

データの信頼性と一貫性を高めるため、データの管理体制を整備し、企業全体で利用可能な形に統合することが必要です。

リアルタイムデータへのアクセス

ビジネスに即応できるデータインフラを整え、タイムリーに意思決定を行う基盤を確立することが、変化の速い市場環境で成功するカギとなります。

データ分析能力の強化

高度な分析ツールやAIを導入し、データから洞察を引き出し、業務プロセスや顧客体験の向上に役立てる必要があります。

データ駆動型の企業文化を構築するためには、これらの取り組みを段階的に進めることで、長期的な競争優位を確保することができます。

ベネフィット: 広範かつ迅速なデータアクセス

業務上の価値創出は、単一の手順に従うものではなく、企業の戦略に応じて多様な方法が求められます。企業ごとに「業務上の価値」の定義が異なるため、各企業のCDOがその基準を設定する必要があります。たとえば、サプライチェーンの最適化を最優先とする企業にとっては、運用効率の向上が価値を生み出します。一方、マーケティングに力を入れている企業では、マーケティングアナリティクスの強化が価値を生む手段となるでしょう。

これらのビジネス目標が異なるにもかかわらず、すべての企業が享受できる共通の利点があります。それは、正確なデータを迅速に適切な担当者に提供できることです。この利点は、組織全体においてコスト削減や信頼性向上、精度改善といったKPIを支える要素となります。

特に「すべてのデータ利用者に対して、いかに迅速にデータを提供できるか」という点は、多くの企業にとって重要な考慮事項です。手動によるデータ提供は時間がかかり、業務のスピードを阻害します。しかし、自動化されたデータマーケットプレイスの導入により、組織内のデータ需要に即座に対応できる環境が整います。これにより、正確なデータが一貫した方法で広範囲にわたり迅速に利用できるようになります。

最近の調査によれば、イノベーションに成功している企業の約8割程度が、社内外でのデータ共有に強力なプロセスを持っています。データマーケットプレイスは、これらのプロセスを支える一つの解決策です。データ取得の障壁を取り除き、手作業によるデータ配信を自動化することで、信頼性の高いデータを迅速に利用者に届けることができます。

これにより、組織全体の効率性が向上し、チームメンバーはより重要なタスクに集中できるようになります。さらに、迅速なデータ提供はリーダーの意思決定を加速させ、企業に対するインパクトを迅速に実現する助けとなります。

例として、データガバナンスチームは、COVID-19の影響を病院システムに迅速に反映させるために、管理されたデータを自動的にTableauのダッシュボードに取り込み、経営層に対する意思決定を支援しました。このように、データの即時性と正確性が、危機的な状況下での迅速な意思決定を可能にしたのです。

このように、データの迅速な提供や自動化の利点を強調することで、企業全体の業務効率と意思決定速度が向上し、最終的に組織の競争力を高めることができます。

ベネフィット: データリテラシーと価値に対する理解の向上

自動化されたデータマーケットプレイスの利点は、単に迅速なデータ配信にとどまりません。それは、データリテラシーを向上させ、組織全体でデータの価値を理解するための重要な基盤となります。しかし、データの理解を深めるには、共通の言語を持つことが不可欠です。Gartner社によると、「データリテラシーは、データ戦略やアナリティクス戦略、変更管理プログラムの約80%以上に正式に含まれており、2023年までには業務上の価値を推進するための不可欠な要因となる」と予測されています。

では、データリテラシーとは具体的に何を指すのでしょうか?ある先進的な企業のデータ担当役員は、「データリテラシーとは、データを社内の第2言語として活用する能力」と定義しています。この定義に基づけば、データ辞書やビジネス用語集、定義の文書化はデータリテラシーを高めるための第一歩となります。しかし、真のデータリテラシーとはそれだけではありません。それは、「データの意味」を理解するだけでなく、組織全体のデータ環境における入出力について他者と効果的にコミュニケーションできる能力を指します。

例えば、ビジネスリーダーが自身のデータニーズをITリーダーに明確に伝え、そのニーズがITチームによって理解され、迅速に対応されることは、データリテラシーが組織に根付いている一例です。データリテラシーがあることで、ビジネスリーダーはデータの要求だけでなく、データを適切に理解し、その分析結果をビジネス戦略に活用できるようになります。

データリテラシーは、単にデータの取り扱いにとどまらず、組織内の文化変革をもたらします。これにより、組織はデータ主導の意思決定を行う基盤を築くことができます。デジタルトランスフォーメーション(DX)を成功させるためには、従業員がデジタル化の重要性を理解し、データを活用して効果的に意思決定を行うスキルを身に付けることが不可欠です。つまり、データリテラシーは、DX推進の根幹を支える能力であり、組織の競争力を向上させる大きな要素となります。

ここでは、データリテラシーの定義や、その重要性がDX推進にどのように貢献するかを強調しました。また、データリテラシーの向上が単なる技術的課題ではなく、組織文化全体の変革につながるという点を明確に示しています。

ベネフィット: 効率性と生産性の向上

手作業でデータを個々の利用者に届けることは、確かに可能ですし、実際に多くの企業がそのようにしてデータの民主化を進めています。このプロセスでは、業務担当者がデータを要求し、データオペレーターがその内容を解釈して提供する一連の作業が行われます。しかし、このアプローチは多くの課題を抱えています。例えば、要求の解釈ミスや情報のやり取りの多さが原因で、業務に必要なデータが遅れてしまうことが頻繁に発生します。特に、データ利用者の数が急増したり、技術スキルが均一でない場合には、データオペレーションがボトルネックとなり、業務効率に大きな影響を及ぼす可能性があります。

スケーラビリティの限界

この問題に対処するために、データオペレーションチームを増強することも考えられますが、これは長期的な解決策とはなりません。なぜなら、このアプローチには拡張性がなく、リソースを増やしても非効率なプロセスが根本的に改善されないためです。

自動化されたデータマーケットプレイスの活用

このような状況で、自動化されたインテリジェントなデータマーケットプレイスが効果を発揮します。これにより、データ利用者はセルフサービス形式で必要なデータにアクセスできるようになり、データオペレーションにかかる時間と労力を大幅に削減できます。利用者は簡単に必要なデータを検索し、情報の意味や背景を理解した上で利用することができます。データマーケットプレイスは、コンテキストを提供するだけでなく、プロビジョニングプロセスを自動化することで、データの配信まで一貫して行います。この「プロビジョニング」のステップにより、利用者の要求は「欲しいものリスト」から、信頼性の高いデータをシームレスに提供する実際のプロセスへと進化します。

自動化による生産性の向上

この自動化されたプロセスにより、データ提供における重複作業が大幅に削減され、CDOは同じ要求に対して何度も対応する必要がなくなります。さらに、CDOのチームが認定した信頼性のあるデータが提供されるため、データ利用者が得る結果の信頼性も向上します。これにより、データチームに高額なリソースを割かずに効率を拡張し、組織全体でデータを活用した迅速な意思決定が可能になります。

今日のCDOの役割は、データを通じて業務上の価値を創出することです。自動化されたインテリジェントなデータマーケットプレイスを導入することで、CDOはデータと人材を効果的に結びつけ、エンドツーエンドでのプロセス自動化を推進し、業務全体の効率化と生産性の向上を実現できます。

ここでは、データコンサルタントの視点から、データ管理と自動化が業務効率に与える影響を強調し、特にスケーラビリティと自動化による価値創出の観点を追加しました。

データクリーニングの重要性

信頼性の低いデータに基づいた分析では、正確なビジネス判断を下すことは困難です。不正確なデータは誤った意思決定を導き、長期的には業務効率の低下やコストの増加につながるリスクがあります。そのため、重複データ、外れ値、関連性のないデータの排除、そして欠損値や構造的エラーの修正を行うデータクリーニングは、ビジネスにおける分析基盤の構築において不可欠なステップです。

課題とリスク 多くの組織では、スプレッドシートを使った手作業でのデータクリーニングが一般的ですが、これは大幅な時間の浪費を招きます。手動での作業は、計算ミスやデータの重複、誤ったデータ型の適用など、ヒューマンエラーのリスクが高まります。また、データの整合性を維持しつつ、効率的に処理を進めることが難しいという課題があります。

さらに、データセット全体を適切に理解し処理するためには、各フィールドを個別に検証しなければならないことが多く、この作業が正確性や網羅性に欠ける場合、分析結果の信頼性が低下します。

解決策と効率化のポイント

データクリーニングプロセスの自動化は、これらの課題を解消します。例えば、最新のツールを利用することで、データの不整合やエラーを検出し、自動的に最適なデータ型を割り当てることができます。また、新しい列の作成や行の削除といった操作をワンステップで適用できるため、クリーニングに要する時間を大幅に短縮することが可能です。

さらに、データの健全性、品質、統計的分布を視覚的に把握できるツールの導入により、変更の影響をリアルタイムで確認しながらクリーニングを進められ、分析プロセス全体の透明性と信頼性が向上します。

データプロファイリングと理解の深化

データプロファイリングは、データの構造や関係性を理解するための重要なステップです。SQLなどの専門スキルが求められるケースもありますが、基本的なデータプロファイルツールを活用することで、フィールドごとのメタデータ取得を自動化し、データの理解を効率化できます。

さらに、可視化ツールを用いることで、データセットの主要な統計情報やトレンドを視覚的に把握でき、データに対する包括的な理解が深まります。このようなアプローチにより、データの質を高め、信頼性のある意思決定を支援することが可能です。

これにより、データコンサルタントの視点で、データクリーニングのプロセスがいかにビジネスに対して重要であるか、またそれを効率化するための自動化ツールやプロファイリング手法の活用の意義が強調されました。

データパフォーマンスの課題と改善策

ライフサイエンス企業が迅速に実用的なインサイトを得るためには、膨大なデータを効率よく処理し、短時間で分析結果を導き出す能力が求められます。特に、臨床試験データの統合、検証、データマイニングの迅速化は、医薬品開発において極めて重要です。加えて、データの活用によってマーケティングキャンペーンの最適化、在庫管理やサプライチェーンロジスティクスの効率化も可能になります。

しかし、多くのライフサイエンス企業は低速なレガシーシステムに依存しているため、以下のような課題に直面しています。

データサイロの悪化:情報が部門ごとに分断され、統合的なインサイトが得られにくい。

断片的なインサイト:手動によるデータ処理が多く、一貫性のない結果が得られやすい。

拡張性の欠如:ユーザーやデータが増加しても、システムがスムーズに拡張できない。

迅速な対応の難しさ:公衆衛生上の危機において、製薬会社が迅速に対応できない可能性がある。

ソリューション:データパフォーマンスの向上

こうした課題を解決するために、「全部調べる君」(仮想のデータ統合プラットフォーム)を導入することで、データパフォーマンスを大幅に向上させることが可能です。このソリューションは以下の特徴を持ちます。

複数のデータソースからの統合:異なるソースのデータを迅速かつ効率的に処理し、一元化されたデータリポジトリに集積できます。これにより、複雑なETL(Extract, Transform, Load)プロセスを簡素化し、様々なデータソースに対応可能です。

同時に複数のデータワークロードに対応:複数のユーザーがリアルタイムでデータリクエストを行っても、システムは効率的にリクエストを処理し、異なる分析ニーズをサポートします。

セルフサービスアナリティクス:データサイエンティストだけでなく、非技術部門のユーザーでもリアルタイムデータにアクセスでき、迅速な意思決定が可能となります。これにより、イノベーションが加速し、救命製品の開発期間を短縮できます。

データエクスチェンジとコラボレーション

データパフォーマンスをさらに向上させるには、企業間のデータエクスチェンジとコラボレーションが不可欠です。ライフサイエンス企業は、さまざまなパートナー企業や組織とセンシティブなデータを共有し、より精度の高いインサイトを得ることが求められています。

課題:

安全なデータ交換の難しさ:異なるレガシーシステムが存在するため、迅速かつ安全なデータ交換が難しく、FTPなど手動でのデータ転送に依存することが一般的です。これはセキュリティリスクやプロセスの遅延を引き起こす可能性があります。

ソリューション:

統合されたデータエクスチェンジプラットフォーム:安全で効率的なデータ転送を実現するためには、APIベースのデータエクスチェンジプラットフォームを導入することが効果的です。これにより、異なるシステム間でのリアルタイムなデータ共有が可能になり、手動によるプロセスを自動化し、セキュリティを向上させることができます。

コンサルタントの視点でのまとめ

ライフサイエンス企業は、データパフォーマンスの向上が、迅速な製品開発や市場投入を実現するために不可欠です。レガシーシステムからの脱却、データサイロの解消、そして効率的なデータエクスチェンジによって、組織全体でのインサイト獲得が加速し、より競争力のあるビジネス展開が可能になります。また、最新のデータプラットフォームを活用することで、セルフサービスアナリティクスやリアルタイムデータに基づいた迅速な意思決定が組織全体で実現できるでしょう。