目次

セキュアで信頼性の高いデータ提供の重要性

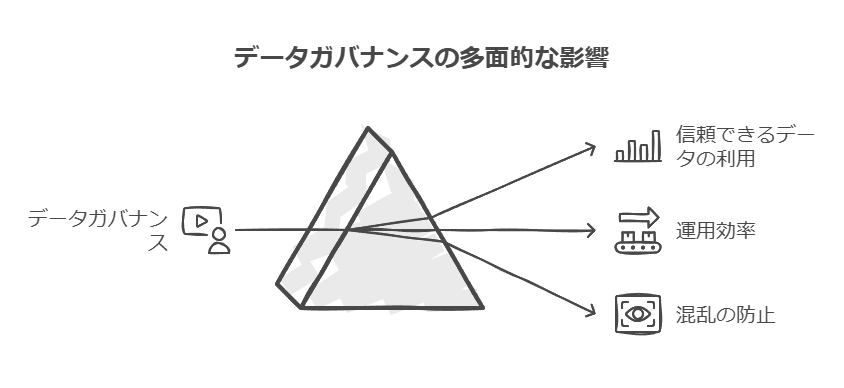

セルフサービス分析を導入している多くの組織が直面する課題は、データの管理や使用方法における混乱です。データが意図しない方法で利用されたり、重複したり、管理されていない場所に保存されることが多々あり、最終的にはデータ品質の低下や業務効率の低下につながります。これに対処するためには、データガバナンスの強化が不可欠です。

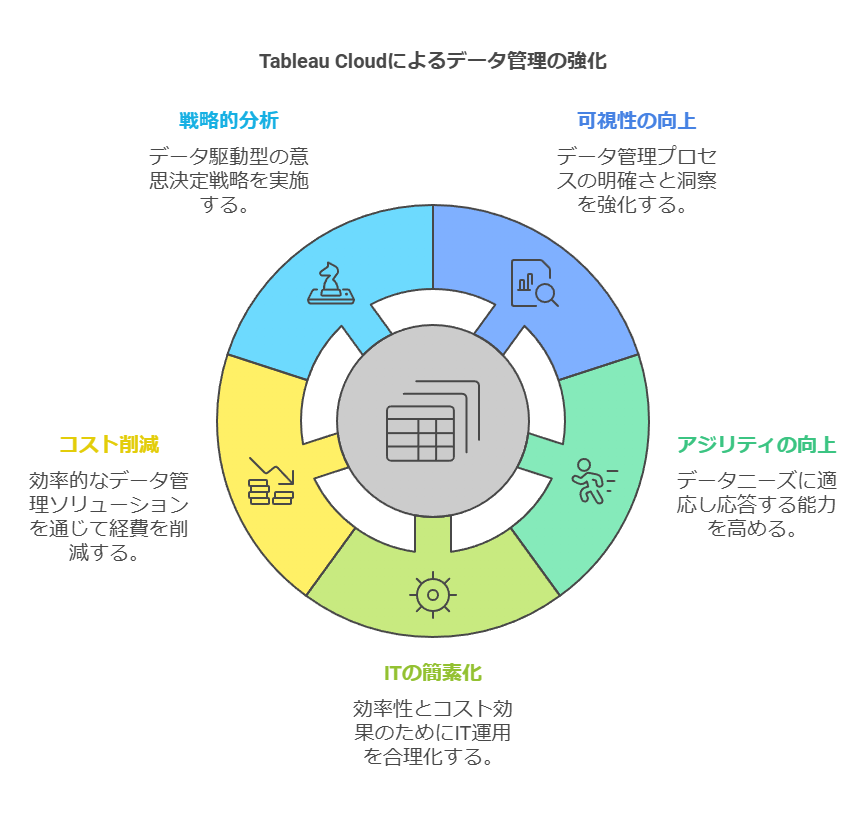

現代のITリーダーには、データ管理を実施しながら、組織全体でデータの最大活用を促進するという両立したアプローチが求められています。これにより、各ユーザーが適切なデータを重複なく活用し、迅速にデータに基づいた意思決定ができる環境を構築できます。

Tableau Cloudを利用することで、組織はこのバランスを保ちながらデータ管理の可視性、自由度、アジリティを最大限に活かすことが可能です。

Tableau Cloudのプラットフォーム機能

1. ユーザーベースのライセンスと管理機能

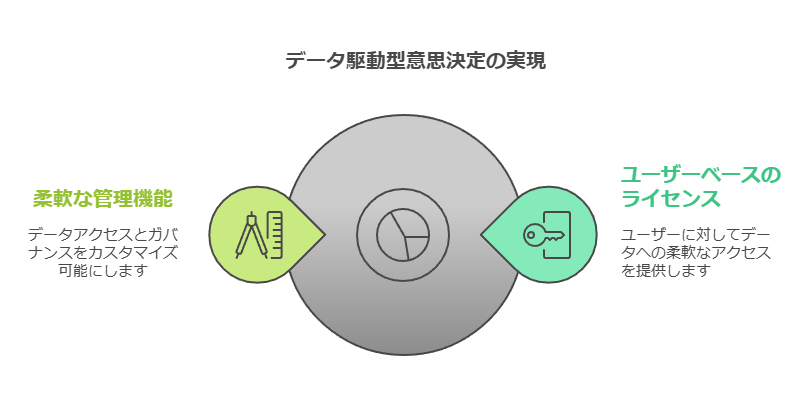

Tableau Cloudのライセンスシステムは、ユーザーベースの柔軟な管理機能を提供します。これにより、データが組織全体で幅広く導入されながら、各ユーザーが自分に必要なデータにアクセスし、データに基づく意思決定を確実に実行できる環境が整います。

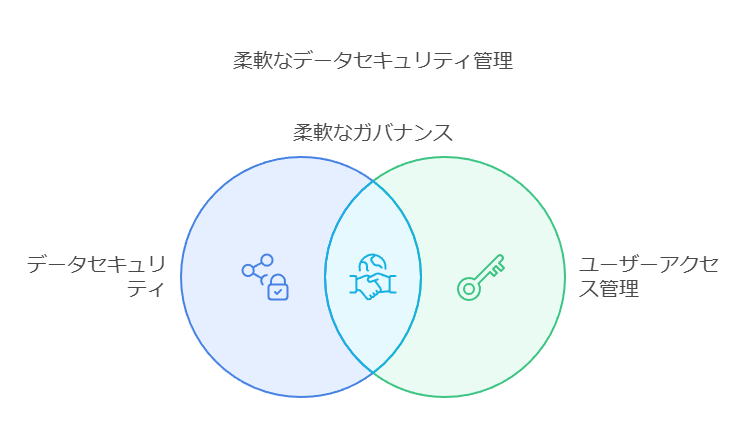

2. カスタマイズ可能なガバナンスとセキュリティ

Tableau Cloudは、ガバナンス機能のカスタマイズ性に優れており、データベース内(行レベルを含む)やTableau内、またはその両方でセキュリティを導入できる柔軟性を持っています。これにより、データガバナンスの一環として、データのセキュリティレベルを細かく調整し、特定のユーザーや部門に適切なアクセス権限を割り当てることが可能です。

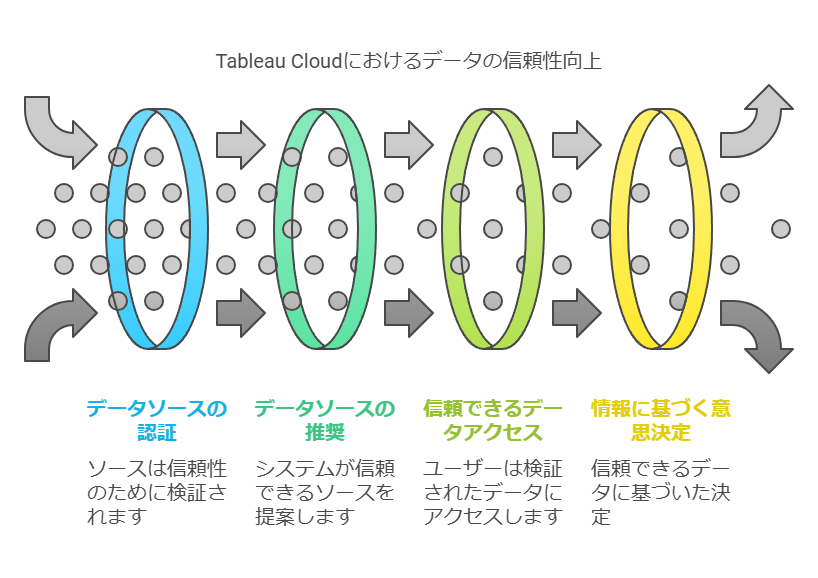

3. 信頼性のあるデータソースの推奨

Tableau Cloudの推奨機能により、認証済みの信頼性の高いデータソースや指標が自動的に提示され、ユーザーは信頼できるデータに基づいた意思決定を行うことができます。これにより、データの正確性や一貫性を保ちながら、セルフサービス分析の信頼性が向上します。

IT運用の簡素化とコスト削減

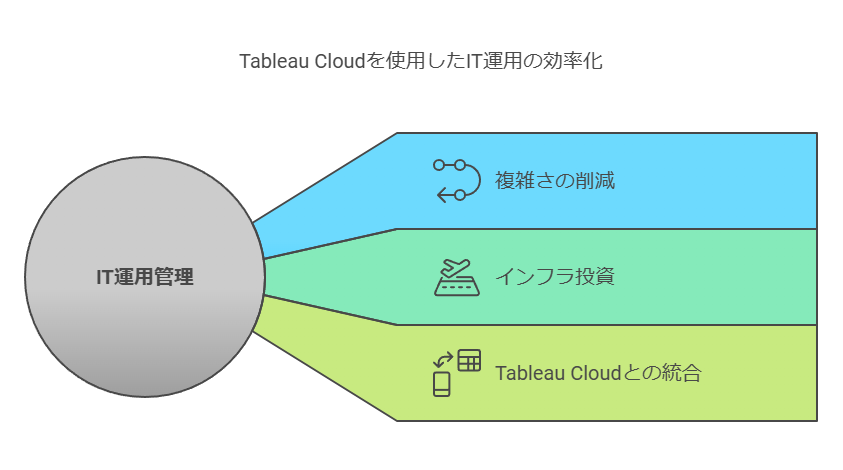

IT部門が直面する最大の課題は、複雑なシステムの運用管理です。特に、手順の整備やシステムの最新状態の維持、さらにはコンプライアンス遵守など、多くの責任が伴います。その結果、高コストな運用が発生し、企業全体のリソースを圧迫する要因となります。

この問題を解決するための鍵は、複雑さを減らしつつ、既存インフラへの投資を有効に活用できるソリューションを選ぶことです。Tableau Cloudを利用することで、従来のシステムを犠牲にすることなく、迅速かつ柔軟に既存のアーキテクチャと緊密に統合することが可能です。これにより、ITコストの削減と運用効率の向上が同時に実現できます。

データコンサルタントの視点から見たポイント

データガバナンスの重要性:セルフサービス分析が広がる中で、データの管理とガバナンスは必須です。適切なガバナンスを導入することで、データの利用者が信頼できるデータを利用できるだけでなく、運用における混乱を防ぐことができます。

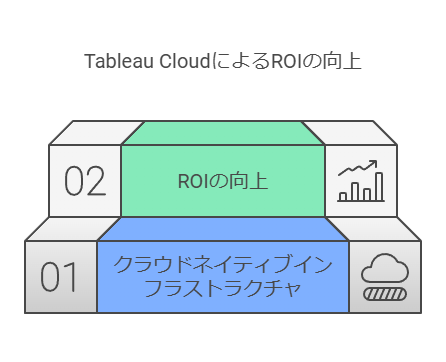

ROIを高めるIT運用の効率化:Tableau Cloudの導入によるクラウドネイティブ環境の構築は、既存のインフラストラクチャに依存せず、柔軟でコスト効率の高いIT運用を可能にします。これにより、**投資対効果(ROI)**が向上し、データを最大限に活用するためのインフラが整備されます。

ユーザーのセルフサービス能力の向上:データの可視化とアクセス権限の適切な管理により、エンドユーザーのデータ活用能力が飛躍的に向上します。これにより、組織全体が迅速にデータドリブンな意思決定を行えるようになり、業務全体のパフォーマンス向上につながります。

データコンサルタントとして、Tableau Cloudの導入は単なるITソリューションの選定にとどまらず、データ管理の適正化、ITコストの削減、そして最終的にはビジネス全体の競争力強化に寄与するものだと考えます。

完全ホスティング型による効率的なサポート

サーバーの構成やソフトウェアアップグレード、ハードウェアの拡張を一切気にすることなく、完全ホスティング型のサポートにより運用がシンプルになります。さらに、SOC 2やISOなどの最高クラスのセキュリティ認証規格に対応したインフラを維持し、常に最新の状態でセキュリティを確保します。

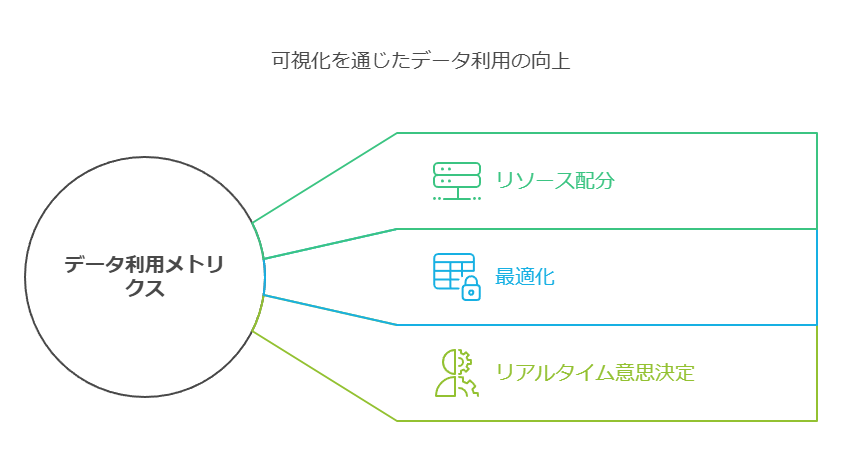

データの利用状況を把握し、業務効率を最大化

誰がどのデータを、どの頻度で使用しているかを可視化するメトリクスにアクセスすることで、データ利用の効率を分析し、リソース配分や最適化に活用できます。これにより、リアルタイムでのデータドリブンな意思決定を支援します。

あらゆるスキルレベルのユーザーがインサイトを迅速に取得

従来のレポートツールでは、技術的な専門知識が必要でしたが、Tableau Cloudでは、コーディングスキルがなくても誰もが直感的に使える分析環境を提供します。高度なAIや機械学習機能を活用し、複雑な質問にも素早く対応できるため、業務のスピードと正確さが大幅に向上します。

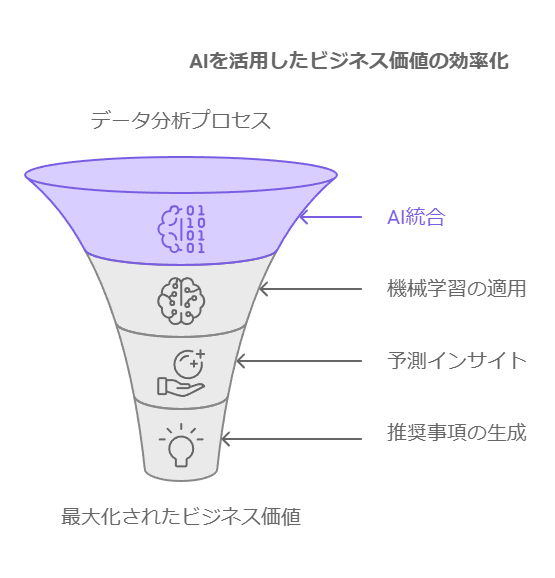

AIと機械学習で生産性向上

AIや機械学習を活用したTableauのEinstein Discovery機能により、予測や推奨事項を迅速に得られます。また、手作業による分析の手間を大幅に削減し、ビジネス価値を早期に最大化します。

強力なコミュニティによるサポート

世界で最も信頼されるデータコミュニティ #DataFam のサポートにより、組織全体でデータ活用を推進し、成功を収めることが可能です。

改善ポイントのまとめ:

各機能や利点をテーマごとに整理し、技術的な要素とビジネス的な効果を明確に区別。

簡潔かつ効果的な表現を用い、読者が理解しやすいように文章をリフロー。

リアルタイムのインサイトで特別な顧客体験を提供

Salesforce Customer 360を支える最新のリアルタイムデータプラットフォームであるSalesforce CDPにより、データドリブンな顧客体験を実現します。Salesforce CDPは、複数のチャネルからのデータを一元的に統合し、常に最新の信頼できる情報源を提供します。この情報に基づき、Tableauを活用して特別な顧客体験を作り出すことが可能です。

シームレスなデータ接続とリアルタイムインサイトの獲得

Tableauは、複数のデータソースへの接続を容易にし、Salesforce Customer 360の他の製品群とシームレスに連携します。これにより、リアルタイムのインサイトをスムーズに獲得し、迅速な意思決定を支援します。

Tableauが提供するユーザー機能

自動化されたワークフローの作成: Tableau Cloudで、データからタイムリーなインサイトを得るためのワークフローを自動化し、業務の効率化を図ります。

Einstein AIとの連携: Salesforce CDPからのデータを活用し、Einstein Discovery機能により、生データから即時に実用的なインサイトを引き出すことが可能です。

Slackとの統合: TableauのSlack統合機能により、リアルタイムで得られたインサイトをチームと共有し、即座に連携・行動に移すことができます。

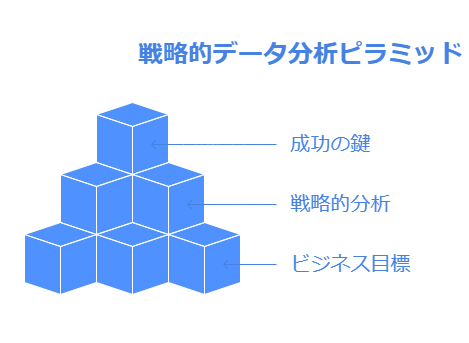

目標に基づいたデータ分析の重要性

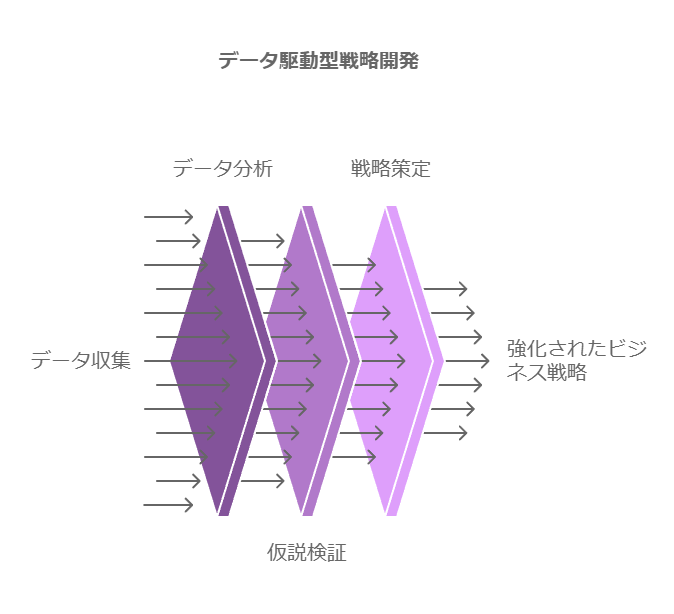

データ分析を始める際には、「売上向上」や「集客アップ」といった最終的なビジネス目標を明確に定めることが不可欠です。単なるデータ分析ではなく、具体的な目標に沿った戦略的な分析が成功のカギとなります。

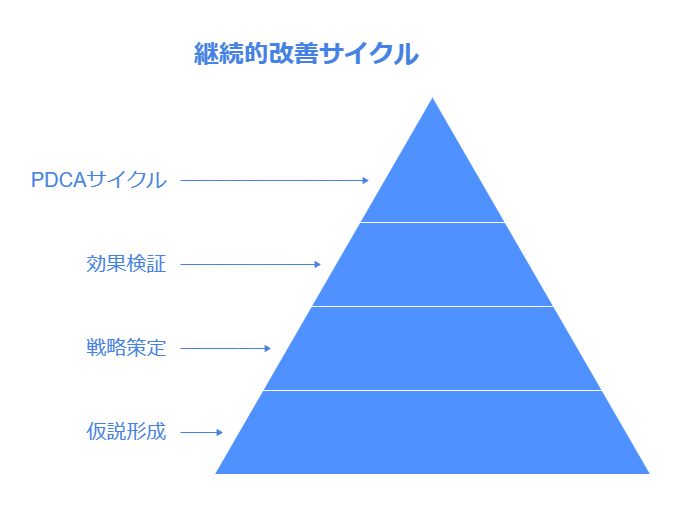

仮説構築とPDCAサイクルの活用

次に、データを基に仮説を立て、具体的な施策を策定します。その施策の効果を検証し、新たな仮説を構築して分析を繰り返すPDCAサイクルを実行します。これにより、施策の効果を継続的に改善し、目標達成に向けて進化させることが可能です。

データ収集と迅速な分析の実行

社内データ、公的データ、外部から購入したデータなど、あらゆるソースから必要なデータを収集し、迅速に分析を行います。このプロセスは、新しいサービスや製品を開発する際にも活用可能です。データに基づく仮説を検証し、より精度の高い戦略を構築しましょう。

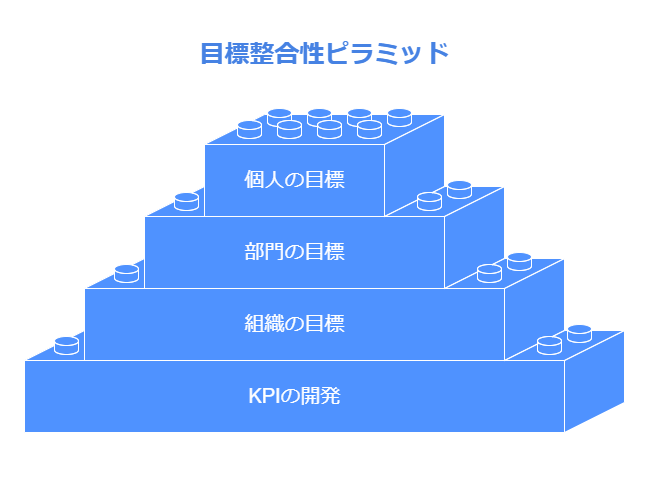

KPIの策定と目標達成

単なるデータ分析に留まらず、KPI(重要業績評価指標)を策定し、組織全体、各部門、個人の目標に結び付けることが重要です。これにより、組織全体で目標に向けた進捗を把握し、具体的な行動を計画・実行できます。

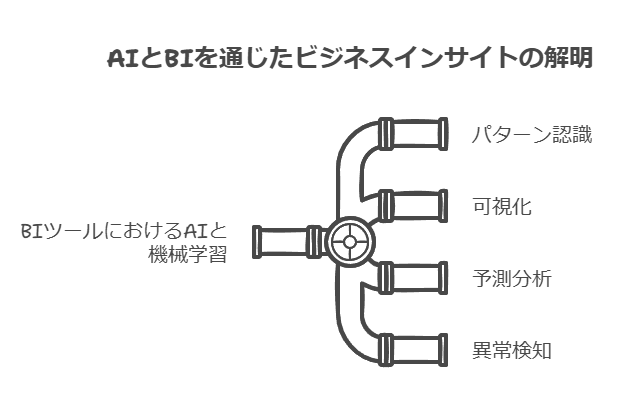

AIとBIツールの連携で高度な予測を実現

最新のBIツールはAIや機械学習を活用し、データの特徴やパターンを見つけ出し、それを人間が理解しやすい形に可視化します。これにより、行動パターンの予測や異常検知など、業務効率を大幅に向上させることが可能です。

組織全体のデータリテラシー向上

データドリブン経営を実現するためには、経営層がリーダーシップを発揮し、BIツールを積極的に活用することが重要です。これにより、全社的なデータ文化が醸成され、組織全体の意思決定がより迅速かつ正確に行えるようになります。

Excelの強みと限界

Excelは多様な分析ツールを備えており、相関分析、分散分析、ヒストグラム、回帰分析など19種類の分析に対応しています。しかし、強力なツールである一方で、運用上の課題や性能面での限界が見受けられます。以下では、Excelの主な5つのデメリットとそれに対する対策や代替案を考察します。

データ量の増加によるパフォーマンス低下 Excelでは1MB、1,000行、500列を超えるデータでも分析は可能ですが、データ量が増えると処理速度が著しく低下します。最悪の場合、アプリがクラッシュすることもあります。大規模データを扱う場合、Excelのパフォーマンスに限界があるため、BIツールやクラウドベースのデータプラットフォーム(例: Power BI, Tableau, Google BigQuery)への移行を検討する必要があります。これらのツールは大規模なデータ処理に優れており、処理速度や安定性が向上します。

複数人での同時編集と管理の煩雑さ OneDriveなどのオンラインストレージを利用することで、複数人での同時編集は可能ですが、バージョン管理が複雑化し、編集履歴の追跡が困難です。これに対して、データベース連携や共同編集に特化したプラットフォーム(例: Google Sheets, SharePoint, Airtable)を活用することで、より効率的なバージョン管理と編集履歴のトラッキングが実現可能です。

レポート作成の手間 Excelでのグラフ化やPowerPointへの転送など、レポート作成には多くの手作業が伴います。自動化が進んでいないため、手間がかかる点が課題です。これを解決するために、BIツールや自動レポート生成機能を活用することで、リアルタイムにデータ可視化やレポート作成を行うことができ、手作業を大幅に削減できます。

複雑で多様な要素を含む分析の難しさ Excelでは、複数の要素を統合した高度な分析は難しく、専門的な知識が必要です。たとえば、来店者数と天候など複数の要因を組み合わせた分析には限界があります。これに対して、機械学習プラットフォームやR/Pythonなどのプログラミング言語を用いた分析環境を構築することで、複雑な要素を含むデータ解析がより柔軟に実現可能です。

分析が属人化しやすい Excelでの分析は、操作が個人のスキルに依存しやすく、属人的になりがちです。特定の担当者のみがツールの使い方や分析手法を理解している場合、属人化のリスクが高まります。これを防ぐために、標準化された分析フレームワークやワークフローの導入が有効です。また、チーム全体でのデータリテラシーを高める研修や教育も重要です。

結論 Excelは強力な分析ツールですが、データ量や複雑な分析、共同作業には限界があります。これらの課題を解決するために、適切なBIツールやクラウドプラットフォームへの移行を提案します。これにより、より効率的でスケーラブルなデータ活用が可能となり、組織全体でのデータドリブンな意思決定が促進されます。

データ保存の進化と最適な選択肢

取得したデータは、分析や運用に活用するため、適切に保存することが重要です。従来は、データを構造化された形式で保存し、特定のフィールドにデータを入力してデータベースに保存するリレーショナルデータベース(RDB)が主流でした。例えば、「教科単位」と「クラスサイズ制限」というフィールドがデータベースにある場合、収集したデータはそれぞれのフィールドに適切に入力され、トランザクションに役立つ形で保存されていました。

このリレーショナルデータベースは、特にトランザクション処理において非常に効率的であり、過去数十年にわたり、膨大なトランザクションデータを処理する際の標準的な方法でした。例えば、教科単位で成績を乗算するような操作は、このようなデータベースの典型的な利用例です。しかし、トランザクションではないデータや、事前に定義された「フィールド」にうまく当てはまらないデータに関しては、このモデルでは情報が制限され、分析に必要な柔軟性を欠く場合があります。

現代のデータ管理のニーズとソリューション

現在では、データの種類や利用目的に応じて、より柔軟で高度なデータ管理システムが求められるようになっています。特にクラウド環境でのデータ活用が主流となる中、リレーショナルデータベースの限界を補完する新しい技術が登場しています。以下は、現代のデータ管理ニーズに対応した代表的なクラウドベースのデータベースソリューションです。

時系列データ管理:Amazon Timestream 時系列データ(例えば、産業用センサーや市場活動を経時的に追跡するデータ)を効率的に管理するために特化したデータベースです。時系列データは、時間の経過とともに発生するデータであり、そのトレンド分析に特化したインフラが必要です。Timestreamはこのニーズに応え、効率的なストレージとクエリ性能を提供します。

履歴データの検証:Amazon Quantum Ledger Database (QLDB) ブロックチェーンのように、データ履歴の検証が求められるシステムに対応しています。暗号化を使用してデータの整合性を維持し、トランザクションの正確な追跡が可能です。特に金融や物流分野でのデータ管理に適しています。

グラフデータベース:Amazon Neptune ソーシャルネットワークや複雑なつながりを持つデータの管理に特化しています。グラフデータベースは、ノード(個人や物)とエッジ(関係性)を表現し、複雑なデータ間の関連性を視覚的に捉えることができ、関係性の解析やネットワーク分析に最適です。

データ管理の現代的アプローチ

エンタープライズにおいて、データをリレーショナルデータベースの枠に強制する必要はなくなり、データの性質や用途に応じて最適なデータベースを選択することが可能になりました。これにより、データ分析や運用がより柔軟かつ効率的になり、ビジネスの俊敏性が向上します。今後は、データの種類ごとに適切なデータ管理インフラを選択し、分析やビジネス価値の最大化を図ることが鍵となります。

データサプライチェーンの再評価が成功への鍵

多くの企業は、データを活用して競争優位を築きたいと考えています。しかし、効果的なデータ活用には、データの取り込みから処分までのデータサプライチェーンを再精査する必要があります。現状、多くの企業がこのプロセスをまだ十分に最適化できていません。

データリーダーの成功要因

先進的な企業リーダーたちは、データ活用において他社よりもはるかに優れたポジションにあります。60%のリーダーが全従業員にデータアクセス権と分析ツールを提供しているのに対し、他社ではその割合がわずか7%です。これは、データの民主化が企業の成功に直結するというリーダーの強い認識によるものです。

多くの企業では、データの管理と利用にギャップが生じています。ハモンド氏は次のように述べています。

「データを理解している人がデータを管理し、データを理解していない人がデータを必要としている。このギャップこそが真の問題です。」

データサイエンティストや専門家に依存したデータ管理は、長期的にスケールしないため、これが問題の根源です。セルフサービス分析は、このギャップを埋め、従業員がデータを直接利用し、その価値を引き出すための手段として非常に効果的です。

セルフサービス分析の導入: データの信頼性と理解を強化

セルフサービスの分析ツールを導入することで、従業員はエンジニアのサポートに依存することなくデータにアクセスでき、データを信頼し、理解するスキルが向上します。これにより、組織全体が迅速かつ効率的にデータに基づいた意思決定を行えるようになります。

データの価値を引き出すための投資

では、なぜ多くの企業がデータに対する投資をためらうのでしょうか?シンミン氏は次のように指摘しています。

「データは新しい石油だと言われていますが、実際には多くの企業にとって古い石油です。まるで、価値を引き出されるのを待っているバレルの中の石油のようなものです。」

企業はデータに価値があると認識していますが、それを実際のビジネス成果に変える方法を理解できていないのです。データを実用的で価値のあるインサイトに変換するためには、適切な処理と活用が必要です。データは単に保存されるものではなく、適切なツールやプロセスによってビジネスに活用されるべきリソースです。

データ投資の成果を測定し、ビジネス価値をつなげる

企業がデータから価値を引き出すためには、データ投資の効果を明確に測定し、ビジネス成果と結びつけることが重要です。10人中8人の企業リーダーが、データと分析への投資がもたらすビジネス成果を測定し報告することが重要だと答えていますが、多くの企業はこの点で苦慮しています。

結論:データ活用のための戦略的アプローチ

データから価値を引き出すには、単にデータを保有するだけではなく、組織全体でデータを活用するカルチャーとツールを整えることが必要です。セルフサービス分析の導入や、データサプライチェーンの再評価により、企業は競争力を強化し、ビジネス成果を向上させることができます。

データカタログとは?迅速に必要なデータへアクセスするための基盤

企業が迅速で正確な意思決定を行うためには、セルフサービスBIや分析ツールを活用したデータ分析が不可欠です。しかし、データ分析担当者が膨大なデータリポジトリから直接データを取り出すだけでは、正確で整理されたデータを即座に活用することは難しくなります。そこで登場するのが「データカタログ」です。

データカタログは、メタデータ管理の仕組みとして、データ管理者以外のデータ分析担当者が容易にデータを扱えるように設計されています。これにより、データサイエンティストやデータアナリストは、管理されたデータを自由に検索・取得でき、目的に応じた正確なデータを迅速に利用することが可能になります。

データカタログの主な機能とメリット

データカタログツールは、データウェアハウスやデータベース管理システムに保管されている膨大なデータを対象に、データの分類やガバナンスに関する情報を提供します。これにより、データ分析担当者は、データに関するメタ情報を理解し、分析に必要なデータセットを効率的に探し出すことができます。

さらに、データカタログは、データガバナンスの一環として、アクセス権の管理やデータの誤用防止にも大きな役割を果たします。ポリシーやルールを自動的に適用することで、データ管理者やガバナンス責任者は、不正アクセスの防止やデータの適正な利用を確保することができるのです。

データカタログ導入の背景とニーズ

企業が業務で生成・収集するデータの量は急速に増加しており、その中にはデータのプライバシー保護に関する規則に従う必要があるものも含まれます。EUの「一般データ保護規則」(GDPR)や米国カリフォルニア州の「カリフォルニア州消費者プライバシー法」(CCPA)など、厳しい規則への対応が求められる中、データカタログツールの重要性はますます高まっています。

データカタログの導入が企業戦略に与える影響

調査会社Gartnerは、企業のデータ戦略を成功に導くために、データカタログツールが重要な役割を果たすと指摘しています。特に、以下の点においてデータカタログの活用が効果的です。

利用可能なデータのメンテナンス、収集、整理

データの質と正確性を維持するために、データカタログを通じて一元管理することで、最新かつ適切なデータに即座にアクセスできる環境を構築します。

データ提供フローの確立

データ分析担当者とデータ管理者の間でスムーズなデータ提供フローを確立することで、データ利用のプロセスを最適化し、業務効率を向上させます。

まとめ:データカタログの導入によるデータ活用の効率化

企業がデータドリブンな意思決定を行うためには、データカタログを活用してデータの管理とアクセスを効率化することが必要不可欠です。データカタログは、単にデータを管理するだけでなく、データの信頼性や正確性を保ちながら、データの価値を最大化するための強力なツールです。企業のデータ活用戦略において、データカタログの導入は、業務の効率化とガバナンス強化に貢献し、ビジネスの成功を後押しします。

過去の経験を活かし、想定外のリスクを回避する

多くの企業は、デジタル変革を進める中で開発組織を再構築してきました。その過程で得た教訓は、クラウドネイティブアプリケーション開発の成熟度を高め、リスクを回避するために重要な役割を果たしています。これらの教訓は、企業の戦略、ガバナンス、人材の管理にまたがり、特にデータ活用と分析の重要性が浮き彫りになっています。

1. 戦略的教訓:データ分析とビジネス価値の活用

クラウドネイティブアプリケーションの導入に伴い、企業が得た最も重要な戦略的教訓は、アナリティクスの進化とビジネス価値の創出が密接に関連していることです。企業は、データ分析を進化させることで、生産性の向上や能力の最適化を図り、成熟したデジタルインフラを築いてきました。

特に、データから得られるインサイトを活用して、クラウドネイティブの開発がどのようにキャッシュフローを生み出し、ビジネスを持続可能にするかを示すことができるようになります。これにより、企業は自己資金によるイノベーションを実現し、さらなる成長へとつなげることが可能となります。

2. ガバナンスの教訓:草の根レベルのサポートとリーダーシップの統合

企業がクラウドネイティブ開発を成功させるためには、適切なガバナンスモデルが不可欠です。ここでの教訓は、リーダーシップの支援と草の根レベルの取り組みを統合し、全体的な組織構造を整備することです。

成功の鍵は、明確なエスカレーションパスと説明責任の基準を確立し、開発チームが問題を管理しやすい環境を作ることです。ガバナンス体制が整備されることで、チーム間の調整がスムーズになり、データガバナンスの徹底が企業全体に浸透します。特に、データサイエンスや分析の領域では、データ管理とガバナンスの強化が、企業の成長を支える基盤となります。

3. 人材管理の教訓:変革文化とスキルの継続的な強化

変革を推進する上で、成功は最終的には人材のマインドセットとスキルに依存しています。企業は、変革を受け入れる文化を育むことが必要であり、そのためには継続的なトレーニングと教育を提供する体制が不可欠です。スキル開発とトレーニングに投資することで、従業員は新しい技術やデータ主導の意思決定に対応できるようになり、組織全体が変革を推進する力を持つようになります。

特に、変革実践コミュニティを奨励する文化を育てることで、草の根レベルからの変革が企業全体に浸透し、データドリブンな意思決定が可能になります。このような文化は、持続可能な成長を支えるために欠かせない要素です。

高度なデータ分析とテクノロジーの活用拡大

企業がデジタル変革を推進する中で、高度なデータ分析やIoTデバイスの利用拡大は、意思決定プロセスを自動化し、迅速な対応を可能にします。さらに、オンプレミスアプリケーションからクラウドへの移行や、SaaS(ソフトウェア・アズ・ア・サービス)の利用拡大も、企業が競争優位性を保つために重要な要素です。

また、エッジアプリケーション開発やレガシーアプリケーションの最新化が進むことで、リアルタイムデータ処理の能力が向上し、ビジネス価値を最大限に引き出すことが可能になります。これらの動向は、企業がデジタル時代において柔軟に対応できる組織を築くための重要な指針となります。

データ活用と変革の成功に向けた教訓の活用

企業がこれまでの経験から得た教訓は、データドリブンな意思決定と変革の推進において極めて重要です。クラウドネイティブ開発や高度なデータ分析を活用することで、企業は持続的な成長を実現し、競争優位を維持することが可能です。

データコンサルタントとして、これらの教訓を基に、企業がリスクを回避しながらも、効率的かつ効果的にデジタル変革を推進できるよう支援していくことが求められています。

最新のBIと分析を活用して意思決定の精度を向上させる方法

データ主導の意思決定を促進するためには、組織内の各チームが信頼性の高いデータにアクセスできる環境を整備することが重要です。これを実現するために、最新のビジネスインテリジェンス(BI)ツールや分析機能を活用し、リアルタイムでデータに基づくインサイトを提供する仕組みが必要です。各チームが効果的にデータを利用できるように、適切に設計されたダッシュボードを提供し、迅速かつ柔軟な意思決定をサポートします。

データアクセスの民主化とセルフサービス分析の強化

データ活用を最大限に引き出すためには、組織内外のユーザーがどこからでも信頼性の高いデータにアクセスできることが不可欠です。例えば、SaaSツールに組み込まれた分析タブや、社内ポータルと統合されたBIツールを活用することで、エンドユーザーがセルフサービスでデータ探索やアドホック分析を行えるようにします。

これにより、データサイエンティストや専門の分析チームに依存することなく、各業務部門が自律的にデータを活用し、意思決定の質を向上させることが可能になります。たとえば、販売部門がリアルタイムでパフォーマンスをモニタリングし、マーケティングチームが顧客インサイトを迅速に得るといった活用例が考えられます。

成功事例から学ぶBIと分析の効果的な導入

以下の企業事例は、BIと分析の導入によって意思決定プロセスの改善を実現した成功例です。

Namely社(大手HRテクノロジープロバイダ)

Namely社は、顧客に付加価値を提供するためにデータが鍵となることを認識し、製品内に分析タブを導入しました。これにより、顧客は自身の人材ニーズを直感的に把握できるようになり、データに基づく意思決定が可能になっています。

Sunrun社(住宅用太陽光発電プロバイダ)

Sunrun社は、セルフサービス分析機能を導入し、販売パイプライン、設置業務、顧客対応といった主要業務全体をカバーする統一されたKPIを活用しています。これにより、各部門がデータに基づくパフォーマンス評価を迅速に行い、業務の最適化を推進しています。

社内外のユーザーに対する信頼性の高いデータ提供

社内ユーザーおよび社外の顧客が、正確で一貫したデータに簡単にアクセスできることは、日々の意思決定を高めるための重要な要素です。適切に管理されたデータが即座に利用可能であれば、各部門はタイムリーにデータドリブンなアクションを取ることができ、結果として組織全体のパフォーマンスが向上します。

結論:データ活用の強化で組織全体の意思決定を支援する

データコンサルタントとして、BIツールやセルフサービス分析を効果的に活用することで、組織がデータドリブンな文化を育み、意思決定の精度とスピードを大幅に向上させるサポートを提供します。組織全体で信頼性の高いデータにアクセスできる環境を整え、迅速で正確な意思決定が行える体制を構築することが、競争力を維持するための鍵となります。