目次

標的型フィッシング攻撃の進化

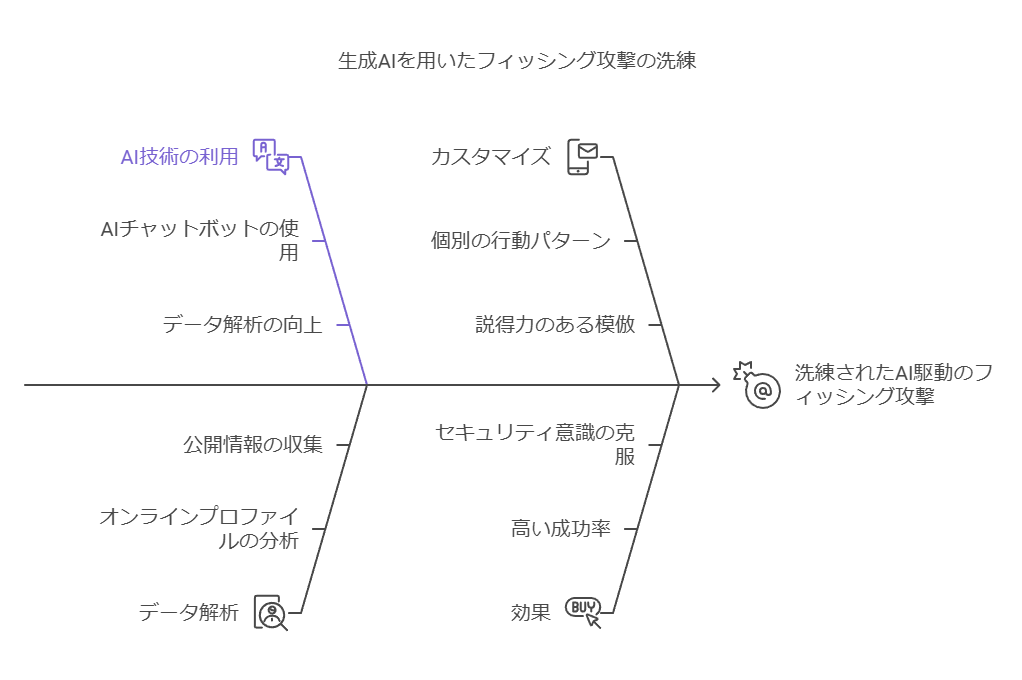

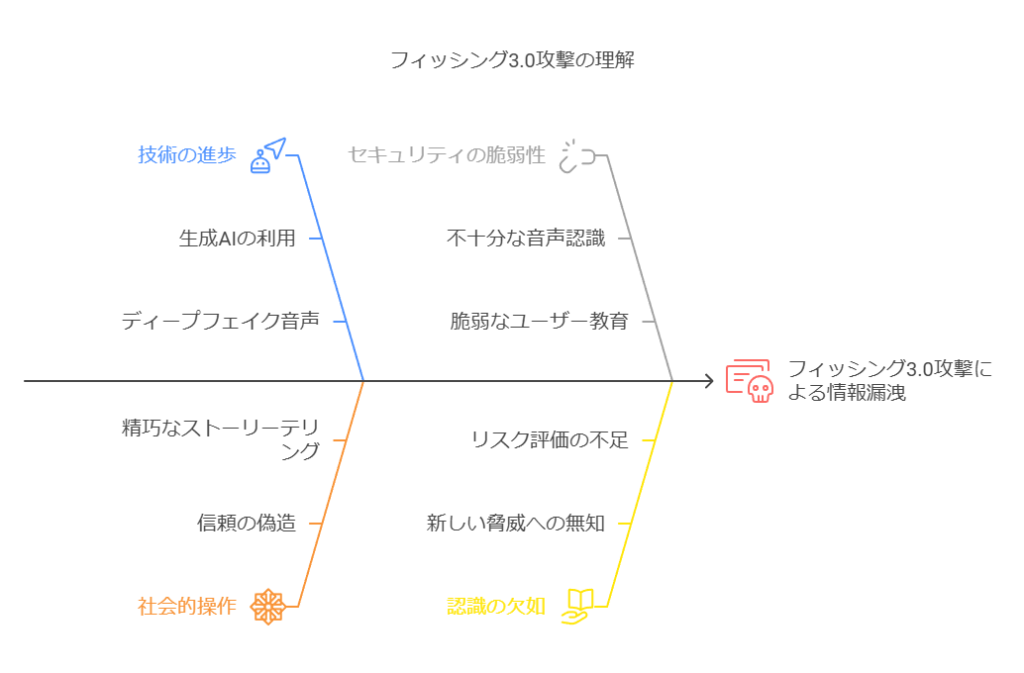

生成AIを活用した標的型フィッシング攻撃は、従来のフィッシング攻撃に比べて一層精巧かつ効果的です。攻撃者はAIチャットボットを用いて、被害者のオンラインプロファイルや公開情報を解析し、個別の行動パターンや生活のインサイトを収集します。これにより、標的の言葉遣いを正確に模倣した、非常に説得力のあるフィッシングメールを自動生成することが可能となります。従来のフィッシングメールに比べ、個別にカスタマイズされたこれらの攻撃は、クリック率や成功率が大幅に向上し、セキュリティの意識が高い組織や個人に対しても有効です。

ディープフェイク音声による新たな脅威

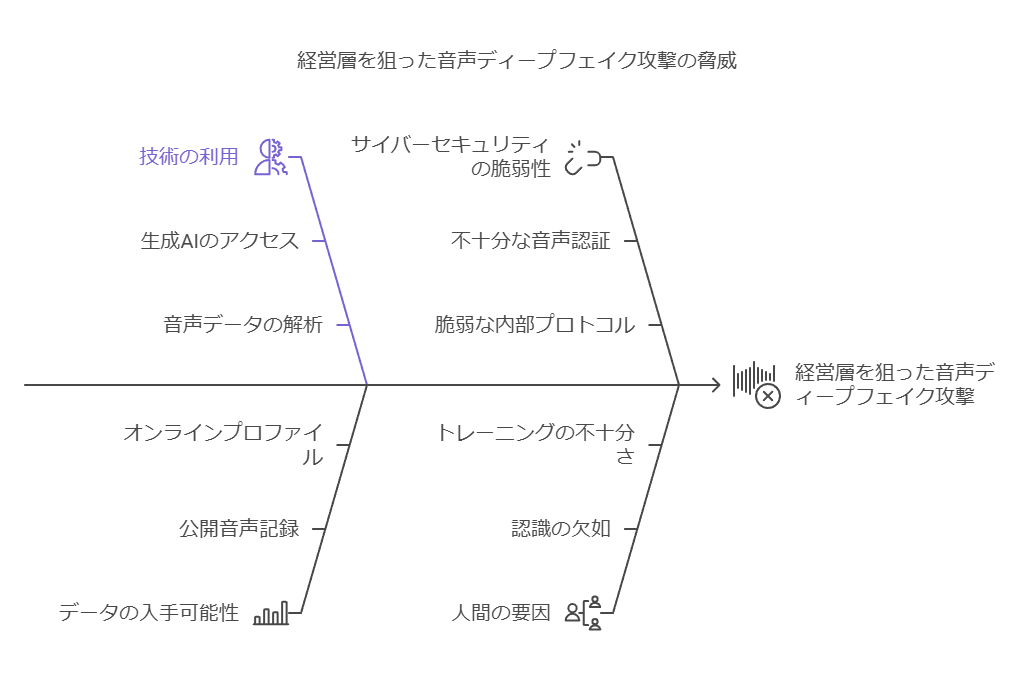

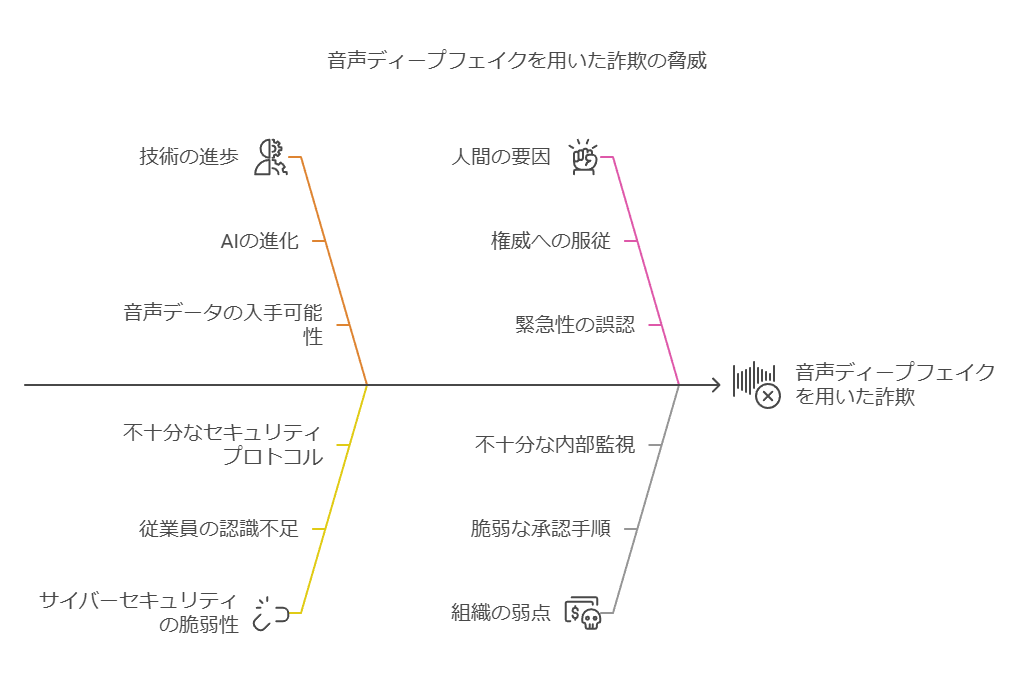

サイバーセキュリティにおいて、生成AIを用いた音声ディープフェイクは、特に経営層をターゲットにした高度な詐欺の一環として懸念されています。音声ディープフェイク技術は、オンラインで公開されているCEOや幹部の音声データを解析し、攻撃者が特定の人物になりすました音声を生成することを可能にします。

例えば、CEOの声でCFOに対して緊急な指示を送り、偽の請求書への支払いを攻撃者が管理する銀行口座へ振り込ませるように仕向けることができます。この手法は、従来の文書やメールベースの詐欺よりも高度で、信憑性が高いため、従業員が騙されやすくなります。

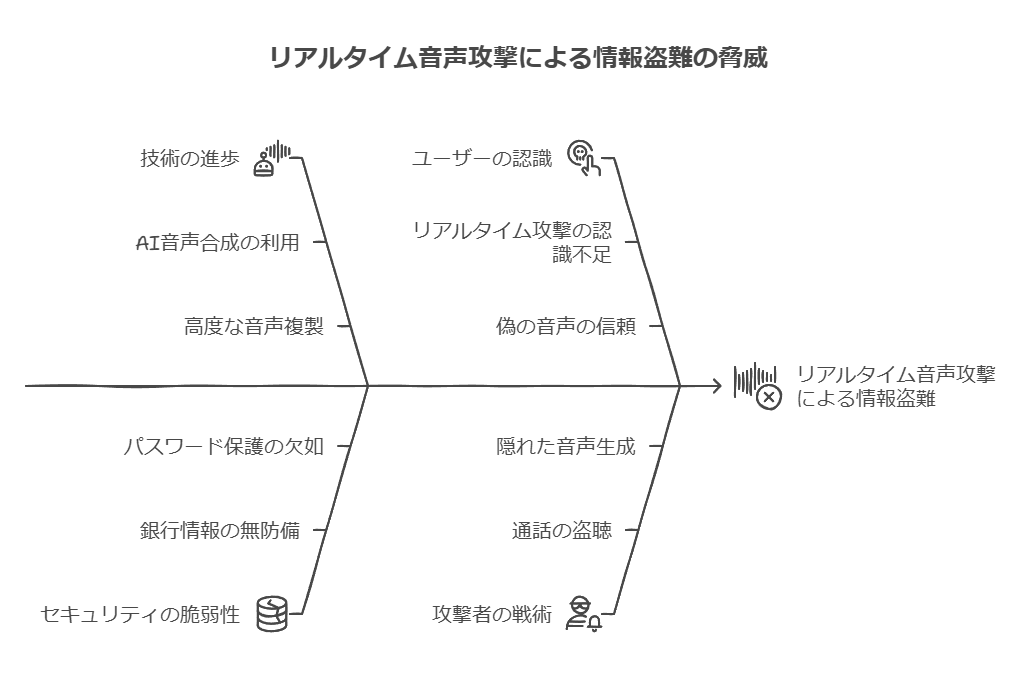

リアルタイム音声攻撃のリスク

さらに、攻撃者は「オーディオ・ジャック」という手法を用いて、リアルタイムで通話を盗聴し、話者の声を複製して不正な音声を生成できることが示されています。これにより、例えば銀行口座番号やオンラインパスワードなど、極めて機密性の高い情報を詐取されるリスクが生じます。この技術はリアルタイムで行われるため、標的に気づかれる前に情報が盗まれる可能性が高まります。

このような攻撃手法は「フィッシング3.0」として分類され、従来のフィッシングよりもさらに洗練されており、被害者には聞こえる内容が信頼できると感じさせますが、実際には攻撃者が生成したものです。

セキュリティ対策の提案

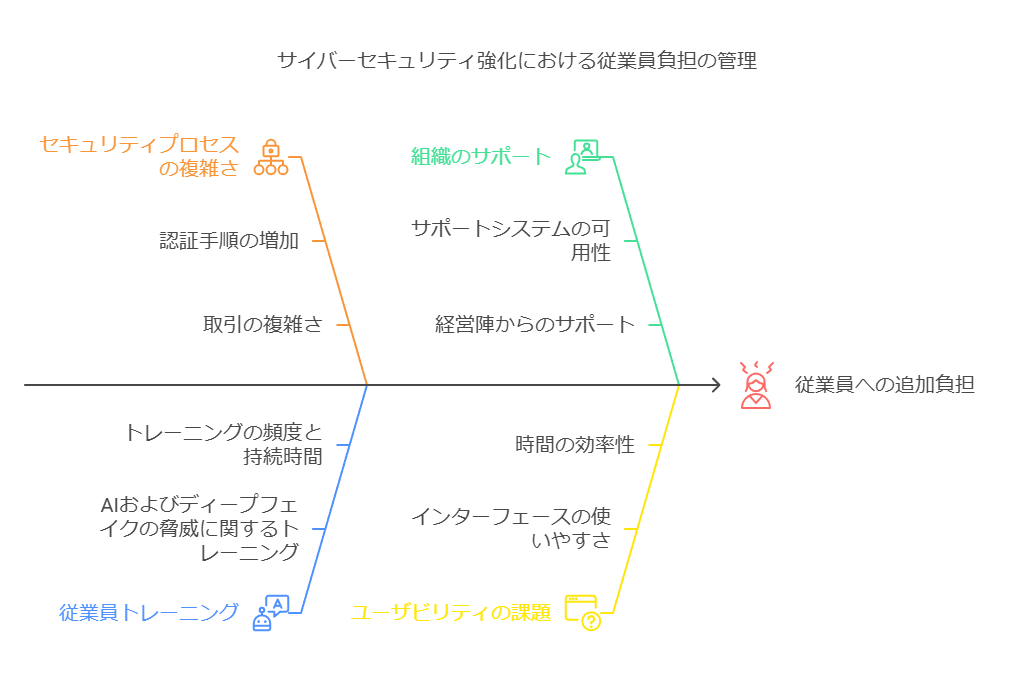

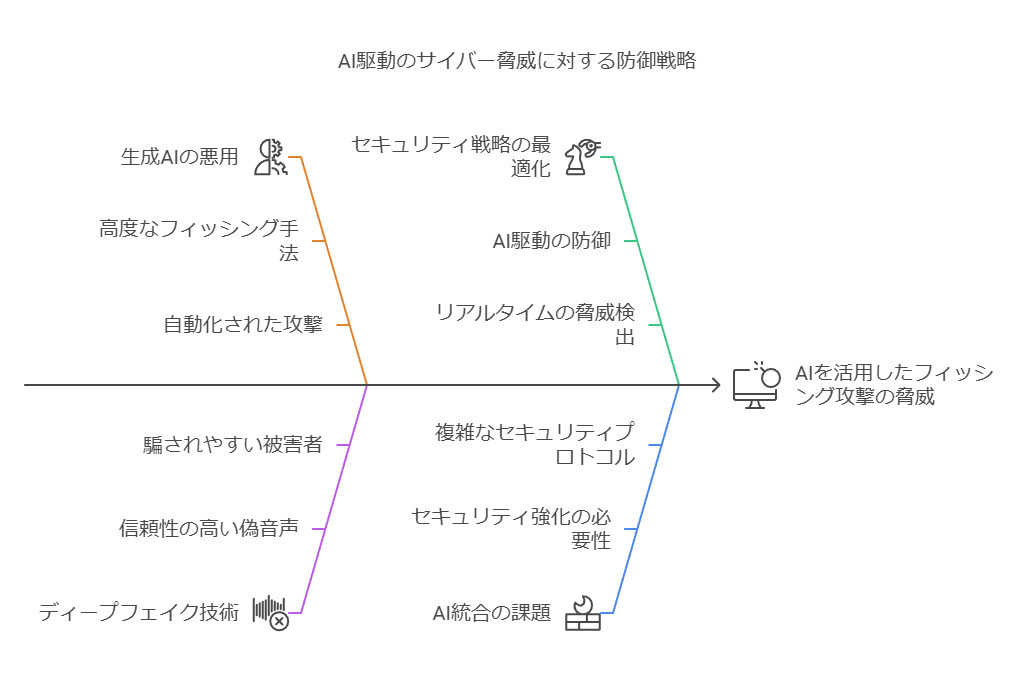

こうした高度な攻撃に対処するためには、企業は従来の認証プロセスに加えて、音声認証や双方向の確認プロセスなど、より複雑なセキュリティコードの使用が求められます。具体的には、取引や重要な意思決定に関するコミュニケーションが音声で行われる際、追加の認証手段(たとえば事前に共有した暗号コードや2要素認証)を用いる必要があります。

ただし、こうした対策は従業員に追加の負担をかけることになります。企業はセキュリティプロセスを強化する一方で、従業員が過度に負担を感じないように、効率的でユーザーフレンドリーなソリューションを導入する必要があります。また、AIやディープフェイクに対する脅威を周知するためのトレーニングも重要です。

AIを活用したサイバーセキュリティ戦略の最適化

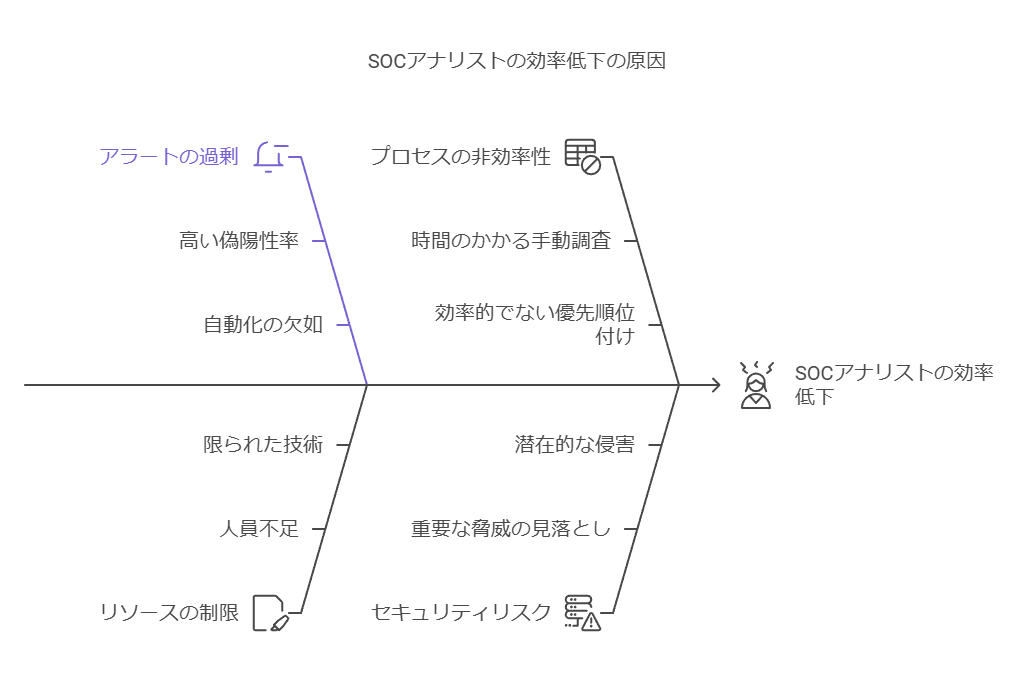

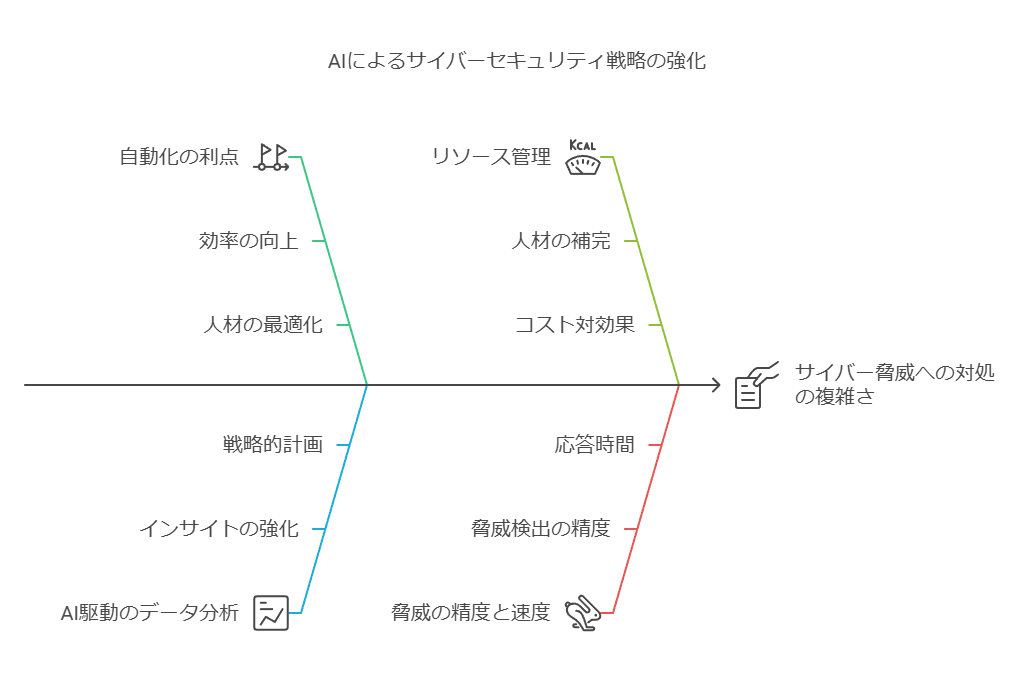

現在のサイバーセキュリティ環境において、リーダーは外部からの攻撃だけでなく、深刻な内部の課題にも直面しています。政府の推計によると、約70万人のサイバーセキュリティ人材が不足しており、全職種においてこの空席を埋めることが困難な状況です。この深刻な人材不足に加えて、機密データの爆発的増加、複雑化するインフラ、そして攻撃対象の広がりがサイバーセキュリティの課題をさらに悪化させています。その結果、セキュリティチームは、データ保護、アクセス管理、数千の脅威への対応という膨大な業務に圧倒されています。

特に、セキュリティオペレーションセンター(SOC)のアナリストは、多くの時間を低リスクのインシデント調査に費やしているのが現状です。実際、SOCチームが毎日調査するインシデントの約3割が脅威ではないことが判明しています。このような膨大なアラートに対応しきれず、日常的に発生するアラートの半数しか確認できないという現状は、業務効率の低下を招き、重大なセキュリティリスクを引き起こす可能性があります。

AIによる効率化と自動化の重要性

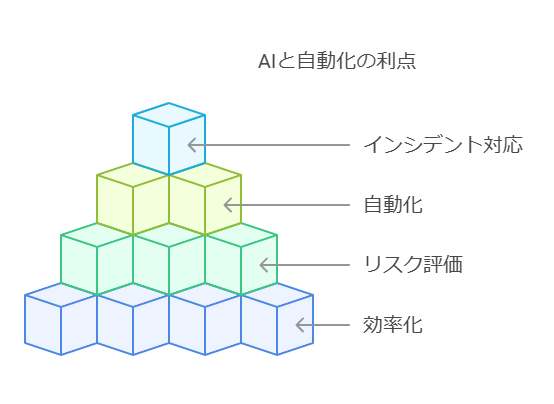

こうした状況に対応するため、多くのサイバーセキュリティリーダーは従来型AIや機械学習(ML)を活用したソリューションを導入しています。これらのソリューションは、SOCアナリストが直面するリスク評価の効率化や対応策の自動推奨を支援し、膨大な業務を軽減します。特に、MLを用いたセキュリティソリューションは、組織独自のセキュリティニーズに合わせて最適化されており、インシデントの早期発見や迅速な対応が可能です。

以下は、AIと自動化を活用することで得られる主要なメリットです:

応答時間の短縮: AIを積極的に活用している組織では、セキュリティ侵害を特定し、封じ込めるまでの平均時間が108日短縮されることが確認されています。この改善により、被害拡大のリスクが大幅に低減されます。

ネットワーク監視の強化: AIを導入している企業は、ネットワークトラフィックの約9割を常時監視することで、脅威検知までの時間を約3分の1短縮しています。これにより、脅威がネットワーク上で広がる前に、迅速な対応が可能となります。

コスト削減効果: AIと自動化技術を広く活用することで、平均170万米ドルのコスト削減が実現されています。これにより、人的リソースの不足を補いつつ、セキュリティ運用の効率を高めることができます。

今後の展望と戦略

AIの活用は、サイバーセキュリティ分野におけるリーダーにとって重要な戦略的アプローチとなります。自動化とAIを最大限に活用することで、限られた人材リソースを補い、脅威対応の精度と速度を向上させることができます。また、AIによって得られるデータ分析やインサイトは、将来的なセキュリティ戦略の策定にも寄与します。組織は、これらの技術を積極的に取り入れ、複雑化するサイバー脅威に対抗していくことが求められています。

AI導入に伴うサイバーセキュリティ強化の必要性

AI技術の進化とイノベーションが加速する中で、サイバーセキュリティに関するガイドラインも成熟しつつあります。特に、信頼性の高い基盤モデルや生成AI、そしてそれらのベースとなるデータセットを保護するフレームワークは、エンタープライズレベルのAI実装に不可欠です。これに伴い、セキュリティチームが考慮すべきガバナンスおよび技術的ベストプラクティスについて、データを最大限に活用したアプローチを以下に紹介します。

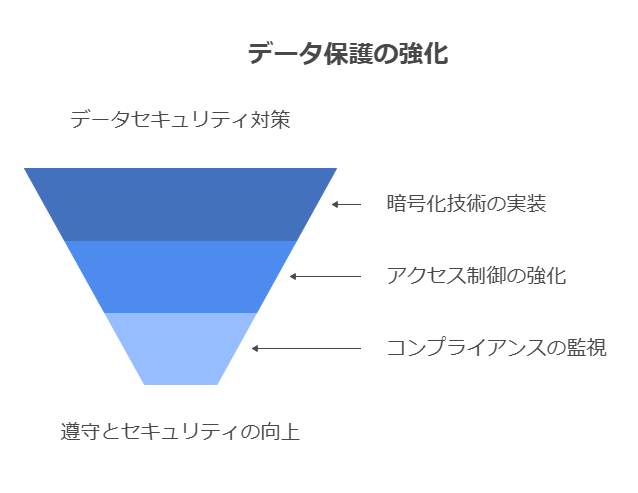

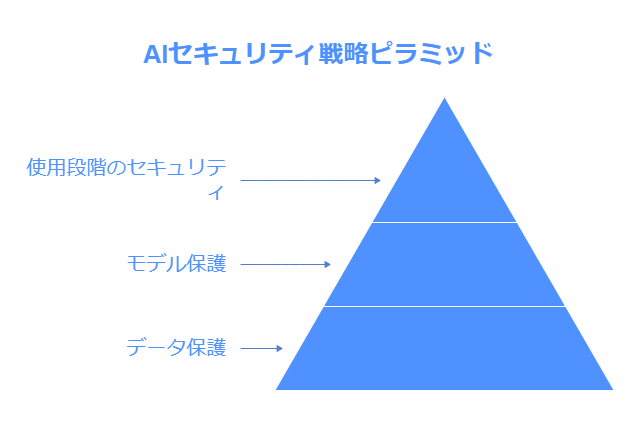

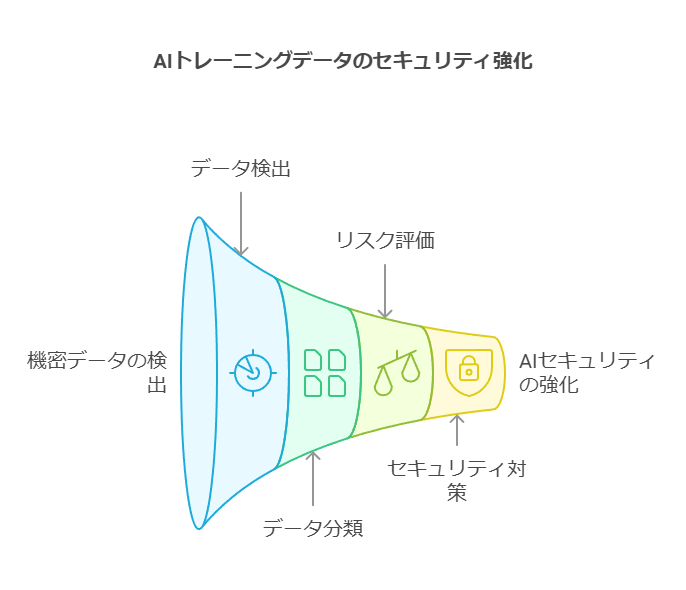

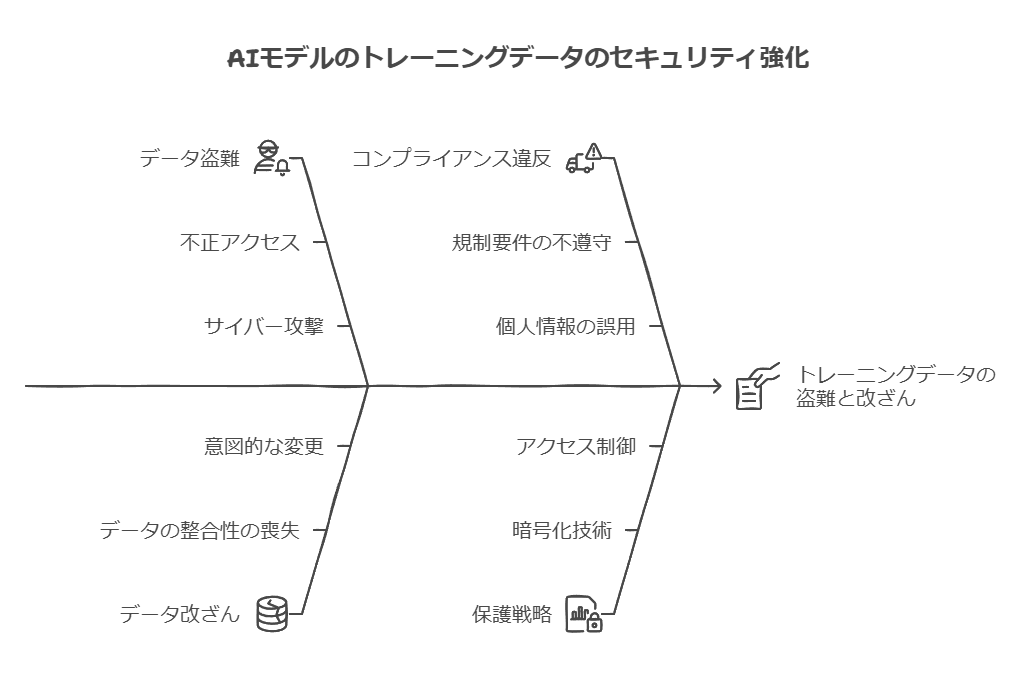

1. データ保護の強化

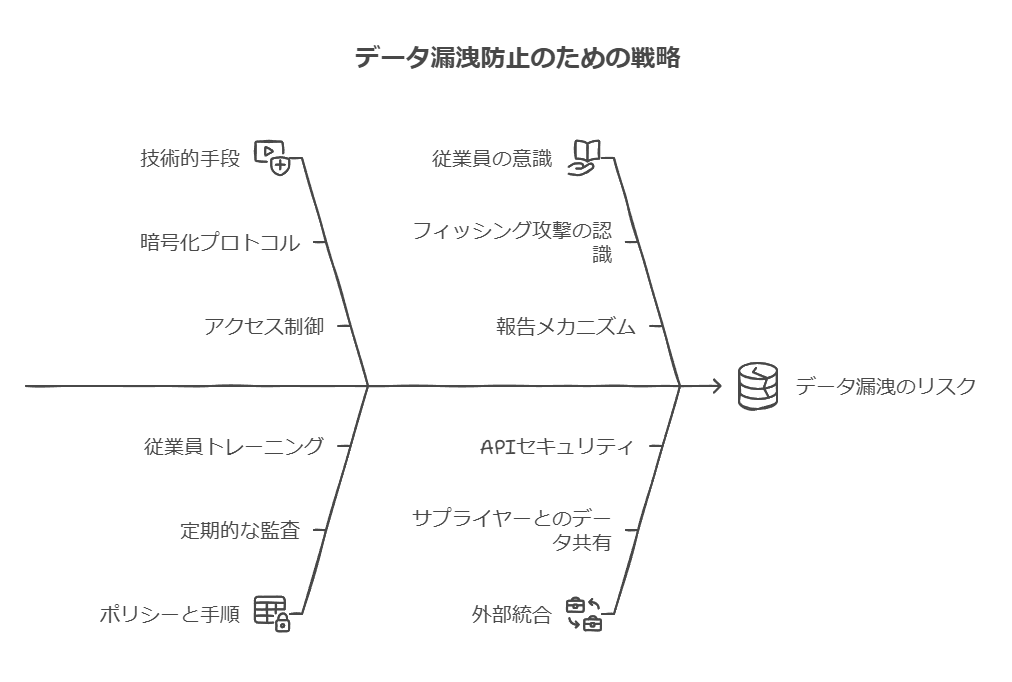

AIモデルのトレーニングに使用されるデータは、盗難、改ざん、そしてコンプライアンス違反から保護する必要があります。特に、トレーニングデータの性質に応じた保護策を講じることが、セキュリティの基盤となります。

データ検出と分類: トレーニングやファインチューニングに使用された機密データを正確に検知し、AIモデルへの不正アクセスや改ざんのリスクを最小化します。これには、個人を特定できる情報(PII)や、機密性の高い情報(SPI)の特定が含まれます。

暗号化とアクセス管理: データの安全性を維持するために、暗号化技術を導入し、データへのアクセスを制限します。さらに、コンプライアンスを継続的に監視することで、規制の変化にも迅速に対応できる体制を構築します。

データ漏洩防止技術(DLP): データ漏洩防止技術を活用して、プロンプトやAPIを介して個人情報が外部に漏れるリスクを軽減します。これにより、組織が取り扱う機密データの安全性を保証します。

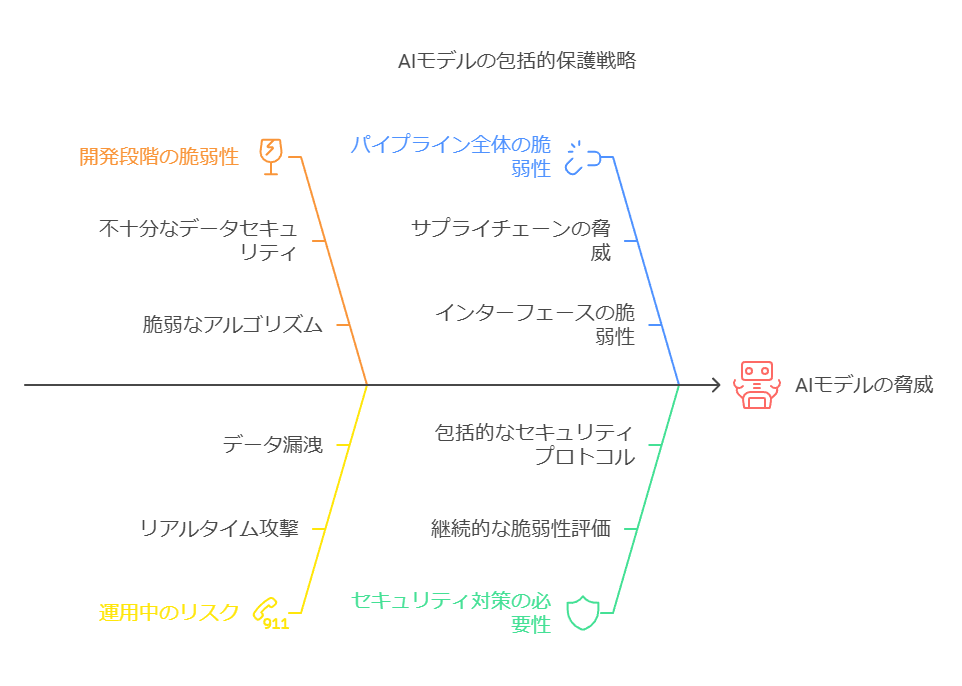

2. モデル保護の強化

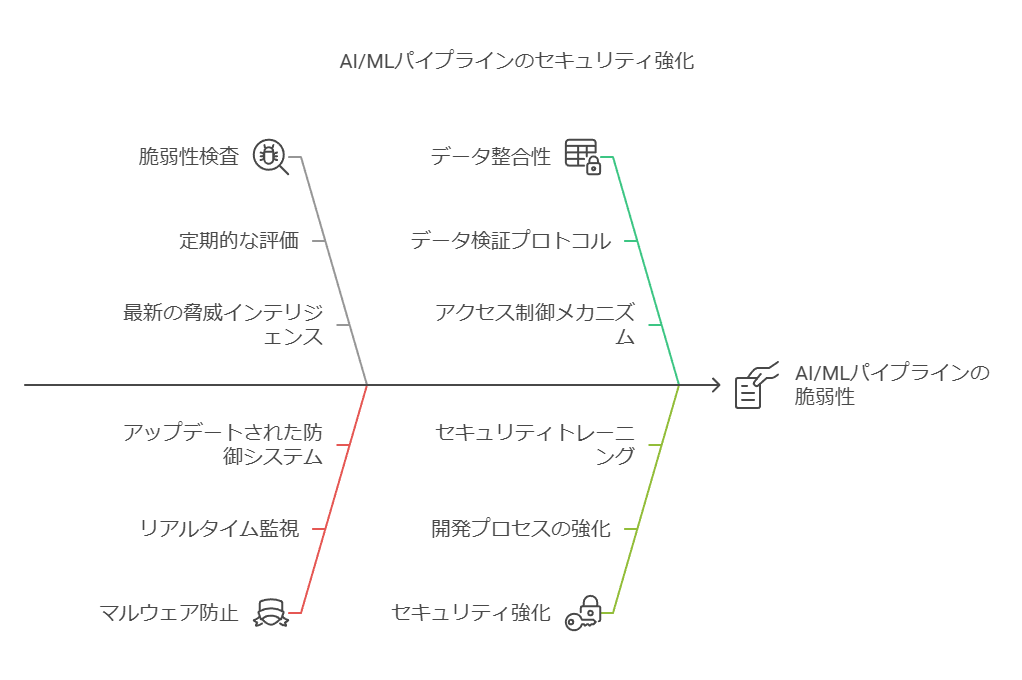

AIモデルは、その開発過程や運用中においても様々な脅威にさらされます。特に、AIと機械学習(ML)モデルのパイプライン全体を保護するための対策が重要です。

パイプラインの脆弱性検査: AIとMLのパイプラインに対して継続的に脆弱性検査を実施し、マルウェアやデータの破損が発生していないか確認します。これにより、開発プロセスのセキュリティを強化します。

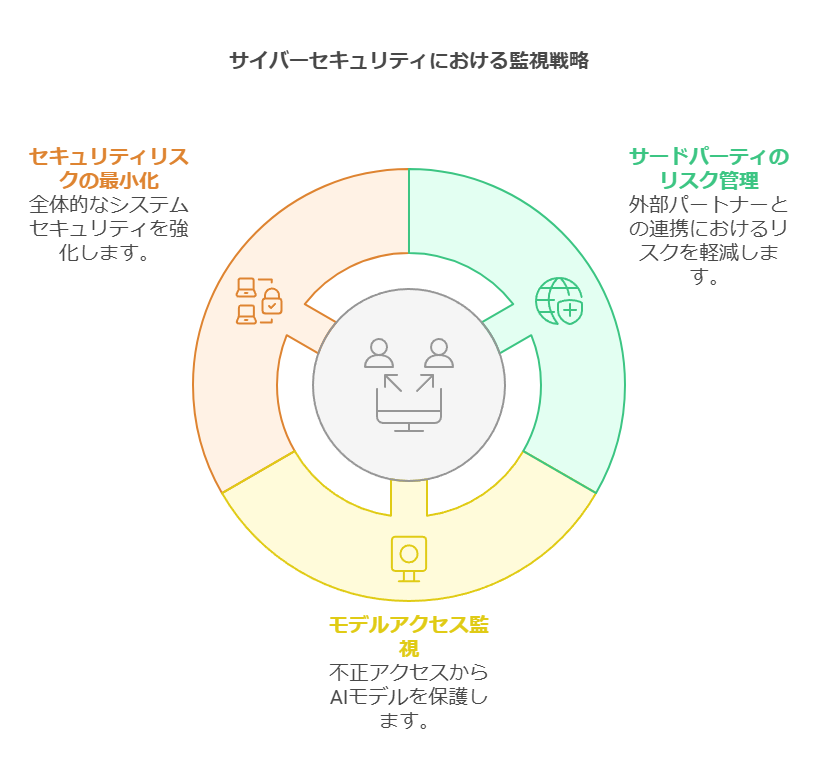

APIとプラグインの監視: サードパーティーのモデルや外部APIとの連携を強化し、セキュリティリスクを最小化します。特に、外部からのモデルアクセスに対する監視が重要です。

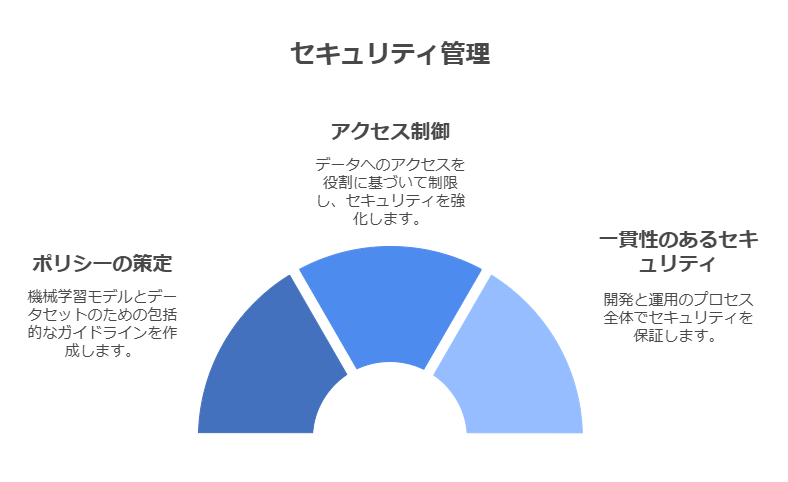

ポリシーとアクセス制御: 機械学習モデルや中間生成物、データセットに関するポリシーを策定し、ロールベースのアクセス制御(RBAC)を実装することで、開発と運用の一貫したセキュリティ管理を実現します。

3. 使用段階でのセキュリティ確保

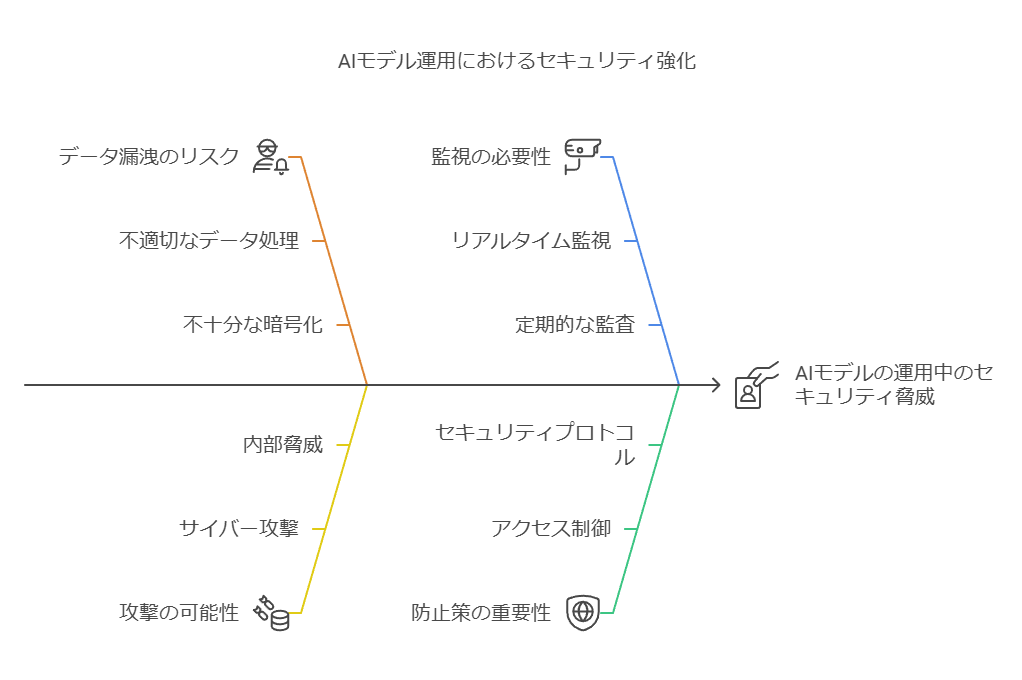

AIモデルの運用中には、特定の攻撃や不正アクセスに対する監視と対応が求められます。AIモデルの使用段階において、データ漏洩や攻撃を防止するための対策を講じる必要があります。

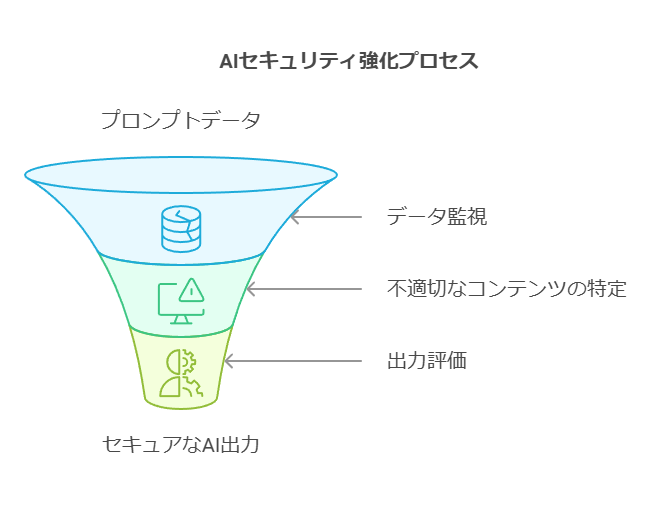

プロンプトインジェクションの監視: AIモデルがプロンプトを通じて不適切なデータを受け取らないよう監視します。これには、モデルが生成する出力に不適切な内容が含まれていないかを確認するプロセスが含まれます。

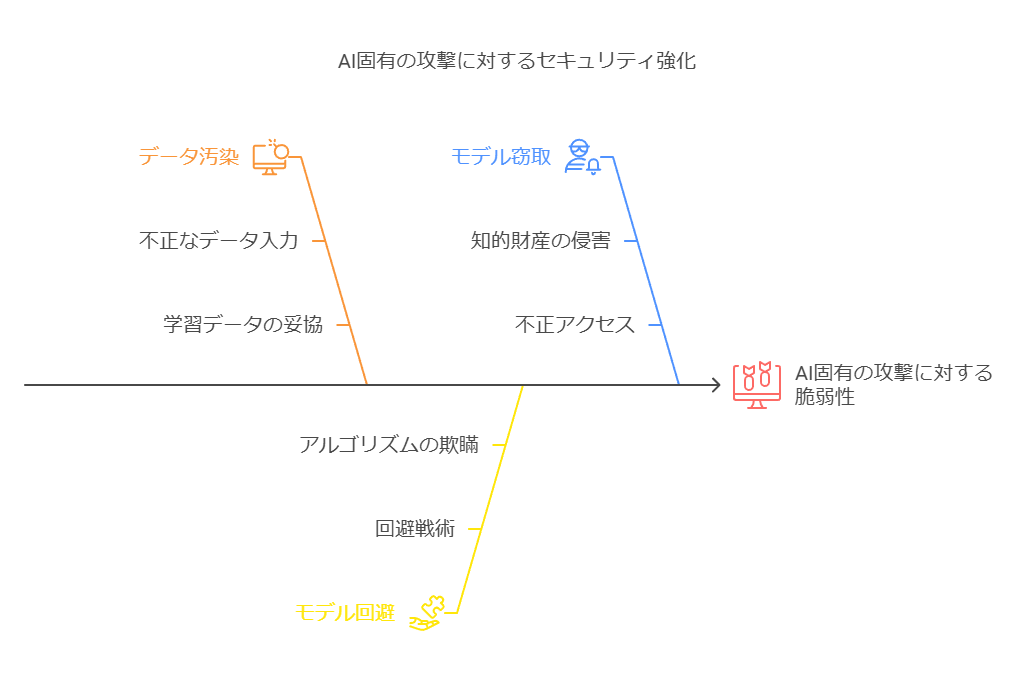

AI固有の攻撃検知と対応: データ汚染、モデル回避、モデル窃取などのAI固有の攻撃に対して、専用のセキュリティソリューションを活用し、リアルタイムで脅威を検知し対応します。

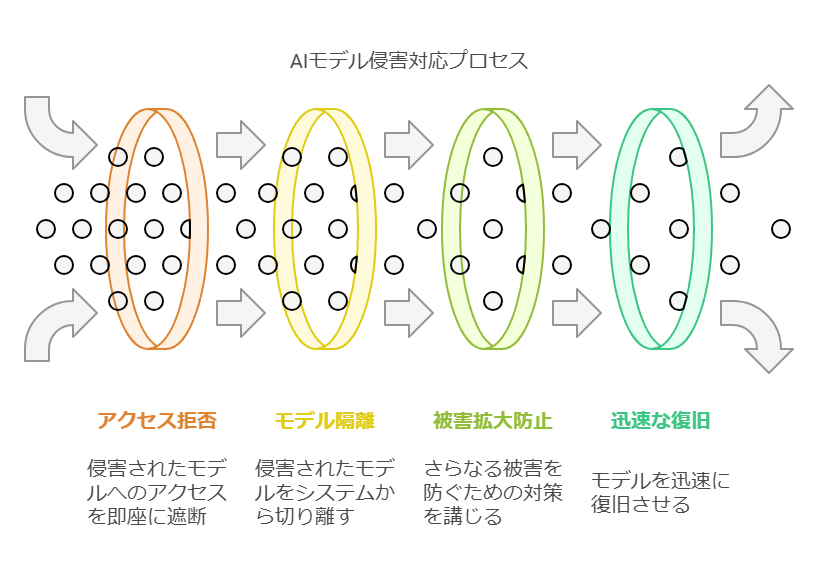

侵害モデルへの対応策: モデルが侵害された場合に備え、アクセスを即時に拒否し、該当モデルを隔離してシステムから切断するための対応プレイブックを作成します。これにより、被害の拡大を防ぎ、迅速な復旧を可能にします。

AI導入の進展とともに、データとモデルのセキュリティがますます重要視されています。セキュリティガイドラインやベストプラクティスを適切に導入することで、AIシステムの保護と信頼性の確保が可能となります。データコンサルタントとしては、セキュリティ対策の強化が長期的なAI活用の成功に不可欠であり、具体的なアクションプランを立案し、各組織に適したフレームワークの構築をサポートします。

インフラストラクチャーの保護

AIの導入に伴い、既存のサイバーセキュリティポリシーやソリューションを、基盤となるAIインフラ全体に適用・拡大することが不可欠です。脅威検知、データセキュリティ、アイデンティティ管理、デバイスの監視といった従来のサイバーセキュリティ手法を適用することで、AI環境における安全性を確保します。

インフラ防御の最前線におけるセキュリティコントロールの導入: AIに対する敵対的なアクセスや攻撃を未然に防ぐため、インフラ全体にわたる強固なセキュリティコントロールを実装します。ネットワーク、アクセス制御、暗号化、侵入検知といったセキュリティ機能を強化することが求められます。

専門知識の最大活用と分散環境での最適化: 既存のセキュリティチームが持つ専門知識を最大限に活用し、分散環境全体でプライバシーやコンプライアンスの基準を最適化します。これにより、AI環境のネットワークセキュリティ、アクセス管理、データ暗号化などが一層強化され、脅威に対する防御力が向上します。

AI保護のための新しいセキュリティ技術への投資: AIに特化した新しいセキュリティ技術やツールへの投資は、今後の脅威に対処する上で重要です。攻撃手法が高度化する中で、AI特有のリスクに対応するための最新の防御策を導入し、AIシステムの安全性を高めます。

AIガバナンスの確立

信頼性のあるAIを構築・運用するためには、AIガバナンスフレームワークを構築し、組織のAI活動全体を管理することが求められます。このガバナンス体制により、リスク軽減、規制対応、倫理的な懸念への対応が効果的に行えるようになります。

説明可能で信頼性の高いAIモデルの実現: AIガバナンスは、責任あるAIの構築を目指し、モデルの透明性と説明可能性を確保するためのフレームワークです。具体的には、AIモデルのリネージュ(履歴)やメタデータを自動で文書化し、信頼性を向上させるとともに、外部監査に対応する基盤を整備します。

公平性とバイアスの監視と是正: AIモデルが公平であることを保証するため、有害なバイアスやモデルの精度低下(ドリフト)を常に監視します。また、再学習が必要なタイミングを自動的に検出し、適切な対応を促します。

コンプライアンス対応と透明性の確保: セキュリティ対策だけでなく、法規制に適合したAIモデルを実現するため、データ保護やモデルの妥当性確認を徹底します。これにより、公正で透明性の高いAI運用を実現し、外部監査にも耐えうるシステムを構築します。

自動文書化と監査サポート: データセットやモデル、関連メタデータ、データ処理経路の出所を自動で文書化し、監査の効率化を図ります。さらに、複数のツールやプラットフォームを自動化・統合することで、AIの開発・運用プロセス全体の透明性と信頼性を強化します。

ここでは、AIインフラの保護における具体的な手法や、AIガバナンスフレームワークの重要性を強調し、データセキュリティやリスク管理の実践的なアプローチを示しました。データコンサルタントの視点として、技術的・組織的な最適化と、投資の優先事項を明確にすることで、AIセキュリティの全体的な戦略を支援します。

レポート作成の自動化

生成AIを活用することで、セキュリティインシデントやケースに関する要約レポートの自動化が可能です。これにより、セキュリティリーダーやビジネスリーダーに対して適切な情報を迅速に提供できます。特に、技術的知識のレベルや関心領域に応じてレポート内容を調整できるため、意思決定プロセスの効率化に寄与します。

脅威ハンティングの加速: 生成AIは、攻撃パターンや脅威の動作を自然言語で解釈し、それに基づいた検索クエリを自動生成します。この機能により、従来の手動検索に比べて脅威の特定が大幅に高速化され、迅速な対応が可能になります。特に、新しい脅威に対するリアルタイムでの対応が強化されます。

機械生成データの解釈

生成AIは、セキュリティシステムで発生するイベントの簡潔な説明を提供することで、セキュリティログデータの理解をサポートします。これにより、アナリストは即座に状況を把握し、調査を迅速に進められるため、インシデント対応の効率が向上します。また、新しいメンバーが技術的な障壁を感じることなくスムーズに業務に取り組めるようになります。

脅威インテリジェンスの収集・整理

生成AIツールは、関連性の高い脅威インテリジェンスを解釈し、要約する機能を持っています。クライアント固有のリスクプロファイルに基づき、最も影響力の大きいリスクに焦点を合わせたインテリジェンスが提供され、リスク管理が効率化されます。

将来的な最適化と自動対応: AIは時間とともに学習し、セキュリティチームの支援をさらに強化します。例えば、類似するセキュリティインシデントの自動検出や、影響を受けたシステムの特定、脆弱なソフトウェアへのパッチ適用など、プロアクティブなセキュリティ対策が可能となります。これにより、運用上の効率が飛躍的に向上し、脆弱性対応のタイムラインが短縮されます。

AIの保護: リスクと推奨事項

LLM(大規模言語モデル)がもたらす迅速性と容易さは、企業における広範な適用に伴い、新たなサイバーセキュリティリスクも引き起こします。技術者やアナリストが生成AIを使用してコード作成やスクリプト開発を行う際、AIが適切なセキュリティプラクティスに基づいてトレーニングされていない場合、リスクが増大します。

推奨事項: 生成AIを安全かつ効果的に利用するためには、以下のステップが推奨されます。まず、AIが生成するコードがセキュリティ基準に準拠していることを検証する仕組みを導入します。また、AIモデルそのものがセキュリティ上のリスクを引き起こさないよう、定期的なモニタリングと評価が必要です。さらに、AIの活用が企業全体にどのように影響するかを理解し、リスク管理のガイドラインを整備することが重要です。

この文章変更により、生成AIを活用した自動化の利点を強調しつつ、リスク管理とAIガバナンスに焦点を当てた実践的な戦略が提示されています。データコンサルタントの視点として、AIの利便性だけでなく、安全性の確保と最適化のための推奨事項を明確に示すことが重要です。

ビジネスリーダーの気づきについて

2023年、多くのビジネスリーダーは、生成AIの導入が組織全体においてもたらす可能性に気づき、デジタルトランスフォーメーションの一環として積極的に活用を検討し始めました。予測分析や業務プロセスの効率化、カスタマーエクスペリエンスの向上など、様々な領域で既に成果を上げています。

サイバーセキュリティの現状について

しかし、サイバーセキュリティ領域においては、生成AIの活用が他の業務分野と比べてまだ限定的です。この状況は、今後12カ月以内に大きく変わると予想されます。

経営幹部の意識と優先順位

多くの経営幹部が、生成AIを活用したサイバーセキュリティソリューションを戦略的な優先事項として位置づけ始めています。調査によると、84%のリーダーが、生成AIを従来のサイバーセキュリティツールよりも優先的に導入する意向を示しており、そのビジネス価値を明確に理解しています。これに伴い、サイバーセキュリティのリーダーシップは、生成AIソリューションの導入を促進し、経営陣との連携を深めることが求められています。

生成AIによるセキュリティ強化の具体例

生成AIはすでに多くの企業で業務プロセスの効率化に貢献していますが、サイバーセキュリティ分野でもその適用が進むことで、セキュリティチームのリソースをより有効に活用することが可能になります。生成AIは、膨大なデータ処理や反復的なタスクを自動化することで、サイバーアナリストが戦略的な意思決定や高度な脅威の検出に専念できる環境を作り出します。

スキルの向上とタスクの迅速化

生成AIの技術により、複雑で専門的なセキュリティ課題に対しても直感的に対応できるツールが提供されます。これにより、セキュリティの専門家は新たなスキルを獲得し、従来よりも高度で困難なタスクをより効率的かつ迅速に処理することが可能となります。

生成AIソリューションの具体的ユースケース

セキュリティ運用を強化するための生成AIソリューションを検討する際には、以下の具体的なユースケースに注目すべきです。

最終版

生成AIによるサイバーセキュリティ強化の可能性

2023年、多くのビジネスリーダーが、生成AIの導入による企業の変革可能性に注目し、業務の効率化や予測分析を活用したサプライチェーン管理、カスタマーエクスペリエンスの改善といった分野でその価値を実感しています。しかし、サイバーセキュリティの分野では、生成AIの活用が他領域に比べて遅れているのが現状です。

この状況は、今後12カ月以内に大きく変わると予想されます。多くの経営幹部が、生成AIをサイバーセキュリティの最優先課題として位置づけており、84%のリーダーが生成AIを従来のサイバーセキュリティソリューションよりも優先して導入する計画を示しています。これにより、サイバーセキュリティリーダーは、生成AIを活用した新しいソリューションの導入を促進し、経営陣との緊密な連携を図る必要があります。

生成AIは、サイバーセキュリティにおいても、他の業務領域と同様に、業務プロセスの自動化や効率化を実現する可能性があります。これにより、セキュリティチームは時間とリソースをより効果的に活用し、アナリストは繰り返しのタスクから解放され、より戦略的な意思決定に専念できる環境を構築できます。

さらに、生成AIは複雑な技術コンテンツを平易にし、セキュリティ専門家がより高度なスキルを習得し、困難なタスクを迅速かつ効率的に遂行することをサポートします。セキュリティ運用の強化を目指す組織は、生成AIの具体的なユースケースに着目し、その活用を検討すべきです。

データセキュリティの軽視について

多くの企業が大規模言語モデル(LLM)の導入を急速に進めていますが、その一方で暗号化、データレジデンシー、特権アクセス管理といった基本的なデータセキュリティ対策を十分に実施できていないケースが見受けられます。これにより、企業はデータの漏洩や不正アクセスのリスクを無意識のうちに増大させています。

ステップ2: ソフトウェアサプライチェーンのリスク

多くの企業がオープンソースや商用ソフトウェアのコンポーネントを利用して、新技術の導入やシステムの構築を行っていますが、このアプローチにはリスクが伴います。特に、誤りのあるコードや脆弱なコンポーネントを使用すると、ソフトウェアサプライチェーン全体で共通の不具合が広がり、攻撃に利用される可能性が高まります。このようなリスクは、企業のセキュリティ体制全体に新たな脆弱性を生み出す恐れがあります。

ステップ3: ハルシネーションによる影響

LLMが生成したコードには、ハルシネーション(幻覚)や誤りが含まれる可能性があり、これがソースコードの完全性やセキュリティを損なう原因となります。このリスクを軽減するためには、バランスの取れた多様なデータでトレーニングされたAIモデルを使用し、エラーの発生を防ぐことが重要です。さらに、企業のAI技術者は、明確で具体的なプロンプトを設計し、AIモデルが意図せぬ結果を出すリスクを最小限に抑える必要があります。

ステップ4: データ漏洩のリスク

たとえデータのセグメント化や保持に関するポリシーが整備されていても、サードパーティーのAIエンジンに対する監視やガバナンスが不十分であれば、機密データが不正アクセスされるリスクが高まります。これに加えて、新たなプロンプト・インジェクション攻撃やプロンプト漏洩攻撃の脅威が拡大し、組織のデータ保護体制をさらに脆弱にする可能性があります。

ステップ5: ブラックボックス効果によるリスク

AIの一部の処理は「ブラックボックス」として扱われるため、セキュリティリーダーや技術チームがプロセスの透明性や説明可能性を確保することが難しくなります。この問題は、特に適切なソフトウェアエンジニアリングの手法が採用されていない場合、企業に重大なセキュリティリスクをもたらします。AIガバナンスの強化を図り、モデルのライフサイクル全体でパフォーマンスの追跡と説明を可能にするフレームワークが必要不可欠です。

最終版

データセキュリティに関する性急な対応がもたらすリスク

多くの企業が大規模言語モデル(LLM)の導入を急いでいますが、暗号化やデータレジデンシー、特権アクセス管理といった基本的なデータセキュリティ対策が十分に実施されていないケースが増えています。このような状況では、データ漏洩や不正アクセスのリスクが高まる可能性があります。

さらに、オープンソースや商用ソフトウェアのコンポーネントを使用する際、誤りのあるコードや脆弱な要素が含まれるリスクがあります。これにより、業界全体で共通の不具合や脆弱性が広がり、企業は新たなセキュリティの脅威に直面することになります。

また、LLMが生成したコードにはエラーやハルシネーションが含まれる場合があり、ソースコードの完全性やセキュリティが損なわれる可能性があります。このリスクを軽減するためには、AIモデルのトレーニングデータを多様でバランスの取れたものにし、プロンプトの設計を慎重に行うことが重要です。

データ漏洩のリスクも無視できません。たとえデータの保持やセグメント化に関するポリシーが整備されていても、サードパーティのAIエンジンに対するガバナンスが不十分であれば、機密データが漏洩するリスクが高まります。プロンプト・インジェクション攻撃やプロンプト漏洩攻撃も新たな脅威として認識されつつあります。

最後に、AIの処理がブラックボックスとして機能する場合、透明性や説明可能性が不足することがあり、適切なAIガバナンスが欠如すると、セキュリティリーダーは意思決定において困難に直面します。AIモデルのライフサイクル全体を通じて、パフォーマンスの追跡や説明を行えるフレームワークを構築することが不可欠です。

現在の生成AI・AI活用における社内データの課題

データ欠損の問題: 生成AIや機械学習モデルのパフォーマンスには十分な量と質のデータが欠かせませんが、必要なデータが不足している場合、アルゴリズムの精度や実用性が制限されます。

データフォーマットの未整備: データ形式が統一されていないことで、AIモデルがデータを効率的に活用できない場合があります。データ整備とクレンジングが導入の前提となります。

データのサイロ化: 各部門やシステムに分散されたデータが統合されておらず、AIモデルが企業全体のデータを十分に学習できないことが生じます。データの統合が求められます。

ストレージ容量の枯渇: データの蓄積やモデルの訓練には膨大なストレージが必要で、容量が不足するリスクが伴います。最適なストレージプランを検討する必要があります。

サーバの処理性能の課題: 高度な生成AIを実行するには大規模な計算リソースが必要で、サーバの処理能力が不足するケースが多いです。性能強化やクラウドサービスの活用が選択肢となります。

セキュリティの課題: 社内データの安全な処理・保存が必要ですが、特に生成AIに利用される場合、データのセキュリティを高めるための施策が欠かせません。

データ転送コスト: クラウドにおけるデータ転送にはコストがかかり、頻繁なデータ送受信が発生する場合はコスト増の原因となります。

クラウド学習の予期せぬリスク: データが意図せずクラウド上で学習に使用される場合、企業の機密情報が外部環境に流出するリスクがあります。利用規約やデータ管理方法の確認が必要です。

導入済みの生成AIツールとAI技術

企業では以下の生成AIツールや技術が活用されるケースが増えてきています:

チャットベースのAI: ChatGPT, Codex

コーディング支援AI: GitHub Copilot, Amazon CodeWhisperer, Tabnine, Codeium

文書生成・分析: Hugging Face

コード生成支援: Jitera, Code Llama, CodePal

これらのツールは、コード自動生成、自然言語処理、カスタマーサポートの自動化など、多様な用途に対応しています。

生成AIおよびAIの導入における主な課題

費用対効果の不確実性: 業務効率やコスト削減効果の測定が難しく、ROI(投資収益率)が不透明で導入の判断が難航する場合があります。

導入費用の不明確さ: 導入費用が明確でない、または予算を超える場合、導入に踏み切れないケースがあります。

セキュリティ制約: 顧客情報や機密情報の管理が厳格化しているため、クラウド上でのAI活用やデータ入力に関する制約があります。

法務・著作権の問題: 著作権や業界特有の法規制がAIの導入を制約し、特に生成AIの利用に慎重な対応が求められます。

業界向けカスタマイズ不足: 自社業界や業務に特化したAIモデルの不足により、汎用的なAIモデルでは期待する成果を得られないケースがあります。

データマネジメント基盤の未整備: AI活用には整備されたデータ基盤が必須ですが、基盤が整っていないことでデータを適切に活用できない組織も多いです。

データサイエンティストやAIパートナーの不在: 専門人材の不足が適切なAIモデルの作成・運用に障害となり、AI導入に苦戦する企業が見受けられます。

経営層や上長の理解不足: AI導入には組織全体の理解と協力が不可欠で、経営層の理解が不足する場合、導入が進まない傾向があります。

運用・管理の人材不足: 導入後の運用・メンテナンスを担う人材が不足していることで、AIの効果的な活用が妨げられる場合があります。

これらの課題に対しては、データコンサルタントとしてリスク管理と共に各課題の整理、優先順位の特定、対策を講じるための具体的な支援が重要です。

AIと機械学習: データ活用による効率化と新たな価値創出

AIと機械学習は、現在のデータドリブンなビジネス環境における最重要なイノベーションの一つといえます。これらの技術が自動運転や医療診断など、さまざまな分野で大きな潜在力を示していることから、ビジネスにおいても非常に高い期待が寄せられています。特にITおよびビジネスマネージャーは、データがAIの基盤であり、AIがデータ活用の核を成すことを理解しているようです。こうした共生的な関係は、AIがデータから学習し、洞察を導くことで、AIがデータ活用における中心的役割を担っているという事実に基づいています。

AI/機械学習は、従来の手法では分析が難しい膨大なデータ量を扱えるため、データサイエンス分野での課題解決に貢献しています。多くの企業がその可能性を認識し、AI/機械学習を活用することで業務効率や精度向上を図る意向を示しています。しかし、調査によると、AI/機械学習について「よく理解している」または「専門的な知識がある」と答えたIT/ビジネスマネージャーはわずか42%にとどまっており、データ時代の中核的なテクノロジーに対して、まだ大きな知識ギャップがあることが分かります。

AI/機械学習導入の進展度合いとしては、すでに25%の組織が何らかの形で導入済みであり、51%が将来的に導入予定と回答しており、導入までのタイムラインは平均で約3.3年と予想されています。特に、金融サービス業界が最も導入を進めている業界の一つですが、現在導入済みの割合は32%に留まり、将来的に導入予定の割合は47%であり、平均で約3年以内の導入を予定しています。

また、AI/機械学習の導入によって組織内のデータ量が増加することを予測する企業は54%に上り、これはAIによって従来は活用されなかったデータや、新たに収集されるデータが増えることによると考えられます。このように、AI/機械学習の導入は、データの収集・管理・活用を一層高度化させ、組織全体のデータエコシステムに大きな影響を与えると見込まれています。

データコンサルタント視点でのAI活用のビジネス変革への可能性

1. AIがもたらすビジネス変革の可能性

AIアプリケーションは、膨大なデータの解析、パターンの認識、予測機能の提供などを通じ、あらゆるビジネスのデジタル変革を支援します。AIの優れた解析能力により、企業は顧客データを深く掘り下げ、パーソナライズされた提案を提供できるだけでなく、ビジネスにおける消費者行動の予測も可能となります。これにより、プロセスの自動化やリソース配分の最適化、価格設定の戦略調整、さらにはアップセルやクロスセルの機会特定が効率的に行えるようになります。

2. AI導入のコスト効率と迅速な展開

既存のハードウェアやソフトウェア、社員リソースを活用することで、AIソリューションの導入にかかるコストを最小限に抑えつつ、ビジネスのニーズに合わせたアプリケーションをスピーディに展開することが可能です。これにより、企業は競争力を維持しつつ、新たな技術活用に向けた柔軟な体制を整えることができます。

3. AIを業務アプリケーションに統合する5つのメリット

a. 顧客体験の向上

生成AIの活用により、迅速で効果的なチャットボットやフロントラインでのサポートアシスタントを構築し、顧客対応のスピードと精度を高めることができます。生成AIの学習機能により、時間が経つごとに回答の精度と質も向上し、顧客との円滑なコミュニケーションが実現します。

メリット: 顧客は求める情報にタイムリーにアクセスでき、担当者は複雑な対応業務に注力できるため、サービスの質を全体的に高めることができます。

トレンドの迅速な把握と意思決定の向上

AIを活用したデータ分析により、企業は変化するトレンドをリアルタイムで把握し、数値データやグラフに即したコンテキストに沿った判断が可能になります。AIの高速な予測分析機能により、意思決定プロセスの精度とスピードが大幅に向上します。

メリット: 社内外から得られるインサイトを統合することで、意思決定の精度を高め、より迅速な対応を図ることができます。

AIの導入は、ただ単に効率化を図るだけではなく、顧客体験の向上や意思決定の迅速化など、ビジネスプロセス全体を進化させる強力なツールです。企業がデジタル変革を推進する中で、AIの活用は競争力の確保と成長の鍵となる要素であり、その可能性を最大限に引き出す取り組みが求められます。